本文详细探讨了Nginx的反向代理、负载均衡和性能优化技术,包括配置优化、系统优化、缓存机制和高并发处理策略,旨在帮助专业从业者深入理解并有效应用Nginx。

关注TechLead,复旦博士,分享云服务领域全维度开发技术。拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,复旦机器人智能实验室成员,国家级大学生赛事评审专家,发表多篇SCI核心期刊学术论文,阿里云认证的资深架构师,上亿营收AI产品研发负责人。

1. Nginx简介与核心架构

1.1 Nginx简介

Nginx (engine x) 是一个高性能的 HTTP 和反向代理服务器,也是一个 IMAP/POP3/SMTP 邮件代理服务器。由 Igor Sysoev 于2004年首次发布,其设计目标是解决 C10K 问题,即在一台服务器上同时处理一万个并发连接。Nginx 以其高并发处理能力、低资源消耗和模块化设计而闻名,广泛应用于 Web 服务器、反向代理、负载均衡等场景。

1.1.1 主要特性

- 高并发处理能力:Nginx 使用异步、非阻塞事件驱动架构,能够高效地处理大量并发连接。

- 低资源消耗:相对于传统的进程或线程模型,Nginx 使用更少的内存和 CPU 资源。

- 模块化设计:Nginx 的功能通过模块实现,用户可以根据需求加载不同的模块。

- 高可扩展性:通过第三方模块和 Lua 脚本,Nginx 能够轻松扩展其功能。

- 丰富的功能:支持 HTTP/2、反向代理、负载均衡、缓存、SSL/TLS、WebSocket 等。

1.2 核心架构

Nginx 的核心架构设计是其高性能和高可用性的关键。核心架构包括模块化设计、事件驱动模型、Master-Worker 进程模型和高效的请求处理流程。

1.2.1 模块化设计

Nginx 采用模块化设计,核心功能和扩展功能都通过模块实现。模块分为核心模块、标准 HTTP 模块和第三方模块。用户可以根据需要启用或禁用模块,灵活配置 Nginx 的功能。

- 核心模块:实现 Nginx 的基本功能,如事件处理、内存管理、配置解析等。

- 标准 HTTP 模块:提供 HTTP 服务的功能,如静态文件服务、反向代理、负载均衡等。

- 第三方模块:由社区或开发者提供,扩展 Nginx 的功能,如 Lua 模块、Redis 模块等。

1.2.2 事件驱动模型

Nginx 使用异步、非阻塞事件驱动模型,能够高效地处理并发连接。事件驱动模型基于 epoll(Linux)、kqueue(FreeBSD)等高效的 I/O 多路复用机制,实现事件的高效分发和处理。

- 异步非阻塞:所有 I/O 操作都通过事件通知机制完成,不会阻塞进程。

- 高效的事件分发:通过 epoll、kqueue 等机制,Nginx 能够快速分发和处理大量并发连接的事件。

1.2.3 Master-Worker 进程模型

Nginx 采用 Master-Worker 进程模型,确保高并发处理能力和高可靠性。Master 进程负责管理 Worker 进程,处理信号和管理共享资源。Worker 进程处理实际的请求,互不干扰,提高了并发处理能力和稳定性。

- Master 进程:启动、停止 Worker 进程,处理信号(如重新加载配置),管理共享资源(如缓存)。

- Worker 进程:处理客户端请求,每个 Worker 进程独立处理不同的连接,避免相互影响。

1.2.4 请求处理流程

Nginx 的请求处理流程高度优化,能够高效地处理 HTTP 请求。主要流程包括接收请求、解析请求、选择处理模块、生成响应和发送响应。

- 接收请求:通过事件驱动模型接收客户端请求。

- 解析请求:解析 HTTP 请求头,生成请求上下文。

- 选择处理模块:根据配置选择相应的模块处理请求,如静态文件服务、反向代理等。

- 生成响应:调用处理模块生成响应数据。

- 发送响应:通过事件驱动模型发送响应给客户端。

2. Nginx反向代理与负载均衡

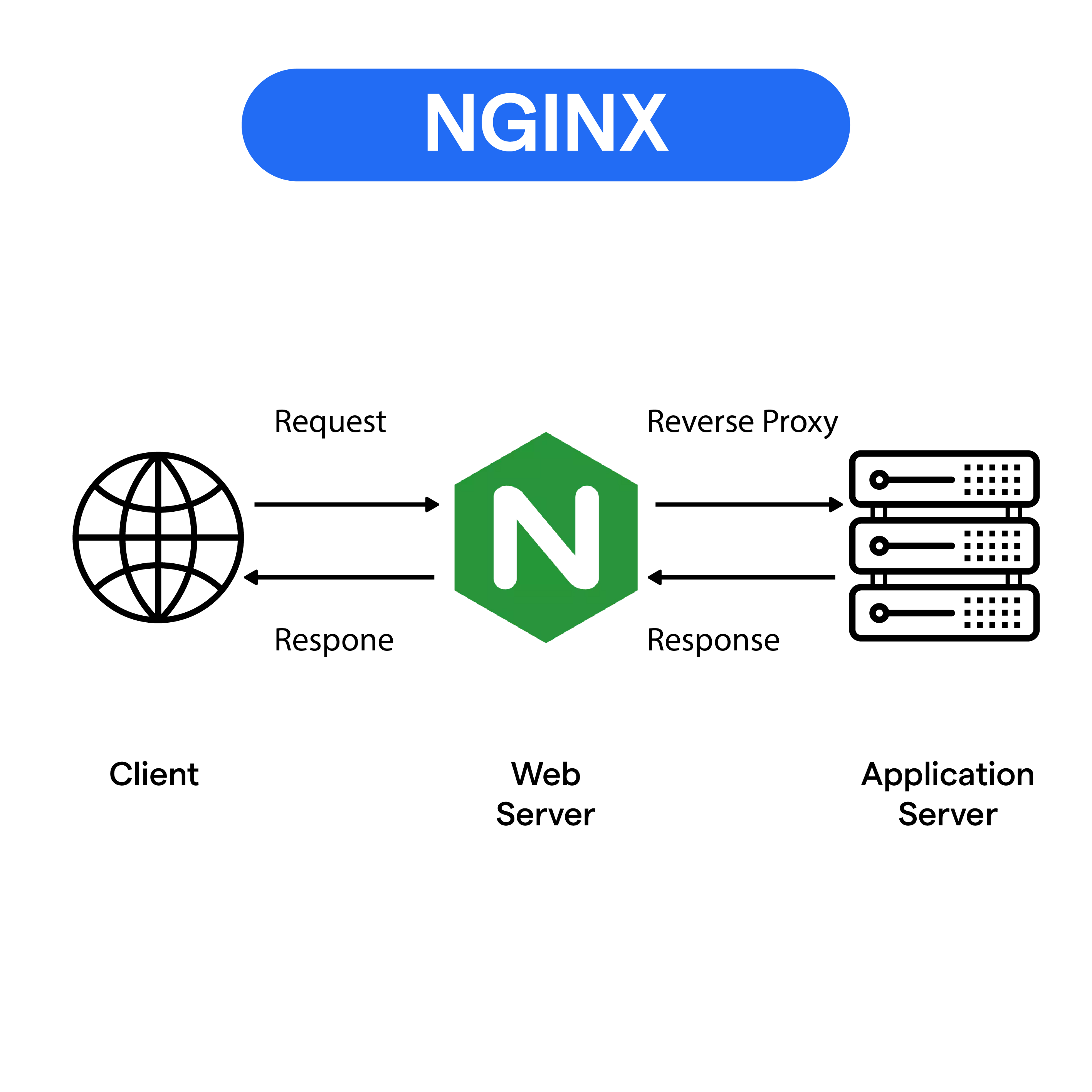

2.1 反向代理基础

反向代理服务器在客户端和服务器之间充当中介,接收客户端的请求并将其转发给后端服务器,然后将后端服务器的响应返回给客户端。Nginx 作为反向代理服务器的优势在于其高并发处理能力、灵活的配置和丰富的功能。

2.1.1 反向代理的优势

- 隐藏后端服务器:反向代理隐藏了后端服务器的真实 IP 和端口,提升了安全性。

- 负载均衡:反向代理可以将请求分发到多台后端服务器,实现负载均衡。

- 缓存:反向代理服务器可以缓存后端服务器的响应,减少后端服务器的压力,提高响应速度。

- SSL 终止:反向代理服务器可以处理 SSL/TLS 加密,减轻后端服务器的负担。

2.1.2 反向代理配置示例

2.2 负载均衡策略

Nginx 支持多种负载均衡策略,能够根据不同的需求选择合适的策略将请求分发到后端服务器。

2.2.1 轮询 (Round Robin)

轮询是 Nginx 的默认负载均衡策略,将请求依次分发到每台后端服务器。该策略简单高效,适用于后端服务器性能均衡的情况。

2.2.2 最少连接 (Least Connections)

最少连接策略将请求分发到当前活动连接数最少的服务器,适用于后端服务器性能不均衡的情况。

2.2.3 IP 哈希 (IP Hash)

IP 哈希策略根据客户端 IP 计算哈希值,将同一客户端的请求分发到同一台服务器,适用于需要会话保持的场景。

2.2.4 权重 (Weight)

权重策略为每台服务器设置权重,权重越高,服务器接收到的请求越多,适用于后端服务器性能不均衡且需要手动调整分配比例的情况。

2.3 配置实例

下面提供几个反向代理和负载均衡的实际配置示例,以帮助理解和应用这些概念。

2.3.1 基本反向代理配置

2.3.2 动静分离配置

动静分离是指将动态请求和静态请求分别处理,以提高效率。Nginx 可以将静态文件请求直接由 Nginx 处理,而将动态请求转发给后端服务器。

2.3.3 负载均衡配置

2.4 健康检查

Nginx 还可以对后端服务器进行健康检查,确保请求不会分发到不可用的服务器。通过配置 ngx_http_upstream_module 模块,可以实现简单的健康检查功能。

在此配置中,backend3.example.com 被标记为 down,Nginx 将不会将请求分发到这台服务器。更高级的健康检查可以通过第三方模块如 ngx_http_upstream_check_module 实现。

2.5 高级反向代理配置

2.5.1 缓存配置

Nginx 可以作为缓存服务器,通过缓存后端服务器的响应,减少后端服务器的负担,提升响应速度。

2.5.2 SSL 终止

Nginx 可以处理 SSL/TLS 加密,解密客户端请求后将其转发给后端服务器,减轻后端服务器的加密负担。

3. Nginx性能优化

Nginx 以其高性能和高并发处理能力著称,但在实际应用中,合理的性能优化策略仍能显著提升其性能。本文将详细探讨 Nginx 的性能优化方法,包括配置优化、系统优化、缓存机制和高并发优化。

3.1 配置优化

Nginx 的配置对其性能有着至关重要的影响。合理的配置可以减少资源消耗,提高处理效率。

3.1.1 Worker 进程配置

Nginx 的 worker_processes 参数决定了处理请求的工作进程数量。一般建议将其设置为等于服务器的 CPU 核心数,以充分利用多核 CPU 的并行处理能力。

auto 表示自动检测 CPU 核心数,并设置相应数量的工作进程。

3.1.2 Worker 连接数配置

worker_connections 参数决定了每个工作进程可以处理的最大连接数。为了提高并发处理能力,建议将其设置为尽可能大的值。

这个配置表示每个工作进程最多可以处理 1024 个并发连接。

3.1.3 缓存配置

Nginx 提供多种缓存机制,可以缓存后端服务器的响应,减少后端服务器的压力,提高响应速度。常用的缓存机制包括 FastCGI 缓存和代理缓存。

这个配置创建了一个缓存区域 my_cache,并在反向代理时启用了缓存。

3.2 系统优化

除了 Nginx 的配置优化,对操作系统的优化也能显著提高 Nginx 的性能。

3.2.1 文件描述符限制

Nginx 处理大量并发连接时,需要打开大量的文件描述符。默认的文件描述符限制可能不足,需通过修改系统配置提高限制。

3.2.2 TCP 连接优化

调整 TCP 连接参数,可以减少网络延迟,提高并发处理能力。

3.3 缓存机制

缓存是提升 Nginx 性能的重要手段。通过缓存机制,Nginx 可以将后端服务器的响应存储在本地,减少后端服务器的负载。

3.3.1 FastCGI 缓存

FastCGI 缓存用于缓存 FastCGI 应用程序的响应,例如 PHP。

3.3.2 代理缓存

代理缓存用于缓存反向代理的响应,减少后端服务器的负载。

3.4 高并发优化

Nginx 在处理高并发连接时,通过异步非阻塞的事件驱动模型,能够高效地处理大量并发连接。以下是一些针对高并发场景的优化策略。

3.4.1 启用 keepalive

keepalive 可以保持客户端和服务器之间的连接,提高连接重用率,减少连接建立和释放的开销。

3.4.2 调整缓冲区大小

调整 Nginx 的缓冲区大小,可以提高大文件传输的效率,减少内存碎片。

3.4.3 启用 Gzip 压缩

启用 Gzip 压缩,可以减少传输的数据量,提高响应速度。

如有帮助,请多关注

TeahLead KrisChang,10+年的互联网和人工智能从业经验,10年+技术和业务团队管理经验,同济软件工程本科,复旦工程管理硕士,阿里云认证云服务资深架构师,上亿营收AI产品业务负责人。

1550

1550

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?