文章目录

论文一

提示:这里可以添加本文要记录的大概内容:

论文精读《基于MFCC的递归神经网络用于临床抑郁症语音自动识别和评估》

基于MFCC的高级特征包含与抑郁症相关的信息。然而,添加视觉动作单元和其他不同的声学特征会进一步将分类结果提高20%和10%,分别达到95.6%和86%的准确率。

提示:以下是本篇文章正文内容,下面案例可供参考

手工制作的基于功能的方法

高斯混合模型(GMM)、原始数据支持向量机(SVM)、GMM支持向量机、多层感知器神经网络(MLP)和层次模糊特征(HFS)。

基于GMM的支持向量机模型的性能优于采用决策融合方法的其他分类器。准确率为81.61%。性能最低的分类器是采用特征融合方法的GMM。GMM获得的最差精度为48.26%。

基于深度学习的方法

基于深度学习的方法强调了性别(男性/女性)对模特表现的影响这一事实。中的抑郁评估结果表明,使用DCNN-DNN模型对一组抑郁女性所获得的均方根误差是使用同一模型对一组抑郁男性所获得的均方根误差的三倍。

低层特征提取Mel倒谱系数

低层特征提取Mel倒谱系数(MFCC)是说话人识别中最常用的音频特征,因为其在描述低频信号变化方面的鲁棒性。MFCC系数以非线性尺度mel尺度描述倒谱的能量。它们被认为是最具辨别力的声学特征,近似于“人类周边听觉系统”感知语音信号的方式[11]。这些系数的一阶导数和二阶导数允许跟踪它们随时间的变化,从而跟踪语音音调的变化[25]。基于这些原因,在本研究中,仅提取MFCC系数,以研究其在基于语音的抑郁症自动诊断应用中的鲁棒性。

基于MFCC的迁移学习实施。该框架与情绪识别任务进行了预训练。**致密层的最后一层大小为八个神经元,用于预测八种情绪类别。**预训练后,该模型根据抑郁症评估的目标任务进行微调:前三个LSTM层冻结,最后三个致密层重新训练。

以下实验中使用的附加视觉特征由DAIC-WOZ语料库提供。

二十个面部动作单元确实与之前训练的三个LSTM层的平坦输出连接在一起。然后,将新引入的视觉特征和提取的高级MFCC特征的连接向量馈送到完全连接的层进行分类。

MFCC系数被输入连续LSTM层的深层递归神经网络**。为了克服训练数据不足和过度拟合的问题,我们考虑了两种方法:增加训练数据和从另一个相关任务转移知识。**在DAIC-WOZ语料库上对所提出的体系结构进行了评估,并取得了令人满意的结果。

论文二

论文精读《多模态主题丰富辅助学习在抑郁症检测中的应用》

多模态主题丰富辅助学习(MTAL)方法

我们提出了一种新的多模态主题丰富辅助学习(MTAL)方法,旨在捕获不同模式(即文本和图像)中的主题信息,用于抑郁症检测。特别是,在我们的方法中,提出了一个模态不可知主题模型,该模型能够从离散的文本信号或连续的视觉信号中挖掘主题线索。在此基础上,主题建模w.r.t.将这两种模式转换为两个辅助任务,以提高主要任务(即抑郁症检测)的性能。

主要任务

主要任务正是抑郁症检测任务(见第3.1节)。

两个辅助任务分别是文本和视觉主题建模(第3.2节介绍了提出的模态不可知主题模型)。

最后,提出了一种主题丰富的辅助学习策略,将主要任务与辅助任务结合起来(在第3.3节中介绍)。

文本采用BERT-Base(未装箱)模型作为共享文本编码器。

图像采用VGG编码器

形态融合采用LSTM网络

辅助任务

辅助任务:文本主题建模和可视化主题建模

多任务学习的目标是在所有任务中获得更好的绩效,辅助学习的不同之处在于,只有单个主要任务需要更好的绩效,辅助任务的作用是帮助提高该主要任务的绩效。为此,我们利用两种策略(即适应性学习和辅助训练)将主要任务与辅助任务结合起来

对于我们的MTAL方法,我们将LSTM隐藏状态的维度设置为256,并采用另一个Adam优化器(Kingma和Ba,2015),初始学习率为10−对于交叉熵训练,β1=0.9。正则化权重为10−5.辍学率为0.5。对于CNN,我们将过滤器的宽度设置为3、4、5,每个过滤器有100个功能。在我们的主题模型中,主题嵌入的维度M是128,主题的数量(K)是20。此外,如果推文不包含图像,则图像向量将初始化为零向量。评估指标。采用标准精度(Acc)和MacroF1(F1)对性能进行评估

1) H-LSTM。这是一种用于方面情绪分类的分层LSTM方法。在我们的实现中,我们使用它来建模单词序列和文本序列,以进行抑郁症分类。

2) 伯特+LSTM。这是一个用于编码每个文本的伯特模型,然后是一个用于编码抑郁症分类的文本序列的LSTM。

3) BERT+LSTM+文本主题建模。这是带有文本主题信息的BERT+LSTM的扩展。

4) VGG+LSTM。这是用于编码每个图像的VGG模型,然后是用于编码图像序列的LSTM。5) VGG+LSTM+视觉主题建模。这是VGG+LSTM的扩展,带有可视主题信息。

6) EF-LSTM(Zadeh等人,2018年)。这是一种最先进的多模态方法,用于人类沟通理解任务。

7) CoMemory(Xu等人,2018年)。这是一种最先进的多模态情绪分析任务的多模态方法。

8) CoATT(Zhang等人,2018年)。这是一种最先进的多模式命名实体识别任务方法。9) 混合注意力(Gu等人,2018年)。这是一种最先进的多模态方法,使用模态注意来学习口语分类的特定模态和模态融合特征。请注意,上述四种多模式方法只能对单个文本+图像对进行编码。在我们的实现中,我们还使用LSTM对所有文本+图像对的最终向量序列进行编码,以进行抑郁症分类。

10) CoMMA(Gui等人,2019b)。这正是一种最先进的多模式抑郁症检测方法。在本研究中,我们基于新的数据设置重新实现了它。

我们的方法VGG+LSTM+视觉主题建模显著优于VGG+LSTM(pvalue<0.05)。这鼓励我们结合视觉主题信息进行抑郁症检测。多模态性能。当同时使用文本和图像模式时,CoMemory、CoATT和混合注意的表现优于基于BERT的单模式BERT+LSTM。这证实了在抑郁症检测中考虑图像信息的帮助。相比之下,就所有指标而言,我们的方法主要任务的性能始终优于上述所有多模式方法。这主要是因为使用BERT作为文本编码器很有用。在所有这些方法中,我们的方法MTAL表现最好,甚至在所有指标方面都显著优于强基线BERT+LSTM+文本主题建模。这些结果鼓励我们结合文本和视觉主题信息进行抑郁症检测。

不平衡情景分析。在现实场景中,只有一小部分用户感到沮丧。受此启发,我们进一步评估了MTAL方法在不同比例的抑郁用户中的稳健性。具体来说,我们构建了9个不同的不平衡训练集,其中抑郁用户的百分比在10%到90%之间,总用户数设置为1500,训练/开发/测试设置为7:1:2。详细的实验结果如图4所示。从图中我们可以看出,即使在非常低的百分比(10%的抑郁用户)的情况下,我们的MTAL方法仍然可以实现稳定的性能,并且始终优于最先进的基线。这可以进一步证明我们方法的稳健性和有效性。

例如用户个人属性信息(如职业、位置和年龄)和社会属性信息(如时间线、社会行为和社会关系),以帮助抑郁症检测。

论文三

论文精读《结合上下文感知分析的新特征选择算法改进抑郁症预测》这篇有MATLAB源码的

数据集

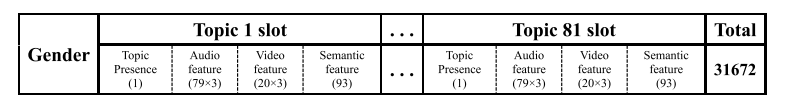

我们开发了一种新的两阶段特征选择算法,通过对DAIC-WOZ数据集的上下文感知分析构建高维(超过3万个)特征,包括音频、视频和语义特征。将预测性能与七个参考模型进行了比较。还分别分析了与保留特征相关的首选主题和特征类别。结果:在每种预测情况下,所提出的方法都选择了简约子集(数十个特征)。在开发集(测试集)上,我们获得了最佳的抑郁分类表现,F1得分为0.96(0.67),精确度为1.00(0.63),召回率为0.92(0.71)。我们在抑郁症严重程度估计方面也取得了有希望的结果,RMSE为4.43(5.11),MAE为3.22(3.98),与最佳参考模型(具有“选定文本”特征的随机森林)存在边际差异。

DAIC-WOZ抑郁症数据库的描述我们在本研究中使用的数据集是一个更大的语料库的一部分,即痛苦分析访谈语料库——绿野仙踪(DAIC-WOZ),其中包含旨在支持诊断焦虑、抑郁和创伤后应激障碍等心理痛苦状况的临床访谈(Gratch et al.,2014)。该数据库包括189名受试者(或会话),每个受试者都包括录音和视频记录,以及7到33分钟的采访记录。采访由一名名名为Ellie的动画虚拟采访者进行,由另一个房间的一名人类采访者控制。参与者识别码为451、458和480的三次会议在技术上是完整的,但缺少了成绩单中的Ellie部分(Gratch等人,2014年)。此外,我们发现会话402和420的视频记录在会话结束前约2分钟被剪切,但仍然可以使用上下文感知分析提取视频特征。因此,我们最终使用了186个会话进行以下分析,数据集的分割与中的相同(Gratch et al.,2014)。训练集中的样本数量为107个,开发集中的样本数量为33个(不包括451和458个课时),测试集中的样本数量为46个(不包括480个课时)。我们还注意到,训练集中409课时的PHQ8得分为10,但相应的二进制标签标记为0,这与标签规则不匹配,即PHQ8得分>=10的参与者被视为抑郁(Gratch等人,2014)。因此,我们将会话409的标签更正为分类任务的1。

特征

语音特征:协作语音分析存储库(COVAREP)工具包(Degottex等人,2014年;Gratch等人,2014年)每10毫秒提取一次会话的音频特征。79维特征向量由2个韵律、9个音质、63个频谱和5个共振峰组成。

视频特征:使用OpenFace toolkit(Baltruˇsaitis等人,2016)提取的动作单元(AUs)特征(20维)作为视频特征,其中的值是每个动作单元的回归输出或二进制标签,反映了动作单元存在或不存在时的。

文本特征:我们使用语言查询和字数统计(LIWC)(Pennebaker et al.,2015)软件将受试者讲话中出现的字数统计为93个类别,如愤怒、消极情绪和积极情绪,即为每个会话生成93维特征向量。

首先,通过遍历DAIC-WOZ数据库会话中的所有Ellie语音,建立一个初步的句子词典,然后排除多余的句子。其次,没有开始新话题的句子被丢弃。第三,对词典进行聚类,使以同一主题开头的句子组合在一起。这些集群被链接到相应的主题,最终形成一个主题词典。包含81个提取主题的完整列表如表S1所示。

模型搭建

基本机器学习模型wrapper中采用的用于抑郁症预测的基本模型是支持向量机(SVM),它适用于在小样本和高维特征的数据集上建模(Vapnik,2000)。SVM模型由LIBSVM软件包实现(Chang和Lin,2011)。分别使用LIBSVM中带有选项’-s 0’的解决方案C-SVC进行分类,并使用带有选项’-s 3’的epsilon SVR进行回归建模。该软件包提供了四种广泛使用的核函数,如线性函数、多项式函数、径向基函数和sigmoid函数。我们使用径向基函数(RBF)作为SVM的默认核,因为RBF核在大多数数据集中表现出更好的泛化能力(Zhou等人,2012;Dai等人,2011)。在训练集上,通过交叉验证的网格搜索策略,优化了LIBSVM的调整参数,包括核函数中的代价c、gamma g和epsilon SVR损失函数中的epsilon p。

准确率性能

根据睡眠质量、PTSD/抑郁诊断、连续治疗、内向性、个人偏好和感觉等6个标准提取文本特征。然后通过相似因子分析方法选择这些特征,随机删除一个或两个特征,并逐步验证其余特征。

F1得分分别为0.40和0.48。虽然PDR-PSO在精确度上获得了完美的分数,但其召回率仅为0.25。值得注意的是,通过我们的两阶段特征选择方法选择的特征明显改善了分类器的性能,即RF分类器的F1得分增加了82%(从0.50增加到0.91),SVM分类器的F1得分增加了152%(从0.38增加到0.96)。

论文四 集成深度和浅层模型的多模态抑制分析——混合架构

提出混合框架

- 基于深度学习的卷积神经网络DCNN和基于深度神经网络DNN的视听多模态抑郁识别模型

- 文本,基于段落向量(PV,首次应用)和支持向量机SVM,分为抑郁和非抑郁,对每个类别抑郁两个高斯阶梯模型进行训练

- PHQ-8建立随机森林RF模型进行分类

- 视觉描述符(HDR)描述视频中的面部标志的位移和速度

有效提高了抑郁症估计的分类的准确性F1 0.746高于AVEC2016的0.724

HDR比BOW和MHH特征具有更好的抑郁识别性能

近期相关研究

多关注于语速、面部动作单元(AUs),这些信息能直接反映个体的睡眠状态和情绪状态。目前很少有研究同时考虑了抑郁症分类和抑郁程度的估计。

本文设计了一种结合音频、视频、文本描述符的混合抑郁分类和估计框架

特征:

运动历史直方图(MHH)

面向位移的直方图(HOD)(描述身体关节的运动和轨迹,用于动作识别)

将语音段内的梅尔尺度滤波器组特征串联起来,构建一个二维表示,输入到卷积神经网络CNN模型,然后用LSTM捕捉长期变化,用于抑郁症检测。

视频 HDR-Based Video Feature(新的全局描述符)

音频 利用opensmile工具为每个语音段提取238个低电平描述符(LLDS)

文本 段落向量(PV)模型是单词在向量空间的分布表示、211个光谱和能量的相关特征。PV获取单词和文档的语义表示,通过一个密集向量表示每个文档,该向量被用于预测文档中的单词,是一种无监督算法,可以从长度可变的文本片段中学习固定长度的特征表示

融合深度和浅层模型的混合架构

基于DCNN和DNN的视听抑制估计

数据集:2016AVEC的数据集,包括189个临床访谈

PHQ-8的分数从0到24,抑郁、非抑郁的二进制制作的标签给出

31个非抑郁女生,13个抑郁女生;55个非抑郁男生,8个抑郁男生

比较了决策融合和模型融合的准确率

84.21% 100%

81.25% 93.75%

在测试集上,提出的混合抑郁估计和分类框架上得到了很好的结果0.746

749

749

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?