-

注意:

- 如果你利用Mac从事开发工作,请务必去了解下Homebrew,他会给你带来很大的便利,下文会细说

- 但是新版的Homebrew有个大问题,他在帮你装软件时会安装最新版,并且大部分软件不支持版本选择,所以要有取舍

- Hadoop3.X和Hadoop2.X有较多不同,所以选择目前的额主流Hadoop2.X,大数据分布式搭建尤其 注意版本兼容问题

- 在搭建前要先了解Hadoop和Spark的相关基础知识,*** Hbase如果你不需要的话可以不用安装**

-如果你觉得网页麻烦,想要良好的阅读体验这有PDF可供下载 GitHub

前言

-

如果你能具备上面的4条,接下来的搭建也相当的快速,大部分的时间是耗在下载和账号注册上面,我会在文章最后附上我的百度云安装包,相信会给大家节省60%以上的安装时间

-

安装过程中难免遇到文档中未提及的报错,需要对Linux系统终端操作(MacOS类似)有所了解

-

很多人更多的想学习Spark的pyspark,但是Spark是需要依赖Hadoop的HDFS以及YARN的框架

-

所有版本附Mac版本的安装包的百度云链接

版本

系统 :MacOS Catalina 10.15.4

JDK:jdk1.8.0_211

scala:scala 2.12

Hadoop:hadoop-2.7.7

spark:spark-2.3.0

Hbase:hase 1.3.5

命令终端:系统自带终端其环境参数在/.base_profile下,网上的教程有的是iTerm,其参数是/.zshrc中

1、SSH免密登录的配置

配置ssh是为了能实现免密登录,这样方便远程管理Hadoop并无需登录密码在Hadoop集群上共享文件资源。

- 生成SSH Keys:

ssh-keygen -t rsa -P ""

- 授权你的公钥到本地可以无需密码实现登录。上个命令会在当前用户目录中的.ssh文件夹中生成id_rsa文件,在执行如下命令:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

- 用如下的命令来测试是否可以进行免密登录

ssh localhost

问题汇总:

ssh的配置其实对于新Mac还是有个坑的,你可能按照教程依旧会有如下的报错:

链接拒绝:

ssh: connect to host localhost port 22: Connection refused

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ZgkrNODH-1592140702519)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20200613225400239.png)]

执行如下命令:

sudo systemsetup -f -setremotelogin on

又会出现如下错误:

setremotelogin: Turning Remote Login on or off requires Full Disk Access privileges.

这个问题的是Mac没有打开远程登录:

a、先查看有没有打开“远程登陆”系统偏好设置 -> 共享 -> 远程登录

b、打开sshd的权限,mac的隐私设置中终端sshd没有开启磁盘完全访问权限,勾选上

2、安装jdk1.8以及环境变量的配置

2.1、官网下载如下的JDK安装包,

我们需要1.8版本目前看最好:但是这个安装包需要十分繁琐的注册Oracle账号,嫌麻烦的百度云链接最后汇总奉上:

名称解释:8u211指的是java8版本号为211的JDK安装包

双击安装,一路Next

2.2、配置系统的环境变量:告诉系统环境你安装到哪了

如果是这种安装方式,那你的路径也应该是这个:“/Library/Java/JavaVirtualMachines/jdk1.8.0_211.jdk/Contents/Home”

-

打开.bash_profile(为啥是.bash_profile在“版本”模块讲过)

open ~/.bash_profile -

在文件末尾加入如下的一句话就是JAVA_HOME的路径(注意这里的Jdk如果不是我这个版本要换成自己的),保存

/Library/Java/JavaVirtualMachines/jdk1.8.0_211.jdk/Contents/Home -

使配置立即生效

source ~/.bash_profile -

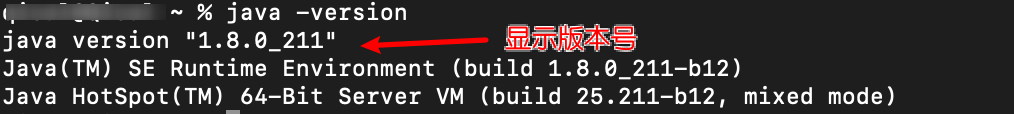

验证JDK1.8是否安装成功

java -version -

得到如下图片表示成功

3、安装Hadoop2.7.7

写这篇文档的区别就是从这开始的,就像我说的homebrew是安装最新版本的hadoop,也就是hadoop3.X 但是这个并不兼容,所以我们只能官网下载而抛弃homebrew,话说homebrew下载是真的香,我们要多配置一点东西

网上的文档有很多参数是配置不全的,实际跑起来还是有不少问题,尽量以我综合的为主吧

- 官网下载 然后解压到自己想放的目录,我这边是直接放到home目录,然后自己创建dev目录的,

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Wu6YdPch-1592140702526)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20200613233005694.png)]

-

同样安装包后面汇总到百度云

# 这个代码作参考,移动加解压 mv ~/Downloads/hadoop-2.7.7.tar.gz ~/dev/hadoop tar -zxvf hadoop-2.7.2.tar.gz -

在~/.bash_profile中添加hadoop的环境变量(比网上的有的要复杂,但都是有用的,建议添加)

-

再次提示配置忘环境后都要执行 source ~/.bash_profile来使你的环境变量立即生效

HADOOP_HOME="/Users/xxx/dev/hadoop/hadoop-2.7.7" export HADOOP_HOME export PATH=$PATH:HADOOP_HOME/sbin:$HADOOP_HOME/bin export LD_LIBRARY_PATH=$HADOOP_HOME/lib/native/ export HADOOP_COMMON_LIB_NATIVE_DIR=

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3329

3329

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?