在前面的文章中,我们介绍了 一种可解释性神经网络——xNN,而在本篇博客中,我们将要介绍一种针对前面文章的一种改进方法,使网络结构的可解释性更强,预测准确率更高。

文章名称:Enhancing Explainability of Neural Networks through Architecture Constraints

Enhancing Explainability of Neural Networks through Architecture Constraints

模型介绍

本博客所介绍的模型主体结构在上一篇博客(一种可解释性神经网络——xNN)已经介绍过,因此针对 xNN 基础模型不再做过多介绍。

其主体模型如下:

模型结构示意图:

但相较之前添加了下述一系列约束条件:

- 条件①表示L1正则化,使得参数W具有稀疏性,从而达到针对每个子网络变量筛选的目的。

- 条件②则是对相当于对子网络进行稀疏,选取部分重要的网络。

- 条件③对 ridge function ( h h h) 进行约束,控制函数的光滑程度。

- 条件④限制投影两两相互正交,可以减轻多重共线性因素对模型造成的影响,避免出现完全相同的 projection indexes( w j , j = 1 , … , k {w_j },j=1,…,k wj,j=1,…,k)。

- ⑤为规范化约束,保证模型的可识别性。

此外,文章还引入了 Importance Ratio (IR),可以直观展示每个子网络的重要性。

针对参数的优化,模型通过梯度下降法,对

W

\bf{W}

W 与除

W

\bf{W}

W 之外的参数进行交替优化。

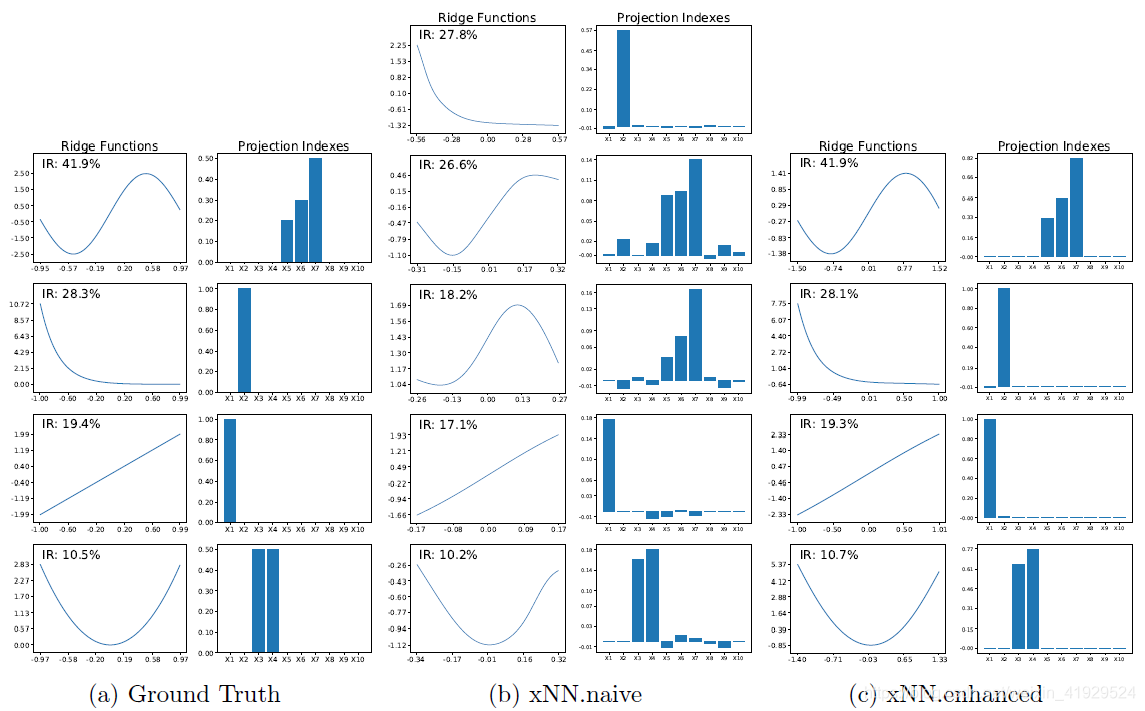

而后文章进行了多种不同的模拟(2种可加模型模拟;4种非可加模型模拟),并将每一行按照IR由大到小进行排序。

模拟实验

两种可加模型结果如下:模型都能够真实刻画出实际的 ridges functions 与对应的 projection indexs ,这是上一代 xNN 所做不到的。

而针对非可加模型,限于模型的假设,其可解释性依旧相对较弱,但却可以对 ridge functions 的重要性进行排序,同时结合每个子网络中选择的变量,间接对变量的重要性进行排序。并且还保持着较高的预测准确率。

但由于模型的假设所限,文章所提出的模型只是针对部分可加模型有非常好的可解释性,针对其他模型的解释性效果相对较差。

更多的模型细节请参见原文,传送门:Enhancing Explainability of Neural Networks through Architecture Constraints

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?