kafka学习笔记

kafka系列四、kafka架构原理、高可靠性存储分析及配置优化

kafka系列八、kafka消息重复和丢失的场景及解决方案分析

kafka消息的分发与消费与高级应用

springboot下 kafka 手动创建topic并指定分区(partition)数及分区副本(replica)数

Topic&Partition 的存储:

Partition 是以文件的形式存储在文件系统中,比如创建一个名为 firstTopic 的 topic,其中有 3 个 partition,那么在kafka 的数据目录(/tmp/kafka-log)中就有 3 个目录,firstTopic-0~3,命名规则是<topic_name>-<partition_id>,创建3个分区的topic:

sh kafka-topics.sh --create --zookeeper 192.168.254.135:2181 --replication-factor 1 --partitions 3 --topic firstTopic

kafka 消息分发策略:

消息是 kafka 中最基本的数据单元,在 kafka 中,一条消息由 key、value 两部分构成,在发送一条消息时,我们可以指定这个 key,那么 producer 会根据 key 和 partition 机制来判断当前这条消息应该发送并存储到哪个 partition 中。我们可以根据需要进行扩展 producer 的 partition 机制。

我们可以通过如下代码来实现自己的分片策略:

public class MyPartition implements Partitioner {//实现Partitioner接口

private Random random=new Random();<br>

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

//获得分区列表

List<PartitionInfo> partitionInfos=cluster.partitionsForTopic(topic);

int partitionNum=0;

if(key==null){

partitionNum=random.nextInt(partitionInfos.size()); //随机分区

}else{

partitionNum=Math.abs((key.hashCode())%partitionInfos.size());

}

System.out.println("key ->"+key+"->value->"+value+"->"+partitionNum);

return partitionNum; //指定发送的分区值

}

@Override

public void close() {

}

@Override

public void configure(Map<String, ?> configs) {

}

}

然后基于之前的代码在producer上需要在消息发送端增加配置:指定自己的partiton策略

properties.put(ProducerConfig.PARTITIONER_CLASS_CONFIG,“com.gupaoedu.kafka.MyPartition”);

消息默认的分发机制:

默认情况下,kafka 采用的是 hash 取模的分区算法。如果Key 为 null,则会随机分配一个分区。这个随机是在这个参数

”metadata.max.age.ms”的时间范围内随机选择一个。对于这个时间段内,如果 key 为 null,则只会发送到唯一的分区。这个值在默认情况下是 10 分钟更新一次。关 于 Metadata ,简单理解就是Topic/Partition 和 broker 的映射关系,每一个 topic 的每一个 partition,需要知道对应的 broker 列表是什么,leader是谁、follower 是谁。这些信息都是存储在 Metadata 这个类里面。

消费端如何消费指定的分区:

通过下面的代码,就可以消费指定该 topic 下的 0 号分区。其他分区的数据就无法接收。

//消费指定分区的时候,不需要再订阅

//kafkaConsumer.subscribe(Collections.singletonList(topic));

//消费指定的分区

TopicPartition topicPartition=new TopicPartition(topic,0);

kafkaConsumer.assign(Arrays.asList(topicPartition));

消息的消费原理:

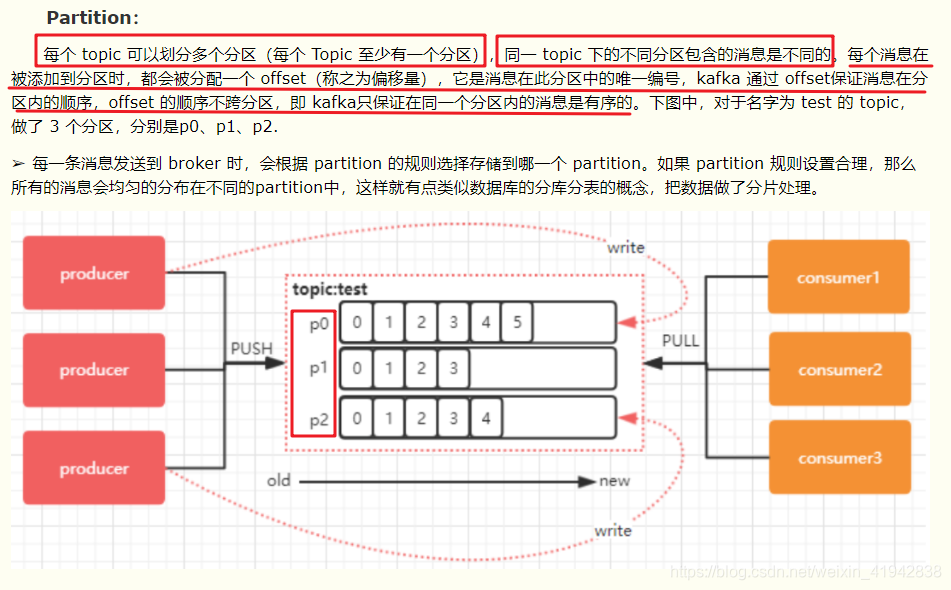

在实际生产过程中,每个 topic 都会有多个 partitions,多个 partitions 的好处在于,一方面能够对 broker 上的数据进行分片有效减少了消息的容量从而提升 io 性能。另外一方面,为了提高消费端的消费能力,一般会通过多个consumer 去消费同一个 topic,也就是消费端的负载均衡机制,也就是我们接下来要了解的,在多个 partition 以及多个 consumer 的情况下,消费者是如何消费消息的?kafka 存在 consumer group的 概 念 , 也 就是 group.id 一 样 的 consumer ,这些consumer 属于一个 consumer group,组内的所有消费者协调在一起来消费订阅主题的所有分区。当然每一个分区只能由同一个消费组内的 consumer 来消费,那么同一个consumer group 里面的 consumer 是怎么去分配该消费哪个分区里的数据的呢?举个简单的例子就是如果存在的分区输,即partiton的数量于comsumer数量一致的时候,每个comsumer对应一个分区,如果comsumer数量多于分区,那么多出来的数量的comsumer将不工作,相反则是其中将会有comsumer消费多个分区。

629

629

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?