点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop(已更完)

- HDFS(已更完)

- MapReduce(已更完)

- Hive(已更完)

- Flume(已更完)

- Sqoop(已更完)

- Zookeeper(已更完)

- HBase(已更完)

- Redis (已更完)

- Kafka(正在更新…)

章节内容

上节我们完成了如下的内容:

- 消费者的基本流程

- 消费者的参数、参数补充

序列化器

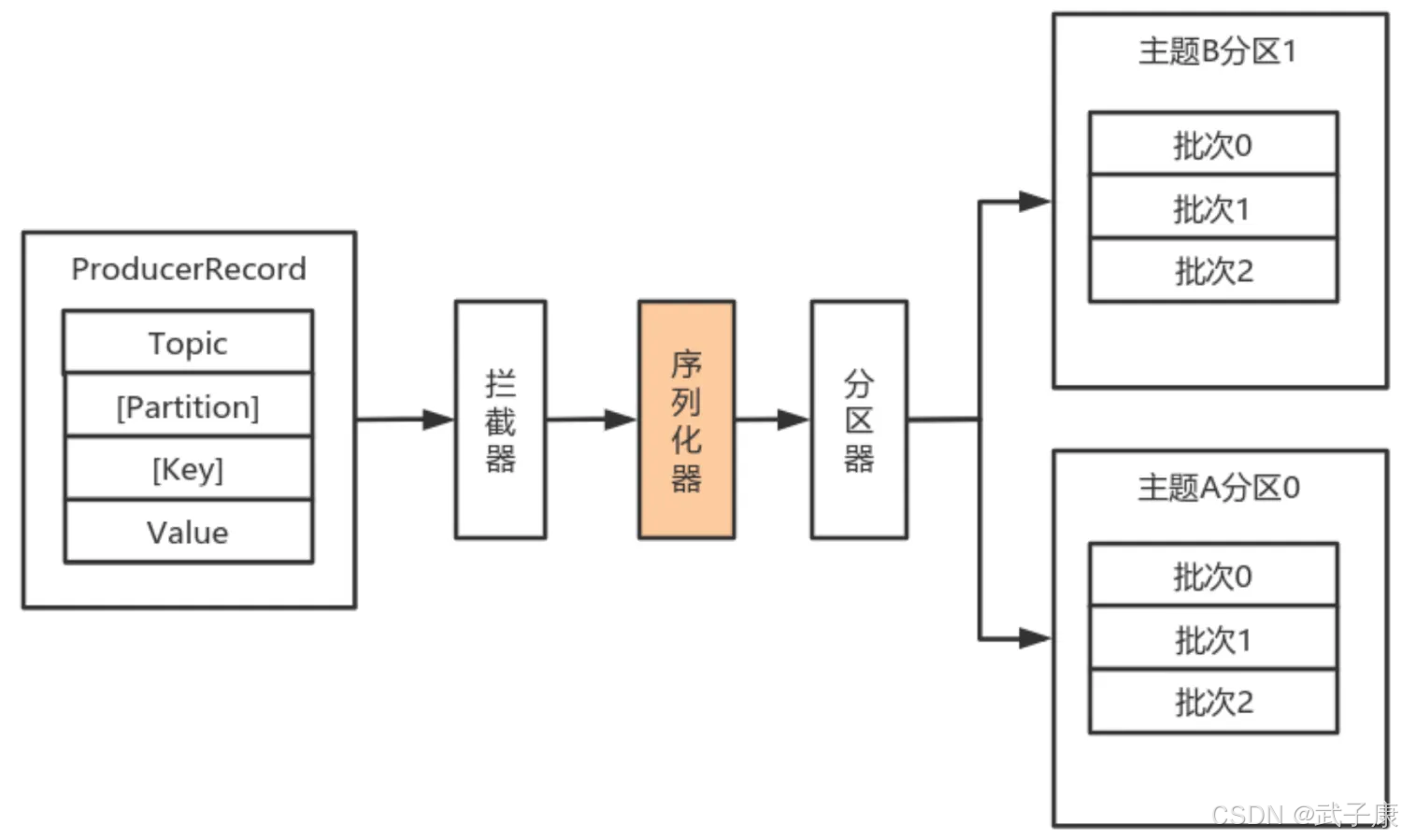

由于Kafka中的数据都是字节数组,在将消息发送到Kafka之前需要将数据序列化成为字节数组。

序列化器作用就是用于序列化要发送的消息的。

Kafka通过 org.apache.kafka.common.serialization.Serializer 接口用于定义序列化器,将泛型指定类型的数据转换为字节数据。

其中Kafka也内置了一些实现好的序列化器:

- ByteArraySerializer

- StringSerializer

- DoubleSerializer

- 等等… 具体可以自行查看

自定义序列化器

自定义实体类

实现一个简单的类:

实现序列化

注意对象中的内容转换为字节数组的过程,要计算好开启的空间!!!

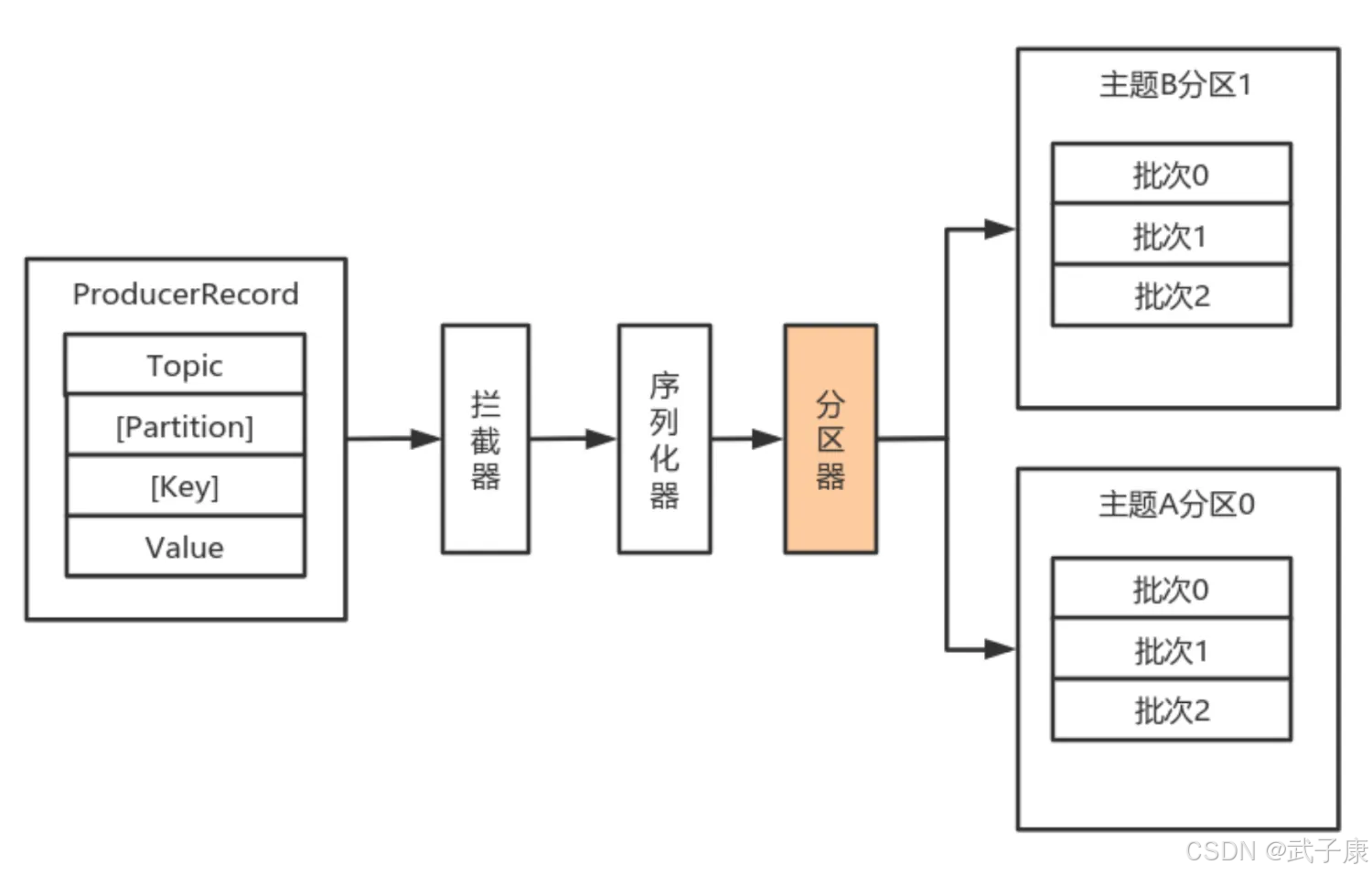

分区器

默认情况下的分区计算:

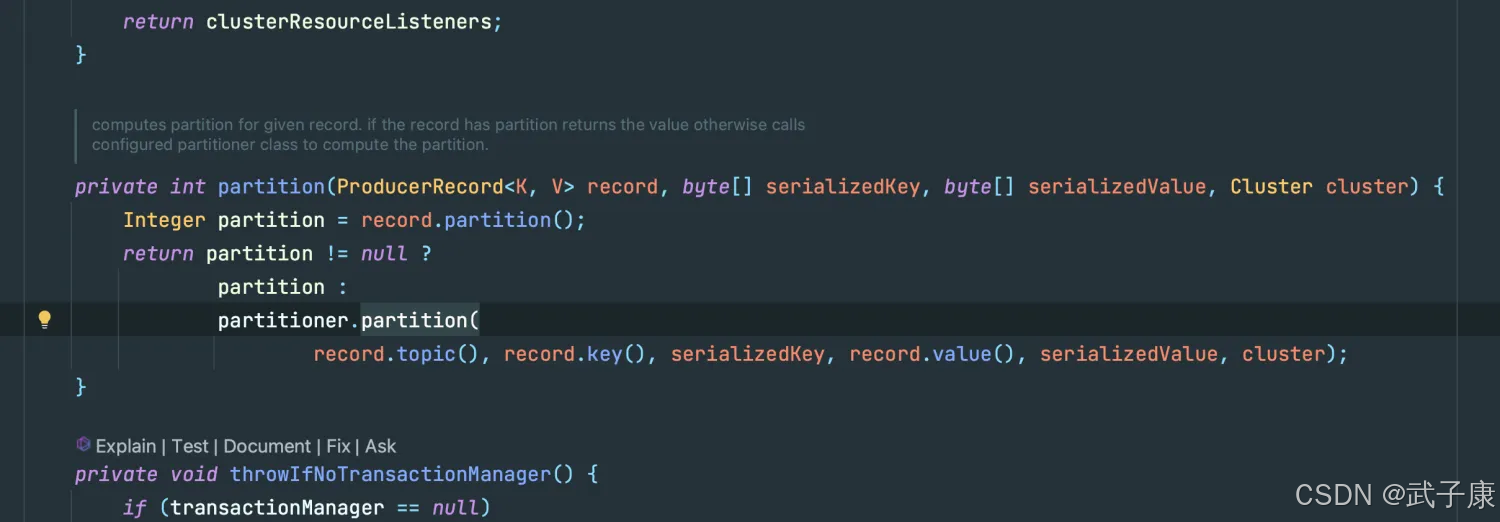

- 如果Record提供了分区号,则使用Record提供的分区号

- 如果Record没有提供分区号,则使用Key序列化后值的Hash值对分区数取模

- 如果Record没有提供分区号,也没有提供Key,则使用轮询的方式分配分区号

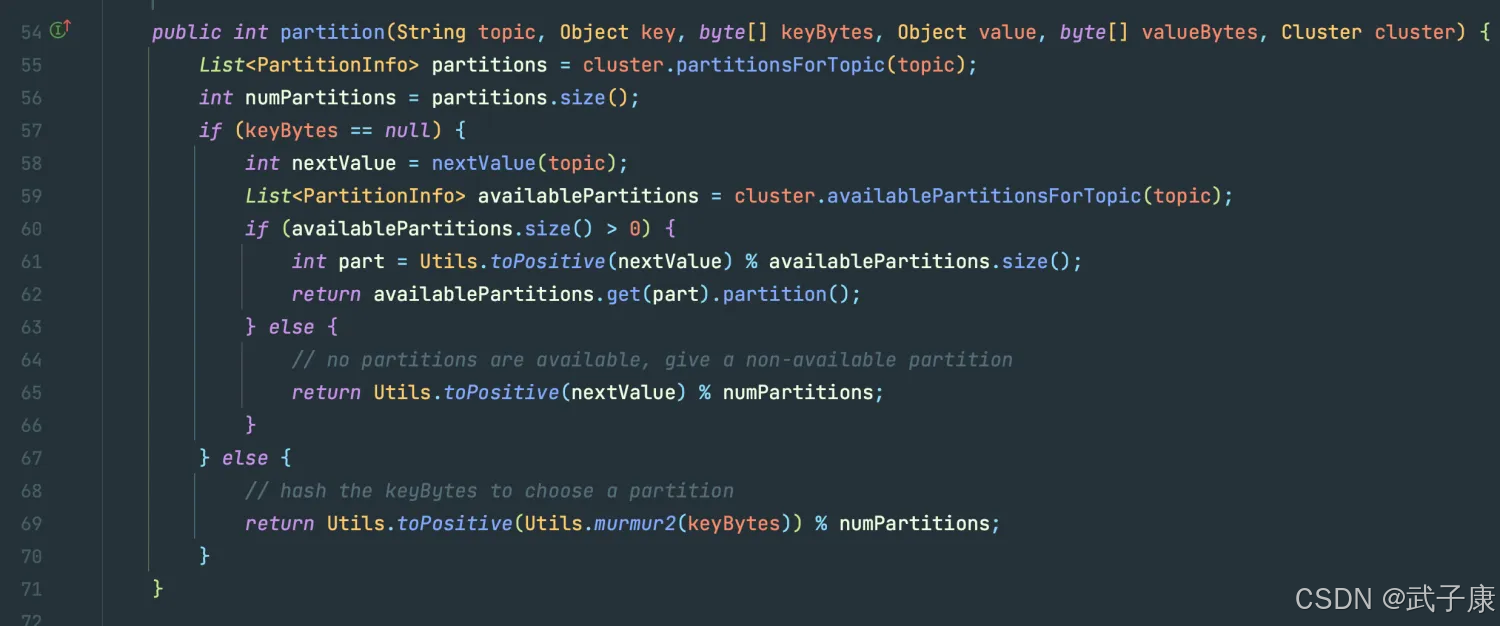

我们在这里可以看到对应的内容:

可以看到,如果 Partition 是 null的话,会有函数来进行分区,跟进去,可以看到如下方法:

自定义分区器

如果要自定义分区器, 需要:

- 首先开发Partitioner接口中的实现类

- 在KafkaProducer中进行设置:configs.put(“partitioner.class”, “xxx.xxx.xxx.class”)

649

649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?