12.6.3 RHCS+Oracle配置实战图解(10)

(3) 在左边的树状目录中选中server1.example.com,单击"Manage Fencing For This Node"。

(4) 选中"m_fencing",单击"Remove this Fence"

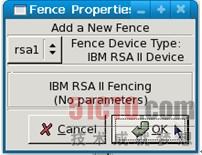

(5) 选中"Fence-Level-1",单击"Add a New Fence to this Level",在"Fence Properties"窗口的"Add a New Fence"下拉菜单中选择刚才建立的名为"rsa1"的设备,如图12-23所示。

图12-23 指定Fence Level使用的Fence设备

(6) 在节点server2.example.com上重复以上工作,将其与名为"rsa2"的设备进行绑定。

重新参考"系统服务cman启动"及"心跳线断链"部分的内容来进行测试操作,此时在服务器启动及系统切换的所有过程中,RHCS都会通过IBM RSA II的Fence机制来实现系统的自动关机及启动管理。

失效节点重新加入

服务器server2重新开机并启动系统后,通过启动系统服务cman及rgmanager可重新加入集群。

停止RHCS

需要手动停止RHCS服务时,请先停止rgmanager,然后再停止cman。

自动启动

在确认以上各个过程都能顺利操作后,可通过在两个服务器中执行以下操作来实现开机自动启动:[root@server1 ~]# chkconfig cman on

[root@server1 ~]# chkconfig rgmanager on

[root@server2 ~]# chkconfig cman on

[root@server2 ~]# chkconfig rgmanager on

注意:

1) 当所有服务器都处于关机状态且需要重新开机时,请确认服务器按先后顺序来启动,千万不要将多个集群节点服务器同时启动,因为这可能会由于启动时集群信息的不完整而导致服务器在启动过程中被Fence。

2) 若发现服务器启动时出现异常,可通过"单用户模式"来运行系统,将cman及rgmanager的启动状态设为off后再按步骤进行排错。

6. 通过Conga配置RHCS

除system-config-cluster外,RHCS还提供了另外一个用于配置集群的工具--Conga。与system-config-cluster不同的是,Conga基于B/S结构,因而可以在不同平台上对集群进行配置和管理。当前国内大部分用户的管理终端都是Windows系统,Conga是跨平台管理的***解决方案。

回顾本节最开始的"红帽集群套件RHCS安装"那部分内容,通过yum安装的luci和ricci就是Conga的组件。

(1) 首先,初始化Conga服务:[root@server1 ~]# luci_admin init

Initializing the luci server

Creating the 'admin' user

Enter password:

Confirm password:

Please wait...

The admin password has been successfully set.

Generating SSL certificates...

The luci server has been successfully initialized

You must restart the luci server for changes to take effect.

Run "service luci restart" to do so

(2) 启动Conga服务:[root@server1 ~]# /etc/init.d/ricci start

Starting ricci: [ OK ]

[root@server1 ~]# /etc/init.d/luci start

Starting luci: [ OK ]

Point your web browser to https://server1.

example.com:8084 to access luci

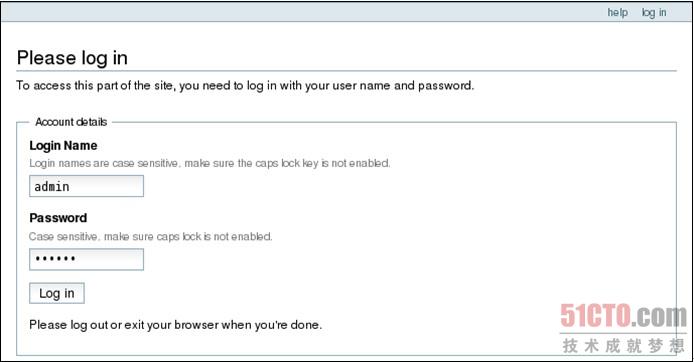

(3) 通过浏览器进入https://server1.example.com:8084或https//192.168.101.11:8084,如图12-24所示。

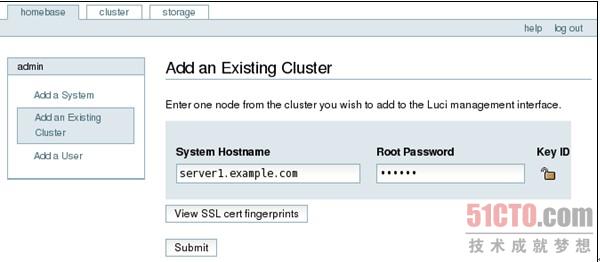

(点击查看大图)图12-24 Conga登录界面(4) 通过"homebase"|"Add an Existing Cluster",将前面已通过system-config-cluster的集群信息导入到Conga中进行管理,如图12-25所示。

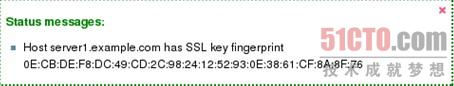

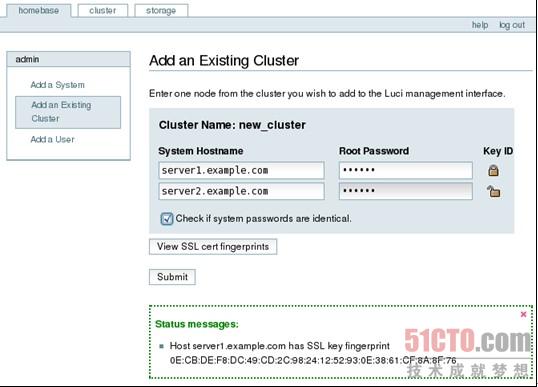

(点击查看大图)图12-25 将集群信息导入到Conga中(5) 在"System Hostname"及"Root Password"中分别填入其中一个节点的机器名及root管理员密码。需要注意的是,当前Conga只支持完整的机器名(要求格式为xxx.xxx.xxx)单击"View SSL cert fingerprints",将会看到图12-26所示的信息,然后单击"Submit"。

图12-26 server1的SSL key fingerprint(1)(6) 通过server1.example.com,Conga发现了一个名为new_cluster的集群并发现了新的节点server2.example.com,如图12-27所示。

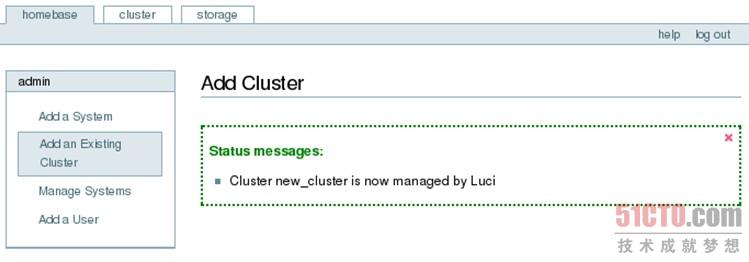

(点击查看大图)图12-27 server1的SSL key fingerprint(2)(7) 选中"Check if system passwords are identical"以确定两台服务器的root密码一致,单击"Submit",得到图12-28所示的结果,表明集群导入成功。

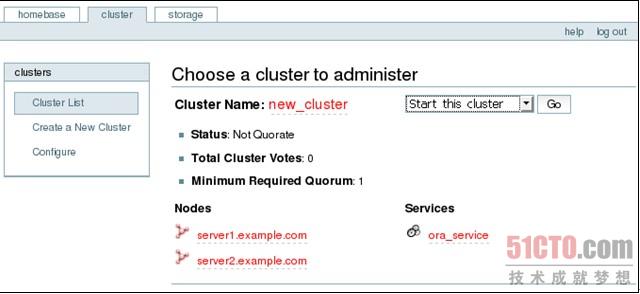

(点击查看大图)图12-28 集群new_cluster导入成功(8) 打开"cluster"标签页,如果当前集群还没有通过cman及rgmanager启动,那么将得到图12-29所示的界面。

(点击查看大图)图12-29 集群运行管理界面

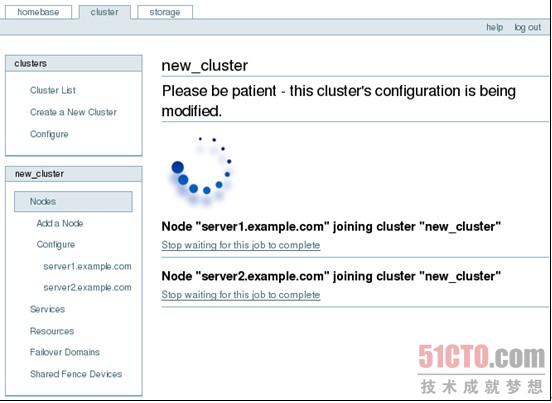

(9) 选择"Start this cluster"并单击"Go",此时集群服务cman及rgmanager会在两台服务器上启动,而不需要再逐一地对这两个服务进行启动操作,如图12-30所示。

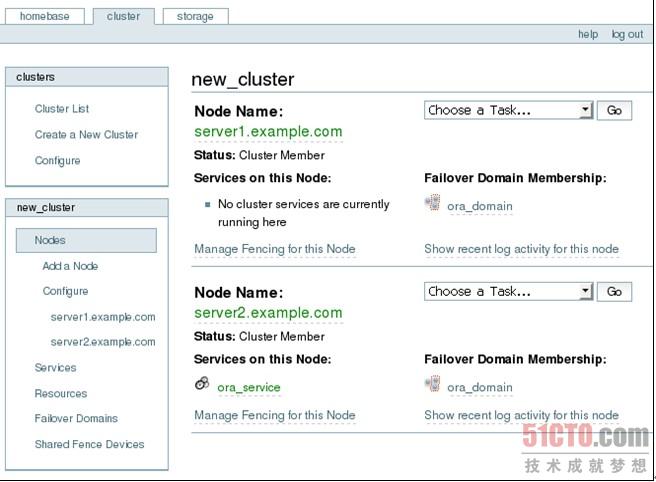

(10) 集群启动后,会自动跳转到图12-31所示的界面,通过此界面管理员可以对集群进行各种设定。每次设定修改提交后,新的设定信息会同步到集群中的各个节点,更新其cluster.conf文件并使新设置生效,这大大减轻了管理员的工作压力。

(点击查看大图)图12-30 通过Conga启动集群

(点击查看大图)图12-31 通过Conga来管理节点、Fence、服务及资源等

【责任编辑:云霞 TEL:(010)68476606】

点赞 0

956

956

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?