转载地址:https://blog.csdn.net/qq_27245709/article/details/53358103

之前的博客介绍过自己对于正则化的理解,经过这段时间的进一步接触,尤其是看了一些关于这一方面的paper,做了一些简短的实验,发现正则化真是一个很给力的建模方法。近期,看到了Laplacian Smoothing,相信很多童鞋遇到过这两个单词,但是,论文中关于这点的介绍往往都很“随意”,甚至出现了很多雷同,这里谈谈我对“拉普拉斯平滑”的一些理解。

首先,说说为什么要“平滑”,换句话说,平滑究竟有什么用。

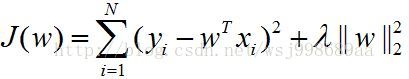

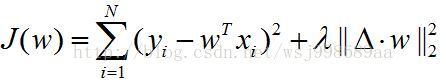

平滑的目的也是正则化的目的之一,它是针对参数w而言,本质上就是要使得w的变化不要那么剧烈,有如下数学模型(假设最小化J):

左侧是一个典型的线性回归模型,(xi,yi)就是实际的观测值,w就是估计的参数,右侧就是一个正则化项。可以直观的感受到,正则化项实际上起到了限制参数w的“变化程度或变化幅值”的作用,具体来说,它可以令w的任何一个分量相比较于剩余分量变化程度保持一致,不至于出现变化特别明显的分量。直接的作用就是防止模型“过拟合”,提高了模型的泛化性能。关于这一点,具体请见http://blog.csdn.NET/wsj998689aa/article/details/39547771

其次,知道了平滑,就开始说说拉普拉斯平滑到底是怎么一回事。这里分为两点介绍,先介绍定义,再介绍如何应用。

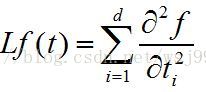

定义:假设f是定义在d维子空间中的一个实函数,该子空间上的拉普拉斯算子和拉普拉斯代价函数分别为:

数学上的定义一般是让人看不懂的,大家都喜欢听例子,我们现在想象一副图像,这幅图像如果含有噪声,或者色彩变化剧烈,就说明其不够平滑,那个算子就好比一个“小刷子”,不仅可以刷去“小黑点(噪声的一种)“,也可以模糊图像。而下面的代价函数就好比用这个”小刷子“去刷一整副图像,使得整幅图像变得平滑了。

然后,当d=2(图像就是2维的)的时候,并且积分号变成和号的时候(连续变为离散),就是拉普拉斯平滑在图像上的应用。

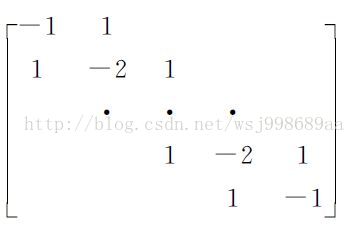

这种”小刷子“有很多种,下面就是一个比较经典的:

这种算子就是第二个公式的离散近似(具体名称:修正的Neuman),起到的作用就是二阶差分。一阶差分就是相邻元素xi,xi+1相减得到的值yi,二阶差分就是yi - yi+1,可以在纸上推推这个矩阵乘以一个向量。值得一提的是,二阶差分其实就起到了平滑(模糊)图像的作用,想通了有木有?

最后,聊聊拉普拉斯平滑在正则化上的应用,这个时候,它的名字往往就叫做”拉普拉斯惩罚“。惩罚的是谁?显然是参数w了!

说说背景,机器学习中,大部分算法直接将图像(假设为M*N)按行或者列拉成向量,这样肯定会损失结构化信息,结构化信息是啥?很好理解,一个像素本来和它周围8个像素都有关系,你直接给拉成向量了,那么这种关系就直接被你给毁掉了,这就叫空间结构信息。这种信息属于先验信息,NFL定理说的很清楚:能够尽可能利用先验信息的学习算法才是好算法。看来,空间结构信息的破坏,会降低算法的”品味“。别担心,拉普拉斯惩罚帮助你找回品味。

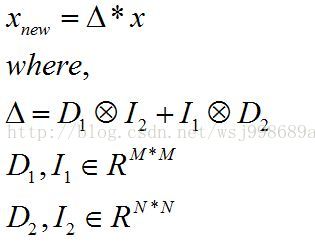

扯多了,回到正题,一幅图像拉成向量x(M*N维),如果我们要通过拉普拉斯惩罚,补偿x上失去的结构信息。很简单,如下式:

那个乘法是Kronecke积,相当于将乘号右边的每个元素替换成为左边矩阵数乘对应元素,如果A是一个 m x n 的矩阵,而B是一个 p x q 的矩阵,克罗内克积则是一个 mp x nq 的矩阵。

上述公式实际上起到的效果是,求一个矩阵中每个元素的水平方向和垂直方向的二阶差分之和,这个矩阵在这里可以被看错参数w的矩阵形式(按列reshape)。

进一步,如果我们对一个线性回归模型加上拉普拉斯惩罚,模型就会变为如下形式:

拉普拉斯惩罚使得模型更加平滑,比简单的2范数(岭回归)要好,因为它考虑了空间结构信息。常被用于PCA,LDA,LPP,NPE等子空间学习算法的改造上面,一般会使算法性能得到提升。

给出一篇参考文献,里面介绍的比较深刻,喜欢看英文的朋友可以仔细的看看《Learning a Spatially Smooth Subspace for Face Recognition》这篇文章。

上一篇博客,我介绍了《拉普拉斯平滑及其在正则化方向上的应用》,但是事后读一读,发现拉普拉斯惩罚这部分,自己说的太快了,想说的东西没有全部并有条理的说出来,于是决定再写写这块的东西,有什么错误,希望大家不吝批评指正,感激万分!

在说之前,我们先把如下几个问题想清楚:

1. 究竟什么是图像的空间结构信息?

2. 为什么在参数向量w(M*N维)上施加平滑约束,就代表着对图像空间结构信息的利用?

3. 对于参数向量w,什么叫做平滑?怎么度量呢?

这也是我最初很迷惑的地方,后来通过阅读相关文献,可能是想明白了,下面是我给出的答案。

1. 我们想想看一副图像,所谓空间信息,我的理解,图像一点的像素和它周围的像素的值之间的“大小关系”,就是空间结构信息,如果在低维空间中这种“大小关系”也能够保持,那么就相当于保持了图像的空间结构信息。

2. 再说说对参数向量w的平滑约束,说白了,也就是让相邻的分量尽可能的相等罢了。这样的话,w与一个图像(肯定是拉成向量之后的图像)相乘,图像像素与周围像素的大小关系得以保持,也就使得图像的空间结构信息得到保持!当然,也就代表对空间结构信息的利用了。

3. 关于这个问题,一般采用”最狠的“度量手段,就是相邻分量之差的平方和,如果这个平方和尽量小,那么相邻分量也就越接近,向量也就越平滑。

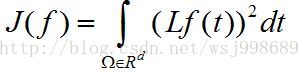

OK!回答完了这三个问题,下面就要回归题目了,拉普拉斯惩罚如下所示:

这个模型就是一个加了正则化项的线性回归模型,这个特定的正则化项就被称作拉普拉斯惩罚!

其具体形式如下:

其中,D1和D2均为拉普拉斯算子,而I1,I2就是单位矩阵,乘法是Kronecke积。

这样的话,假设图像x为M*N矩阵,那么对应的参数向量w就为M*N维的列向量,当算子采用修正的Neuman算子时(如下图所示),公式第一项起到的作用就是保持图像的列方向的空间结构(列方向上,相邻像素的大小关系保持不变),第二项起到的作用就是提取行方向的空间结构(列方向上,相邻像素的大小关系保持不变),两项加在一起,保持的自然就是图像整体的空间结构了。

我们再来看看拉普拉斯惩罚项,其具体可以展开成为如下形式:

上面的公式,实际上就代表了问题3所说的度量方式:相邻变量之差的平方和。让这个平方和越小,相邻的分量值也就越接近,参数向量w也就越平滑喽!这l时,还得再说说正则化的作用,最小化上述模型,通过正则化因子的”平衡作用“,如果参数因子变大,意味着参数向量w更加平滑,也就使得图像的空间结构信息得以越好的保持。

难道空间结构信息得以越好的保持,模型就越好吗?我认为答案是否定的,要看你的目的是什么,你觉得呢?

3902

3902

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?