Mysqld分三层,一个MGM用于管理配置,多个mysqld给应用程序提供访问,多个ndbd提供集群存储。mysqld的作用和一般的mysqld相同,不过加入的对NDB 数据存储的支持。数据是分散存储在每组ndb节点的,每组中ndb节点的数据相同,每组至少有一个ndbd保持运行状态才能访问数据。(组的分配参看NoOfReplicas参数)。ndb节点间保证数据的同步。

下面简单介绍下各个节点功能:

管理节点(MGM)

用于管理mysql集群里面的其他节点,比如配置数据、开启、停止和重启节点。由于该节点起到管理作用,所以需要最先启动该节点。

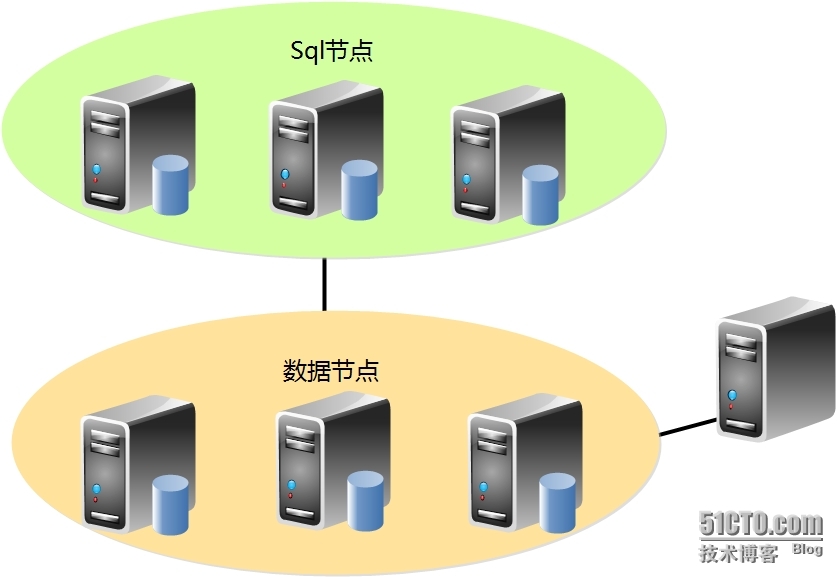

数据节点

用于保存mysql集群中的数据。

SQL节点

这是用来访问mysql集群数据的节点。对于MySQL集群,客户端节点是使用NDB存储引擎的传统MySQL服务器。

【实验环境】

Rhel6.3_x64

【实验架构】

【IP分配】

数据库管理节点: 192.168.30.113

数据库数据节点: 192.168.30.114 192.168.30.115

数据库sql节点: 192.168.30.114 192.168.30.115

注:实际生产环境中搭建mysql集群至少需要5台机器,由于是实验环境,这里我将数据节点和sql节点搭建在相同的两台服务器上。

【实验步骤】

一、管理节点的配置与安装

1、管理节点安装

[root@node1 src]# groupadd mysql

[root@node1 src]# useradd mysql -g mysql

[root@node1 src]# tar xf mysql-cluster-gpl-7.1.26-linux-x86_64-glibc23.tar.gz -C /usr/local/

[root@node1 src]# cd /usr/local/

[root@node1 local]# mv mysql-cluster-gpl-7.1.26-linux-x86_64-glibc23/ mysql

[root@node1 mysql]# scripts/mysql_install_db --user=mysql

2、管理节点配置

[root@node1 mysql]# mkdir /var/lib/mysql-cluster

[root@node1 mysql]# cd /var/lib/mysql-cluster/

[root@node1 mysql-cluster]# vim config.ini #手动创建并添加以下内容

[NDBD DEFAULT]

NoOfReplicas = 2

DataMemory = 80M

IndexMemory = 18M

[NDB_MGMD]

#Id = 1 // Id 可以不设置,系统会自动分配

Hostname = 192.168.30.113 // 管理节点IP

datadir = /usr/local/mysql/logs

[NDBD]

#Id = 2

Hostname = 192.168.30.114

datadir = /usr/local/mysql/data/ // 这里设置的路径应与my.cnf中的设置一样

[NDBD]

#Id = 3

Hostname = 192.168.30.115

datadir = /usr/local/mysql/data/

[MYSQLD]

[MYSQLD]

[root@node1 ~]# mkdir -p /usr/local/mysql/logs

二、安装配置数据节点

1、数据节点安装

[root@node2 ~]# groupadd mysql

[root@node2 ~]# useradd mysql -g mysql

[root@node2 ~]# cd /usr/src/

[root@node2 src]# tar xf mysql-cluster-gpl-7.1.26-linux-x86_64-glibc23.tar.gz -C /usr/local/

[root@node2 src]# cd /usr/local/

[root@node2 local]# mv mysql-cluster-gpl-7.1.26-linux-x86_64-glibc23/ mysql

[root@node2 local]# chown -R mysql.mysql mysql

[root@node2 local]# cd mysql/

[root@node2 mysql]# scripts/mysql_install_db --user=mysql

[root@node2 mysql]# cp support-files/my-medium.cnf /etc/my.cnf

[root@node2 mysql]# cp support-files/mysql.server /etc/init.d/mysqld

[root@node2 mysql]# vim /etc/my.cnf # 手动添加以下内容

datadir = /usr/local/mysql/data/

ndbcluster

ndb-connectstring = 192.168.30.113

[ndbd]

connect-string = 192.168.30.113

[mysql_cluster]

ndb-connectstring = 192.168.30.113

[ndb_mgm]

connect-string = 192.168.30.113

[ndb_mgmd]

config-file = /var/lib/mysql-cluster/config.ini //指定管理节点配置文件路径

三、启动服务

1、在管理节点上启动相关服务

[root@node1 ~]# /usr/local/mysql/bin/ndb_mgmd -f /var/lib/mysql-cluster/config.ini

[root@node1 ~]# netstat -nultp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:1186 0.0.0.0:* LISTEN 1372/ndb_mgmd

2、在数据节点启动相关服务

[root@node2 ~]# /usr/local/mysql/bin/ndbd --initial

2013-09-02 18:54:39 [ndbd] INFO -- Angel connected to '192.168.30.113:1186'

2013-09-02 18:54:39 [ndbd] INFO -- Angel allocated nodeid: 2

[root@node2 ~]# netstat -nultp

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 192.168.30.114:42629 0.0.0.0:* LISTEN 1440/ndbd

tcp 0 0 192.168.30.114:53542 0.0.0.0:* LISTEN 1440/ndbd

tcp 0 0 192.168.30.114:55500 0.0.0.0:* LISTEN 1440/ndbd

[root@node2 mysql]# service mysqld start

Starting MySQL.. ERROR! Manager of pid-file quit without updating file.

解决办法:

[root@node2 mysql]# scripts/mysql_install_db --user=mysql--datadir=/usr/local/mysql/data

[root@node2 mysql]# service mysqld start

Starting MySQL.. SUCCESS!

[root@node2 mysql]# netstat -nutlp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:3306 0.0.0.0:* LISTEN 2336/mysqld

四、测试

1、到管理节点查看下相关服务状态

[root@node1 ~]# cd /usr/local/mysql/bin

[root@node1 bin]# ./ndb_mgm

-- NDB Cluster -- Management Client --

ndb_mgm> show

Connected to Management Server at: localhost:1186

Cluster Configuration

---------------------

[ndbd(NDB)]2 node(s)

id=2@192.168.30.114 (mysql-5.1.67 ndb-7.1.26, Nodegroup: 0, Master)

id=3@192.168.30.115 (mysql-5.1.67 ndb-7.1.26, Nodegroup: 0)

[ndb_mgmd(MGM)]1 node(s)

id=1@192.168.30.113 (mysql-5.1.67 ndb-7.1.26)

[mysqld(API)]2 node(s)

id=4@192.168.30.114 (mysql-5.1.67 ndb-7.1.26)

id=5@192.168.30.115 (mysql-5.1.67 ndb-7.1.26)

可以看到这里的数据节点、管理节点、sql节点都是正常的.

2、现在我们在其中一个数据节点上进行相关数据库的创建,然后到另外一个数据节点上看看数据是否同步

[root@node2 mysql]# /usr/local/mysql/bin/mysql -uroot -p

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| ndb_2_fs |

| ndbinfo |

| test |

+--------------------+

5 rows in set (0.09 sec)

mysql> use test;

Database changed

mysql> CREATE TABLE cluster(id INT) ENGINE=NDB; //这里必须指定数据库表的引擎为NDB,否则同步失败

Query OK, 0 rows affected (0.48 sec)

mysql> INSERT INTO cluster values(1);

Query OK, 1 row affected (0.07 sec)

mysql> SELECT * FROM cluster;

+------+

| id |

+------+

| 1 |

+------+

1 row in set (0.00 sec)

现在到另外一个数据节点查看下是否同步过来

[root@node3 mysql]# /usr/local/mysql/bin/mysql -uroot -p

mysql> use test;

Database changed

mysql> SHOW TABLES;

+----------------+

| Tables_in_test |

+----------------+

| cluster |

+----------------+

1 row in set (0.14 sec)

mysql> SELECT * FROM cluster;

+------+

| id |

+------+

| 1 |

+------+

1 row in set (0.04 sec)

可以看到数据已经同步过来了,至此mysql集群搭建完毕

3、下面再做一下宕机测试,即停掉192.168.30.114这台机器的数据节点,看看mysql工作是否正常

[root@node2 bin]# ./ndb_mgm

-- NDB Cluster -- Management Client --

ndb_mgm> show

Connected to Management Server at: 192.168.30.113:1186

Cluster Configuration

---------------------

[ndbd(NDB)]2 node(s)

id=2@192.168.30.114 (mysql-5.1.67 ndb-7.1.26, Nodegroup: 0, Master)

id=3@192.168.30.115 (mysql-5.1.67 ndb-7.1.26, Nodegroup: 0)

[ndb_mgmd(MGM)]1 node(s)

id=1@192.168.30.113 (mysql-5.1.67 ndb-7.1.26)

[mysqld(API)]2 node(s)

id=4@192.168.30.114 (mysql-5.1.67 ndb-7.1.26)

id=5@192.168.30.115 (mysql-5.1.67 ndb-7.1.26)

从上面可以看到192.168.30.114这个节点是作为主节点的,现在停下这个节点

[root@node2 bin]# netstat -nutlp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 192.168.30.114:42629 0.0.0.0:* LISTEN 1440/ndbd

[root@node2 bin]# kill 1440

[root@node3 bin]# ./ndb_mgm

-- NDB Cluster -- Management Client --

ndb_mgm> show

Connected to Management Server at: 192.168.30.113:1186

Cluster Configuration

---------------------

[ndbd(NDB)]2 node(s)

id=2 (not connected, accepting connect from 192.168.30.114)

id=3@192.168.30.115 (mysql-5.1.67 ndb-7.1.26, Nodegroup: 0, Master)

[ndb_mgmd(MGM)]1 node(s)

id=1@192.168.30.113 (mysql-5.1.67 ndb-7.1.26)

[mysqld(API)]2 node(s)

id=4@192.168.30.114 (mysql-5.1.67 ndb-7.1.26)

id=5@192.168.30.115 (mysql-5.1.67 ndb-7.1.26)

可以看到192.168.30.114这个节点已经连接不上,而192.168.30.115这个节点成了主节点

现在在192.168.30.115这个节点上插入数据,接着恢复192.168.30.114这个节点,看数据能否同步过来

在192.168.30.115是上操作

[root@node3 bin]# /usr/local/mysql/bin/mysql -uroot -p

mysql> USE test;

Database changed

mysql> CREATE TABLE cluster1(id int)ENGINE=NDB;

Query OK, 0 rows affected (0.43 sec)

mysql> SHOW TABLES;

+----------------+

| Tables_in_test |

+----------------+

| cluster |

| cluster1 |

+----------------+

2 rows in set (0.06 sec)

mysql> INSERT INTO cluster1 values(1);

Query OK, 1 row affected (0.00 sec)

mysql> SELECT * FROM cluster1;

+------+

| id |

+------+

| 1 |

+------+

1 row in set (0.00 sec)

恢复节点192.168.30.115,看数据是否会同步过来

开启服务:

[root@node2 bin]# /usr/local/mysql/bin/ndbd --initial

[root@node2 bin]# /usr/local/mysql/bin/mysql -uroot -p

mysql> USE test;

Database changed

mysql> SHOW TABLES;

+----------------+

| Tables_in_test |

+----------------+

| cluster |

| cluster1 |

+----------------+

2 rows in set (0.32 sec)

mysql> SELECT * FROM cluster1;

+------+

| id |

+------+

| 1 |

+------+

1 row in set (0.12 sec)

可以看到数据同步过来了,至此实验完成!

注意:

从上面的实验可以看到,实际上mysql集群并不像其他集群系统那样能提供一个唯一的虚拟IP供外部程序调用。我们知道数据节点上的数据都是实时同步的,有人可能会说让外部程序调用任一数据节点不就可以了吗?反正数据是一致调用哪一个节点都一样。但这样是会有问题的万一这个节点断开,程序将访问不到数据,这时候也无法自动恢复过来。那么这种情况应该如何是好呢?

解决办法就是:在前端加多一个调度器,提供一个虚拟IP供外部程序调用,这个时候即使哪天某一台机器宕机,也不会造成过大影响。但是此时,这台调度器也将成为整个系统的瓶颈。解决的办法就是对调度器做双机热备!当主的调度器宕机,则启用备用调度器继续工作。

5544

5544

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?