简介:本方案利用树莓派实现语音交互功能,包括语音识别、语音合成和语音唤醒技术。介绍了开源语音识别引擎如Google Speech-to-Text API及科大讯飞SDK的运用,以及如何将文本转换为语音输出。详细解释了如何通过配置如Snowboy的语音唤醒工具使设备待机唤醒,舵机控制的实现以及远程视频应用的构建。提供了一个全面的框架,帮助开发者构建智能语音交互项目。

1. 树莓派简介与应用领域

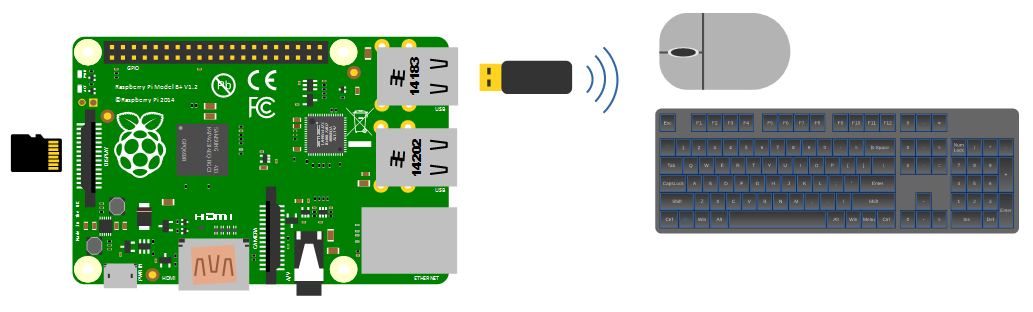

树莓派是一种低成本、信用卡大小的计算机,它的出现为广大爱好者和专业人士提供了一个强大的平台,来尝试各种DIY项目和应用开发。由于其小巧的尺寸和灵活的使用方式,树莓派在教育、原型设计、家庭自动化和嵌入式系统开发等领域中占有重要地位。

树莓派搭载了ARM处理器,提供了丰富的GPIO接口,用户可以利用这些接口连接各种传感器和外围设备,进行数据采集和控制。此外,树莓派支持多种操作系统,如Raspbian、Ubuntu等,这些系统提供了强大的软件库和开发工具,为开发者提供了便利。

随着技术的进步,树莓派还被应用到了更加复杂的领域,如人工智能、机器学习和IoT(物联网)等。它的高扩展性和社区支持使得树莓派成为实现这些技术的热门选择。在接下来的章节中,我们将详细探讨树莓派如何在语音识别、语音合成和语音唤醒等技术中发挥关键作用。

2. 语音识别技术的实现与工具选择

2.1 语音识别技术原理解析

2.1.1 语音信号处理基础

语音信号处理是语音识别技术的基础,它包括声音的采集、预处理、特征提取和模式匹配等步骤。在采集环节,一个高精度的麦克风至关重要,它负责将声音信号转换成模拟电信号。预处理步骤涉及去噪、端点检测等,目的是改善信号质量,去除无关信号。特征提取关注的是将时间信号转换成频域特征,常用的如梅尔频率倒谱系数(MFCC)。模式匹配则通过比较输入的特征向量与预先训练好的模型库中的模式,进行词语、句子的识别。

在树莓派上实施语音信号处理时,需要使用适当的库,例如使用Python语言时可以利用 librosa 库进行音频信号的分析和特征提取, numpy 库用于数值计算等。

import librosa

import numpy as np

# 读取音频文件

y, sr = librosa.load('audio.wav')

# 提取MFCC特征

mfcc = librosa.feature.mfcc(y=y, sr=sr)

# 显示前几个MFCC特征

print(mfcc[:, :10])

2.1.2 识别算法的类型与特点

语音识别的算法主要可以分为模板匹配和统计模型两类。模板匹配算法将输入语音与预存的语音模板进行比较;而统计模型如隐马尔可夫模型(HMM)和深度学习模型,是目前主流的语音识别算法。

深度学习模型特别是循环神经网络(RNN)和卷积神经网络(CNN)的组合,利用大量数据训练模型达到极高的识别率。Google的DeepSpeech就是一个很好的例子,使用了深度学习的语音识别技术。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 构建一个简单的LSTM模型

model = Sequential()

model.add(LSTM(256, input_shape=(None, mfcc.shape[0]), return_sequences=True))

model.add(LSTM(256))

model.add(Dense(units=256, activation='relu'))

model.add(Dense(units=num_classes, activation='softmax'))

# 编译模型

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10, batch_size=32)

2.2 语音识别工具的对比分析

2.2.1 开源工具与商业软件的评估

在语音识别工具中,开源工具如CMU Sphinx、Google Speech Recognition API和商业软件如Nuance Dragon和IBM Watson提供了不同的功能和性能。开源工具的优势在于可自由定制和成本较低,但可能在准确性和支持的语言数量上不及商业软件。商业软件通常提供更准确的识别结果和更完善的售后服务,但成本较高且使用限制较多。

选择时需要根据项目预算、项目需求(如语言支持、识别精度)、定制化程度以及后续技术支持等因素综合考虑。

2.2.2 工具选择的考量因素

在选择适合自己的语音识别工具时,需要评估多个因素。首先,语言支持是最重要的考量之一,需要确定所选工具是否支持你的目标语言。其次,准确性和处理速度也是不能忽视的因素,特别是实时应用中。此外,用户界面友好性、文档和社区支持都是重要的参考点。最后,API的易用性和灵活性也是项目实施过程中重要的方面。

2.3 语音识别项目实践案例

2.3.1 树莓派上实现语音识别的过程

在树莓派上实现语音识别,一般需要以下步骤:

1. 安装所需的库和依赖项,例如Python的 SpeechRecognition 和 PyAudio 。

2. 使用麦克风采集声音数据。

3. 使用语音识别库将音频信号转换成文本。

4. 输出识别结果或执行相应的操作。

# 安装必要的Python库

pip install SpeechRecognition

pip install PyAudio

import speech_recognition as sr

# 初始化识别器

recognizer = sr.Recognizer()

# 使用麦克风作为音频源

with sr.Microphone() as source:

print("请说话...")

audio = recognizer.listen(source)

# 识别音频

try:

text = recognizer.recognize_google(audio)

print("你说的话是: " + text)

except sr.UnknownValueError:

print("Google Speech Recognition 无法理解音频")

except sr.RequestError as e:

print("无法从Google Speech Recognition服务获取结果; {0}".format(e))

2.3.2 项目案例分析与总结

通过一个项目案例,我们可以看到,树莓派结合Python和开源语音识别库,可以完成一个简单的语音识别系统。案例中,我们成功地利用了Google的语音识别服务来识别通过树莓派麦克风采集的语音,并将识别出的文本打印出来。

进一步的优化可以考虑加入噪声过滤功能以提高识别准确率,在不同的环境噪音条件下测试系统的鲁棒性,并且可以考虑本地化语音识别引擎,减少对网络的依赖,提高实时性和数据隐私性。

3. 语音合成技术的介绍与实施

语音合成技术(Text-to-Speech, TTS)是人工智能领域的一个重要分支,它将文本信息转换成人类能够听懂的语音信息。随着技术的进步,TTS技术已经能够实现接近自然人的语音质量,广泛应用于智能助手、导航系统、客服机器人等多个领域。本章将详细介绍语音合成技术的原理、选择工具的方法以及在树莓派上的实践应用。

3.1 语音合成技术概述

语音合成技术的核心是将文字信息转换为语音信号。这一过程需要通过自然语言处理技术,理解文本内容的含义,并依据语调、语速、发音等信息将文本转换为模拟人声的语音信号。

3.1.1 文字转语音的原理

文字转语音(TTS)通常包括以下几个步骤:

- 文本预处理 :将输入的文本进行标准化处理,如分词、消除歧义等。

- 文本分析 :解析文本以确定发音、强调、语调等,这一步骤是TTS系统理解语言的关键。

- 声学模型 :将文本分析结果转换成声学特征。

- 声码器 :将声学特征转换为可播放的波形声音。

- 后处理 :对声音信号进行放大、滤波等处理,提升听感效果。

3.1.2 合成技术的分类及优缺点

语音合成技术按照实现方式可以分为以下几类:

- 基于规则的合成 :该方法依赖于语音学和语言学规则,生成清晰但可能缺乏自然感的声音。

- 统计参数合成 :使用大量数据训练出的声学模型,生成的声音更加自然流畅。

- 神经网络合成 :利用深度学习技术,通过神经网络直接从文本到声音信号,极大地提升了合成语音的质量和自然度。

每种方法都有其优缺点,其中基于规则的方法较为简单,但合成语音自然度不高;统计参数合成技术能够提供较为自然的语音,但需要大量数据和复杂的模型训练;神经网络合成技术目前是业界的主流,尽管模型训练复杂,但合成质量极高,是未来发展的趋势。

3.2 语音合成工具与库的选择

在开始一个语音合成项目之前,选择合适的工具和库是成功的关键。下面介绍一些流行的开源语音合成工具和库,以及如何根据项目需求来选择合适的工具。

3.2.1 常见的开源语音合成工具

- eSpeak :一个轻量级的开源语音合成引擎,支持多种语言,适合嵌入式和资源受限的环境。

- Festival :一个较为全面的语音合成系统,可进行多语言合成,适合研究和开发使用。

- MaryTTS :一个模块化的多语言语音合成平台,具有良好的扩展性和配置灵活性。

3.2.2 工具选择与集成策略

选择工具时需要考虑以下因素:

- 支持语言 :项目所需的语音合成语言是否被支持。

- 性能与资源 :系统资源是否足够支撑选定的工具。

- 扩展性 :是否需要自定义TTS功能,如语音、语调的定制。

- 易用性 :开发和维护的方便程度。

对于树莓派这样的嵌入式设备,推荐使用eSpeak这样的轻量级工具,它的资源占用较少,适合树莓派的处理能力。集成策略通常包括:

- 库的引入 :将语音合成库集成到项目中,例如在Python中通过pip安装eSpeak的Python接口。

- 系统集成 :将TTS工具配置为系统服务,方便在不同的应用中调用。

- API封装 :根据需要,封装TTS库的API,形成统一的调用接口。

3.3 语音合成应用实践

在树莓派上实现语音合成,可以给设备赋予“说话”的能力。本节将介绍如何在树莓派上实现语音合成,并通过案例展示实际的应用效果。

3.3.1 实现树莓派上的语音合成

在树莓派上实现语音合成的步骤可以概括如下:

-

安装eSpeak :使用以下命令安装eSpeak库:

bash sudo apt-get update sudo apt-get install espeak -

编写Python脚本 :创建一个Python脚本,利用eSpeak库的API进行文本到语音的转换。

python import os import espeak def text_to_speech(text): espeak.speak(text) return True if __name__ == '__main__': text = "Hello, this is a TTS test." if text_to_speech(text): print("TTS executed successfully.") else: print("TTS failed.") -

执行脚本 :运行上述Python脚本,树莓派将朗读指定的文本信息。

3.3.2 应用案例与效果评估

通过在树莓派上实现语音合成,可以开发出多种实用的项目。例如,可以创建一个语音提示的天气预报系统,每当有天气更新时,树莓派就会自动“说话”,播报天气情况。

效果评估通常需要考虑以下几点:

- 清晰度 :合成语音是否清晰,是否容易被听者理解。

- 自然度 :合成语音的自然程度,是否接近人类发音。

- 延迟性 :从输入文本到播放语音的时间延迟。

- 稳定性 :在长时间运行过程中的稳定性和可靠性。

通过综合评估,可以对语音合成系统进行优化,比如调整合成参数、更新语音库等,以达到最佳的听觉体验。

通过以上章节的内容,我们深入了解了语音合成技术的原理、工具选择以及在树莓派上的实际应用。这为进一步探索和开发树莓派语音相关的高级功能奠定了基础。

4. 语音唤醒技术的配置与优化

4.1 语音唤醒技术工作原理

语音唤醒技术是让设备能够通过听取用户的指令,从而被激活的一种功能。这种技术的关键在于能够在不同的噪声环境下准确地识别并响应用户的唤醒词或命令。本小节将详细介绍语音唤醒机制的基本概念及关键技术点。

4.1.1 唤醒机制的基本概念

语音唤醒系统通常由前端的唤醒词检测和后端的命令解析两个部分组成。唤醒词(也称为触发词或关键词)是预先设定的,用于激活设备监听的短语,它需要具有较高的独特性以减少误唤醒。在检测到唤醒词后,系统才会开始处理后续的命令,否则处于低功耗或休眠状态。

4.1.2 唤醒技术的关键技术点

语音唤醒技术包括音频信号的预处理、特征提取、模式匹配和决策算法等关键技术。预处理可以减少噪声和回声的干扰,特征提取则关注于如何高效地捕捉声音中的关键信息。模式匹配涉及将提取的特征与预先设定的唤醒词模板进行对比,而决策算法则负责判断是否达到唤醒阈值,以避免错误触发。

4.2 语音唤醒系统配置

在树莓派上配置语音唤醒系统涉及多个步骤,从准备工具和环境到测试系统的可靠性。本小节将详细介绍配置步骤与环境搭建、常见问题及对策。

4.2.1 配置步骤与环境搭建

首先,需要一个树莓派设备,一个麦克风以及一个扬声器或耳机。接下来的配置步骤大致包括:

- 安装操作系统和必要的依赖库。

- 安装和配置音频处理和语音识别库。

- 设置音频输入输出设备。

- 运行唤醒词检测程序,并进行调整以适应环境噪音水平。

# 安装依赖库和工具(以Python为例)

sudo apt-get update

sudo apt-get install -y python-pyaudio python3-pyaudio

sudo pip install pocketsphinx

4.2.2 配置过程中的常见问题及对策

在配置过程中,可能会遇到的问题包括声音质量问题、音频设备兼容性问题或系统性能瓶颈等。以下是一些对策:

- 声音质量不佳 :可能由麦克风质量、环境噪音或距离导致,使用噪声抑制算法或调整麦克风位置可改善。

- 音频设备不兼容 :确认树莓派已正确检测到音频输入输出设备,有时可能需要手动选择设备。

- 系统性能瓶颈 :优化音频处理算法,降低采样率和位深度,或者关闭其他不必要的进程。

4.3 唤醒系统的优化与测试

为了确保语音唤醒系统在实际使用中具备较高的准确性和可靠性,需要对其执行优化并进行测试。本小节将讨论提升识别率的优化技巧和实际使用场景下的测试与评估。

4.3.1 提升识别率的优化技巧

优化识别率可以通过多种方法实现:

- 调整唤醒词 :选择一个不太常见,且容易区分的唤醒词。

- 适应性学习 :通过用户反馈不断调整唤醒词模型。

- 噪声消除 :使用环境噪声消除算法,提高唤醒词的识别准确性。

4.3.2 实际使用场景下的测试与评估

测试应模拟真实使用环境,包括不同的噪音条件、声音强度和距离等。评估指标可能包括:

- 唤醒率 :成功唤醒的次数与尝试次数的比例。

- 误唤醒率 :未执行唤醒词而错误激活的次数。

- 响应时间 :从发音唤醒词到系统响应所需的时间。

下面是一个简单的Python脚本,用于演示如何使用Pocketsphinx进行语音唤醒的测试:

import speech_recognition as sr

# 初始化识别器

recognizer = sr.Recognizer()

# 从麦克风获取音频输入

with sr.Microphone() as source:

print("请说出唤醒词...")

audio = recognizer.listen(source)

try:

# 使用Pocketsphinx识别唤醒词

text = recognizer.recognize_sphinx(audio, language='en-US')

print(f"你说了: {text}")

# 这里可以加入检查是否为特定唤醒词的逻辑

except sr.UnknownValueError:

print("无法理解音频")

except sr.RequestError:

print("语音服务出错")

通过上述测试与评估,可以对系统进行进一步的调整,以提高其性能。

测试表格

下面是一个用于记录不同场景下测试结果的表格。

| 测试次数 | 唤醒词 | 噪音条件 | 声音强度 | 唤醒距离 | 唤醒率 | 误唤醒率 | 响应时间 |

|---|---|---|---|---|---|---|---|

| 1 | 开启设备 | 无噪声 | 中等 | 1米 | 100% | 0% | 0.8秒 |

| 2 | 开启设备 | 室外 | 较低 | 0.5米 | 90% | 1% | 1.5秒 |

| … | … | … | … | … | … | … | … |

Mermaid流程图

一个典型的语音唤醒流程可由以下流程图表示:

graph TD

A[开始] --> B{环境检测}

B --> |有唤醒词| C[唤醒系统]

B --> |无唤醒词| D[保持休眠]

C --> E[处理命令]

E --> F[等待下一次唤醒]

D --> A

以上内容完成了第四章节的核心阐述,涵盖了语音唤醒技术的原理、系统配置、优化与测试等关键知识点。

5. 树莓派高级功能拓展

5.1 舵机控制与GPIO接口应用

树莓派的GPIO(通用输入输出)接口是一个强大且灵活的工具,允许用户连接各种电子组件,并通过编程控制它们。对于需要物理动作的应用,如机器人制作或自动化项目,控制舵机是一种常见的需求。

5.1.1 GPIO接口的工作原理

GPIO接口提供了26个引脚,其中包含8个GPIO引脚。每个引脚都可以被配置为输入或输出状态,并可以进行软件编程控制。在控制舵机时,我们通常使用PWM(脉冲宽度调制)信号,它允许我们发送一定宽度的脉冲信号,从而控制舵机的角度。

5.1.2 树莓派控制舵机的方法

树莓派控制舵机一般需要使用PWM库,比如 RPi.GPIO 或 gpiozero 。以下是使用 RPi.GPIO 库的一个简单示例代码,它演示了如何控制舵机转动到特定的角度:

import RPi.GPIO as GPIO

import time

# 设置GPIO模式为BCM

GPIO.setmode(GPIO.BCM)

# 设置GPIO引脚,连接到舵机的控制线(通常是GPIO17)

PIN = 17

GPIO.setup(PIN, GPIO.OUT)

# 设置PWM频率为50Hz,这是舵机通常的控制频率

pwm = GPIO.PWM(PIN, 50)

pwm.start(0)

def set_servo_angle(angle):

# 舵机的控制信号周期通常是20ms(50Hz)

# 脉冲宽度与角度的对应关系依赖于舵机型号

pulse_width = 0.05 + (0.05 * 2) * (angle / 180)

pwm.ChangeDutyCycle(pulse_width)

time.sleep(0.5)

pwm.ChangeDutyCycle(0)

try:

# 将舵机设置到0度

set_servo_angle(0)

# 做一些其他的事情...

# 将舵机设置到90度

set_servo_angle(90)

# 做一些其他的事情...

# 将舵机设置到180度

set_servo_angle(180)

finally:

pwm.stop()

GPIO.cleanup()

这段代码首先设置了GPIO模式,然后配置了一个PWM信号,最后定义了一个函数 set_servo_angle 来设置舵机的角度。请注意,具体的脉冲宽度可能需要根据你的舵机型号进行调整。

5.2 远程视频功能的构建

随着物联网(IoT)的发展,远程视频功能在家庭自动化、安全监控和远程控制等方面的应用变得越来越普遍。利用树莓派的GPIO接口和网络功能,我们可以构建一个简单的远程视频监控系统。

5.2.1 视频流媒体技术介绍

视频流媒体技术允许我们在网络上实时传输视频。一种常见的方法是使用RTSP(实时流协议)进行视频流的传输。树莓派可以通过安装如 motion 的软件包来实现视频流的捕获和传输。

5.2.2 构建远程视频监控系统的方法

构建远程视频监控系统主要包括以下几个步骤:

- 安装并配置摄像头模块,如Raspberry Pi Camera。

- 安装

motion软件包。 - 配置

motion的配置文件,以适应你的需求。 - 通过浏览器或其他视频流客户端访问你的视频流。

以下是一个简单的示例说明如何安装和启动 motion :

sudo apt-get update

sudo apt-get install motion

安装完成后,编辑 /etc/motion/motion.conf 文件以配置摄像头和网络设置。

启动 motion 服务:

sudo service motion start

之后,你可以在浏览器中输入 http://<树莓派的IP地址>:8080 来访问视频流。

5.3 综合应用案例

综合应用案例会将我们在本章中讨论的各个高级功能结合起来,实现一个特定的项目。

5.3.1 案例项目的设计思路

假设我们正在设计一个室内环境监测系统。系统需要能够远程查看室内情况、检测环境参数(如温度、湿度等)并控制室内设备(如加热器、风扇等)。为了实现这些功能,我们可能需要:

- 使用树莓派的GPIO接口控制加热器、风扇等设备。

- 利用树莓派的GPIO连接温度和湿度传感器。

- 使用树莓派摄像头模块和

motion软件包来实现远程视频流。

5.3.2 实际效果展示与讨论

实现上述功能后,用户能够通过一个网页界面查看室内实时视频流,同时查看温度和湿度等数据。此外,用户可以通过该界面发送指令,控制加热器或风扇的开关。

这样的系统可以被进一步扩展,例如,加入人工智能算法,通过图像识别判断室内是否有人,从而自动开启或关闭相应的设备,为用户节省能源。

以上就是第五章“树莓派高级功能拓展”的内容。通过本章,我们了解了如何利用树莓派的GPIO接口进行舵机控制、构建远程视频功能,并通过一个综合应用案例来展示这些功能的实际应用。这些高级功能的掌握将使你能够设计出更复杂、实用的树莓派项目。

简介:本方案利用树莓派实现语音交互功能,包括语音识别、语音合成和语音唤醒技术。介绍了开源语音识别引擎如Google Speech-to-Text API及科大讯飞SDK的运用,以及如何将文本转换为语音输出。详细解释了如何通过配置如Snowboy的语音唤醒工具使设备待机唤醒,舵机控制的实现以及远程视频应用的构建。提供了一个全面的框架,帮助开发者构建智能语音交互项目。

1534

1534

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?