简介:DBF文件格式在数据存储与交换中的重要性,以及其在股票行情数据传输中的应用。介绍DBF文件结构和核心任务,包括使用代码读取DBF文件、数据处理、合并数据和数据传输。详细说明了错误处理与日志记录的重要性,并以 Send_Convert 脚本为例,解释了实现股票行情数据传输的具体步骤。

1. DBF文件格式及其在数据传输中的应用

1.1 DBF文件格式概述

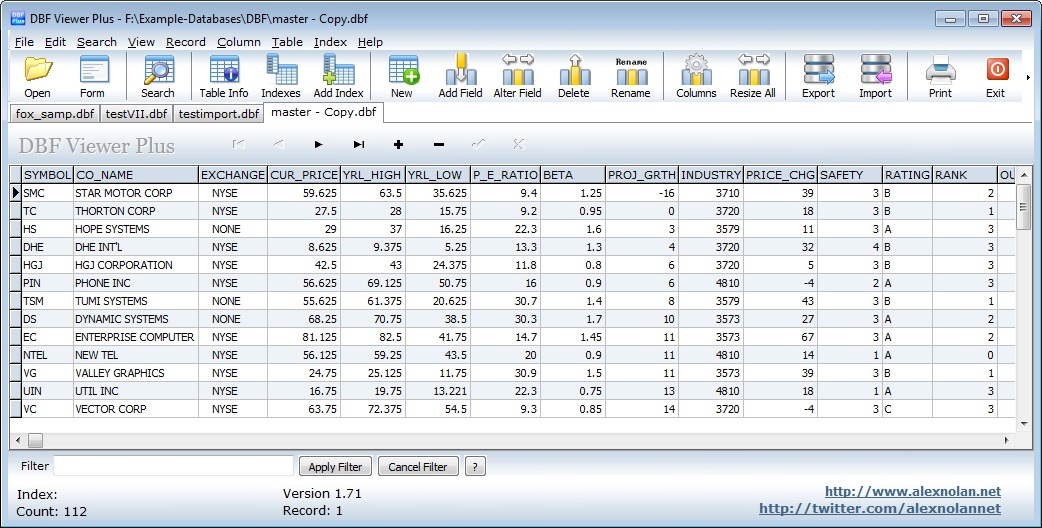

DBF文件格式是一种早期广泛使用的数据表格式,它支持多种数据类型,包括数字、字符、日期等,是数据传输和交换的常用格式之一。DBF文件具有简单、高效的特点,能够快速地被多种程序读写,这使得它在数据转换和处理方面具有独特的价值。

1.2 DBF文件在数据传输中的角色

在数据交换过程中,DBF文件充当了中间桥梁的角色。由于它的广泛支持和兼容性,DBF文件常被用于不同系统和平台间的数据导出导入。通过DBF,可以实现快速的数据集成和迁移,特别是在需要兼容老旧系统的场景下,DBF文件提供了一种稳定可靠的数据交互方式。

2. 股票行情数据处理的代码实现

2.1 股票数据结构分析

股票数据的结构通常涉及股票代码、开盘价、最高价、最低价、收盘价、成交量等多个字段。为了有效地处理这些数据,需要对数据结构进行深入的分析和定义。

2.1.1 数据字段的定义与格式

在处理股票数据前,明确数据字段的定义和格式至关重要。例如,股票代码通常为字符串格式,价格则为浮点数,成交量为整数。这些字段的定义直接影响到后续的数据读取和处理逻辑。

# 示例代码块 - 数据结构定义

class StockData:

def __init__(self, code: str, open_price: float, high_price: float,

low_price: float, close_price: float, volume: int):

self.code = code

self.open_price = open_price

self.high_price = high_price

self.low_price = low_price

self.close_price = close_price

self.volume = volume

2.1.2 股票行情数据的时间序列特性

股票行情数据具有明显的时间序列特性。这意味着数据是按时间顺序排列的,且相邻数据间存在时间间隔。处理这类数据时,时间戳的准确性和数据的时序性是分析股票价格走势的基础。

# 示例代码块 - 时间序列数据处理

import pandas as pd

# 读取数据并转换为DataFrame

data = pd.read_csv('stock_data.csv')

# 设置时间列为索引

data['date'] = pd.to_datetime(data['date'])

data.set_index('date', inplace=True)

2.2 代码实现的逻辑框架

在实现股票数据处理的代码时,需要构建一个清晰的逻辑框架,包括初始化设置以及数据处理函数的封装与调用。

2.2.1 数据读取的初始化设置

读取股票数据通常涉及文件的打开、读取与关闭。确保初始化设置正确可以避免在数据处理过程中发生错误。

# 示例代码块 - 数据读取初始化设置

import pandas as pd

# 数据文件路径

file_path = 'path/to/stock_data.csv'

# 读取数据,跳过开头的标题行

data = pd.read_csv(file_path, header=0)

# 显示数据的前几行

print(data.head())

2.2.2 数据处理的函数封装与调用

为了提高代码的复用性和可维护性,将常用的数据处理逻辑封装成函数是一个好的实践。这样可以使得主程序逻辑更加清晰,也便于调试和优化。

# 示例代码块 - 数据处理函数封装与调用

def clean_data(df):

# 清洗数据,例如去除空值

df.dropna(inplace=True)

# 删除重复数据

df.drop_duplicates(inplace=True)

return df

# 调用函数处理数据

cleaned_data = clean_data(data)

接下来,我们会详细介绍股票行情数据的处理方法、数据合并技术、数据传输机制以及错误处理等相关技术,为股票数据分析提供一个全面的技术框架。

3. 数据读取和文件操作技巧

3.1 DBF文件的数据读取方法

3.1.1 文件打开与关闭的管理

DBF文件是一种常见的数据存储格式,广泛应用于各种数据管理系统中。在读取DBF文件之前,首先需要了解如何打开与关闭DBF文件,这是文件操作中最基本也是最重要的一环。有效的文件管理不仅保证了数据的安全性,而且提高了程序的健壮性和效率。

在Python中,可以使用标准库中的 open 函数来打开一个DBF文件。一般而言,文件打开后需要确保在使用完毕后能够及时关闭,避免内存泄漏。在较旧版本的Python中,通常推荐使用 try-finally 语句确保文件正确关闭,而在Python 3.3及以上版本中,推荐使用 with 语句,它可以自动管理文件的打开与关闭。

# 使用 with 语句打开和关闭 DBF 文件

with open('example.dbf', 'rb') as f: # 以二进制读模式打开DBF文件

# 在这里进行文件操作...

pass # pass 是一个占位符,示意在这一块代码中进行数据处理

# 使用 with 语句后,即使在文件操作过程中发生异常,文件也会被正确关闭

3.1.2 高效遍历记录的策略

DBF文件通常包含大量记录,高效地遍历这些记录对于处理大量数据至关重要。在遍历DBF文件记录时,应避免一次性将所有数据加载到内存中,这样不仅消耗大量内存资源,也可能导致程序崩溃。因此,推荐使用逐条读取的方式,这样可以逐步处理数据,同时减少内存的使用。

dbf 库提供了逐条访问DBF文件记录的接口,下面展示如何使用该库高效地遍历DBF文件中的记录:

import dbf

# 打开 DBF 文件

db = dbf.Dbf('example.dbf', new=False)

# 遍历 DBF 文件中的记录

for record in db:

# 在这里处理每一条记录...

print(record.field('field_name')) # 以字段名的方式获取数据

# 关闭 DBF 文件

db.close()

3.2 文件操作的最佳实践

3.2.1 批量处理与内存管理

在处理大量数据时,一个常见的实践是将数据分批次进行处理,以减少内存消耗并提高处理效率。在DBF文件操作中,这意味着不需要一次性读取所有记录,而是可以定义一个固定的块大小,分批次处理数据。

例如,可以实现一个函数,该函数接受一个DBF文件路径和一个处理函数,然后按照设定的块大小将记录分批次传递给该处理函数:

def process_in_chunks(dbf_path, process_function, chunk_size=100):

with open(dbf_path, 'rb') as f:

db = dbf.Dbf(f)

record_count = 0

chunk = []

for record in db:

chunk.append(record)

record_count += 1

if record_count % chunk_size == 0:

process_function(chunk)

chunk = []

# 处理剩余的记录(如果有的话)

if chunk:

process_function(chunk)

db.close()

# 示例处理函数

def my_process_function(chunk):

# 在这里定义对块的处理逻辑...

print("Processing chunk with", len(chunk), "records")

process_in_chunks('example.dbf', my_process_function)

3.2.2 文件损坏与备份机制

文件操作的一个重要方面是确保数据的安全性。当处理大量重要数据时,文件损坏的风险不可忽视。因此,制定备份策略和及时进行数据备份是必须的。在DBF文件操作中,可以编写辅助脚本在备份前验证文件的完整性,并定期将数据复制到备份位置。

此外,一些DBF库提供了文件修复的功能,可以在文件损坏时尝试恢复数据。 dbf 库就支持这样的功能。下面是一个使用 dbf 库备份并尝试修复DBF文件的例子:

import dbf

import shutil

# 备份 DBF 文件

def backup_dbf(file_path, backup_path):

shutil.copyfile(file_path, backup_path)

# 尝试修复 DBF 文件

def repair_dbf(file_path):

db = dbf.Dbf(file_path, writeable=True)

try:

db.reIndex() # 尝试重建索引

db.repack() # 尝试修复文件结构

print("File is repaired successfully.")

except dbf.DbfError as e:

print("Error repairing the file:", e)

finally:

db.close()

# 使用示例

original_file = 'example.dbf'

backup_file = 'example_backup.dbf'

backup_dbf(original_file, backup_file)

repair_dbf(original_file)

通过实现上述策略,可以最大限度地确保数据在操作过程中的安全性和完整性。

4. 数据清洗与转换的方法

在数据处理领域,数据清洗与转换是至关重要的环节,确保数据的质量和可用性,为后续的数据分析和决策提供准确的信息基础。本章旨在详细介绍数据清洗与转换的方法,为读者提供一个系统化的数据处理框架。

4.1 数据清洗的步骤与技术

4.1.1 空值、异常值的处理

在数据集中,空值和异常值是常见的问题。空值可能是由于数据收集不完整或者记录被删除而产生的,异常值可能是由于错误或者数据输入不规范导致的。这两种情况都可能对数据分析结果产生负面影响。

空值处理

空值的处理方法包括删除含有空值的记录、用统计方法(如平均值、中位数)填充空值,或者使用基于模型的方法预测填充空值。以Python为例,我们可以使用 pandas 库中的 dropna() 、 fillna() 、 interpolate() 等方法来处理空值。

import pandas as pd

# 创建示例数据框

data = {'A': [1, 2, None, 4], 'B': [5, None, None, 8]}

df = pd.DataFrame(data)

# 删除含有空值的记录

df_cleaned = df.dropna()

# 使用平均值填充空值

df_filled = df.fillna(df.mean())

# 使用线性插值填充空值

df_interpolated = df.interpolate()

在上述代码中, dropna() 函数用于删除数据框中包含空值的记录, fillna() 函数则用来填充数据框中的空值,可以指定具体的填充值或者使用统计方法计算的填充值, interpolate() 函数则用于进行线性插值,填补数据中的空值。

异常值处理

异常值通常通过统计分析方法检测,例如标准差法、IQR(四分位距)法等。一旦检测到异常值,可以考虑将其删除或者替换为合理的数值。这里展示使用IQR方法来处理异常值的代码示例:

# 假设df是一个已经加载的数据框

Q1 = df.quantile(0.25)

Q3 = df.quantile(0.75)

IQR = Q3 - Q1

# 移除异常值

df_no_outliers = df[~((df < (Q1 - 1.5 * IQR)) | (df > (Q3 + 1.5 * IQR))).any(axis=1)]

上述代码计算了数据框中每个数值列的四分位数和IQR,然后依据IQR法判断并移除异常值。

4.1.2 重复数据的识别与删除

重复数据通常由于数据录入错误、数据合并处理不当等原因产生,它们可能会导致数据分析结果产生偏差。识别和删除重复数据是数据清洗过程中不可缺少的一步。

以 pandas 库为例,我们可以使用 duplicated() 函数来检测重复数据,并利用 drop_duplicates() 函数来删除它们:

# 删除重复数据

df_deduped = df.drop_duplicates()

duplicated() 函数可以标记数据框中的重复数据,而 drop_duplicates() 函数则根据这些标记删除重复的数据行。

4.2 数据转换的策略

4.2.1 数据类型的转换规则

不同数据类型的转换是数据处理中的基础。例如,日期字符串需要转换为 datetime 对象以便进行日期运算,类别数据可能需要转换为数值型数据以适应某些统计模型的要求。

以 pandas 为例,我们可以使用 astype() 方法来转换数据类型:

# 假设df有一个名为日期的列,数据类型为字符串

df['日期'] = pd.to_datetime(df['日期'], format='%Y-%m-%d')

在上述代码中, pd.to_datetime() 方法用于将字符串格式的日期转换为 datetime 类型,这在处理时间序列数据时非常有用。

4.2.2 跨系统数据格式的兼容性处理

在不同系统之间传输数据时,需要确保数据格式的一致性与兼容性。例如,某些系统可能使用特定的编码格式或者数据文件格式,这时需要进行相应的格式转换。

假设我们需要将数据框导出为CSV文件,并且要确保编码为UTF-8:

df.to_csv('output.csv', encoding='utf-8')

在上述代码中, to_csv() 函数用于将数据框导出为CSV文件, encoding='utf-8' 参数确保了文件的编码格式为UTF-8,这是跨系统兼容性处理的关键。

综上所述,数据清洗与转换是数据处理的基础,但其重要性不可小觑。准确处理空值、异常值、重复数据,并正确转换数据类型和格式,对于保证数据质量、提高数据可用性至关重要。在下一节中,我们将探讨数据合并的策略和实现方法,这对于整合多个数据集和实现复杂的数据分析尤为重要。

5. 多DBF文件数据合并技术

在处理大量数据时,合并来自不同DBF文件的信息是一项常见的任务。DBF文件是早期数据库管理系统中广泛使用的一种文件格式,即便在现代技术中,它们仍然在某些应用场景中扮演着重要角色。了解如何有效地合并多个DBF文件不仅能够提高数据处理的效率,还能够增强数据管理的灵活性。

5.1 数据合并的需求分析

5.1.1 合并的目标与原则

数据合并的目标通常是为了得到更全面的数据视图,以便于进行更深入的数据分析。合并的原则包括确保数据一致性、处理重复记录、保持数据完整性以及优化合并后的数据结构。在实际操作中,我们可能需要考虑以下几个方面:

- 数据一致性 :确保合并后的数据遵守同样的业务规则和格式约定。

- 性能优化 :合并大量数据时,需要考虑程序的运行效率,避免产生性能瓶颈。

- 扩展性 :合并逻辑应能适应不同规模的数据集,以及可能出现的新字段和数据类型。

5.1.2 合并策略的设计

为了实现高效的数据合并,设计良好的合并策略至关重要。设计策略时,以下几点需要重点考虑:

- 数据预处理 :在合并前,对每个DBF文件的数据进行清洗和格式标准化。

- 合并算法选择 :根据数据的特性选择适合的合并算法,例如全外连接、左连接等。

- 索引优化 :为了提高查询和合并的效率,合理地创建索引能够显著提高处理速度。

- 错误处理机制 :合并过程中可能出现数据不匹配等问题,需要设计错误处理和异常捕获机制。

5.2 实现数据合并的代码案例

为了更好地理解如何在代码层面上实现DBF文件数据合并,以下是使用Python语言的一个案例。我们将展示如何使用 dbfpy 库来读取DBF文件,并使用 pandas 库来进行数据合并和优化。

5.2.1 使用Python进行数据合并的步骤

首先,确保已安装 dbfpy 和 pandas 库:

pip install dbfpy pandas

接着,我们将编写Python代码来执行数据合并操作。以下是一个简单的合并过程:

import dbf

import pandas as pd

# 定义一个函数读取DBF文件

def read_dbf(file_path):

db = dbf.Dbf(file_path, encoding='utf-8')

db.open()

records = []

for record in db:

records.append(record)

db.close()

return records

# 读取两个DBF文件的数据

data1 = read_dbf('file1.dbf')

data2 = read_dbf('file2.dbf')

# 将读取的数据转换为DataFrame

df1 = pd.DataFrame(data1)

df2 = pd.DataFrame(data2)

# 合并数据

merged_data = pd.merge(df1, df2, on='共同字段', how='left')

# 输出合并后的数据

print(merged_data)

在上述代码中,我们定义了 read_dbf 函数来读取DBF文件,并将数据转换为Pandas DataFrame格式。然后使用Pandas的 merge 方法进行数据合并,根据实际情况选择合适的 on 和 how 参数。

5.2.2 多表关联与查询优化

在进行多表关联和查询操作时,合理使用索引可以极大地提高数据处理的效率。下面是一个优化查询的示例:

# 创建索引

df1.set_index('关键字段1', inplace=True)

df2.set_index('关键字段2', inplace=True)

# 使用索引进行快速关联

fast_merged_data = df1.join(df2, how='inner')

# 输出优化后的合并数据

print(fast_merged_data)

在上述代码中,我们通过设置DataFrame的索引,利用 join 方法替代 merge 方法来执行内连接操作,从而实现更快速的数据关联。

总结

多DBF文件数据合并是一个复杂的过程,涉及到多个技术层面的考量。在实际操作中,选择合适的方法和工具对于保障数据合并的效率和准确性至关重要。通过上述章节的介绍,我们展示了如何利用Python、 dbfpy 和 pandas 库来实现高效的数据合并。在实践中,开发者还需根据具体需求灵活应用上述技术,并对合并过程进行持续优化。

在下一章节,我们将深入探讨数据传输机制与网络编程的知识,探索数据如何在网络中安全、高效地传输。

6. 数据传输机制与网络编程

在现代信息技术领域,数据传输与网络编程是构建高效、安全、稳定的数据交换平台的核心技术之一。本章将探讨数据传输的基本原理、网络传输协议的选择与应用,以及网络编程的实现,包括socket编程基础和安全性与性能优化策略。

6.1 数据传输的基本原理

数据传输是计算机网络中最基本的功能,涉及到数据在不同设备之间移动的过程。理解其基本原理,对于设计和实施有效的网络传输协议至关重要。

6.1.1 数据封装与分组传输

为了确保数据在复杂的网络环境中能够准确无误地传输,通常采用数据封装的方法。数据在发送之前会被封装到一个数据包中,包含有源地址、目的地址、数据内容、校验和等关键信息。为了适应网络中的各种物理和逻辑链路,数据会被进一步拆分为小的数据块,即分组(或称为数据报)进行传输。

这种分组交换技术可以有效提高网络利用率和可靠性。每一分组独立路由到目的地,即使其中的某些分组丢失或损坏,也只需要重新发送这些分组,而不需要重发整个消息。

6.1.2 网络传输协议的选择与应用

选择合适的网络传输协议对于确保数据传输的效率和安全至关重要。目前广泛使用的有以下几种:

- TCP/IP协议 :该协议是一组用于互联网的通信协议,提供可靠的、有序的、基于连接的字节流传输服务,适用于需要高可靠性的数据传输,如网页浏览、电子邮件等。

-

UDP协议 :用户数据报协议(UDP)提供一种无连接的网络通信服务,适用于对传输速度有较高要求、数据传输的可靠性要求相对较低的场合,例如视频会议、在线游戏等。

-

HTTP/HTTPS协议 :超文本传输协议(HTTP)以及安全的HTTP(HTTPS)是用于分布式、协作式和超媒体信息系统的应用层协议。HTTPS为HTTP加入了SSL/TLS层,提供数据加密和身份验证功能。

选择特定协议时需要综合考虑传输数据的类型、传输环境的稳定性、以及对传输速度和安全性的要求等因素。

6.2 网络编程的实现

网络编程是创建网络应用程序的过程,它让开发者可以编写能够发送、接收和处理数据的程序代码。

6.2.1 socket编程基础

在Python中,socket编程通常涉及到 socket 模块的使用。socket是网络通信的基础,提供了多种类型的网络通信方式,包括面向连接的TCP通信和无连接的UDP通信。

以下是一个简单的TCP socket通信示例:

import socket

def create_server(ip, port):

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

server_socket.bind((ip, port))

server_socket.listen(1)

print(f"Listening on {ip}:{port}...")

conn, addr = server_socket.accept()

with conn:

print(f"Connected by {addr}")

while True:

data = conn.recv(1024)

if not data:

break

conn.sendall(data)

def create_client(ip, port):

client_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

client_socket.connect((ip, port))

client_socket.sendall(b'Hello, World')

data = client_socket.recv(1024)

client_socket.close()

print(f"Received {data.decode()}")

if __name__ == '__main__':

# Create server

create_server('***.*.*.*', 12345)

# Create client

create_client('***.*.*.*', 12345)

在这个示例中,我们创建了一个TCP服务器和客户端。服务器在指定端口上监听连接请求,客户端连接到服务器并发送一条消息,服务器接收到消息后将其回发给客户端。

6.2.2 安全性与性能优化策略

网络编程面临的安全挑战包括数据窃听、篡改、重放攻击等。因此,在网络编程中,使用加密和身份验证机制至关重要。例如,在创建TCP连接时使用SSL/TLS加密:

import socket

import ssl

def create_secure_server(ip, port):

# Creating an SSL context

context = ssl.create_default_context(ssl.Purpose.CLIENT_AUTH)

context.load_cert_chain(certfile="path/to/certfile.pem", keyfile="path/to/keyfile.pem")

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

server_socket.bind((ip, port))

server_socket.listen(1)

# Wrap with an SSL layer

while True:

conn, addr = server_socket.accept()

secure_conn = context.wrap_socket(conn, server_side=True)

with secure_conn:

print(f"SSL connection from {addr}")

while True:

data = secure_conn.recv(1024)

if not data:

break

secure_conn.sendall(data)

def create_secure_client(ip, port):

context = ssl.create_default_context()

with socket.create_connection((ip, port)) as sock:

with context.wrap_socket(sock, server_hostname=ip) as ssock:

ssock.sendall(b'Hello, World')

data = ssock.recv(1024)

print(f"Received {data.decode()}")

if __name__ == '__main__':

# Create secure server

create_secure_server('***.*.*.*', 12346)

# Create secure client

create_secure_client('***.*.*.*', 12346)

性能优化方面,除了选择合适的传输协议外,还需要考虑到数据的压缩、批处理、以及连接的复用等技术。这些都能在减少网络延迟的同时提高数据传输效率。

例如,在一个高并发的网络应用中,可以使用连接池来复用socket连接,减少每次建立连接的开销。同时,也可以采用数据压缩算法,如gzip,来减少传输数据的大小,提高传输速率。

通过上述示例,我们可以看到,在进行网络编程时,需要对传输数据进行封装,并选择合适的协议。同时,实现网络通信的过程要兼顾安全性和效率,利用各种优化手段来提高程序的性能。在实际应用中,这需要开发者具有深入的理解和丰富的实践经验。

简介:DBF文件格式在数据存储与交换中的重要性,以及其在股票行情数据传输中的应用。介绍DBF文件结构和核心任务,包括使用代码读取DBF文件、数据处理、合并数据和数据传输。详细说明了错误处理与日志记录的重要性,并以 Send_Convert 脚本为例,解释了实现股票行情数据传输的具体步骤。

920

920

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?