关键时刻,第一时间送达!

节前一个误操作把mysql中record表和movie表都清空了,显然我是没有做什么mysql备份的。所以,索性我把所有的表数据都清空的,一夜回到解放前……

在上一个版本中,record表存储了7万多条记录,爬取的有4万多条,但是可以明显的发现爬取的数据量越多的时候,机子就越卡。又一次报错,是有关JDBC的,还有一次机子跑卡死了。

仔细一琢磨,上个版本的爬虫程序与数据库的读写次数太频繁,存在以下问题:

3.存储电影详情页记录以及短评数据都是采用解析一条则立即存储到数据库。

显然,上面的这种方式是一目了然的效率低下,所以今天下午对相关代码进行改造,部分实现了批量插入,尽可能减少与数据库的交互,从而降低时空成本。

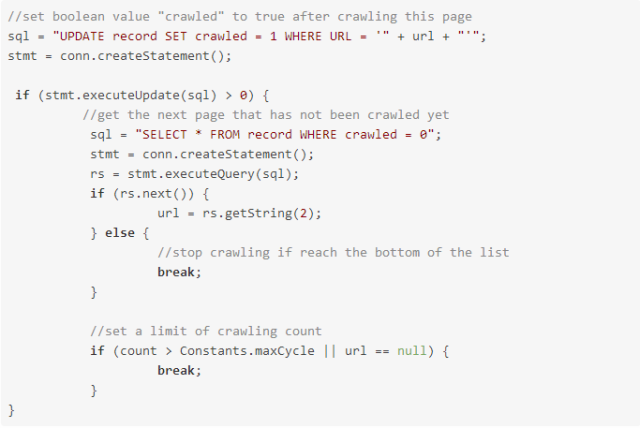

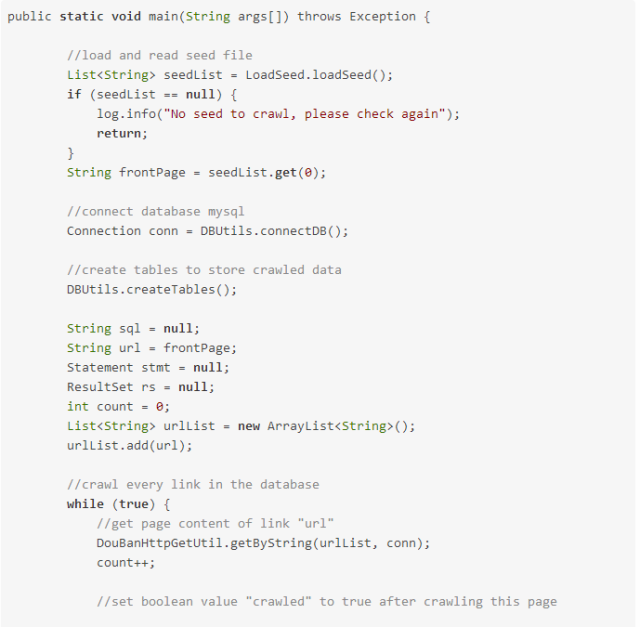

既然问题出现了,就顺着这个版本看看,最终发现问题的原因是对于种子网址并没有存储到mysql的record表中,所以在DoubanCrawler类中。

执行stmt.executeUpdate(sql) > 0是返回的值为0,从而不会从数据库中读取crawled为0的记录,最后就一直在while的循环中爬取种子网站。

解决方法:对于种子网站既然没有存储到record的操作,那么就对种子网站做特殊处理,将if的判断条件改为 if (stmt .executeUpdate(sql) > 0 || frontPage .equals(url)),这样对于种子网站即使没有update更新成功操作仍然可以进入读取数据库crawled为0 的操作。

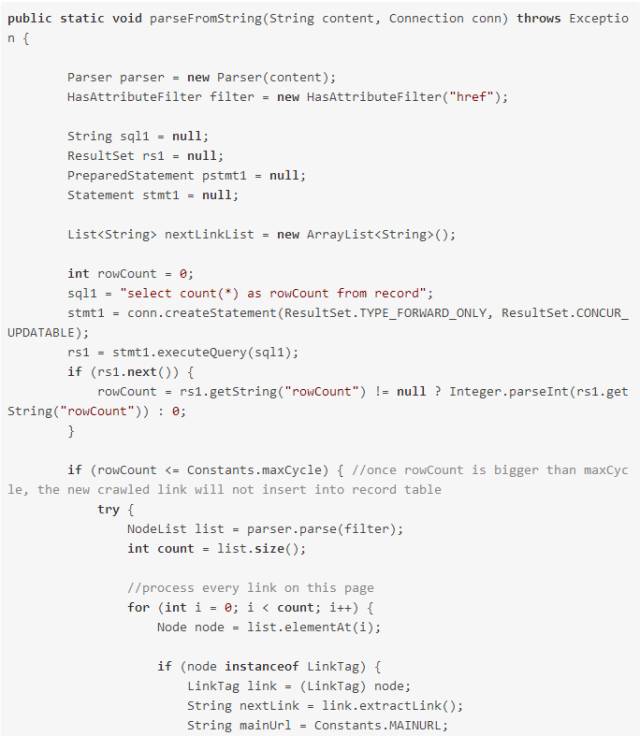

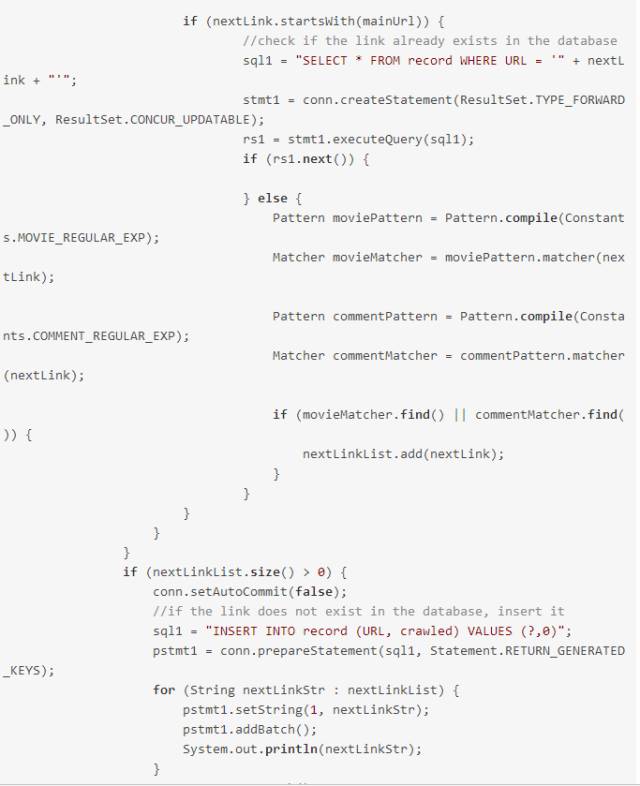

针对第一个问题,采用批量插入操作

具体实现如下:

1.通过正则匹配,找到符合条件的link,并添加到nextLinkList集合中

2.遍历完后,将数据存到数据库中

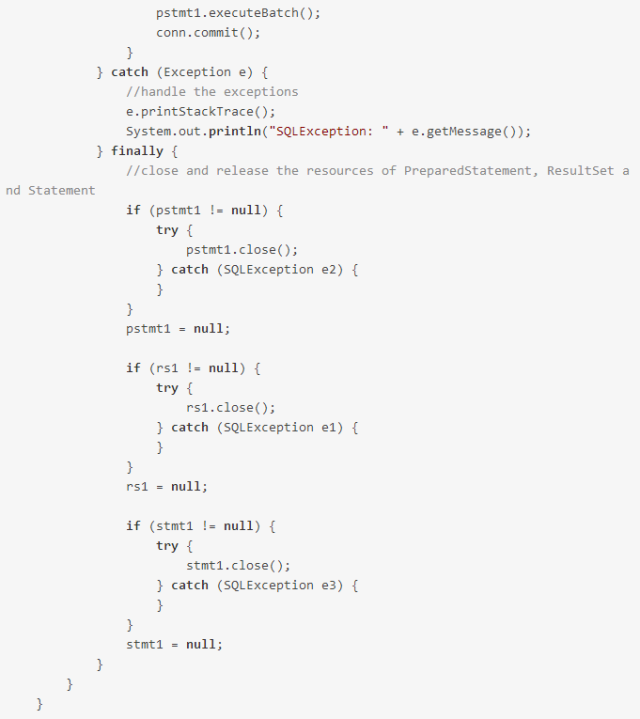

3. 在批量操作中,使用了addBatch()方法和executeBatch()方法,注意需要添加conn.setAutoCommit( false);以及conn.commit()表示手动提交。

针对第二个问题,采用一次查询多条记录

实现思路 :将每次只查询一条记录,改为每次查询10条记录,并将这10条记录存放到list集合中,并将原来的String类型的url改为list类型的urlList传入

到 DouBanHttpGetUtil.getByString()方法里。这样即减少了与数据库的交互,同时也减少了对于getByString方法的调用。

具体实现如下:

注意: 1.这里采用每次读取10条记录,相应的也需要将这10条记录的crawled字段更新为1,表示爬取过。

2. mysql不支持top 10 * 这样的语法,但是可以通过代码中所示的limit 10 的方式取出数据。

3. 添加conn.setAutoCommit( true );表示更新操作设置为自动提交,这样就可以解决虽然程序执行成功但是数据没有更新到数据库的现象。

针对第三个问题,与第一个问题解决方法相同。

虽然不知道这样做带来的效果有多明显,或有是否有更好的解决方案,但是可以肯定的是上个版本的代码会大量占用内存并频繁与数据库交互。

本人(作者)是数据库小白,希望有更好的方案可以提出来~~~

来源:博客园精华区

程序员大咖整理发布,转载请联系作者获得授权

5541

5541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?