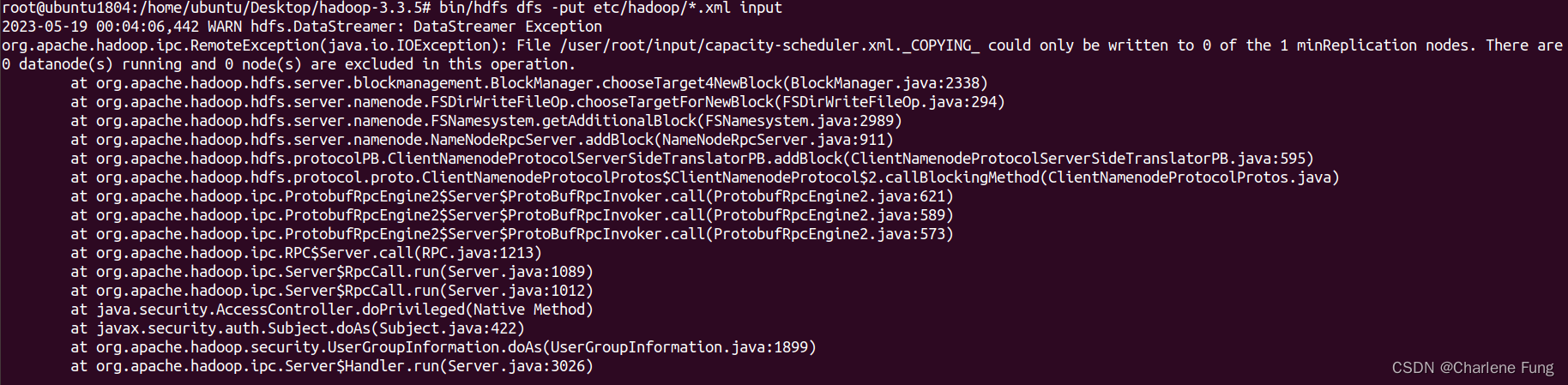

如图所示,执行bin/hdfs dfs -put etc/hadoop/*.xml input时,出现错误:

2023-05-19 00:04:06,442 WARN hdfs.DataStreamer: DataStreamer Exception org.apache.hadoop.ipc.RemoteException(java.io.IOException): File /user/root/input/capacity-scheduler.xml._COPYING_ could only be written to 0 of the 1 minReplication nodes. There are 0 datanode(s) running and 0 node(s) are excluded in this operation.

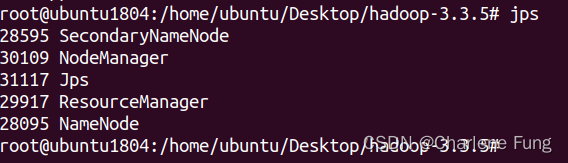

执行jps列出正在运行的java进程,没有找到DataNode。

查了许多资料,大多都提及了需要将tmp下的文件清空(参考:此处)。而我先前使用了hadoop默认配置,tmp目录在/tmp/hadoop-${user.name}(参考:来源,更多关于配置文件的信息可以参考这篇blog)。因此,参照这篇blog给出的建议——尽量不要使用默认路径,我需要修改etc/hadoop/路径下的配置文件core-site.xml,新增以下配置代码:

<configuration>

<--! 在已有的configuration中新增这一部分: -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/ubuntu/Desktop/hadoop-3.3.5/tmp</value>

</property>

</configuration>

如此一来,tmp文件夹下内容为空,当然呢,如果已经新建了自己的路径,只需要follow前面提到的tmp文件清空(参考:此处)即可。

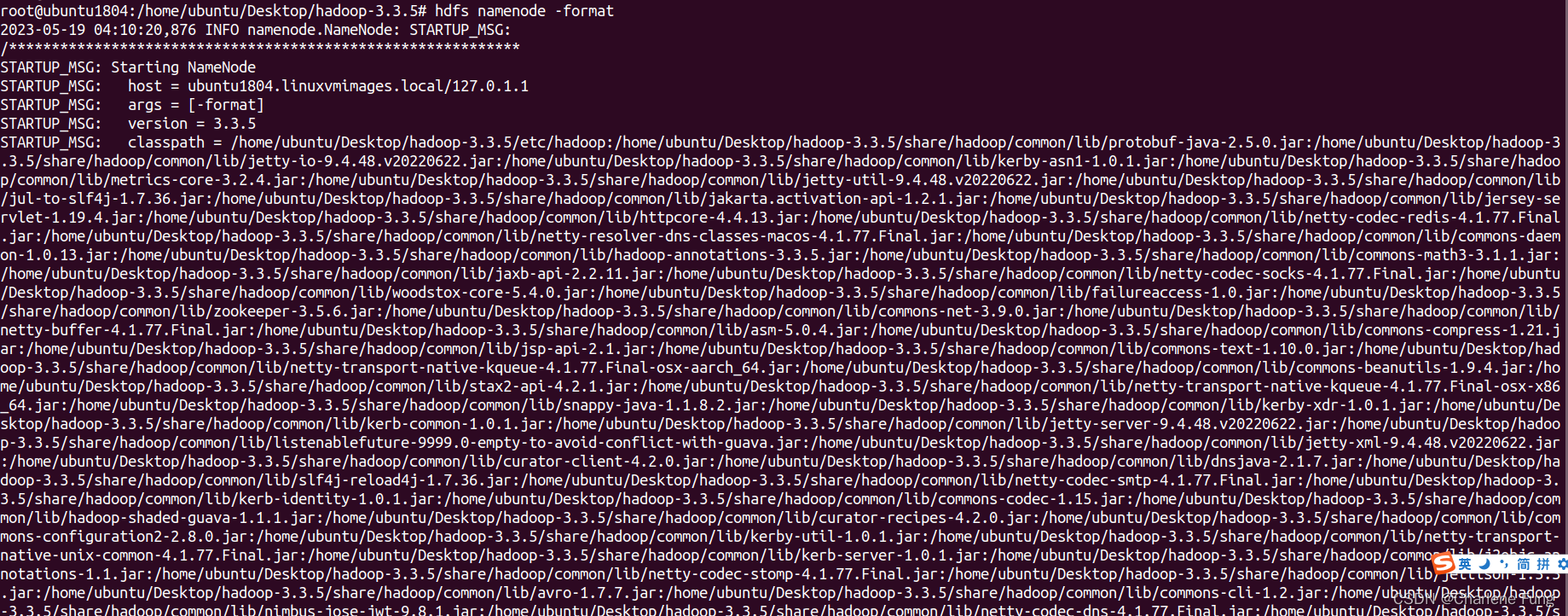

接下来,再格式化namenode,hdfs namenode -format。

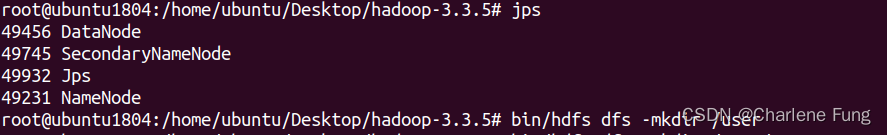

重新启动datanode,此处我启动sbin/start-dfs.sh,再运行jps,看到datanode了!

1642

1642

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?