测试debezium与kafka的步骤

1、sqlServer

注意: sqlsever 已经配置好

Navicate连接sqlserver配置信息:

ip:10.170.130.xxx

host: 1433

user: sa

password :123456

监控的表:bs_news

1、目前sqlserver配置已经配置好 监控的表无需操作,测试时只需要往表中复制上一条数据增加一条数据即可

2、postman查看kafka启动的connector状态

http://10.208.63.1:8083/

返回:

{"version":"2.2.2","commit":"1d348535a0a747d1","kafka_cluster_id":"9gckc_g_Q-eOFjTHSLMacA"}

http://10.208.63.1:8083/connectors/

返回:【】

http://10.208.63.1:8083/connector-plugins

返回:plugins下放的jar包

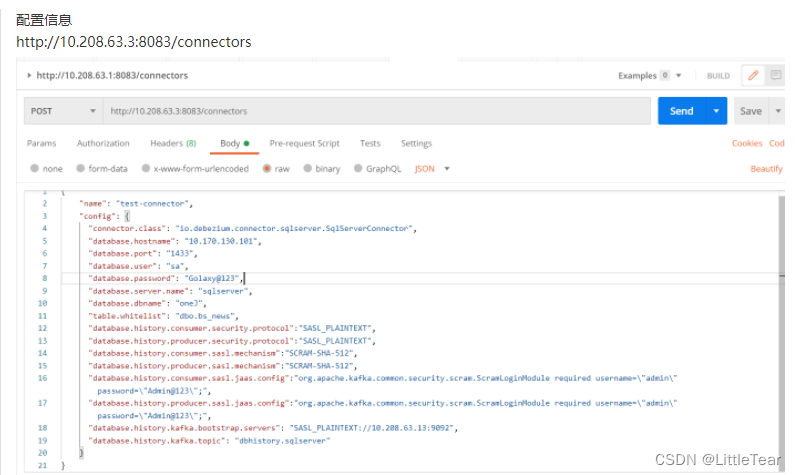

3、postman 提交配置

配置信息

http://10.208.63.xxx:8083/connectors

{

"name": "test-connector",

"config": {

"connector.class": "io.debezium.connector.sqlserver.SqlServerConnector",

"database.hostname": "10.170.130.xxx",

"database.port": "1433",

"database.user": "sa",

"database.password": "123456",

"database.server.name": "sqlserver",

"database.dbname": "oneJ",

"table.whitelist": "dbo.bs_news",

"database.history.consumer.security.protocol":"SASL_PLAINTEXT",

"database.history.producer.security.protocol":"SASL_PLAINTEXT",

"database.history.consumer.sasl.mechanism":"SCRAM-SHA-512",

"database.history.producer.sasl.mechanism":"SCRAM-SHA-512",

"database.history.consumer.sasl.jaas.config":"org.apache.kafka.common.security.scram.ScramLoginModule required username=\"admin\" password=\"Admin@123\";",

"database.history.producer.sasl.jaas.config":"org.apache.kafka.common.security.scram.ScramLoginModule required username=\"admin\" password=\"Admin@123\";",

"database.history.kafka.bootstrap.servers": "SASL_PLAINTEXT://10.208.63.xxx:9092",

"database.history.kafka.topic": "dbhistory.sqlserver"

}

}

上述参数说明

1、name:自定义连接器名称

2、database.server.name:自定义名字(在kafka生成的topic前缀相关)

3、table.whitelist:监听的表列表

4、database.history.kafka.topic:需要存储信息的topic

5、其余为kafka连接验证配置

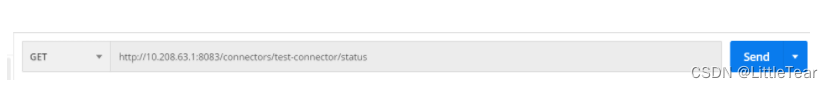

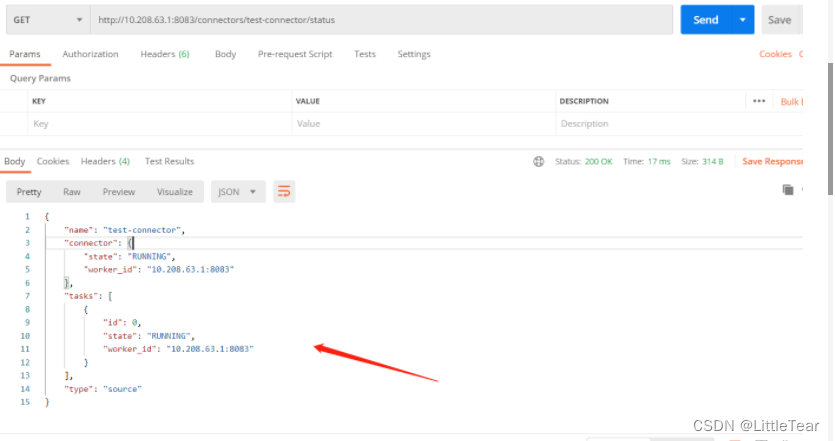

4、查看提交配置的运行状态

查看命令:

# 查看当前提交之后的状态

http://10.208.63.xxx:8083/connectors/test-connector/status

查看connector的信息

http://10.208.63.xxx:8083/connectors/test-connector

#查看connector下运行的task信息

http://10.208.63.xxx:8083/connectors/test-connector/tasks

#删除 创建的Connector任务

http://10.208.63.xxx:8083/connectors/test-connector

提交之后查看状态显示上述状态 无报错信息则为成功

否则会在下面的tasks位置显示报错详细信息

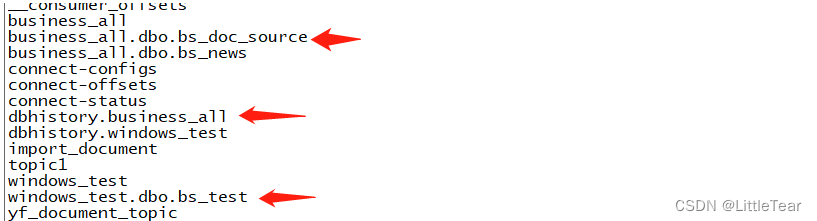

5、 运行成功之后

正确的结果:

会在kafka中自动创建一个 以 dbhistory.sqlserver 和sqlserver.dbo.tableName 的两个主题 。

消费 sqlserver.dbo.tableName 这个主题中可以看到sqlserver中追加新增的数据。否则失败

目前只能生成dbhistory.sqlserver 一个主题,sqlserver中的表无法创建主题并生产数据

6、正确产生kafkatopic的图解

会产生上述类似的主题

此图的kafka位置是

10.170.130.xxx

/usr/local/kafka/

458

458

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?