KOSMOS-2.5在KOSMOS-2的基础上发展而来的,突出了对于文本密集图像的多模态阅读和理解能力(Multimodal Literate Model)。KOSMOS-2.5的目标是在文本丰富的图像中实现无缝的视觉和文本数据处理,以便理解图像内容并生成结构化文本描述。

论文地址:https://arxiv.org/pdf/2309.11419.pdf

摘要

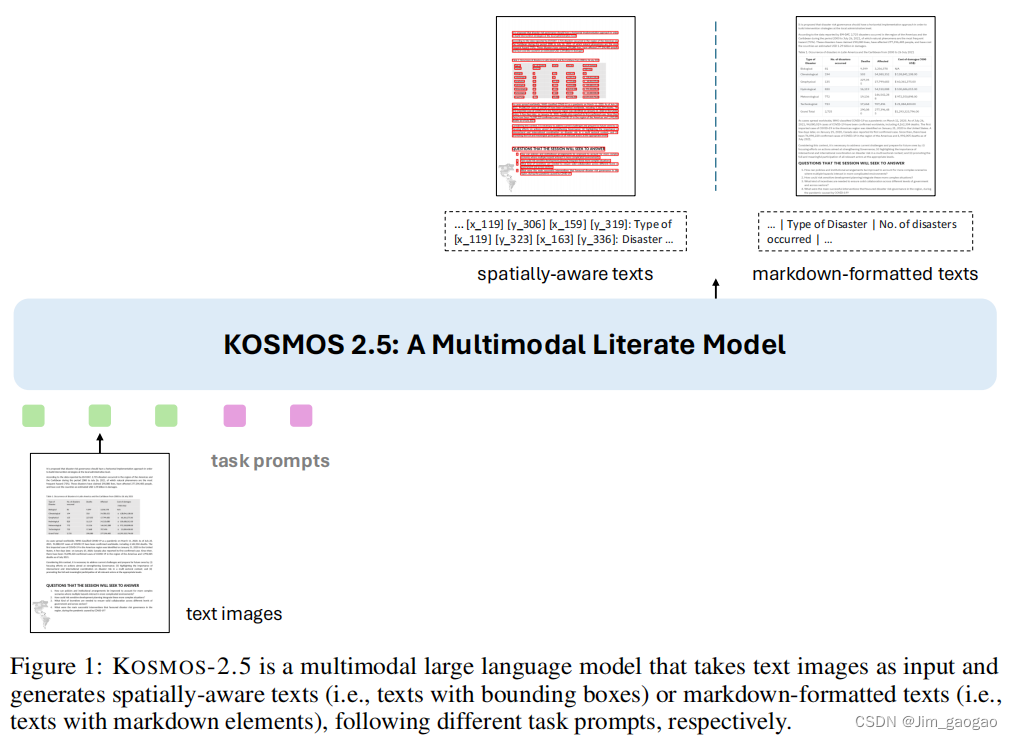

KOSMOS-2.5是一个多模态的文学模型,能够在文本密集的图像中进行机器阅读。它通过共享Transformer架构、任务特定的提示和灵活的文本表示,实现了生成具有空间感的文本块和将样式和结构转换为Markdown格式的结构化文本输出。该模型可用于文档级文本识别和图像到Markdown文本生成,并可通过监督微调适应不同提示的任何文本密集的图像理解任务,是一个通用的工具。这项工作也为未来的多模态大型语言模型的扩展铺平了道路。

简介

大型语言模型(LLMs)是人工智能领域的重要研究方向,能够从大量自然语言数据中学习,实现各种语言相关任务。近年来,研究人员致力于构建更大更复杂的模型,如GPT-3和GPT-4,这些模型具有数百/数千亿的参数,能够生成引人入胜的语言输出。虽然这些模型需要大量计算资源来训练和运行,但它们具有革命性的潜力,可以改变我们与自然语言的交互和理解方式。

目前的LLM主要关注文本信息,无法理解视觉信息。但是,多模态大语言模型(MLLM)的发展旨在解决这个问题。MLLM将视觉和文本信息结合在一个模型中,使模型能够基于两种模态学习和生成内容。MLLM在自然图像理解和文本图像理解等各种实际应用中表现出了潜力。这些模型利用语言建模作为多模态问题的通用接口,允许它们基于文本和视觉输入处理和生成响应。将文本图像纳入训练过程并开发基于文本和视觉信息的模型,可以为涉及高分辨率文本密集图像的多模态应用开启新的可能性。

本研究提出了KOSMOS-2.5,一种多模态文本模型,利用KOSMOS-2来处理文本密集型图像的机器阅读。该模型执行两个紧密相关的转录任务,生成具有空间感的文本块和结构化文本输出。该模型采用统一框架,利用共享的Transformer架构、任务特定提示和灵活的文本表示。该模型在大量文本密集型图像上进行预训练,具有强大的文本理解能力。实验结果表明,该模型在多个文本密集型图像理解任务中表现出色,并在少样本和零样本学习场景中展现出有前途的能力。

本文贡献如下:

- KOSMOS-2.5是一种重要的文本图像理解模型,采用了解码器模型而不是传统的编码器-解码器模型。它通过将空间感知文本块生成和结构化标记文本生成两个任务融合到一个统一的模型架构中进行预训练。

- 这种创新方法通过整合生成式多模态语言建模,简化了传统复杂的级联管道,从而简化了各种下游任务的应用界面。

- KOSMOS-2.5展示了令人印象深刻的多模态读写能力,为未来大规模多模态语言模型的扩展奠定了基础。

KOSMOS-2.5

模型

KOSMOS-2.5模型架构包括一个预训练的视觉编码器和一个与之连接的语言解码器,中间还有一个Resampler模块。视觉编码器基于Vision

KOSMOS-2.5是一种多模态文献模型,专为文本密集图像的机器阅读设计,能够无缝处理视觉和文本数据。模型在预训练中学习生成具有空间感的文本块和Markdown格式的结构化输出,适用于文档级文本识别和图像到Markdown转换。通过统一框架和共享Transformer架构,KOSMOS-2.5在多个文本密集图像理解任务中表现出色,展示出多模态读写能力,并为未来的大规模多模态语言模型扩展奠定了基础。

KOSMOS-2.5是一种多模态文献模型,专为文本密集图像的机器阅读设计,能够无缝处理视觉和文本数据。模型在预训练中学习生成具有空间感的文本块和Markdown格式的结构化输出,适用于文档级文本识别和图像到Markdown转换。通过统一框架和共享Transformer架构,KOSMOS-2.5在多个文本密集图像理解任务中表现出色,展示出多模态读写能力,并为未来的大规模多模态语言模型扩展奠定了基础。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?