windows下pyspark安装环境配置:

文章目录

安装目录展示

需要的软件:

python3.6

jdk1.8

spark-2.3.1-bin-hadoop2.7.tar

hadoop2.7.3-on-windows_X64-master.zip

这里需要注意一下版本对应:spark2.3.1 对应 python3.6可用,python3.8报错(也是为什么上图安装了两个python版本)

安装过程检测是否安装成功

一、安装python是否成功

python

二、安装JDK是否成功

java -version

三、安装spark-2.3.1-bin-hadoop2.7.tar

3.1 下载软件包

下载Spark2.3.1,注意与操作系统版本一致

下载地址为:http://spark.apache.org/downloads.html

3.2 解压安装

只需解压程序包,并拷贝至存放路径,注意安装路径中的文件夹名称不要存在空格

3.3 配置环境变量

新建系统变量SPARK_HOME,值为Spark安装路径

配置系统变量PATH,添加%SPARK_HOME%\bin及%SPARK_HOME%\sbin

针对PATH环境变量进行配置

3.4 配置日志显示级别

选择…\spark\conf\目录下log4j.properties.template,复制为log4j.properties

将log4j.properties中,“INFO, console"改为"WARN, console”

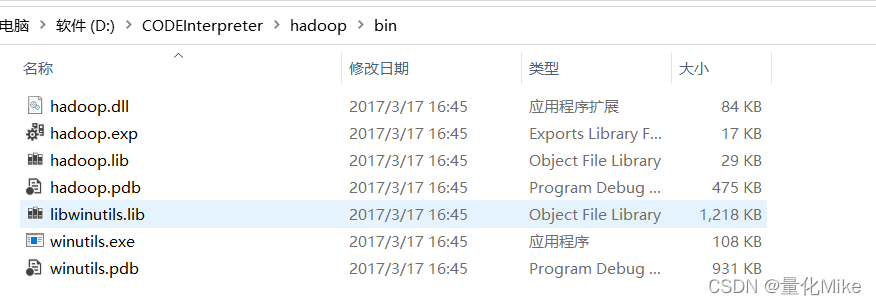

四、配置Hadoop支持模块

4.1 下载安装包(仅仅2.3M大小)

4.2 安装

只需解压程序包,并拷贝至存放路径,注意安装路径中的文件夹名称不要存在空格

4.3 配置环境变量

新建系统变量HADOOP_HOME,值为Hadoop安装路径

配置系统变量PATH,添加%HADOOP_HOME%\bin

检测Spark环境是否在win系统下有效可用

开启CMD输入下列命令:

spark-shell #查看Spark版本信息

pyspark #查看Pyspark版本

出现上述界面说明安装成功!!!

python脚本进行验证

# 从spark.sql模块中导入SparkSession

from pyspark.sql import SparkSession

# 实例化一个Sparksession,用子连接Spark集群

#app名中不要带空格,否剩会出错

#此处以本地模式加载集群

spark = SparkSession.builder.master("local") \

.appName("CreditCard") \

.getOrCreate()

sc = spark.sparkContext

print(sc)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?