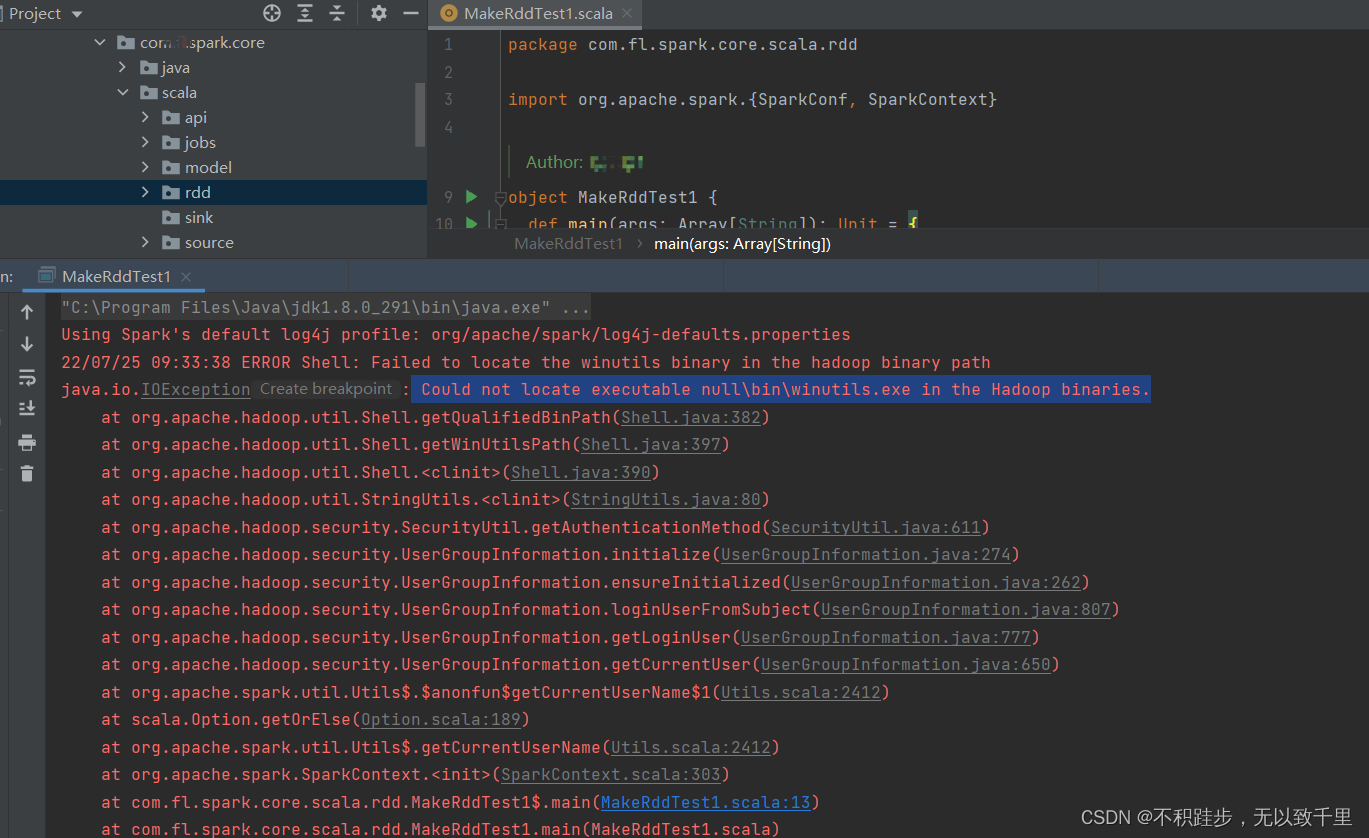

在windows系统本地运行spark的wordcount程序,会出现一个异常,但不影响现有程序运行。

发现是因为在Windows环境中缺少winutils.exe程序。

因为一般情况下Hadoop、spark都是运行在Linux系统下的,在windows下运行时需要安装Windows下运行的支持插件:hadoop2.7-common-bin。

原因分析 :https://www.cnblogs.com/tijun/p/7567664.html

解决办法

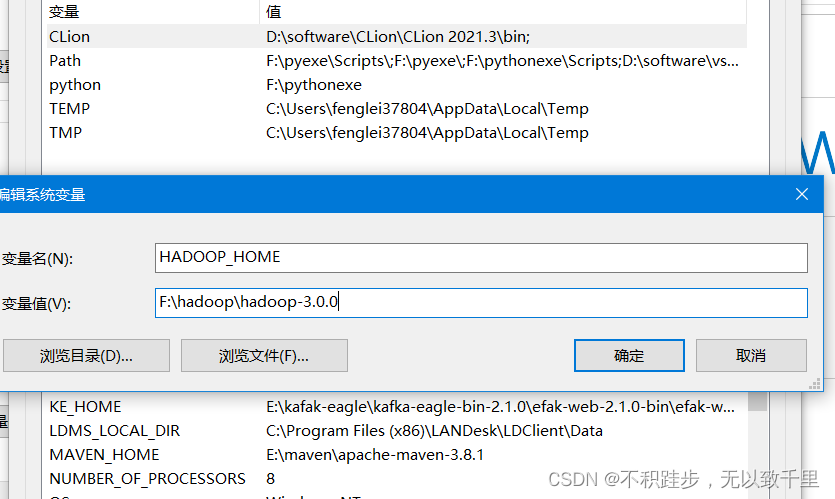

1、下载spark 依赖对应的hadoop版本,我的spark版本是3.0 对应的 hadoop选择 3.0.0即可。

http://hadoop.apache.org/releases.html

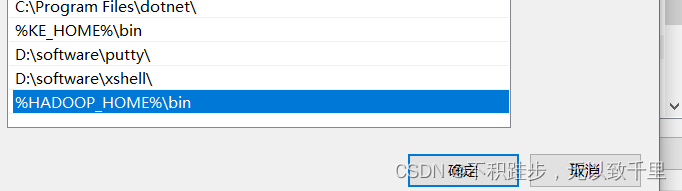

2.解压配置环境变量

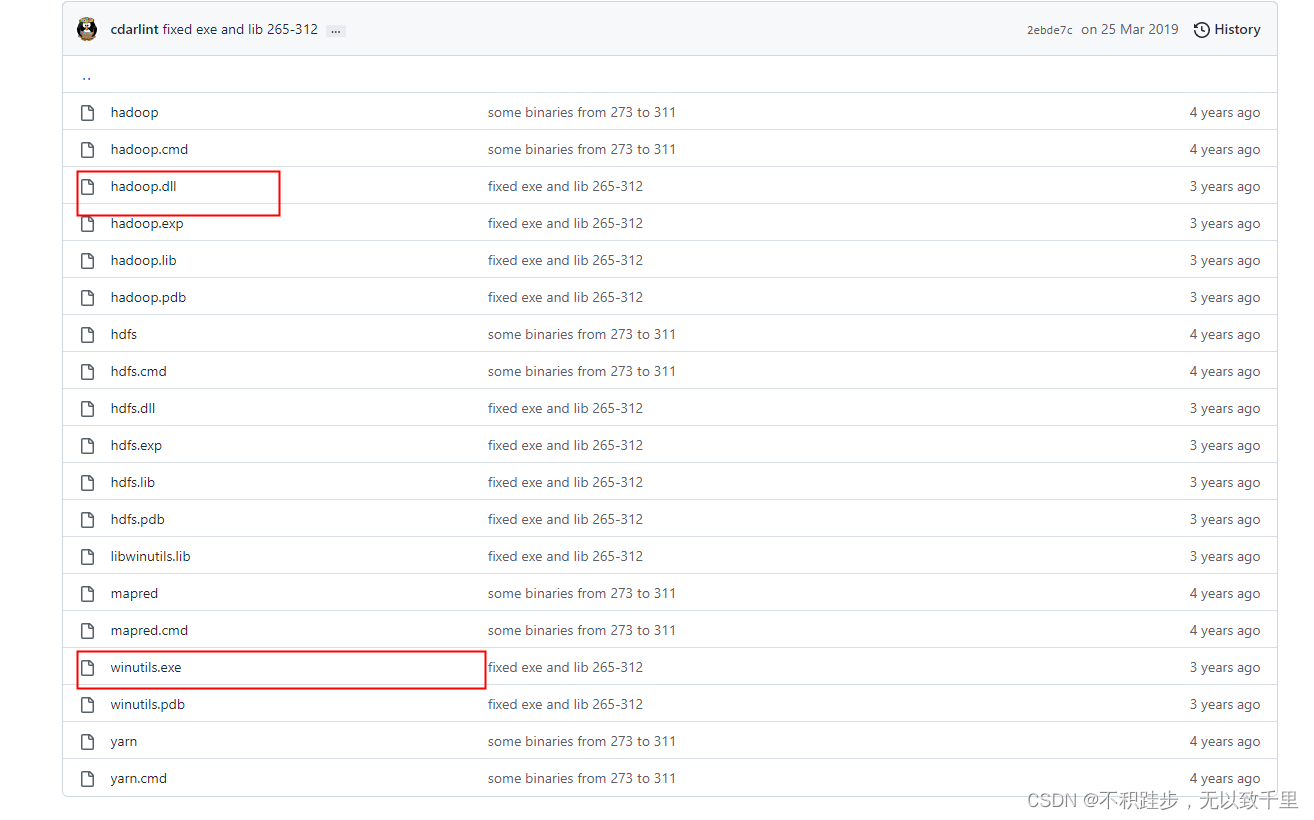

下载地址:https://github.com/cdarlint/winutils

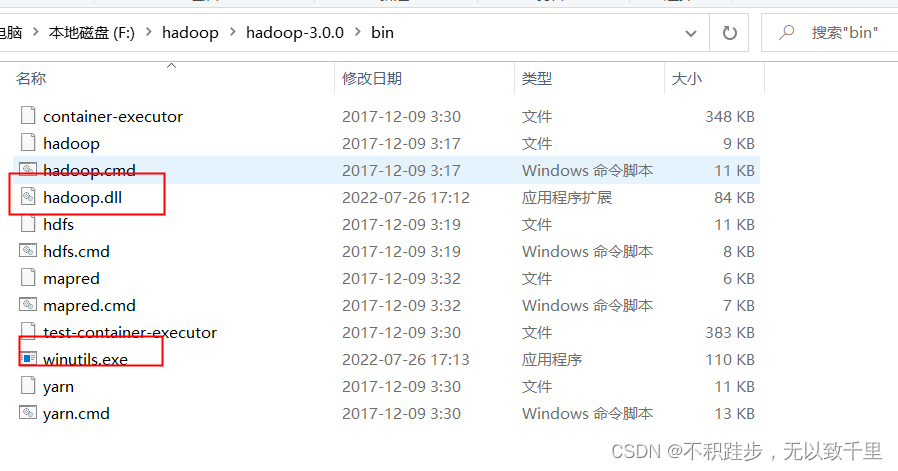

下载对应的版本这两个文件,放到hadoop 的bin 目录下。

如图:

bingo,问题解决!

3585

3585

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?