java.lang.Exception: java.lang.NullPointerException

at org.apache.hadoop.mapred.LocalJobRunner$Job.runTasks(LocalJobRunner.java:489)

at org.apache.hadoop.mapred.LocalJobRunner$Job.run(LocalJobRunner.java:549)

Caused by: java.lang.NullPointerException

at cn.edu360.app.log.mr.AppLogDataClean$AppLogDataCleanMapper.map(AppLogDataClean.java:135)

at cn.edu360.app.log.mr.AppLogDataClean$AppLogDataCleanMapper.map(AppLogDataClean.java:1)如图。。。。MapReduce的空指针异常错误对我来说真的太常见了,我这个错误犯得非常睿智。

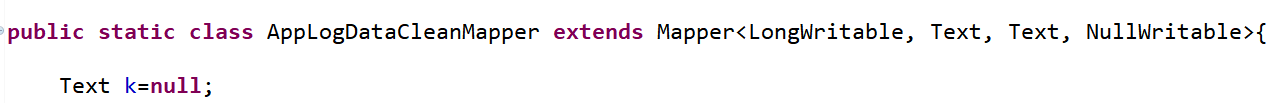

给大家看一下出错的代码行:

k即map方法中的key

k.set(JsonToStringUtil.toString(headerObj));为什么会报这个错呢,因为我创建key的时候忘记实例化了(/ □ \)我可真是个睿智

MapReduce空指针异常详解

MapReduce空指针异常详解

本文详细解析了一个常见的MapReduce编程错误——空指针异常,通过具体代码示例,阐述了在Map阶段如何因变量未正确实例化而引发异常,并提供了避免此类错误的有效策略。

本文详细解析了一个常见的MapReduce编程错误——空指针异常,通过具体代码示例,阐述了在Map阶段如何因变量未正确实例化而引发异常,并提供了避免此类错误的有效策略。

17万+

17万+