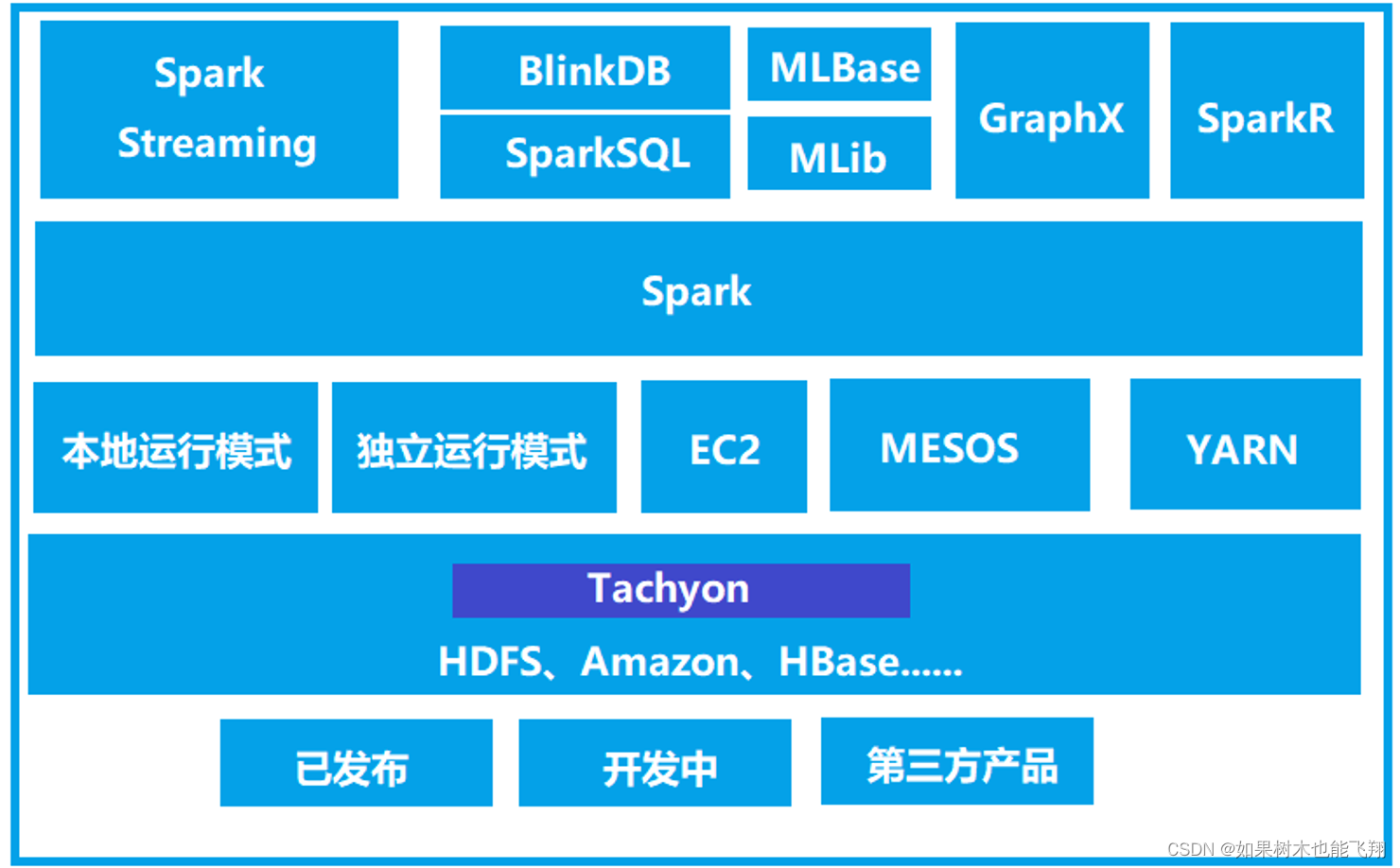

Spark作为一个数据处理框架和计算引擎,被设计在所有常见的集群环境中运行, 在国内工作中主流的环境为Yarn,不过逐渐容器式环境也慢慢流行起来。接下来,我们就分别看看不同环境下Spark的运行。

Local模式

所谓的Local模式,就是不需要其他任何节点资源就可以在本地执行 Spark 代码的环境,一般用于教学,调试,演示等,之前在IDEA中运行代码的环境我们称之为开发环境,不太一样。

上传并解压缩文件

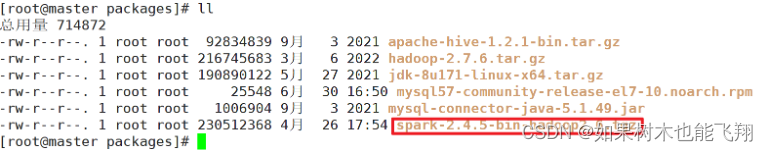

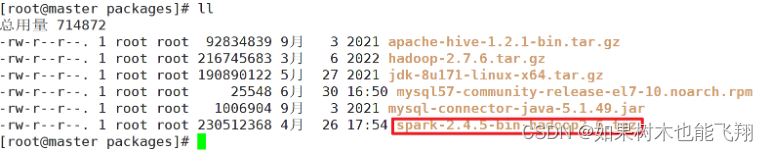

将spark-2.4.5-bin-hadoop2.6.tgz文件上传到Linux并解压缩,放置在指定位置,路径中不要包含中文或空格。

(1)上传文件至/usr/local/packages中:

(2)解压缩到指定目录:

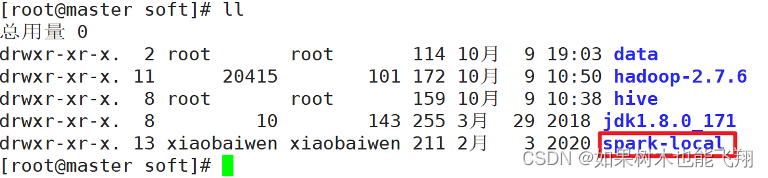

[root@master local]# tar -zxvf spark-2.4.5-bin-hadoop2.6.tgz -C /usr/local/soft/

(3)重命名:

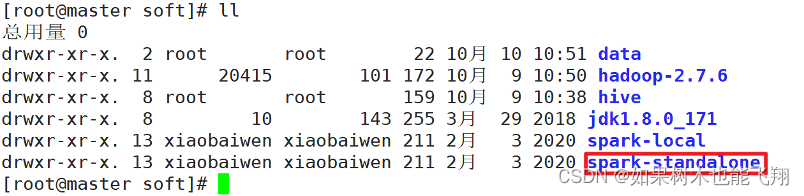

[root@master soft]# mv spark-2.4.5-bin-hadoop2.6/ spark-local

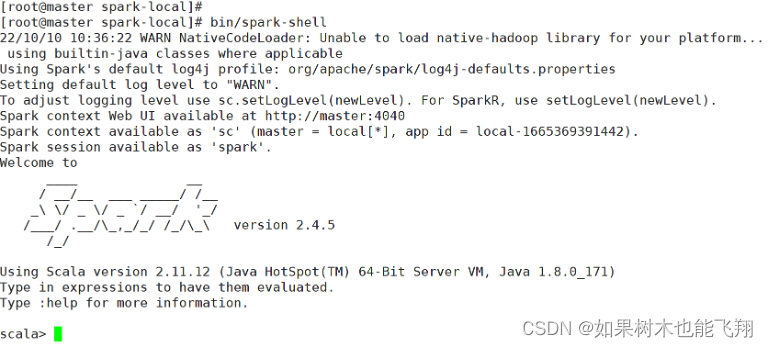

启动Local环境

(1)进入解压缩(spark-local)目录,执行以下命令:

[root@master spark-local]# bin/spark-shell

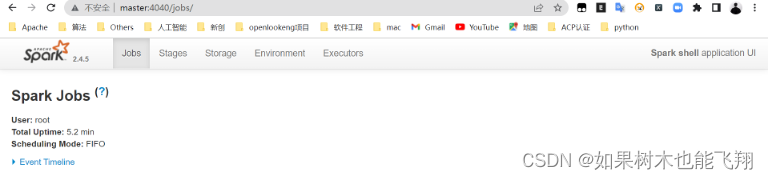

(2)启动成功后,可以输入网址进行Web UI监控页面访问:

http://master:4040

命令行工具

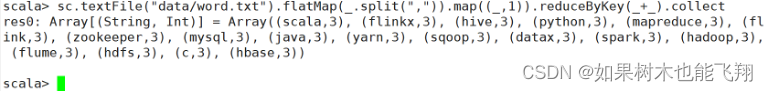

在解压缩文件夹(spark-local)下的data目录中,添加word.txt文件。在命令行工具中执行如下代码指令。

sc.textFile("data/word.txt").flatMap(_.split(",")).map((_,1)).reduceByKey(_+_).collect

退出本地模式

按键Ctrl+C或输入Scala指令:

scala> :quit

提交应用

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[1] \

./examples/jars/spark-examples_2.11-2.4.5.jar \

10

参数解释:

(1)–class表示要执行程序的主类,此处可以更换为我们自己写的应用程序。

(2)–master local[2]部署模式,默认为本地模式,数字表示分配的虚拟CPU核数量。

(3)spark-examples_2.11-2.4.5.jar运行的应用类所在的jar包,实际使用时,可以设定为我们自己打的jar包。

(4)数字10表示程序的入口参数,用于设定当前应用的任务数量。

Standalone模式

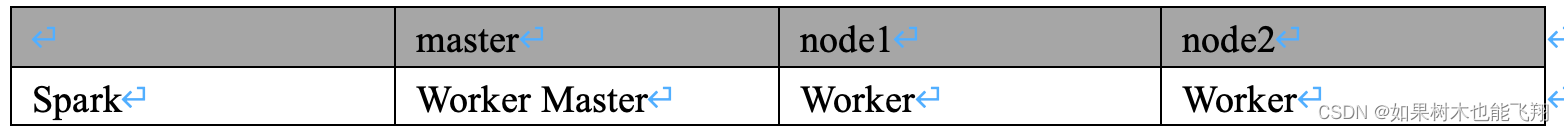

local本地模式毕竟只是用来进行练习演示的,真实工作中还是要将应用提交到对应的集群中去执行,这里我们来看看只使用Spark自身节点运行的集群模式,也就是我们所谓的独立部署(Standalone)模式。Spark的Standalone模式体现了经典的master-slave模式。集群规划:

上传并解压缩文件

将spark-2.4.5-bin-hadoop2.6.tgz文件上传到Linux并解压缩,放置在指定位置,路径中不要包含中文或空格。

(1)上传文件至/usr/local/packages中:

(2)解压缩到指定目录:

[root@master local]# tar -zxvf spark-2.4.5-bin-hadoop2.6.tgz -C /usr/local/soft/

(3)重命名:

[root@master soft]# mv spark-2.4.5-bin-hadoop2.6/ spark-standalone

修改配置文件

(1)进入解压缩路径(spark-standalone)的conf目录,修改slaves.template文件名为slaves:

[root@master conf]# mv slaves.template slaves

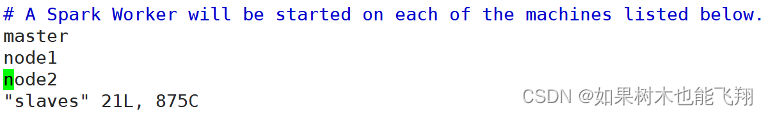

(2)修改slaves文件,添加work节点:

[root@master conf]# vim slaves

master

node1

node2

(3)修改spark-env.sh.template文件名为spark-env.sh:

(3)修改spark-env.sh.template文件名为spark-env.sh:

[root@master conf]# mv spark-env.sh.template spark-env.sh

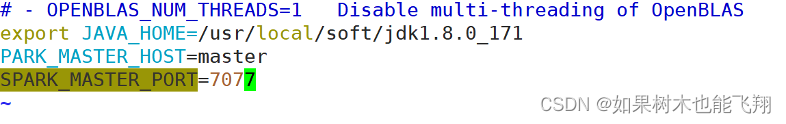

(4)修改spark-env.sh文件,添加JAVA_HOME环境变量和集群对应的master节点:

[root@master conf]# vim spark-env.sh

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

PARK_MASTER_HOST=master

SPARK_MASTER_PORT=7077

注意:7077端口,相当于master内部通信的8020端口,此处的端口需要确认自己的Hadoop配置。

(5)分发spark-standalone目录

[root@master soft]# scp -r spark-standalone/ node1:`pwd`

[root@master soft]# scp -r spark-standalone/ node2:`pwd`

启动集群

(1)执行以下命令:

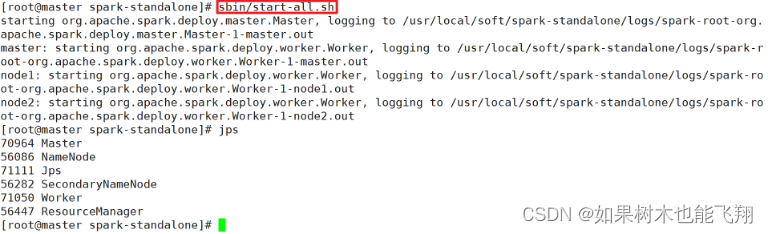

[root@master spark-standalone]# sbin/start-all.sh

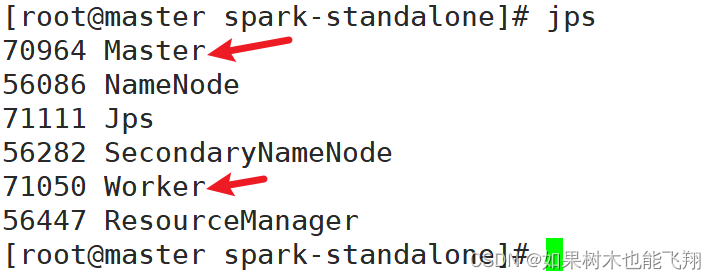

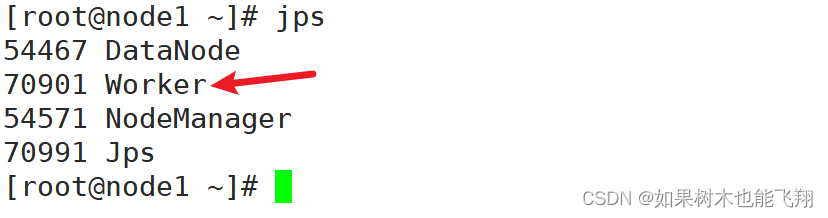

(2)查看三台服务器运行进程

master:

node1:

node2:

node2:

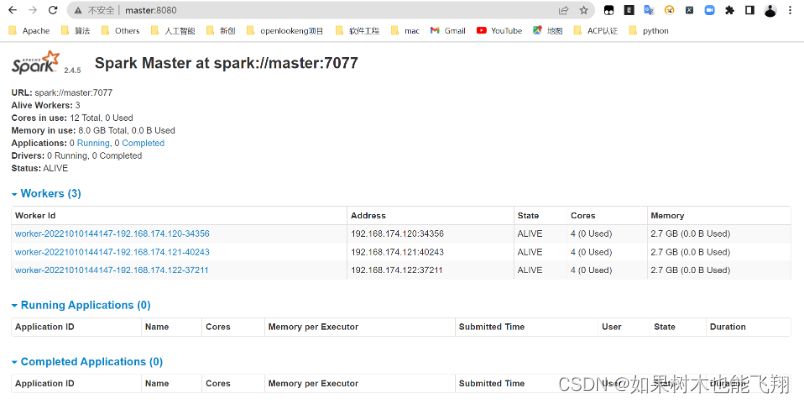

(3)查看Master资源监控Web UI界面:http://master:8080

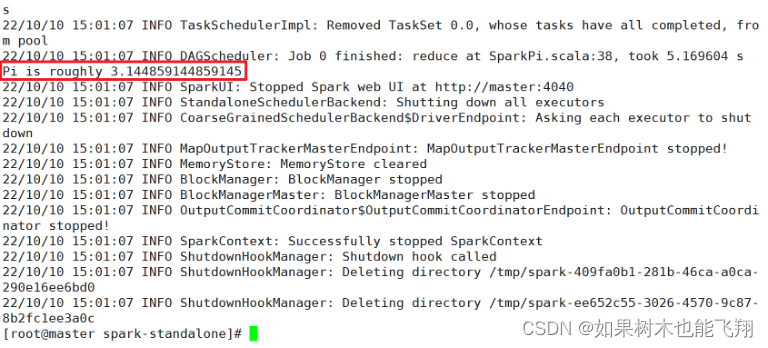

提交应用

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://master:7077 \

./examples/jars/spark-examples_2.11-2.4.5.jar \

10

参数解释:

(1)–class 表示要执行程序的主类

(2)–master spark://master:7077 独立部署模式,连接到Spark集群

(3)spark-examples_2.11-2.4.5.jar运行类所在的jar包

(4)数字10表示程序的入口参数,用于设定当前应用的任务数量

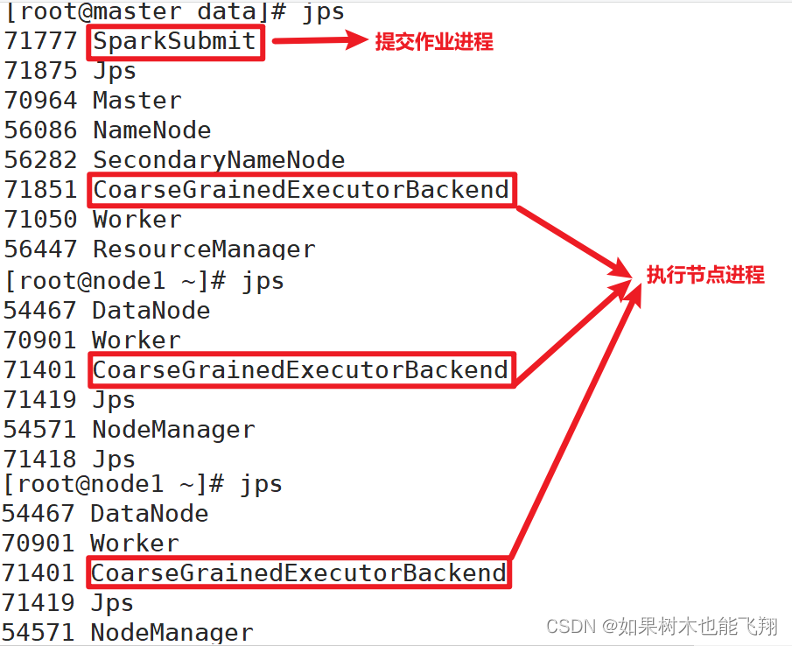

执行任务时,会产生多个 Java 进程:

执行任务时,会产生多个 Java 进程:

执行任务时,默认采用服务器集群节点的总核数,每个节点内存1024M。

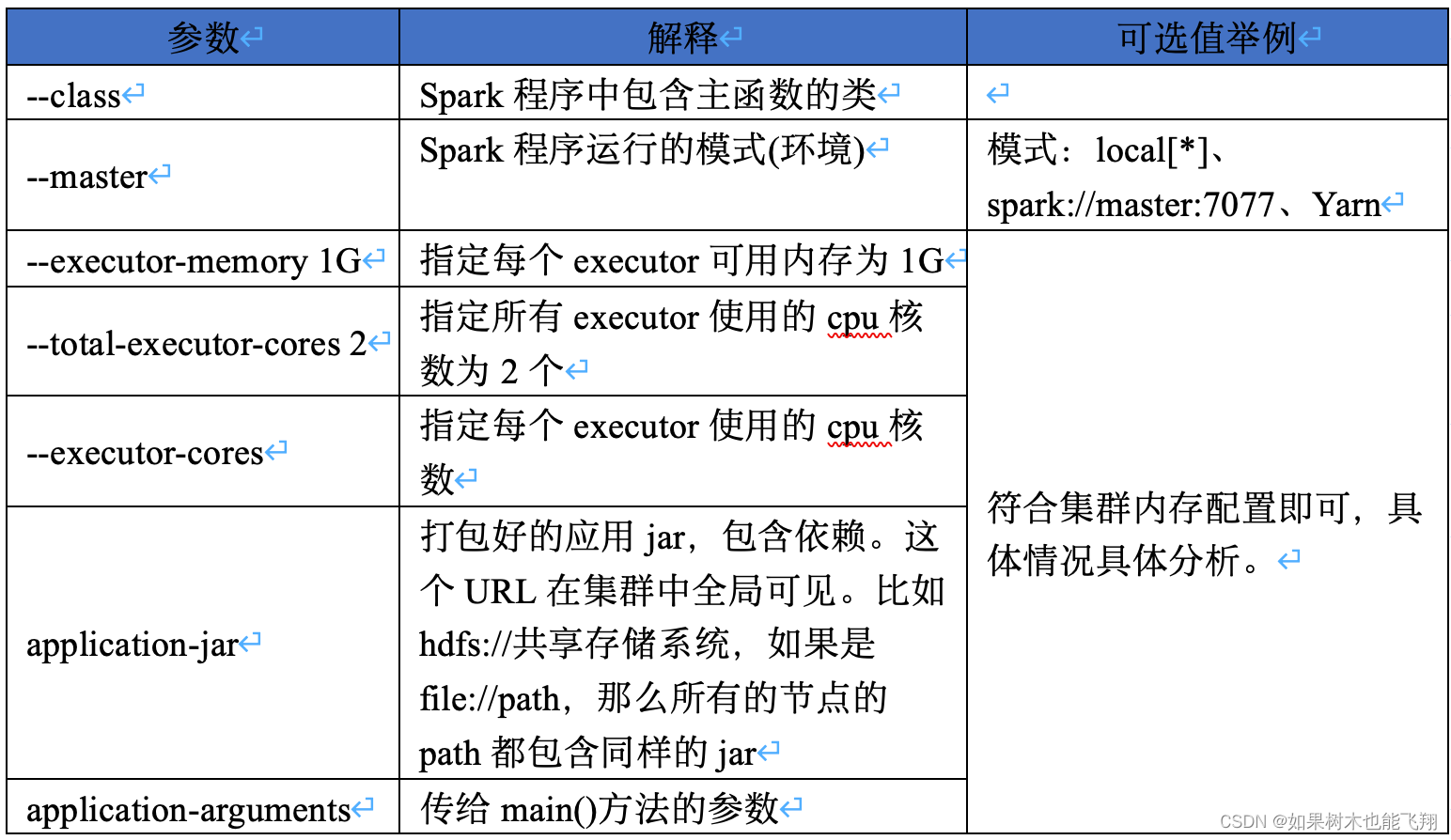

提交参数说明

在提交应用中,一般会同时一些提交参数

bin/spark-submit \

--class <main-class>

--master <master-url> \

... # other options

<application-jar> \

[application-arguments]

配置历史服务

由于spark-shell停止掉后,集群监控master:4040页面就看不到历史任务的运行情况,所以开发时都配置历史服务器记录任务运行情况。

(1)修改spark-defaults.conf.template文件名为spark-defaults.conf

[root@master conf]# mv spark-defaults.conf.template spark-defaults.conf

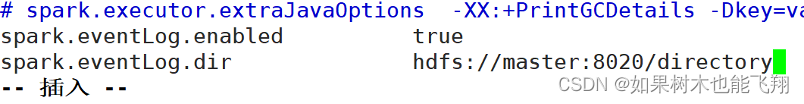

(2)修改spark-default.conf文件,配置日志存储路径

[root@master conf]# vim spark-defaults.conf

spark.eventLog.enabled true

spark.eventLog.dir hdfs://master:9000/directory

注意:需要启动hadoop集群,HDFS上的directory目录需要提前存在。

hadoop fs -mkdir /directory

(3)修改spark-env.sh文件, 添加日志配置

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://master:9000/directory

-Dspark.history.retainedApplications=30"

(4)分发配置文件

[root@master spark-standalone]# scp -r conf/ node1:`pwd`

[root@master spark-standalone]# scp -r conf/ node2:`pwd`

(5)重新启动集群和历史服务

sbin/start-all.sh

sbin/start-history-server.sh

(6)重新执行任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://master:7077 \

./examples/jars/spark-examples_2.11-2.4.5.jar \

10

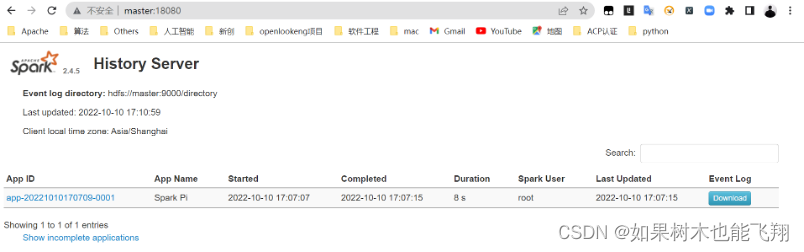

(7)查看历史服务:http://master:18080

Yarn模式

独立部署(Standalone)模式由Spark自身提供计算资源,无需其他框架提供资源。这种方式降低了和其他第三方资源框架的耦合性,独立性非常强。但是你也要记住,Spark主要是计算框架,而不是资源调度框架,所以本身提供的资源调度并不是它的强项,所以还是和其他专业的资源调度框架集成会更靠谱一些。所以接下来我们来学习在强大的Yarn环境下Spark是如何工作的(其实是因为在国内工作中,Yarn使用的非常多)。

上传并解压缩文件

将spark-2.4.5-bin-hadoop2.6.tgz文件上传到Linux并解压缩,放置在指定位置,路径中不要包含中文或空格。

(1)上传文件至/usr/local/packages中:

(2)解压缩到指定目录:

[root@master local]# tar -zxvf spark-2.4.5-bin-hadoop2.6.tgz -C /usr/local/soft/

(3)重命名:

[root@master soft]# mv spark-2.4.5-bin-hadoop2.6/ spark-yarn

修改配置文件

(1)修改hadoop配置文件/usr/local/soft/hadoop-2.7.6/etc/hadoop/yarn-site.xml, 并分发

<!--是否启动一个线程检查每个任务正使用的物理内存量,如果任务超出分配值,则直接将其杀掉,默认是true -->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<!--是否启动一个线程检查每个任务正使用的虚拟内存量,如果任务超出分配值,则直接将其杀掉,默认是true -->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

分发:

[root@master hadoop]# scp -r yarn-site.xml node1:`pwd`

[root@master hadoop]# scp -r yarn-site.xml node2:`pwd`

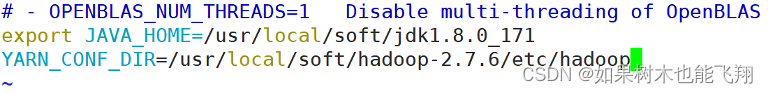

(2)修改conf/spark-env.sh,添加JAVA_HOME和YARN_CONF_DIR配置

[root@master conf]# mv spark-env.sh.template spark-env.sh

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

YARN_CONF_DIR=/usr/local/soft/hadoop-2.7.6/etc/hadoop

启动Hadoop集群

[root@master conf]# star-all.sh

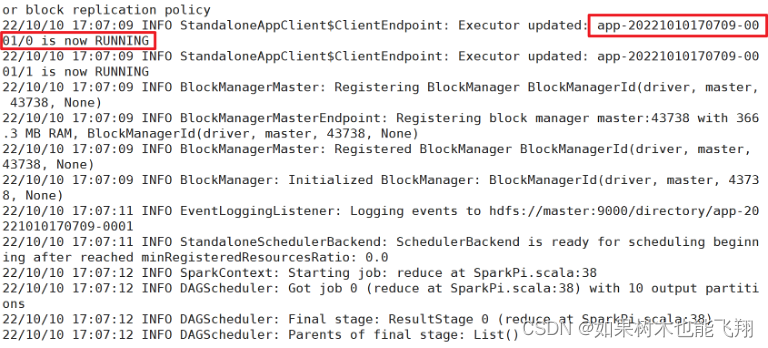

提交应用spark on yarn cluster模式,上线使用,不会再本地打印日志,减少io:

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode cluster \

./examples/jars/spark-examples_2.11-2.4.5.jar \

10

获取yarn程序执行日志,执行成功之后才能获取到:

yarn logs -applicationId application_1665713361275_0003

杀死yarn任务:

yarn application -kill application_1626660789491_0012

查看http://master:8088页面,点击History,查看历史页面

2064

2064

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?