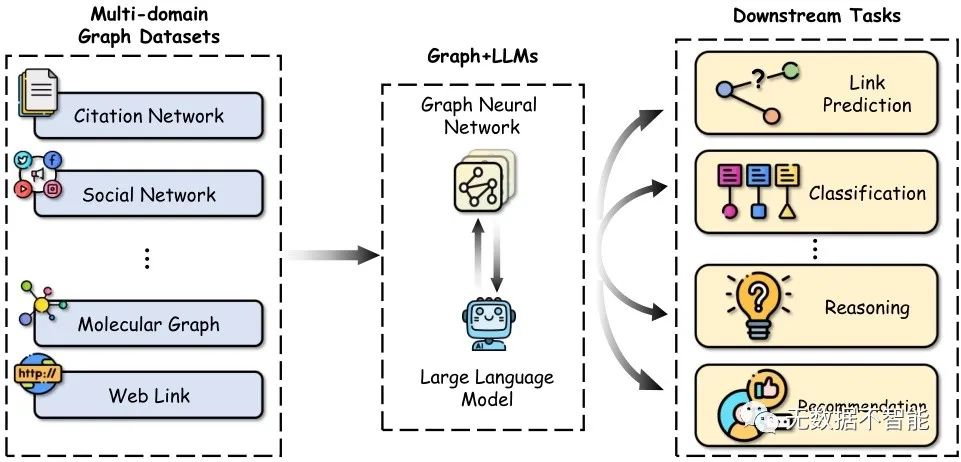

○ 介绍了图在表示和分析现实世界中复杂关系(如引用网络、社交网络和生物数据)中的重要作用。

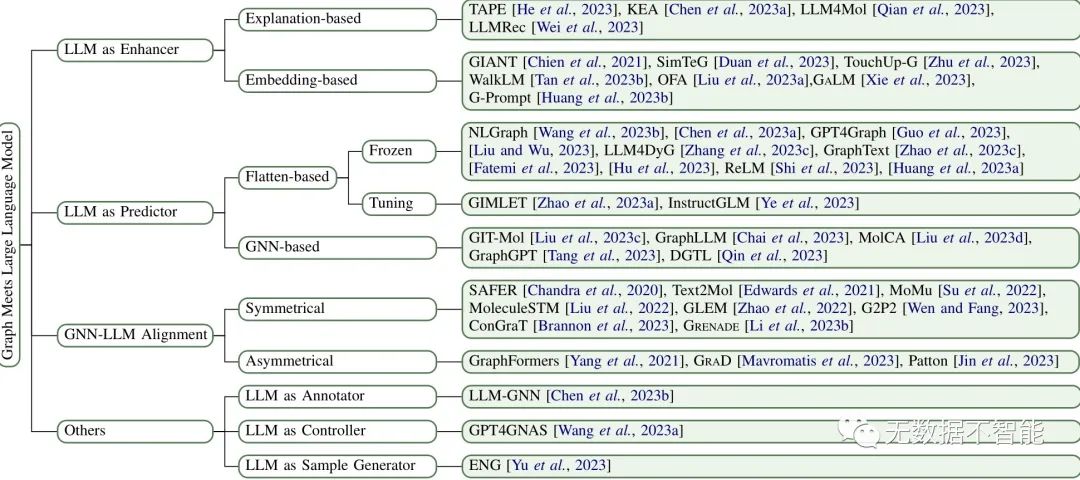

○ 综述了将大型语言模型(LLMs)与图结合的现有方法,并将其分为增强器、预测器和对齐组件三类。

○ 系统地调查了每类中代表性的方法。

○ 讨论了现有研究的局限性,并指出未来研究的有前景的方向。

1. 在图相关任务中,如何将大型语言模型(LLMs)与图结合,对图的处理有何帮助? 答:将LLMs与图结合可以提供更全面和强大的图学习能力。LLMs可以通过对文本属性的理解,为图节点提供更强大的特征表示,捕捉结构和上下文信息。而GNNs则擅长于捕捉图结构信息。将LLMs与GNNs结合可以有效地提升图的学习能力,使其能够处理更复杂的图相关任务。

2. LLM-as-enhancer方法中,采用LLMs增强图节点嵌入的方式有哪些? 答:LLM-as-enhancer方法可以分为两种方式:基于解释和基于嵌入。基于解释的方法通过使用LLMs生成解释、知识实体或伪标签等来增强文本属性。基于嵌入的方法直接利用LLMs生成文本嵌入作为图节点的初始嵌入。

3. 如何将LLMs应用于图相关任务的预测中? 答:LLMs可以作为图相关任务的预测模型,直接预测图的标签或结果。这些方法通常将图数据转换为文本描述或序列,通过LLMs进行预测。预测过程中还需要使用解析策略从LLMs的输出中提取预测结果。

4. LLM-as-predictor方法中的flatten-based预测和GNN-based预测有何不同? 答:flatten-based预测将图数据转换为文本描述作为LLMs的输入,然后通过解析策略从LLMs的输出中提取预测结果。GNN-based预测则利用GNNs将图结构编码为图表示,然后将图表示作为LLMs的输入进行预测。

5. 如何将GNNs和LLMs进行对齐,以实现图文融合? 答:对齐GNNs和LLMs的方法可以分为对称对齐和非对称对齐。对称对齐同时处理图和文本的编码过程,保证两个模态的性能相当。非对称对齐更强调其中一个模态,保持各自的特征,但在特定阶段协调两个模态的嵌入空间。

6. LLM-as-enhancer方法有哪些优势和劣势? 答:LLM-as-enhancer方法具有提供强大的文本特征表达能力、增强图学习能力的优势。但是,基于解释的方法遇到大规模数据处理时可能会有较大的开销,因为需要查询LLMs的API。

7. LLM-as-predictor方法相较于传统的GNN方法有何优势? 答:相较于传统的GNN方法,LLM-as-predictor方法在处理图的文本属性方面表现出更强的能力,尤其在零样本学习方面取得了显著的成果。

8. GNN-LLM Alignment方法中的对称对齐和非对称对齐有何区别? 答:对称对齐方法在对齐过程中对图和文本模态进行了相等的处理,确保两个模态的性能相当。非对称对齐方法则更强调其中一个模态的表达,并在特定阶段协调两个模态的嵌入空间。

9. LLM-as-predictor方法中的flatten-based预测和GNN-based预测各有哪些优缺点? 答:flatten-based预测有效性较高,但对于长距离依赖关系的捕捉有一定的限制。GNN-based预测则更高效,能够捕捉图的结构特征和依赖关系,但需要额外的GNN模块和联合训练。

10. 在GNN-LLM Alignment方法中,如何协调GNNs和LLMs的嵌入空间? 答:GNN-LLM Alignment方法会在特定阶段将GNNs和LLMs的嵌入空间协调起来,以确保两者在模态特征表示上能够兼容和协同工作,从而实现图文的融合。常见的方法包括设计对应的投影模块或特征交互机制来实现嵌入空间的对齐。

论文链接:https://arxiv.org/abs/2311.12399.pdf

本文探讨了如何将大型语言模型与图结合,分为增强器、预测器和对齐组件,概述了LLMs在图节点特征增强、预测任务中的应用以及GNNs的协作。文章还讨论了各种方法的优缺点,并指出了未来研究方向。

本文探讨了如何将大型语言模型与图结合,分为增强器、预测器和对齐组件,概述了LLMs在图节点特征增强、预测任务中的应用以及GNNs的协作。文章还讨论了各种方法的优缺点,并指出了未来研究方向。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?