目录

一、简介

1.1、什么是scrapy

scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。可以应用在包括数据挖掘、信息处理或存储历史数据等一系列的程序中。

1.2、结构性数据

类似的,具有相同结构的数据,称为结构性数据,如下图。

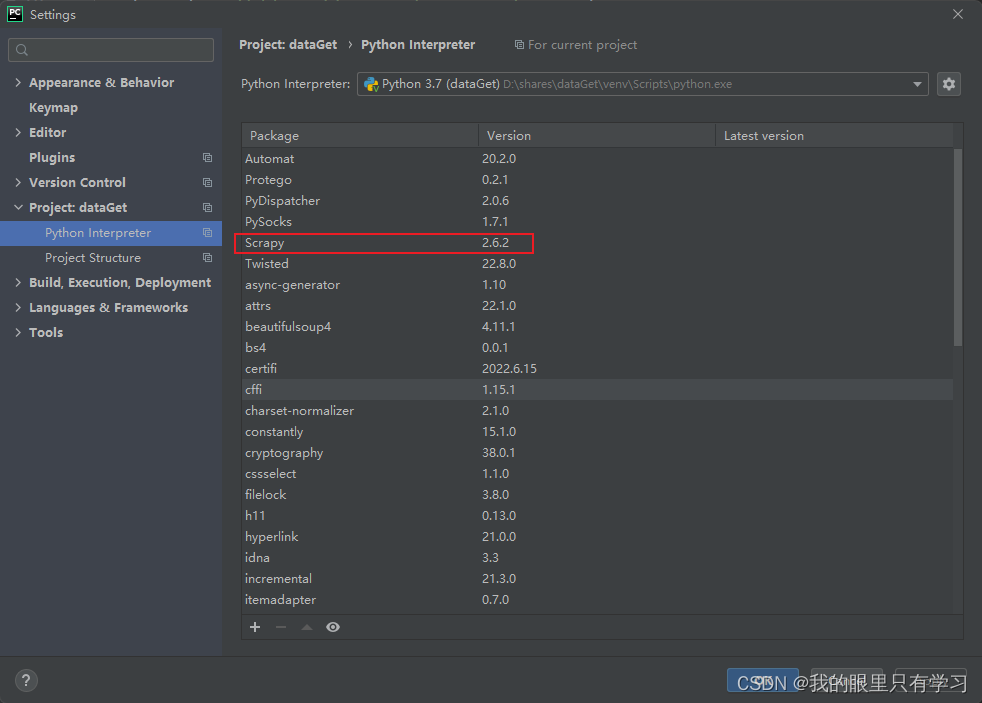

1.3、安装

二、scrapy的使用

2.1、创建scrapy项目

1)在终端输入:scrapy startproject 项目名称

注意:项目名称不能以数字开头,且不能包含中文

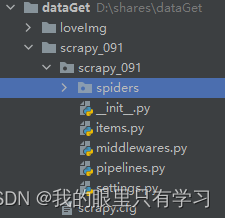

2)此时,在目录下会出现新建的scrapy项目

2.2、创建爬虫文件

1)进入spiders文件夹下,创建爬虫文件:scrapy genspider 爬虫文件名称

scrapy genspider baidu http://www.baidu.com

注意:1)需要在spiders文件夹中创建爬虫文件

2)域名不需要加http协议,scrapy会自动添加

2)创建成功:

3)baidu.py文件内容

注意:如果请求的页面以 html 结尾,最后的 “/” 需要删除

import scrapy

class BaiduSpider(scrapy.Spider):

# 爬虫名字:运行爬虫时使用

name = 'baidu'

# 允许访问的域名

allowed_domains = ['www.baidu.com']

# 起始的url地址,表示第一次访问的域名:

# start_urls = 'http://' + allowed_domains + '/'

start_urls = ['http://www.baidu.com/']

# 方法中response为爬取网页后的返回对象

# 类似于:respons

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

191

191

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?