1. 应用背景

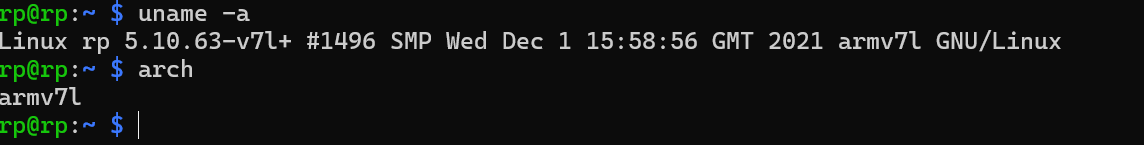

查看系统处理器的型号,用

uname -a 或者

arch

如下所示

2. 环境安装

numpy 安装

python3 -m pip install numpy -i https://pypi.tuna.tsinghua.edu.cn/simpleopencv安装

sudo apt-get update

sudo apt-get install python3-opencv -ypyqt5安装

sudo apt-get install python3-pyqt5scipy安装

sudo apt-get install python3-scipy -ytorch安装

参考:树莓派(7):树莓派4B+安装Pytorch新版本1.3(python3.7)_pymodbus python3.7-CSDN博客

其他版本的torch下载地址:

Releases · KumaTea/pytorch-arm

安装后报错

解决办法,安装 libopenblas-dev

sudo apt-get update

sudo apt-get install libopenblas-dev其他库的安装

pip3 install importlib-metadata

pip3 install importlib

pip3 install thop

pip3 install timm

sudo apt-get install python3-shapely

sudo apt-get install python3-matplotlib

sudo apt-get install python-yaml

sudo apt-get install python3-tqdmtimm安装,这个要多几个安装步骤

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

python3 -m pip install safetensors

python3 -m pip install timm3. python torch推理 速度测试

yolo11-seg 实例分割网络,输入尺寸是960,batch为1,耗时在20s左右,算法在10.5GFLOPS

4. onnxruntime推理测试

模型转为onnx后再进行推理测试

编译好的onnxruntime.wheel 包

运行时报错:

导致这个问题的原因是编译onnxruntime的gcc版本比较高,而我树莓派的gcc版本比较低,所以在树莓派上运行时会报错。

因为torch的速度已经要20秒左右很慢了, onnx推理速度估计提高不了多少,这个不符合我的要求,就不再鼓捣了。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?