Graph Neural Prompting with Large Language Models (GNP)

新型的一种软提示调优方法

背景

大型语言模型(llm)在各种语言建模任务中都表现出了显著的泛化能力和卓越的性能,模型规模的显著增长进一步赋予了llm突出性能力

动机

1:LLM包含大量的参数和它们需要大量的计算资源。

2:现存的方法仍然表现出语言建模在准确捕获和返回基础知识方面的固有局限性。

结构图

方法

Subgraph Retrieval

目的:为了在输入文本标记X与拥有数百万节点的庞大知识图G之间进行语义对齐

Graph Neural Prompting

GNN Encoder

直接输入实体三元组会引入噪声,阻碍LLM模型集中于关键信息。

用的是标准的图注意力网络。

Cross-modality Pooling

为了识别与问题相关的最相关的节点,并将节点嵌入整合为一个整体的图形级表示。

1:把H1经过自注意力机制层变成了Node Embs。

2:把text Emb经过两层FFN。然后把H2当query,T’作为key和value。进行一边注意力机制形成H3。

3:(H4)Graph Embs 是H3经过平均池化(average pooling)得到的。

Domain Projector

为了在图级嵌入和文本域之间创建一个映射,以方便LLM的理解。

就是H4经历两层FFN。

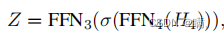

Self-supervised Link Prediction

设计了一个链接预测任务,以进一步细化其对实体之间关系的理解,并以自我监督的方式捕获图知识。

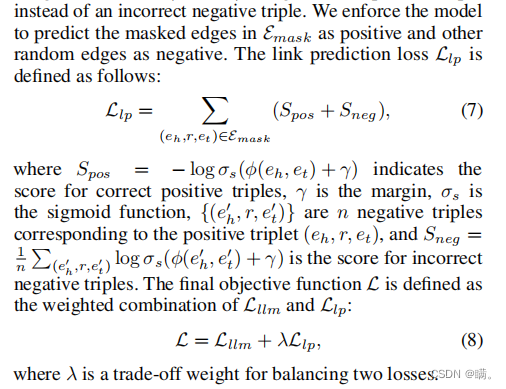

实验结果

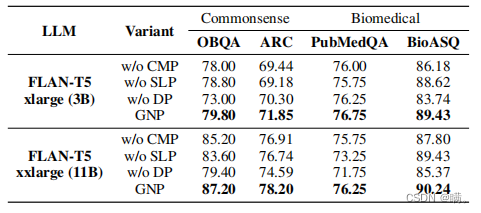

1:总体效果

通过很多数据集以及很多基线的对比,与input embedding Frozen的LLM 以及prompt tuning的LLM进行比较GNF的效果脱颖而出。GNP再用LORA微调一下效果会更好。(准确率是评价指标)

2:消融实验

证明了GNF的几个关键组件都是有效的,其中domain projector对模型影响的效果最大。

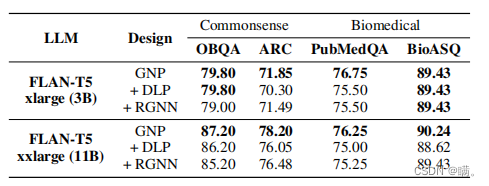

3:模型设计比较

意思就是GNF提供的实例级提示为LLM提供了足够的指导。

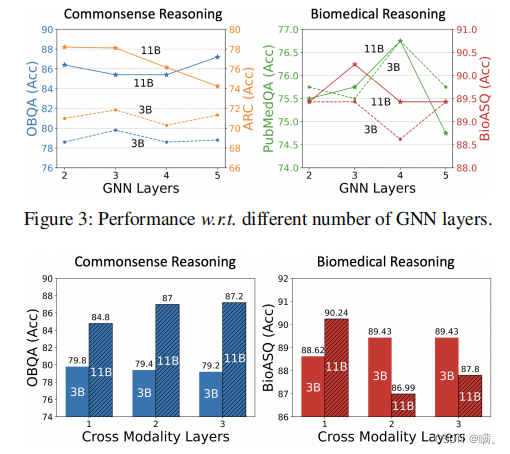

4:参数敏感度

GNN的层数和 cross-modality层数都对结果有影响。

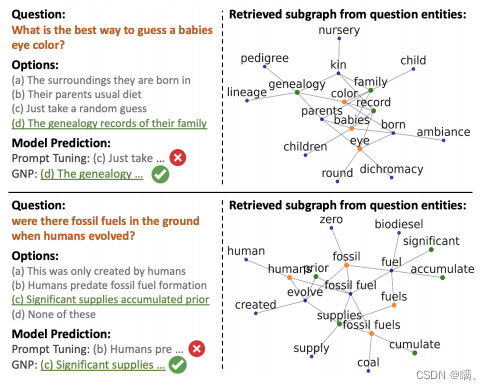

5:可视化

GNP方法具有在图中收集最关键信息以确定正确答案的能力,GNP能够捕获关键实体之间的结构接近性,并选择正确的答案。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?