A Survey on In-context Learning

摘要

随着大型语言模型(LLMs)能力的增强,上下文学习(ICL)已成为自然语言处理(NLP)领域的新范式,其中LLMs仅基于上下文中增加的一些示例进行预测。探索ICL以评估和推断LLMs的能力已成为一种新趋势。在本文中,我们旨在调查和总结ICL的进展和挑战。我们首先提出了ICL的正式定义,并阐明了它与相关研究的相关性。然后,我们组织并讨论了先进技术,包括训练策略、示例设计策略以及相关分析。最后,我们讨论了ICL的挑战,并为进一步研究提供了潜在方向。我们希望我们的工作能鼓励更多关于揭示ICL工作原理和改进ICL的研究。

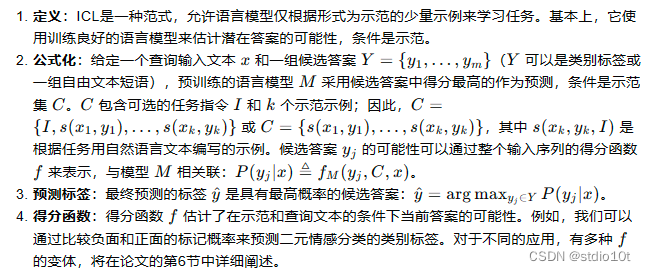

一、ICL的定义和公式化

二、模型预热

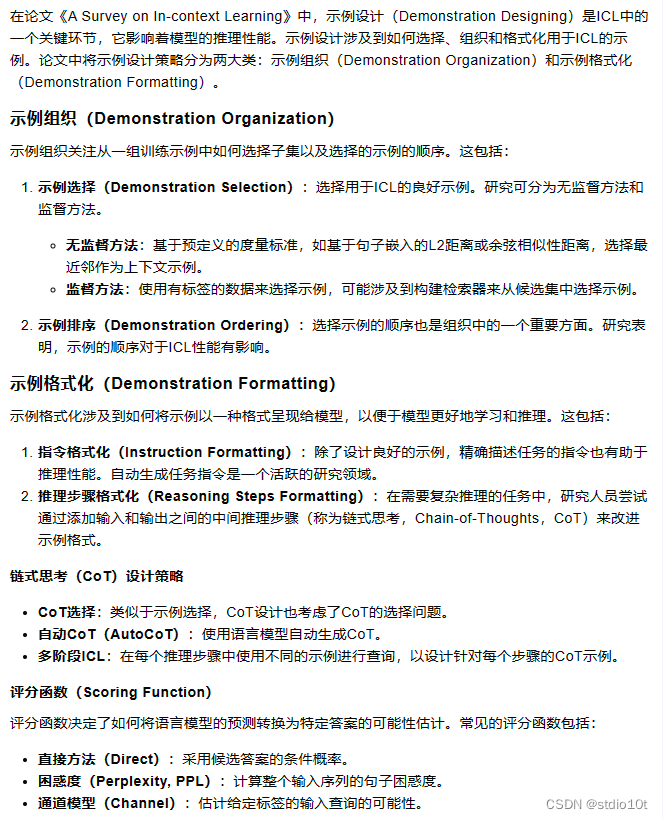

三、示例设计

四、ICL影响因素

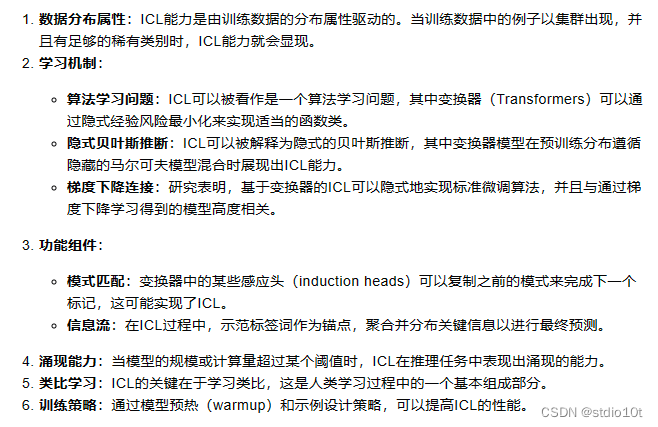

五、ICL为什么有效

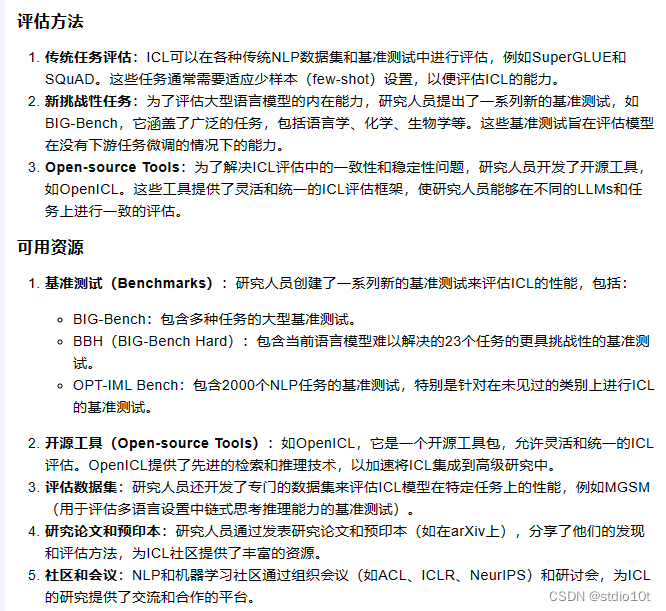

六、评估方法、可用资源

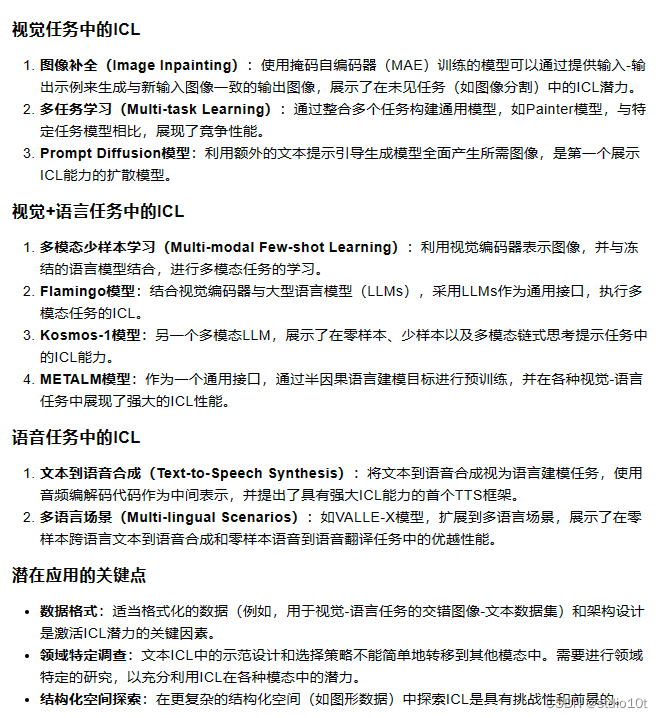

七、其它领域应用

421

421

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?