如果我们想在本地调用线上的OpenAI 接口,实现自己项目里的一个写入式AI功能,最简单便捷的方法就是以下几个步骤:

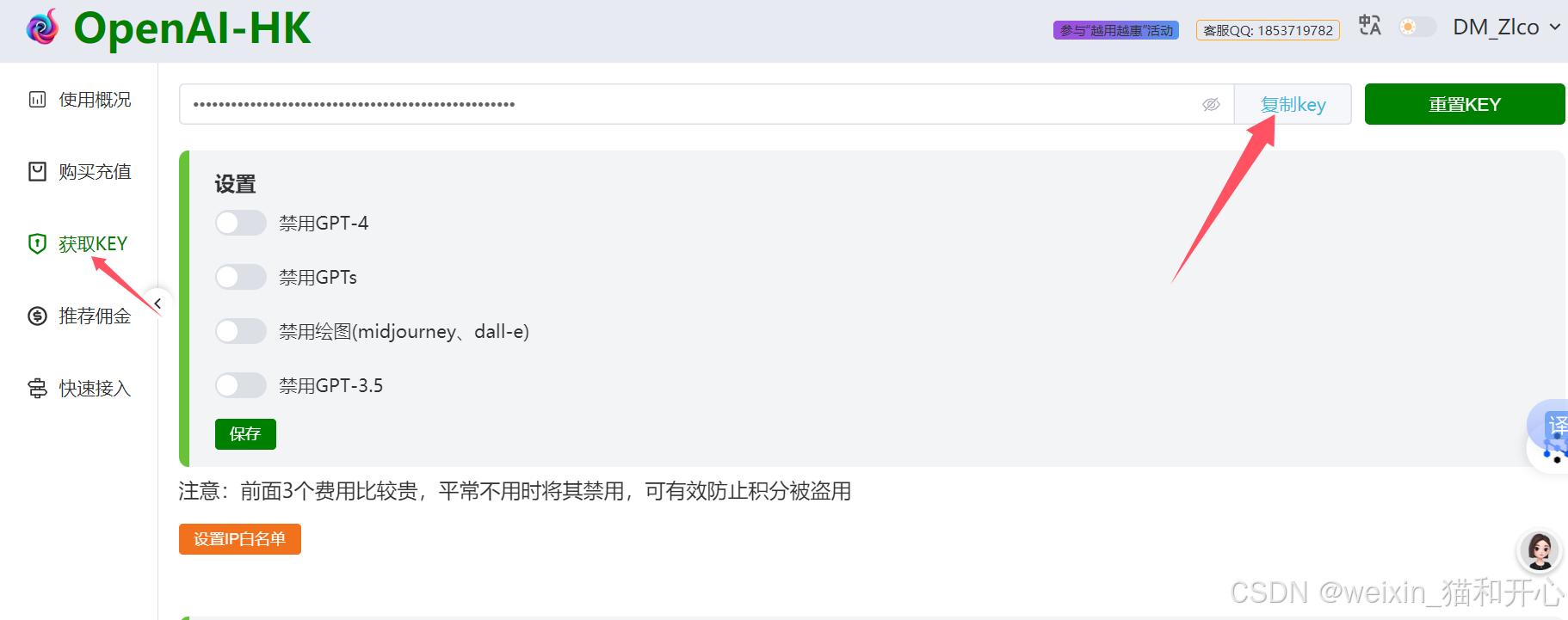

1、找到KEY

打开官网地址:https://openai-hk.com/open/index

点击右上角的“控制台”,再点击左侧的“获取KEY",再点击”复制KEY“

点击右上角的“控制台”,再点击左侧的“获取KEY",再点击”复制KEY“

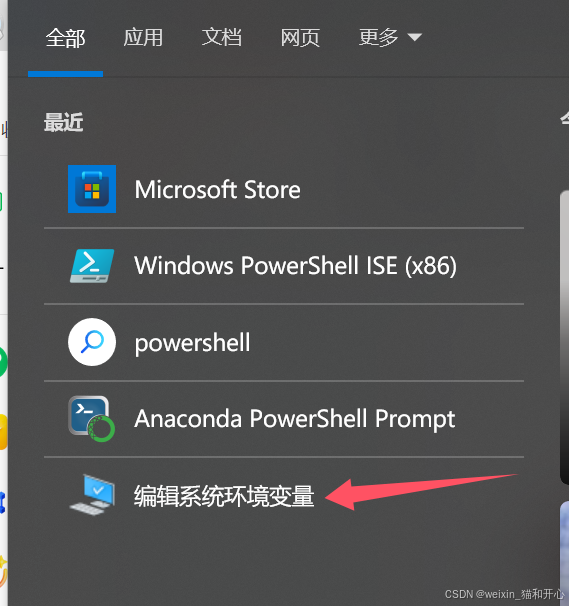

2、编辑系统环境变量

在电脑任务栏点击查找”放大镜“图标,再点击编辑系统环境变量

在电脑任务栏点击查找”放大镜“图标,再点击编辑系统环境变量

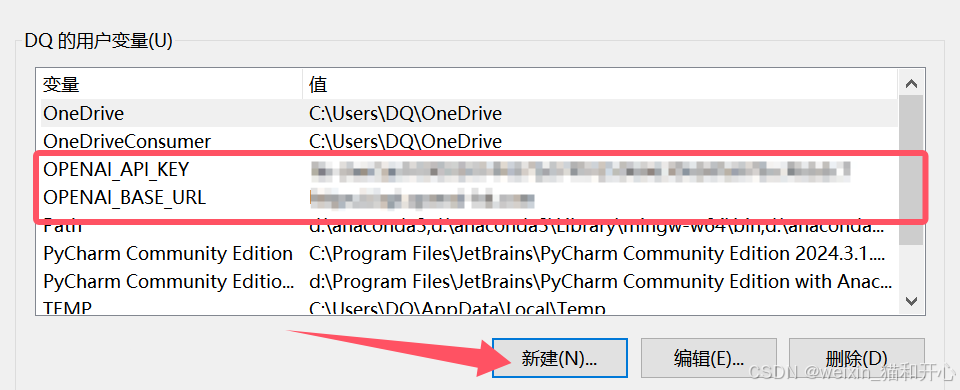

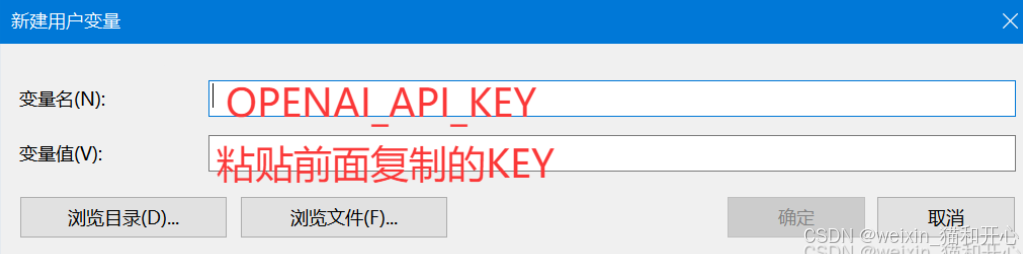

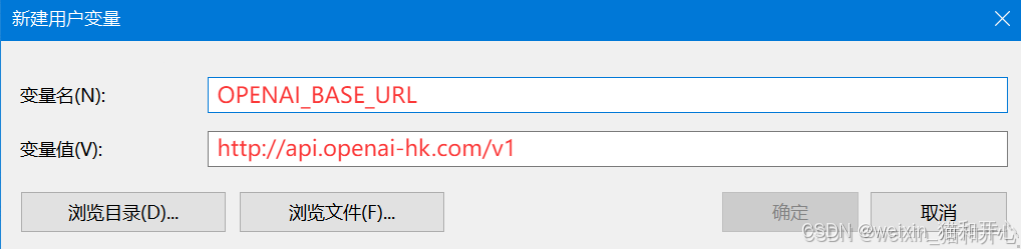

我的系统里面已有这两个变量,初次使用需要新建上面两个环境变量,具体方法为:

我的系统里面已有这两个变量,初次使用需要新建上面两个环境变量,具体方法为:

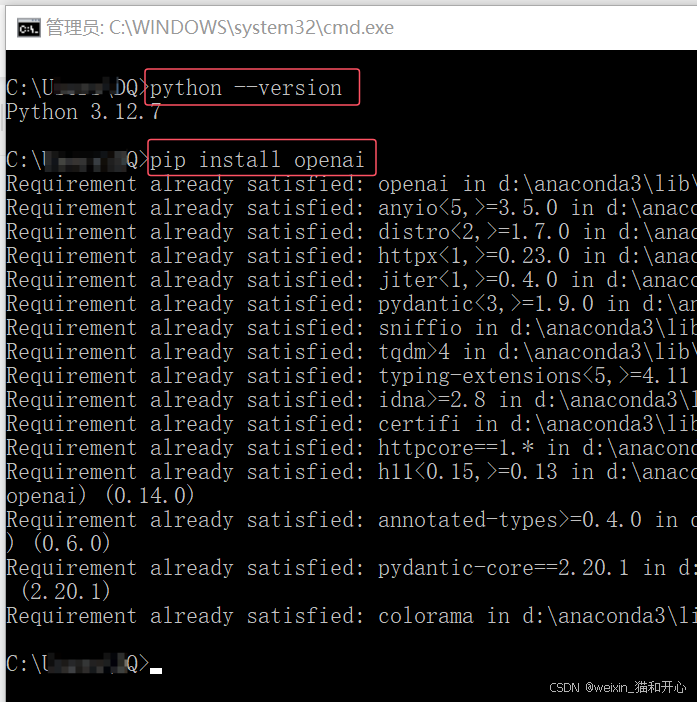

3、检查是否安装Python

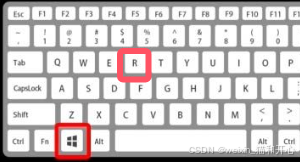

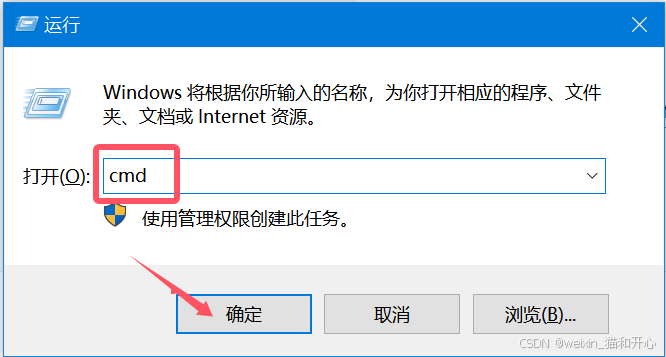

(1)按下“win+R”建,输入“cmd" 回车,

(2)查看是否安装Python,显示版本,如果已安装,接着安装一下openai

4、测试

一般会创建一个独立的空间再添加程序,本次这边不创建了。

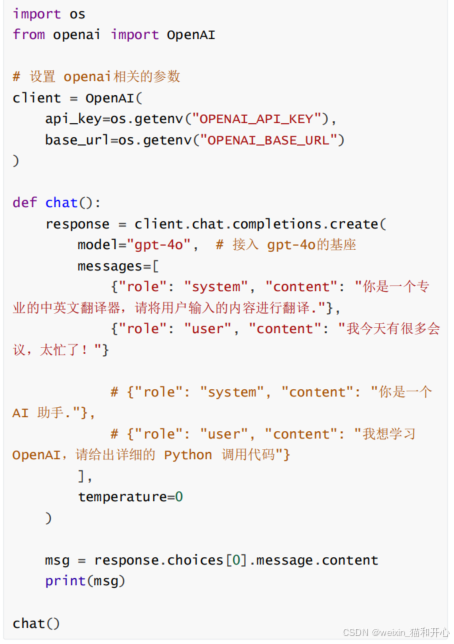

打开编辑器,粘贴下面代码

运行程序,稍等一会儿就可以看到调用的返回结果啦。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?