介绍

- 通常CNN网络在卷积层之后会接上若干个全连接层,将卷积层产生的特征图(feature map)映射成一个固定长度的特征向量,以AlexNet为代表的经典CNN结构适合图像级的分类和回归任务,因为最后得到整幅图像的的数值描述,比如AlexNet的ImageNet模型输出一个1000维的向量表示输入图像属于每一类的概率(softmax归一化)。

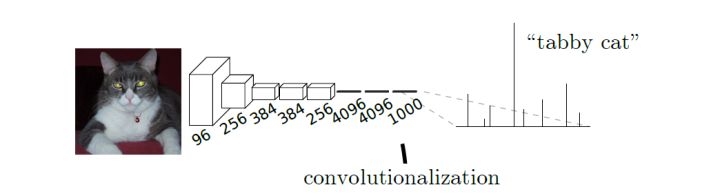

- 例子:AlexNet网中输入是下图中猫的图片,输出的结果是一个向量,表示输入图像属于每一类的概率,其中“tabby cat”这一统计概率最高。

- 而在本文中建立了一种可以接受任意大小图像,并输出与输入等大小的图像的全卷积神经网络,在文章中作者定义了全卷积神经网络(FCN)的空间结构,解释了FCN在空间密集型预测任务上的应用并且给出了他与之前其他网络之间的联系,之后通过迁移学习的方法进行微调(finetune),以此来完成所需要的分割任务。此外作者还定义了跳跃结构,通过结合来自于深的、粗糙层的语义信息和来自浅、细层的表征信息来产生准确和精细的分割。

相关工作

卷积网络在识别领域前进势头很猛,卷积网不仅在全图式的分类上有所提高,在结构化输出的局部任务上也取得了进步。包括检测目标边框、关键点预测和局部通信的进步。

在以往的分割方法中,主要有两大类缺点:

- 基于图像块分割的效率低,往往需要前期或后期处理;

- 语义分割面临在语义和位置的内在张力问题:全局信息解决的

是什么。局部信息解决的是在哪里。

为了解决上面这两个问题,本文主要有三个创新点:

- 将分类网络结果重新解释为全卷积神经网络结构,这里面具体包括两点,一个是全连接层转化为卷积层,还有就是通过反卷积进行上采样。

- 使用迁移学习的方法进行 finetune ,因为很明显通过第一点可知可以将 VGG 这类有预训练权重的分类网络重新解释为 FCN

- 使用跳跃结构使得,使得深的粗的语义信息可以结合浅的细的表征信息,产生准确和精细的分割。

以往的方法主要有以下的缺点:

- 限制容量和感受野的小模型;

- 分块训练;

- 超像素投影的预处理,随机场正则化、滤波或局部分类;

- 对于密集输出采用输入移位和输出交错的方法;

- 多尺度金字塔处理;

- 饱和双曲线正切非线性;

- 集成

- 基于 FCN 的方法没有以上缺点。

- 传统的基于CNN的分割方法:为了对一个像素分类,使用该像素周围的一个图像块作为CNN的输入用于训练和预测。这种方法有几个缺点:一是存储开销很大。例如对每个像素使用的图像块的大小为15x15,然后不断滑动窗口,每次滑动的窗口给CNN进行判别分类,因此则

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+