1.RAID概念-企业级RAID-0-1-5-10的工作原理

磁盘阵列(Redundant Arraysof Independent Disks,RAID),有“独立磁盘构成的具有冗余能力的阵列”之意。磁盘阵列是由很多价格较便宜的磁盘,以硬件(RAID卡)或软件(MDADM)形式组合成一个容量巨大的磁盘组,利用多个磁盘组合在一起,提升整个磁盘系统效能。利用这项技术,将数据切割成许多区段,分别存放在各个硬盘上。磁盘阵列还能利用同位检查(ParityCheck)的观念,在磁盘组中任意一个硬盘故障时,仍可读出数据,在数据重构时,将数据经计算后重新置入新硬盘中

注:RAID可以预防数据丢失,但是它并不能完全保证你的数据不会丢失,所以大家使用RAID的同时还是注意备份重要的数据

RAID的创建有两种方式:软RAID(通过操作系统软件来实现)和硬RAID(使用硬件阵列卡);在企业中用的最多的是:opt/test2、raid5和opt/test20。

不过随着云的高速发展,供应商一般可以把硬件问题解决掉。

RAID几种常见的类型

RAID基本思想:把好几块硬盘通过一定组合方式把它组合起来,成为一个新的硬盘阵列组,从而使它能够达到高性能硬盘的要求

RAID有三个关键技术:

镜像:提供了数据的安全性;

chunk条带(块大小也可以说是条带的粒度),它的存在的就是为了提高I/O,提供了数据并发性

数据的校验:提供了数据的安全

Raid相对于单个磁盘优点

2、RAID-0的工作原理

条带(strping),也是我们最早出现的RAID模式

需磁盘数量:2块以上(大小最好相同),是组建磁盘阵列中最简单的一种形式,只需要2块以上的硬盘即可.

特点:成本低,可以提高整个磁盘的性能和吞吐量。RAID0没有提供冗余或错误修复能力,但速度快.

任何一个磁盘的损坏将损坏全部数据;磁盘利用率为100%

3、RAID-1的工作原理

mirroring(镜像卷),需要磁盘两块以上

原理:是把一个磁盘的数据镜像到另一个磁盘上,也就是说数据在写入一块磁盘的同时,会在另一块闲置的磁盘上生成镜像文件,(同步)opt/test2mirroring(镜像卷),至少需要两块硬盘,raid大小等于两个raid分区中最小的容量(最好将分区大小分为一样),数据有冗余,在存储时同时写入两块硬盘,实现了数据备份;磁盘利用率为50%,即2块100G的磁盘构成opt/test2只能提供100G的可用空间。如下图

4.RAID-5的工作原理

需要三块或以上硬盘,可以提供热备盘实现故障的恢复;只损坏一块,没有问题。但如果同时损坏两块磁盘,则数据将都会损坏。空间利用率:(n-1)/n 2/3 如下图所示

奇偶校验信息的作用:

当RAID5的一个磁盘数据发生损坏后,利用剩下的数据和相应的奇偶校验信息去恢复被损坏的数据。

扩展:异或运算

是用相对简单的异或逻辑运算(相同为0,相异为1)

| A值 | B值 | Xor结果 |

|---|---|---|

| 0 | 0 | 0 |

| 1 | 0 | 1 |

| 0 | 1 | 1 |

| 1 | 1 | 0 |

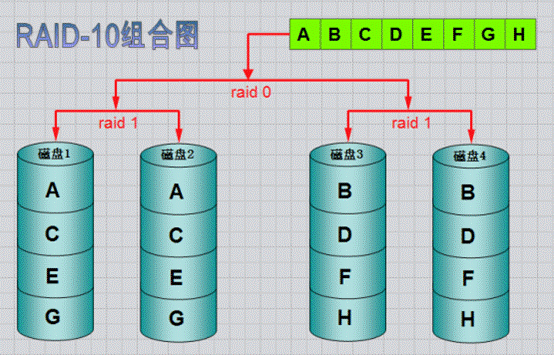

4.RAID-10的工作原理

RAID-10 镜像+条带

opt/test20是将镜像和条带进行两级组合的RAID级别,第一级是opt/test2镜像对,第二级为RAID0。比如我们有8块盘,它是先两两做镜像,形成了新的4块盘,然后对这4块盘做RAID0;当opt/test20有一个硬盘受损其余硬盘会继续工作,这个时候受影响的硬盘只有2块

几个方案对比下来,RAID5是最适合的,如下图:

5.RAID硬盘失效处理

一般两种处理方法:热备和热插拔

热备:HotSpare

定义:当冗余的RAID组中某个硬盘失效时,在不干扰当前RAID系统的正常使用的情况下,用RAID系统中另外一个正常的备用硬盘自动顶替失效硬盘,及时保证RAID系统的冗余性

全局式:备用硬盘为系统中所有的冗余RAID组共享

专用式:备用硬盘为系统中某一组冗余RAID组专用

如下图所示:是一个全局热备的示例,该热备盘由系统中两个RAID组共享,可自动顶替任何一个RAID中的一个失效硬盘

热插拔:HotSwap

定义:在不影响系统正常运转的情况下,用正常的物理硬盘替换RAID系统中失效硬盘。

6.RAID的实现方式

互动:我们做硬件RAID,是在装系统前还是之后?

答:先做阵列才装系统,一般服务器启动时,有显示进入配置Riad的提示,比如:按下CTRL+L/H/M进入配置raid界面

硬RAID:需要RAID卡,我们的磁盘是接在RAID卡的,由它统一管理和控制。数据也由它来进行分配和维护;它有自己的cpu,处理速度快

软RAID:通过操作系统实现

Linux内核中有一个md(multipledevices)模块在底层管理RAID设备,它会在应用层给我们提供一个应用程序的工具mdadm,mdadm是linux下用于创建和管理软件RAID的命令。

mdadm命令常见参数解释

| 参数 | 作用 | 参数 | 作用 |

|---|---|---|---|

| -C或–creat | 建立一个新阵列 | -r | 移除设备 |

| -A | 激活磁盘阵列 | -l或–level= | 设定磁盘阵列的级别 |

| -D或–detail | 打印阵列设备的详细信息 | -n或–raid-devices= | 指定阵列成员(分区/磁盘)的数量 |

| -s或–scan | 扫描配置文件或/proc/mdstat得到阵列缺失信息 | -x或–spare-devicds= | 指定阵列中备用盘的数量 |

| -f | 将设备状态定为故障 | -c或–chunk= | 设定阵列的块chunk块大小,单位为KB |

| -a或–add | 添加设备到阵列 | -G或–grow | 改变阵列大小或形态 |

| -v | –verbose显示详细信息 | -S | 停止阵列 |

实验环境:新添加11块硬盘,每块磁盘的作用如下:

互动:磁盘达到sdz以后,名字应该如何排?

答:sdaa、sdab。。。

实验环境:

| raid种类 | 磁盘 | 热备盘 |

|---|---|---|

| raid0 | sdb、sdc | |

| raid1 | sdd、sde | sdf |

| raid5 | sdg、sdh、sdi | sdj |

| raid10 | 分区:sdk1,sdk2,sdk3,sdk4 |

注:工作作中正常做raid全部是使用独立的磁盘来做的。为了节约资源,opt/test20以一块磁盘上多个分区来代替多个独立的磁盘做raid,但是这样做出来的raid没有备份数据的作用,因为一块磁盘坏了,这个磁盘上所做的raid也就都坏了。

7.创建RAID0

请注意,以下案例请根据自身设备操作,请勿超额使用。我每次操作案列都将恢复快照重新添盘操作,但是案例的磁盘名会按照上面说的样子采用,请灵活脑袋替换代入

实验环境:

| raid种类 | 磁盘 | 热备盘 |

|---|---|---|

| raid0 | sdb、sdc |

1、创建raid0

请注意,使用mdadm命令需要yum安装

[root@exercise1 ~]# yum -y install mdadm.x86_64 #yum安装mdadm

[root@exercise1 ~]# mdadm -C -v /dev/md0 -l 0 -n 2 /dev/sdb /dev/sdc

mdadm: chunk size defaults to 512K

mdadm: Fail to create md0 when using /sys/module/md_mod/parameters/new_array, fallback to creation via node

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md0 started.

[root@exercise1 ~]#

[root@exercise1 ~]# mdadm -Ds

ARRAY /dev/md0 metadata=1.2 name=exercise1:0 UUID=8abab33d:92bf0898:320fd5c1:76517bbc

[root@exercise1 ~]# mdadm -D /dev/md0

/dev/md0:

Version : 1.2

Creation Time : Fri Feb 4 11:16:33 2022

Raid Level : raid0

Array Size : 41908224 (39.97 GiB 42.91 GB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Fri Feb 4 11:16:33 2022

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Chunk Size : 512K

Consistency Policy : none

Name : exercise1:0 (local to host exercise1)

UUID : 8abab33d:92bf0898:320fd5c1:76517bbc

Events : 0

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

[root@exercise1 ~]# mdadm -Ds > /dev/mdadm.conf #生成配置文件

3、对创建的RAID0进行文件系统创建并挂载

[root@exercise1 ~]# mkfs.xfs /dev/md0

meta-data=/dev/md0 isize=512 agcount=16, agsize=654720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=10475520, imaxpct=25

= sunit=128 swidth=256 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=5120, version=2

= sectsz=512 sunit=8 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

[root@exercise1 ~]# mkdir /opt/raid0

[root@exercise1 ~]# mount /dev/md0 /opt/raid0

[root@exercise1 ~]# df -h

文件系统 容量 已用 可用 已用% 挂载点

/dev/sda3 18G 2.3G 16G 13% /

devtmpfs 479M 4.0K 479M 1% /dev

tmpfs 489M 0 489M 0% /dev/shm

tmpfs 489M 6.7M 482M 2% /run

tmpfs 489M 0 489M 0% /sys/fs/cgroup

/dev/sr0 4.3G 4.3G 0 100% /mnt

/dev/sda1 197M 97M 100M 50% /boot

tmpfs 98M 0 98M 0% /run/user/0

/dev/md0 40G 33M 40G 1% /opt/raid0

[root@exercise1 ~]# echo 324 > /opt/raid0/a.txt

开机自动挂载

[root@exercise1 ~]# echo "/dev/md0 /opt/raid0/ xfs defaults 0 0" >> /etc/fstab

8.创建RAID1

请注意,以下案例请根据自身设备操作,请勿超额使用。我每次操作案列都将恢复快照重新添盘操作,但是案例的磁盘名会按照上面说的样子采用,请灵活脑袋替换代入

实验内容如下

| raid种类 | 磁盘 | 热备盘 |

|---|---|---|

| raid1 | sdb、sdc | sdd |

1)创建RAID1

2)添加1个热备盘

3)模拟磁盘故障,自动顶替故障盘

4)从RAID1中移出故障盘

[root@exercise1 ~]# yum -y install mdadm.x86_64 #yum安装mdadm

[root@exercise1 ~]# mdadm -C -v /dev/md1 -l 1 -n 2 -x 1 /dev/sd[b,c,d]

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store '/boot' on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

--metadata=0.90

mdadm: size set to 20954112K

Continue creating array? #回车

Continue creating array? (y/n) y #输入y

mdadm: Fail to create md1 when using /sys/module/md_mod/parameters/new_array, fallback to creation via node

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md1 started.

#将RADI信息保存到配置文件

[root@exercise1 ~]# mdadm -Dsv >> /etc/mdadm.conf

#查看RAID阵列信息:

[root@exercise1 ~]# mdadm -D /dev/md1

/dev/md1:

Version : 1.2

Creation Time : Fri Feb 4 14:13:12 2022

Raid Level : raid1

Array Size : 20954112 (19.98 GiB 21.46 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 2

Total Devices : 3

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:13:44 2022

State : clean, resyncing

Active Devices : 2

Working Devices : 3

Failed Devices : 0

Spare Devices : 1

Consistency Policy : resync

Resync Status : 34% complete

Name : exercise1:1 (local to host exercise1)

UUID : b2e9b71a:c2b6a348:a9acf5cc:83cbb87b

Events : 5

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

2 8 48 - spare /dev/sdd

[root@exercise1 ~]#

在RAID设备上创建文件系统

[root@exercise1 ~]# mkfs.xfs /dev/md1

meta-data=/dev/md1 isize=512 agcount=4, agsize=1309632 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=5238528, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=2560, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

[root@exercise1 ~]# mkdir /opt/test2

[root@exercise1 ~]# mount /dev/md1 /opt/test2/

#准备测试文件

[root@exercise1 ~]# cp /etc/passwd /opt/test2/

[root@exercise1 ~]#

模拟损坏

下面模拟RAID1中数据盘/dev/sdc出现故障,观察/dev/sdd备用盘能否自动顶替故障盘

[root@exercise1 ~]# mdadm /dev/md1 -f /dev/sdc

mdadm: set /dev/sdc faulty in /dev/md1

#查看一下阵列状态信息

[root@exercise1 ~]# mdadm -D /dev/md1

/dev/md1:

Version : 1.2

Creation Time : Fri Feb 4 14:13:12 2022

Raid Level : raid1

Array Size : 20954112 (19.98 GiB 21.46 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 2

Total Devices : 3

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:20:17 2022

State : active, degraded, recovering

Active Devices : 1

Working Devices : 2

Failed Devices : 1

Spare Devices : 1

Consistency Policy : resync

Rebuild Status : 10% complete

Name : exercise1:1 (local to host exercise1)

UUID : b2e9b71a:c2b6a348:a9acf5cc:83cbb87b

Events : 21

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

2 8 48 1 spare rebuilding /dev/sdd

1 8 32 - faulty /dev/sdc

[root@exercise1 ~]#

更新配置文件

[root@exercise1 ~]# mdadm -Dsv > /etc/mdadm.conf

#查看数据是否丢失

[root@exercise1 ~]# ls /opt/test2/ #数据正常,没有丢失

passwd

[root@exercise1 ~]#

重要的数据如:数据库;系统盘(把系统安装到opt/test2的md1设备上,可以对md1做分区)

移除损坏的设备:

[root@exercise1 ~]# mdadm -r /dev/md1 /dev/sdc

mdadm: hot removed /dev/sdc from /dev/md1

#查看信息:

[root@exercise1 ~]# mdadm -D /dev/md1

/dev/md1:

Version : 1.2

Creation Time : Fri Feb 4 14:13:12 2022

Raid Level : raid1

Array Size : 20954112 (19.98 GiB 21.46 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:23:11 2022

State : active

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Consistency Policy : resync

Name : exercise1:1 (local to host exercise1)

UUID : b2e9b71a:c2b6a348:a9acf5cc:83cbb87b

Events : 38

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

2 8 48 1 active sync /dev/sdd

[root@exercise1 ~]#

添加一块新热备盘

[root@exercise1 ~]# mdadm -a /dev/md1 /dev/sdc

mdadm: added /dev/sdc

9.创建RAID5

请注意,以下案例请根据自身设备操作,请勿超额使用。我每次操作案列都将恢复快照重新添盘操作,但是案例的磁盘名会按照上面说的样子采用,请灵活脑袋替换代入

实验环境

| raid种类 | 磁盘 | 热备盘 |

|---|---|---|

| raid5 | sdb、sdc、sdd | sde |

1)创建RAID5,添加1个热备盘,指定块大小为32K

-x或–spare-devicds= 指定阵列中备用盘的数量

-c或–chunk= 设定阵列的块chunk块大小,单位为KB

2)停止阵列,重新激活阵列

3)使用热备盘,扩展阵列容量,从3个磁盘扩展到4个

创建RAID-5

[root@exercise1 ~]# yum -y install mdadm.x86_64 #yum安装mdadm

[root@exercise1 ~]# mdadm -C -v /dev/md5 -l 5 -n 3 -x 1 -c32 /dev/sd{b,c,d,e}

mdadm: layout defaults to left-symmetric

mdadm: layout defaults to left-symmetric

mdadm: size set to 20954112K

mdadm: Fail to create md5 when using /sys/module/md_mod/parameters/new_array, fallback to creation via node

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md5 started.

[root@exercise1 ~]# mdadm -D /dev/md5

/dev/md5:

Version : 1.2

Creation Time : Fri Feb 4 14:38:18 2022

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:38:25 2022

State : clean, degraded, recovering

Active Devices : 2

Working Devices : 4

Failed Devices : 0

Spare Devices : 2

Layout : left-symmetric

Chunk Size : 32K

Consistency Policy : resync

Rebuild Status : 10% complete

Name : exercise1:5 (local to host exercise1)

UUID : 575ed5ec:eb30731f:3d731f5a:9b5bfb40

Events : 2

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

4 8 48 2 spare rebuilding /dev/sdd

3 8 64 - spare /dev/sde

[root@exercise1 ~]#

停止MD5阵列

停止前,一定要先保存配置文件

[root@exercise1 ~]# mdadm -Dsv > /etc/mdadm.conf #停止前,一定要先保存配置文件

[root@exercise1 ~]# mdadm -D /dev/md5 #停止前,请确认数据已经同步完

/dev/md5:

Version : 1.2

Creation Time : Fri Feb 4 14:38:18 2022

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:39:43 2022

State : clean, degraded, recovering

Active Devices : 2

Working Devices : 4

Failed Devices : 0

Spare Devices : 2

Layout : left-symmetric

Chunk Size : 32K

Consistency Policy : resync

Rebuild Status : 82% complete

Name : exercise1:5 (local to host exercise1)

UUID : 575ed5ec:eb30731f:3d731f5a:9b5bfb40

Events : 14

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

4 8 48 2 spare rebuilding /dev/sdd

3 8 64 - spare /dev/sde

#等一两分钟比较一下会发现以下变化

#ConsistencyPolicy:resync#数据已经同步完

#Rebuild Status : 82% complete #同步状态,同步完,此行消失

[root@exercise1 ~]# mdadm -D /dev/md5

/dev/md5:

Version : 1.2

Creation Time : Fri Feb 4 14:45:50 2022

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:47:34 2022

State : clean

Active Devices : 3

Working Devices : 4

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 32K

Consistency Policy : resync

Name : exercise1:5 (local to host exercise1)

UUID : 1a3a979d:a8ce124f:f58e06f9:22c841ae

Events : 18

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

4 8 48 2 active sync /dev/sdd

3 8 64 - spare /dev/sde

[root@exercise1 ~]# mdadm -S /dev/md5

mdadm: stopped /dev/md5

[root@exercise1 ~]#

激活MD5阵列

[root@exercise1 ~]# mdadm -As

mdadm: Fail to create md5 when using /sys/module/md_mod/parameters/new_array, fallback to creation via node

mdadm: /dev/md5 has been started with 3 drives and 1 spare.

[root@exercise1 ~]#

扩展RAID5磁盘阵列

将热备盘增加到md5中,使用md5中可以使用的磁盘数量为4块

[root@exercise1 ~]# mdadm -G /dev/md5 -n4 -c32 #-G或--grow改变阵列大小或形态

[root@exercise1 ~]# mdadm -Dsv > /etc/mdadm.conf #保存配置文件

备注:阵列只有在正常状态下,才能扩容,降级及重构时不允许扩容。对于raid5来说,只能增加成员盘,不能减少。而对于opt/test2来说,可以增加成员盘,也可以减少。

[root@exercise1 ~]# mdadm -D /dev/md5 #查看状态

/dev/md5:

Version : 1.2

Creation Time : Fri Feb 4 14:45:50 2022

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Fri Feb 4 14:50:58 2022

State : clean, reshaping

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 32K

Consistency Policy : resync

Reshape Status : 27% complete

Delta Devices : 1, (3->4)

Name : exercise1:5 (local to host exercise1)

UUID : 1a3a979d:a8ce124f:f58e06f9:22c841ae

Events : 49

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

4 8 48 2 active sync /dev/sdd

3 8 64 3 active sync /dev/sde

…

Array Size : 41908224 (39.97 GiB 42.91 GB) #发现新增加硬盘后空间没有变大,为什么?

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

…

…

Reshape Status : 27% complete #重塑状态:3%完成,等到100%,数据才同步完,同步完后会变成:ConsistencyPolicy:resync #一致性策略:再同步,表示已经同步完

…

Number Major Minor RaidDevice State

0 8 16 0 active sync /dev/sdb

1 8 32 1 active sync /dev/sdc

4 8 48 2 active sync /dev/sdd

3 8 64 3 active sync /dev/sde

…

等一会,等所有数据同步完成后,查看md5空间大小:

Array Size : 62862336 (59.95 GiB 64.37 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

10.创建RAID10

请注意,以下案例请根据自身设备操作,请勿超额使用。我每次操作案列都将恢复快照重新添盘操作,但是案例的磁盘名会按照上面说的样子采用,请灵活脑袋替换代入

实验环境

| raid种类 | 磁盘 | 热备盘 |

|---|---|---|

| raid10 | 分区:sdb1,sdb2,sdb3,sdb4 |

[root@exercise1 ~]# yum -y install mdadm.x86_64 #yum安装mdadm

[root@exercise1 ~]# fdisk /dev/sdb #分4个主分区,每个分区1G大小

[root@exercise1 ~]# mdadm -C -v /dev/md10 -l10 -n4 /dev/sdb[1-4]

mdadm: layout defaults to n2

mdadm: layout defaults to n2

mdadm: chunk size defaults to 512K

mdadm: size set to 1046528K

mdadm: Fail to create md10 when using /sys/module/md_mod/parameters/new_array, fallback to creation via node

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md10 started.

[root@exercise1 ~]# cat /proc/mdstat

Personalities : [raid10]

md10 : active raid10 sdb4[3] sdb3[2] sdb2[1] sdb1[0]

2093056 blocks super 1.2 512K chunks 2 near-copies [4/4] [UUUU]

unused devices: <none>

[root@exercise1 ~]# mdadm -D /dev/md10

/dev/md10:

Version : 1.2

Creation Time : Fri Feb 4 15:07:03 2022

Raid Level : raid10

Array Size : 2093056 (2044.00 MiB 2143.29 MB)

Used Dev Size : 1046528 (1022.00 MiB 1071.64 MB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Fri Feb 4 15:07:13 2022

State : clean

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Layout : near=2

Chunk Size : 512K

Consistency Policy : resync

Name : exercise1:10 (local to host exercise1)

UUID : a5488635:1559dd7c:15dc3092:0c0948b1

Events : 17

Number Major Minor RaidDevice State

0 8 17 0 active sync set-A /dev/sdb1

1 8 18 1 active sync set-B /dev/sdb2

2 8 19 2 active sync set-A /dev/sdb3

3 8 20 3 active sync set-B /dev/sdb4

删除RAID所有信息及注意事项

[root@exercise1 ~]# umount /dev/md10 /opt/test1 #如果你已经挂载raid,就先卸载

[root@exercise1 ~]# mdadm -Ss #停止raid设备

[root@exercise1 ~]# rm -rf /etc/mdadm.conf #删除raid配置文件

[root@exercise1 ~]# mdadm --zero-superblock /dev/sdb #清除物理磁盘中的raid标识

mdadm: Unrecognised md component device - /dev/sdb

参数:–zero-superblock: erase the MD superblock from a device. #擦除设备中的MD超级块

需求:

实现RAID与lvm的存储方案(自由发挥)

3539

3539

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?