使用日志服务,读取函数计算产生的日志

-

因为日志服务Logtail默认只采集增量的日志文件(大白话来讲就是只支持最近产生的文件查看,有可能就几个小时)所以如果需要导入历史文件,可使用Logtail自带的导入历史文件功能。

-

前提是:已在服务器上安装0.16.15(Linux系统)或1.0.0.1(Windows系统)及以上版本的Logtail,

-

白话文翻一下阿里云操作步骤

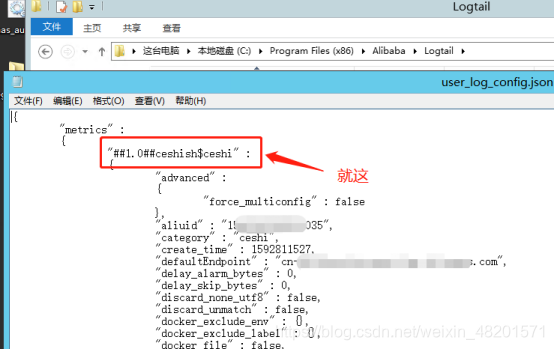

1.获取Logtail配置的唯一标识。 您可以在Logtail安装目录下的user_log_config.json文件中获取Logtail配置的唯一标识。 (就看看你自己的project叫什么名字,别找错)

2.添加本地事件。

在Logtail安装目录下,创建local_event.json文件。

在local_event.json文件中添加本地事件,类型为标准JSON,格式如下所示。

[

{

"config" : "${your_config_unique_id}",

"dir" : "${your_log_dir}",

"name" : "${your_log_file_name}"

},

{

实例也就是下边这个样子

[

{

"config" : "##1.0##ceshish$ceshi",//Logtail配置的唯一标识

"dir" : "C:\\runtime\\log202006",

//这里是你的文件路径:注意啊得指定到实际目录,历史数据采集不支持递归子目录

"name" : "*.log" //需要采集的文件后缀

}

]

每一次修改的时候一定要注意,看看这个文件会不会丢失。

那么关于ecs上面的一些操作就结束了,下面看看阿里云上的部分操作

首先还是创建一个自己的project,这个比较简单,自己搜搜看看就会

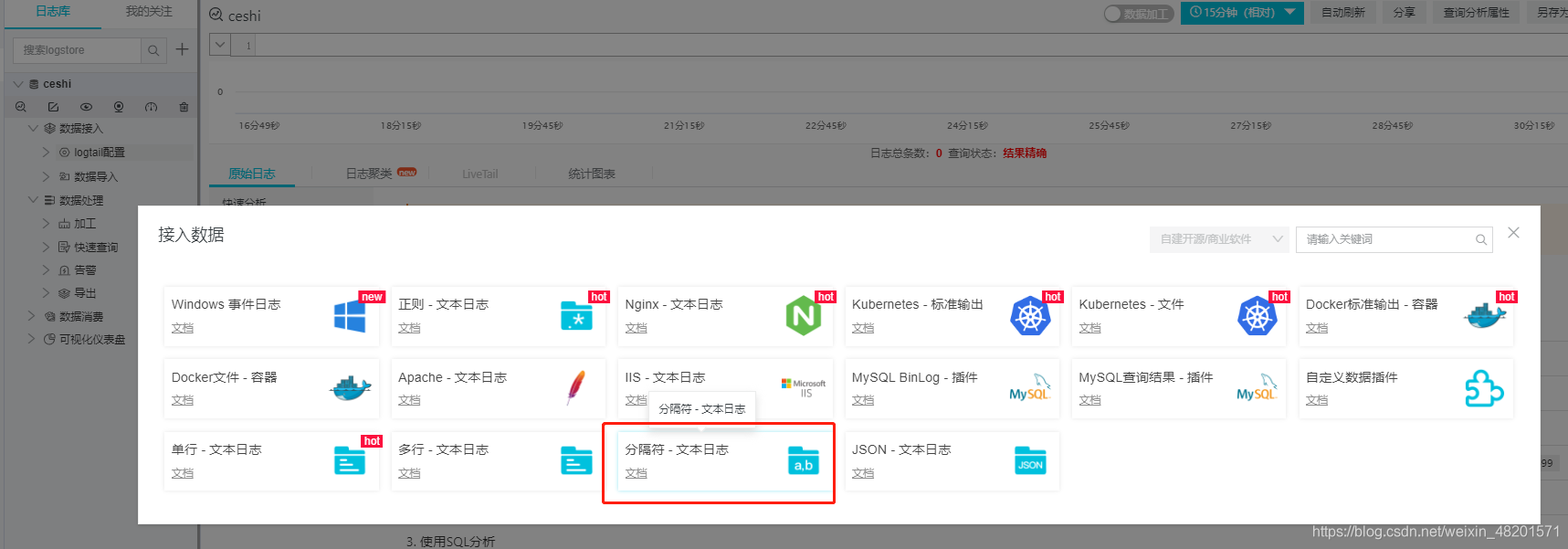

建好后,接入数据。这估计会有两种情况会出现,

1:边建project的时候直接就接入数据

2:没等到接入数据就关掉界面了,我们下次进来时可以将直接点击自己建好的内阁project,

进去后在接入这个配置就完事了

选择分隔符日志直接接入

进入后如果已经有机器组看就直接使用,没有的选中你的实例。点击下一步,一步步操作

正常来讲下一步后会出现心跳这个东西,显示有可能是full,多点击几下重试,直到变为ok再进行下一步

变不了的看看是不是上边的Logtail没安装,自己排除下错误。然后就回到下面的这个界面

之后直接下一步下一步,按照下边点击查看即可

本文记录了在使用阿里云函数计算时遇到的日志服务配置问题,包括一个logstore只能配置一个目录的限制、ECS上local_event.json文件更新的重要性以及掌握正则表达式的必要性。通过导入历史日志文件功能,解决了增量日志采集的问题。

本文记录了在使用阿里云函数计算时遇到的日志服务配置问题,包括一个logstore只能配置一个目录的限制、ECS上local_event.json文件更新的重要性以及掌握正则表达式的必要性。通过导入历史日志文件功能,解决了增量日志采集的问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?