大数据工程实战:

实时数据流处理

一、案例简介

1.1 需求

1.2 背景及架构

二、案例目的及任务

2.1 实验目的

2.2 实验任务

三、时间安排

四、实验环境搭建

4.1 安装java环境

4.1.1 安装并解压

4.1.2 配置环境变量

4.2 安装Hadoop

4.3 安装HBase

4.3.1 下载安装文件

4.3.2 配置环境变量

4.4 安装spark

4.4.1 下载安装文件

4.4.2 配置相关文件

4.5 安装Flume

4.5.1 下载安装文件

4.5.2 配置环境变量

4.6 安装Kafka

4.7 安装Maven

4.8 安装Tomcat

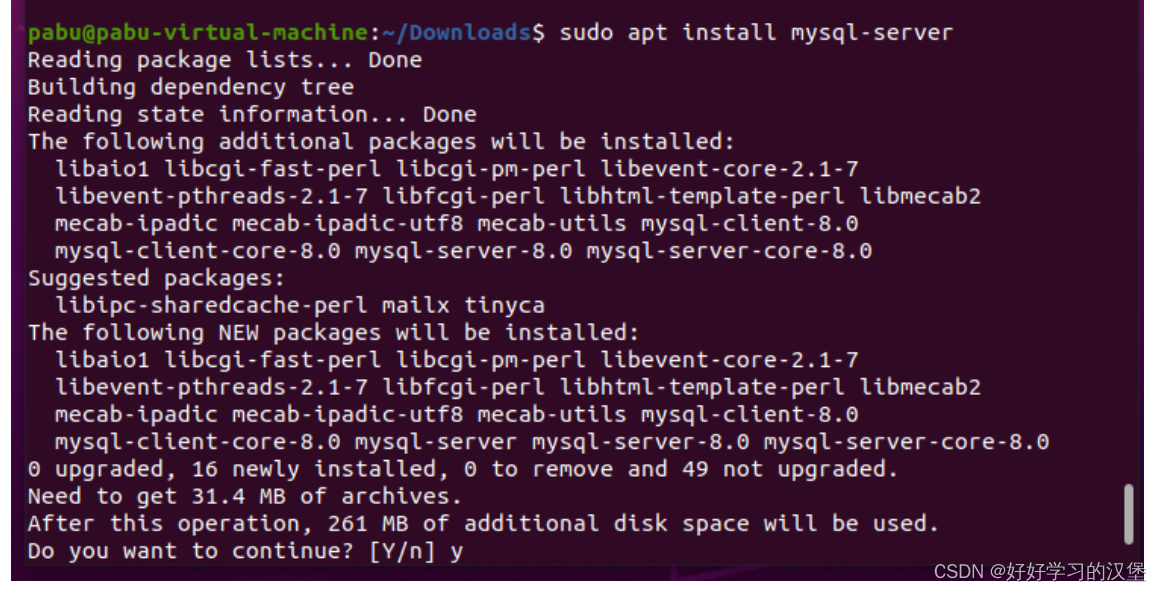

4.9 安装Mysql

4.10 下载JDBC驱动包

五、实验步骤

5.1 编写python脚本

5.2 设置Ubuntu定时器

5.3 利用Flume与Kafka进行日志数据采集

5.3.1 创建Flume日志文件

5.3.2 创建kafka主题

5.3.3 测试

5.4 在HBase中创建项目需要的表

5.4.1 启动HBase

5.4.2 创建项目需要的表

5.5 构建后端项目

5.5.1 构建项目

5.5.2 引入依赖

5.5.3 具体的代码实现

5.5.3.1 Util

5.5.3.2 domain

5.5.3.3 dao

5.5.3.4 application

5.6 测试运行程序

5.6 构建前端项目

5.6.1 创建Maven项目

5.6.2 引入依赖

5.6.3 添加项目框架

5.6.4 配置JDBC

5.6.5 部署Tomcat

5.6.6 设置classes和lib

5.6.6.1 配置项目Path

5.6.6.2 添加依赖到lib文件夹

5.6.7 Mysql配置 5.6.8 测试

5.6.8.1 Tomcat测试

5.6.8.2 测试HBase是否连接成功

5.6.8.3 测试mysql是否连接成功

5.6.10 具体的代码实现

5.6.10.1 引入依赖

5.6.10.2 utils

5.6.10.3 controller

5.6.10.4 js

5.6.10.5 jsp

六、数据可视化展示

七、实践总结

一、案例简介

1.1 需求

如今大数据技术已经遍布生产的各个角落,其中又主要分为离线处理和实时流处理。本实战项目则是使 用了实时流处理,而大数据的实时流式处理的特点为: 数据会不断的产生,且数量巨大。 需要对产生额数据实时进行处理。 处理完的结果需要实时读写进数据库或用作其他分析。

1.2 背景及架构 数据的处理一般涉及数据的聚合,数据的处理和展现能够在秒级或者毫秒级得到响应。针对这些问题目 前形成了Flume + kafka + Storm / Spark /Flink + Hbase / Redis 的技架构。本实战采用Flume + kafka + Spark + Hbase的架构。

二、案例目的及任务

2.1 实验目的 掌握实时流处理技术

2.2 实验任务

编写python脚本,源源不断产生学习网站的用户行为日志。 启动 Flume 收集产生的日志。 启动 Kafka 接收 Flume 接收的日志。 使用 Spark Streaming 消费 Kafka 的用户日志。 Spark Streaming将数据清洗过滤非法数据,然后分析日志中用户的访问课程,统计课程数,以及 搜索引擎访问量 将 Spark Streaming 处理的结果写入 HBase 中。 前端使用 jsp+JQuery+ajax设计模式整合作为数据展示平台。 使用Ajax异步传输数据到jsp页面,并使用 Echarts 框架展示数据。

关于本次实验详情见主页详细报告。

269

269

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?