习题7-1:在小批量梯度下降中,试分析为什么学习率要和批量大小成正比.

答:在小批量梯度下降中:

令,则:

因此我们要使得参数最优,则α K \frac{\alpha}{K}Kα为最优的时候的常数,故学习率要和批量大小成正比。

习题7-2:在Adam算法中,说明指数加权平均的偏差修正的合理性(即公式(7.27)和公式(7.28)).

答:在Adam算法中:

因此当的时候:

因此可以发现此时梯度消失,因此需要进行偏差偏正

习题7-9:证明在标准的随机梯度下降中,权重衰减正则化和l,正则化的效果相同.并分析这一结论在动量法和 Adam算法中是否依然成立.

答:

L2正则化:

L2正则化损失函数相对于参数w的偏导数(梯度)

得到损失函数的偏导数结果后,将结果代入梯度下降学习规则中,代入后,打开括号,重新排列,使其等价于在一定假设下的权值衰减方程。

最终重新排列的L2正则化方程和权值衰减方程之间的唯一区别是α(学习率)乘以λ(正则化项)。为了得到两个方程,我们用λ来重新参数化L2正则化方程。

将λ'替换为λ,对L2正则化方程进行重新参数化,将其等价于权值衰减方程,如下式所示。

where

综上,在标准的随机梯度下降中,权重衰减正则化和l2正则化的效果相同得证。

但这一结论在动量法和Adam算法中不成立。L2正则化梯度更新的方向取决于最近一段时间内梯度的加权平均值。

当与自适应梯度相结合时(动量法和Adam算法),L2正则化导致具有较大历史参数 (和/或) 梯度振幅的权重被正则化的程度小于使用权值衰减时的情况。

总结:

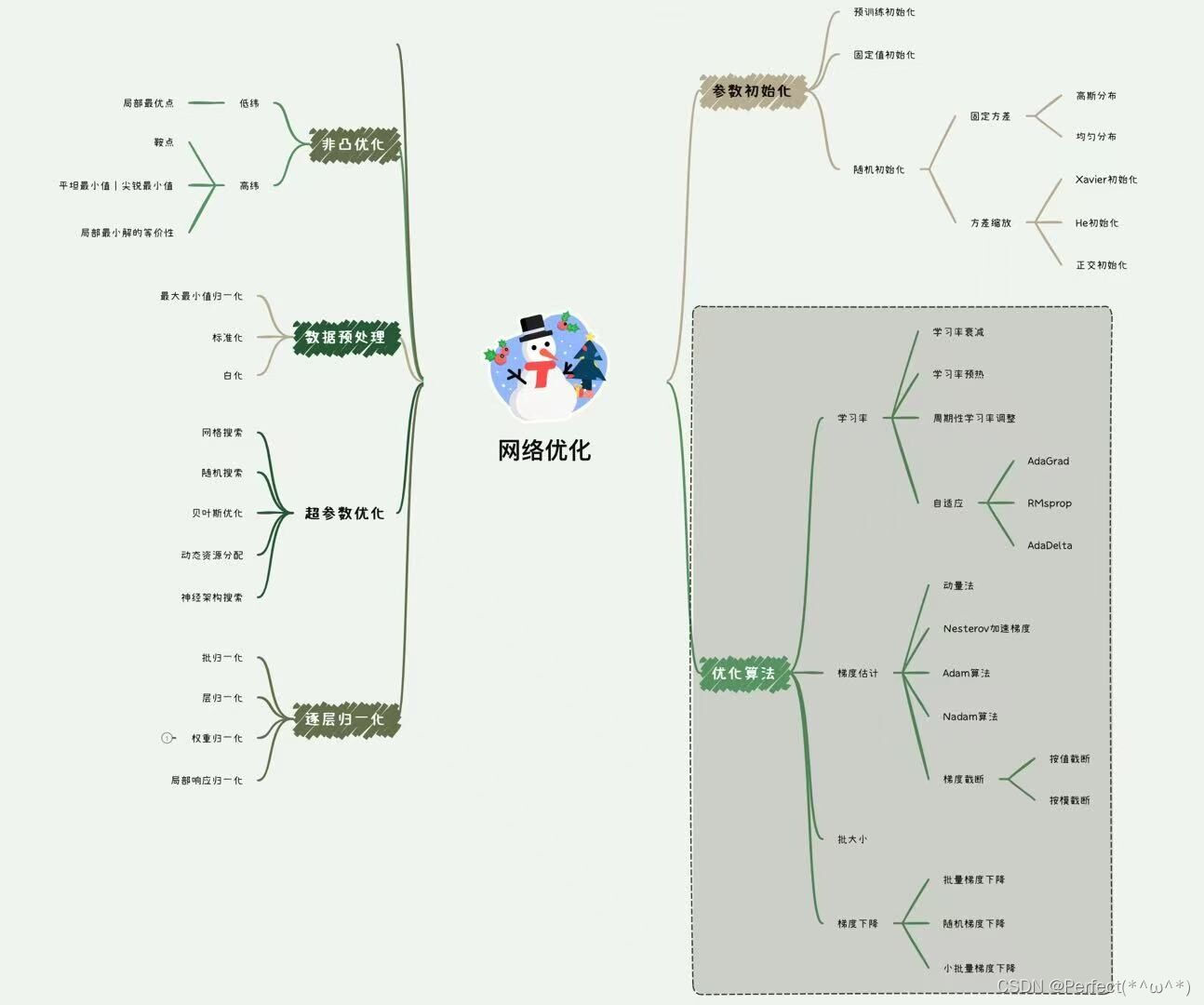

这是本学期的最后一个作业了,在老师的谆谆教诲下,经过一学期的学习和努力对深度学习有了更加深入的认识。通过本次作业知道了网络优化的几个常用算法,以及为什么在小批量梯度下降中学习率与权重大小成正比等。思维导图可以将知识很好的很好的归纳总结,是个不错的学习方法,自己以后也会多多运用。

1189

1189

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?