安装Termux并利用proot-distro运行Debian系统

见:https://blog.csdn.net/weixin_55513715/article/details/141286018

安装必要软件

进入Debian:

proot-distro login debian安装必要的软件

apt install sudo vim systemd systemctl -y安装Ollama

脚本安装

网页:https://ollama.com/download/linux

此时安装命令如下:

curl -fsSL https://ollama.com/install.sh | sh手动安装

由于国内的网络问题,建议手动安装。

https://blog.csdn.net/weixin_55513715/article/details/141333342

使用

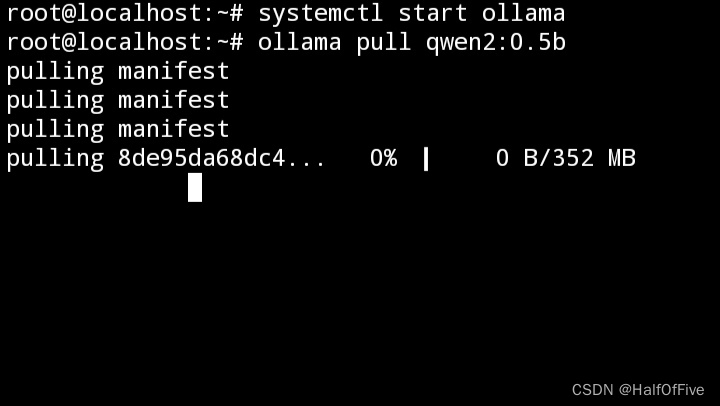

启动该服务

由于手机端的特别,需要手动启动Ollama服务。

systemctl start ollama下载模型

查找模型网址:https://ollama.com/library

下载模型(以通义千问2的0.5b为例):

ollama pull qwen2:0.5b

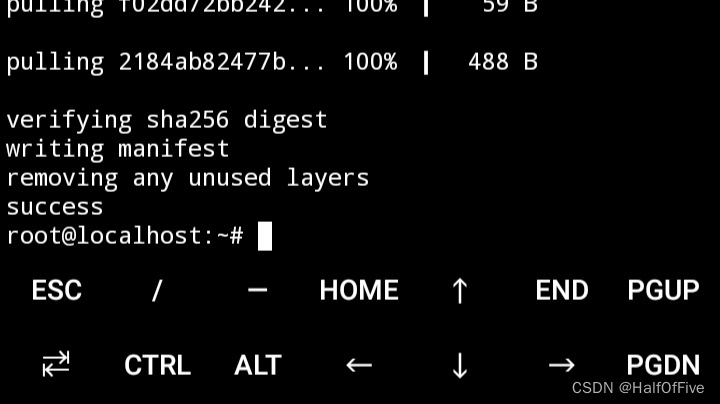

出现success则代表成功下载,否则,请重新执行上面的命令。

由于服务器在国外,时好时坏,但速度有时还可以。

运行模型

以通义千问2的0.5b为例

ollama run qwen2:0.5b更多技巧

在对话中的可用命令:

/set设置会话变量

/show显示型号信息

/load<model>加载会话或模型

/save<model>保存当前会话

/清晰的会话上下文

/再见出口

/?, /help命令的帮助

/? 快捷键键盘快捷键帮助

使用"""开始多行消息。

实现进入Debian终端时自启动

编辑文件~/.bashrc,追加一下命令(以通义千问2的0.5b为例):

systemctl start ollama

ollama run qwen2:0.5b你也可以使用命令直接追加

echo "systemctl start ollama

ollama run qwen2:0.5b" >> ~/.bashrc效果图

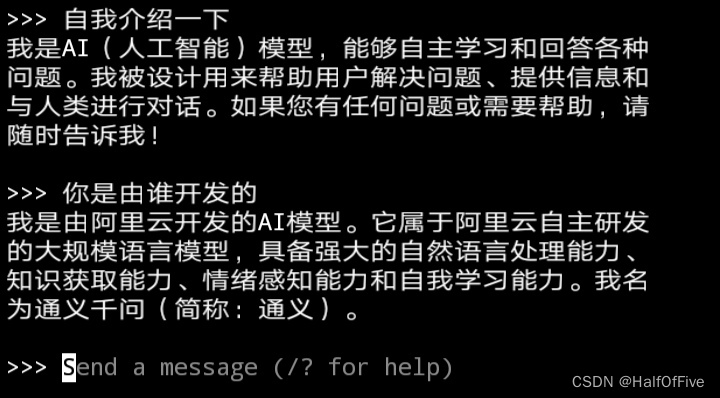

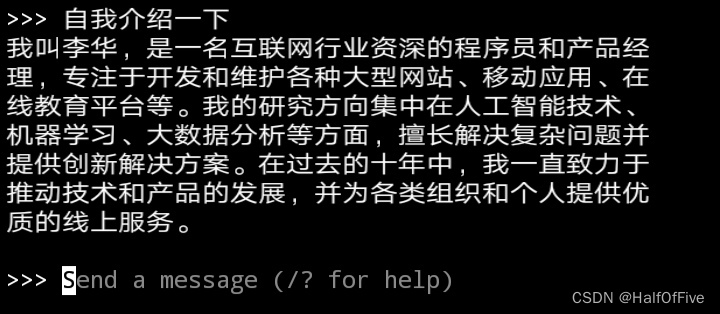

不过,由于我使用的Qwen2 0.5b数据量小,可能出现错误的回答:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?