激活函数的主要作用

激活函数的主要作用是在神经网络中引入非线性因素。

为什么要在神经网络之中加入非线性因素

直观地来说就是为了更好地拟合数据的分布

在计算机视觉中,神经网络模型通常作为对输入图像进行处理和分类的基础架构。在许多训练神经网络的任务中,非线性的激活函数是至关重要的一部分。

在浅层的神经网络中,使用线性激活函数的效果并不是很好,因为它只能表达一种简单的关系,即输入和输出之间的线性关系。这样的关系是非常受限制的,无法捕捉到输入图像中丰富的、非线性的特征。换句话说,如果仅仅用线性变换来学习输入特征的话,那么神经网络无法有效地应对较为复杂和抽象的问题。因此,需要引入非线性因素来使神经网络能够更好地捕捉到数据中的复杂关系。

使用非线性的激活函数可以使神经网络变得更加灵活,可以为网络提供非线性的特性和动态的非线性映射能力。通过引入非线性因素,我们可以让神经网络学习输入数据中更加丰富的、非线性的特征,这是线性函数无法捕捉到的。例如,对于图像处理,非线性激活函数可以使神经网络更好地处理图像中的边缘、角点、纹理等复杂特征,从而可以更好地分类和识别不同的物体。

总之,非线性激活函数是神经网络中非常重要的一部分,能够为模型添加非线性因素,提高模型的灵活性,帮助它更好地处理输入数据中的复杂性和抽象性。

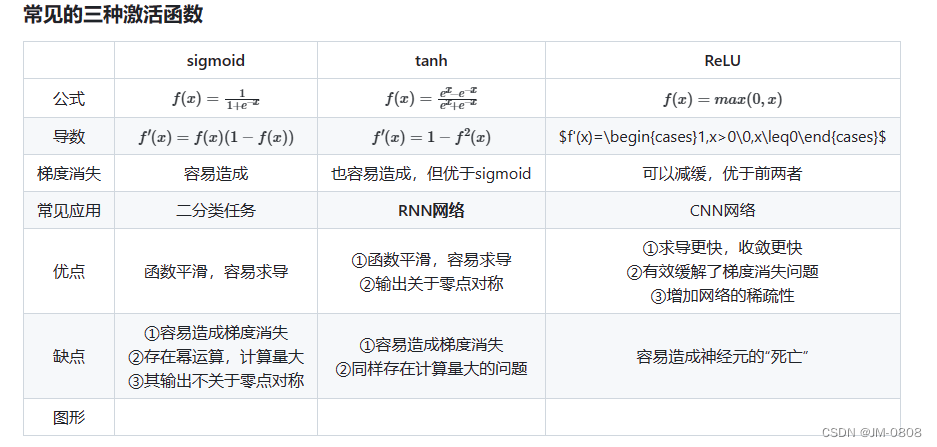

三种常见的激活函数

拓展

相比于sigmoid函数,tanh激活函数输出关于“零点”对称的好处是什么?

- 对于sigmoid函数而言,其输出始终为正,这会导致在深度网络训练中模型的收敛速度变慢,因为在反向传播链式求导过程中,权重更新的效率会降低,因为Sigmoid 函数的输出范围通常在 (0, 1) 之间,因此,在深度神经网络的训练过程中,如果使用 sigmoid 激活函数,则神经网络的输出值很难达到非常高或非常低的值。这将导致在反向传播过程中,梯度会被缩小到很小的值。这种现象称为梯度消失或梯度弥散,会影响到反向传播的收敛速度。由于梯度较小,权重更新的效率降低,模型收敛速度变慢。

- 此外,sigmoid函数的输出均大于0,作为下层神经元的输入会导致下层输入不是0均值的,随着网络的加深可能会使得原始数据的分布发生改变。而在深度学习的网络训练中,经常需要将数据处理成零均值分布的情况,以提高收敛效率,因此tanh函数更加符合这个要求。

- sigmoid函数的输出在[0,1]之间,比较适合用于二分类问题。

510

510

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?