欢迎关注我们的公众号“情迷搜广推”会不时发布搜广推及其他前沿技术讨论

LLM不同程度地影响着各个领域,搜索也不例外。本文整理了10篇较新的LLM应用于搜索改写的文章供大家学习参考。

一、背景

信息检索(Information Retrival,IR)系统已不仅仅局限于网络上的各类搜索引擎,在对话机器人、问答系统、图像搜索系统等场景已有广泛的应用。大模型时代的各种技术方法对现有的文本搜索会产生什么样的影响?

1.1 搜索系统发展现状

搜索系统长期以来的发展可粗略进行以下划分:

- 基于符号的方法:布尔模型、关键字匹配等。高效精准。

- 基于统计语言模型的方法:TF-IDF、BM25等。捕捉术语间细微的语义关系。

- 结合神经网络模型的方法:DNN、Transformers等。支持语义搜索、个性化搜索等。

现在搜索系统仍面临着诸多挑战,比如模糊query、检索效率等。

1.2 LLM的优势

LLM已成为引领各个领域变革的力量,总体来说,LLM的优势主要有下:

- 出色的语义理解和生成能力

- 随着规模的扩大出现涌向能力

- 通过上下文学习适应各种任务

在出色能力的加持下,已有诸多研究已将LLM应用于搜索系统。

二、LLM赋能query理解的改写模块

2.1 什么是改写(Rewrite)?

改写(Rewrite)是指搜索系统根据用户的查询意图和搜索历史等信息,对查询进行改写,以提供更准确、更相关的搜索结果,是搜索系统中的关键模块,对于长尾query的搜索质量提升有非常大的帮助。搜索系统中常见的改写方法可以被分为以下两类:

- 伪相关反馈(Pseudo Relevance Feedback,PRF):将搜索结果中出现频率较高的词语作为新的查询条件,重新执行搜索。PRF易于实现且结果可控,但受第一次搜索结果影响较大,易受噪声影响。

- 生成相关反馈(Generative Relevance Feedback,GRF):通过生成式模型,根据用户query生成文本,提升搜索结果的质量。GRF效果好但实现复杂,且生成结果一定程度上是不可控的。

LLM拥有出色的语义理解及生成能力,因此不管将其应用于PRF还是GRF都有很大的提升空间。下面介绍的研究方法也是围绕这两个方面进行的优化改进。

2.2 让LLM写一个改写结果

最简单直接的思路,让LLM作为生成模型,根据用户的query写一段文本,将其作为改写结果送入后续的检索模块,以提高最终的检索质量。相关研究有下:

- Query2doc:Query2doc: Query Expansion with Large Language Models,微软

- Query Expansion by Prompting Large Language Models,谷歌

- LLMCS:Large Language Models Know Your Contextual Search Intent: A Prompting Framework for Conversational Search,人大

- GRM:GRM: Generative Relevance Modeling Using Relevance-Aware Sample Estimation for Document Retrieval

- Neural text generation for query expansion in information retrieval

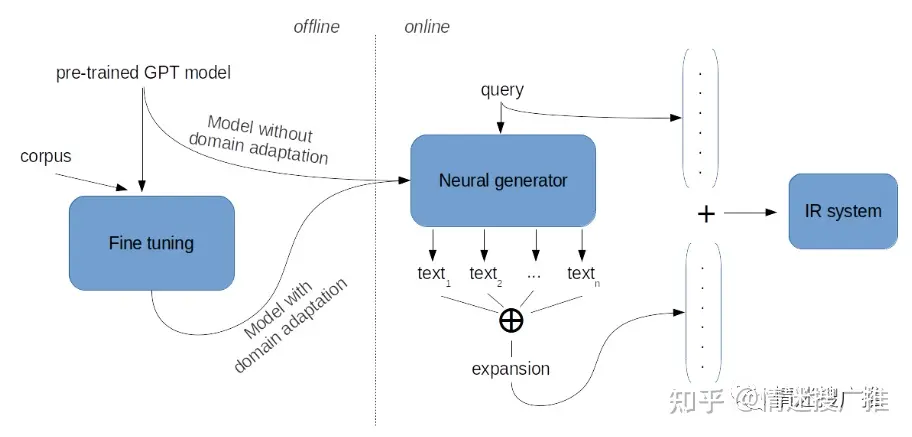

Neural text generation for query expansion in information retrieval

在LLM时代到来之前,就有不少研究利用各种生成式模型来对query进行改写。例如,《Neural text generation for query expansion in information retrieval》一文就利用gpt-2,根据query生成文本作为改写结果。文章整体思路非常简单,但是可以应用在各式各样的搜索系统上,效果也不错。另外,gpt-2模型体量不大,再加上cache等手段的运用,对于搜索系统整体没有什么额外负担。

query2doc

Query Expansion by Prompting Large Language Models

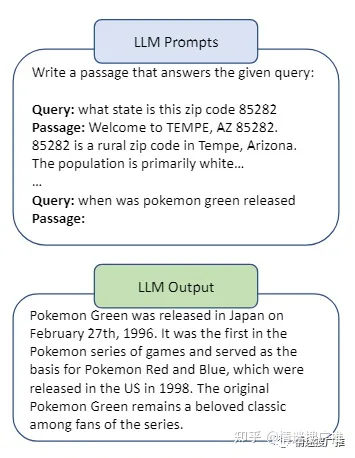

微软的Query2doc方法通过预定的prompt,根据用户的query生成一段文本,用于辅助后续的检索。相比之下,谷歌的研究有两点不同,一是没有利用上下文学习(ICL),二是要求LLM给出其答案的思维链。

LLMCS

上述两个方法可以应用于即席搜索(ad-hoc search)场景,而现代的搜索系统很多支持会话搜索(session search),类似于多轮对话,搜索结果会考虑一个会话中的前几次搜索信息。人大提出的LLMCS是一个支持会话搜索的框架,且针对于会话搜索场景下LLM输入长度增加的问题使用了滑窗方法进行优化。

尽管LLM拥有出色的文本理解和生成能力,不可否认其还是会存在幻觉问题,导致其输出结果背离事实,引入无关噪声影响最终检索结果。针对这一问题,GRM训练了一个神经网络模型,对LLM生成的结果进行相关性打分,最后将得分作为每个生成结果的权重,以减轻无关信息对最终检索结果的影响。

GRM

2.3 综合利用PRF+GRF

以上研究都是利用LLM的生成结果作为改写结果的主要内容,我们可以将其看作是一种生成相关反馈(GRF),而不少研究也同时在模型生成或结果后处理阶段加入伪相关反馈(PRF)的方法来改进改写结果的质量。相关研究有下:

- HyDE:Precise Zero-Shot Dense Retrieval without Relevance Labels,CMU

- LameR:Large Language Models are Strong Zero-Shot Retriever,UTS

- Rewrite-Retrieve-Read:Query Rewriting for Retrieval-Augmented Large Language Models,上交

- PRF+GRF:Generative and Pseudo-Relevant Feedback for Sparse, Dense and Learned Sparse Retrieval

- InteR:Knowledge Refinement via Interaction Between Search Engines and Large Language Models,北大

HyDE

与GRM相同,HyDE针对的主要问题也是LLM可能产生幻觉的问题。HyDE将LLM生成的结果进行编码,利用向量检索器,与真实的文档库中的候选文档进行相关性匹配,然后利用真实的文档作为改写的结果辅助查询。可以看出,该方法实质上就是利用LLM的输出结果而不是query去召回伪文档。相比传统的PRF方法,保证了第一次检索的伪文档的相关性;相比Query2doc等方法,又通过结合PRF避免了LLM可能产生幻觉的问题,保证了结果的高度真实性。类似地,LameR则是将PRF这一过程放到了LLM输入之前。

LameR

从LameR的流程图可以看出,系统首先根据query召回部分相关文档,再将这部分文档形成prompt输入LLM得到输出,作为query的改写结果。这一过程有点类似现在热门的检索增强LLM,只是任务限制在了query改写这一任务上。相关的,Rewrite-Retrieve-Read这一研究则是利用改写去加强检索增强LLM的效果。

Rewrite-Retrieve-Read

Rewrite-Retrieve-Read图中从左到右分别是:检索增强LLM、带有改写器的检索增强LLM、带有强化学习改写器的检索增强LLM。其中Rewrite-Retrieve-Read指的是第三个。可以看出,Rewrite-Retrieve-Read方法不仅利用LLM作为改写器增加了其检索增强的效果,还引入了强化学习,通过最终答案的反馈,来训练高质量LLM改写器。

回到改写任务,HyDE相当于GRF前插了PRF,而LameR相当于PRF前插了GRF,还有研究综合利用了两者来得到改写结果。PRF+GRF直接结合PRF和LLM输出的结果,然后综合加权考虑两者的结果作为改写结果。而InteR则是一种搜索系统和LLM多轮交互框架,通过多次PRF、LLM输出,达到增强两过程效果的目的。

PRF+GRF

InteR

三、小结

至此对LLM赋能搜索改写的几篇论文进行了简单介绍,各类研究都是利用了LLM生成质量较高的特点对已有的搜索系统进行调整优化。以上论文有的出自微软、谷歌等大厂之手,质量有所保障,但仍有部分论文学术性质较强性,落地性未知,但仍提供了宝贵的思路供我们参考借鉴。

感兴趣的可以根据后面参考列表继续进行深入了解。

四、参考文献

- Wang L, Yang N, Wei F. Query2doc: Query Expansion with Large Language Models[J]. arXiv preprint arXiv:2303.07678, 2023.

- Jagerman R, Zhuang H, Qin Z, et al. Query Expansion by Prompting Large Language Models[J]. arXiv preprint arXiv:2305.03653, 2023.

- Mao K, Dou Z, Chen H, et al. Large Language Models Know Your Contextual Search Intent: A Prompting Framework for Conversational Search[J]. arXiv preprint arXiv:2303.06573, 2023.

- Mackie I, Sekulic I, Chatterjee S, et al. GRM: Generative Relevance Modeling Using Relevance-Aware Sample Estimation for Document Retrieval[J]. arXiv preprint arXiv:2306.09938, 2023.

- Vincent Claveau. 2022. Neural text generation for query expansion in information retrieval. In IEEE/WIC/ACM International Conference on Web Intelligence and Intelligent Agent Technology (WI-IAT '21). Association for Computing Machinery, New York, NY, USA, 202–209. https://doi.org/10.1145/3486622.3493957

- Gao L, Ma X, Lin J, et al. Precise zero-shot dense retrieval without relevance labels[J]. arXiv preprint arXiv:2212.10496, 2022.

- Shen T, Long G, Geng X, et al. Large Language Models are Strong Zero-Shot Retriever[J]. arXiv preprint arXiv:2304.14233, 2023.

- Ma X, Gong Y, He P, et al. Query Rewriting for Retrieval-Augmented Large Language Models[J]. arXiv preprint arXiv:2305.14283, 2023.

- Mackie I, Chatterjee S, Dalton J. Generative and Pseudo-Relevant Feedback for Sparse, Dense and Learned Sparse Retrieval[J]. arXiv preprint arXiv:2305.07477, 2023.

- Feng J, Tao C, Geng X, et al. Knowledge Refinement via Interaction Between Search Engines and Large Language Models[J]. arXiv preprint arXiv:2305.07402, 2023.

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?