第5章 Linux网络编程基础API

从以下3方面讨论Linux网络API:

-

1.socket地址API。socket最开始的含义是一个IP地址和端口对(ip,port),它唯一表示了使用TCP通信的一端,本书称其为socket地址。

-

2.socket基础API。socket的主要API都定义在sys/socket.h头文件中,包括创建socket、命名socket、监听socket、接受连接、发起连接、读写数据、获取地址信息、检测带外标记、读取和设置socket选项。

-

3.网络信息API。Linux提供了一套网络信息API,以实现主机名和IP地址之间的转换,以及服务名和端口号之间的转换,这些API都定义在netdb.h头文件中。

5.1 socket地址API

先理解主机字节序和网络字节序

5.1.1 主机字节序和网络字节序

现代CPU的累加器一次能装载至少4字节(32位机),即一个整型数。这4个字节在内存中排列的顺序将影响它被累加器装载成的整数的值,这就是字节序问题。

字节序分为大端字节序(big endian)和小端字节序(little endian)。

在大端字节序中,高位字节(Most Significant Byte,MSB)被存储在较低的内存地址,而低位字节(Least Significant Byte,LSB)被存储在较高的内存地址。在小端字节序中,高位字节(MSB)被存储在较高的内存地址,而低位字节(LSB)被存储在较低的内存地址。这就好像把多字节数据当作一个整数,低位字节在前,高位字节在后。

假设有一个32位整数0x12345678,

它以大端字节序存储在内存中如下:

地址: 0x1000 0x1001 0x1002 0x1003

数据: 0x12 0x34 0x56 0x78

以小端字节序存储在内存中如下:

地址: 0x1000 0x1001 0x1002 0x1003

数据: 0x78 0x56 0x34 0x12

以下代码用于检查机器的字节序:

#include <stdio.h>

void byteorder()

{

union

{

short value;

char union_bytes[sizeof(short)];

} test;

test.value = 0x0102;

if ((test.union_bytes[0] == 1) && (test.union_bytes[1] == 2))

{

printf("big endian\n");

}

else if ((test.union_bytes[0] == 2) && (test.union_bytes[1] == 1))

{

printf("little endian\n");

}

else

{

printf("unknown...\n");

}

}

int main()

{

byteorder();

return 0;

}

现代PC大多采用小端字节序,因此小端字节序又被称为主机字节序。

当格式化的数据(如32 bit整型数和16 bit短整型数)在两台使用不同主机序的主机之间直接传递时,接收端会错误解释它。解决问题的方法是发送端总是把要发送的数据转化成大端字节序数据后再发送,而接收端知道对方传送过来的数据总是大端字节序,所以接收端可以根据自身采用的字节序决定是否对接收到的数据进行转换(小端机转换,大端机不转换)。因此大端字节序也称为网络字节序。

Linux提供了以下4个函数完成主机字节序和网络字节序之间的转换:

// h: host; n: network; l: long; s: short

// long: 往往用来转换 IP; short: 往往用来转换 port

#include <netinet/in.h>

unsigned long int htonl(unsigned long int hostlong);// host to network long,将长整型(32bit)的主机字节序数据转化为网络字节序数据

unsigned short int htons(unsigned short int hostshort);

unsigned long int ntohl(unsigned long int netlong);

unsigned short int ntohs(unsigned short int netshort);

5.1.2 通用socket地址

用sockaddr 结构体表示 socket 地址

#include <bits/socket.h> // <sys/scoket.h>

struct sockaddr {

sa_family_t sa_family; // 常见的地址簇有: AF_UNIX/AF_INET/AF_INET6

char sa_data[14]; // 存放 socket 地址值,不同的地址簇地址值长度不同

}

sa_family成员是地址族类型(sa_family_t)的变量,地址族通常与协议族类型对应。

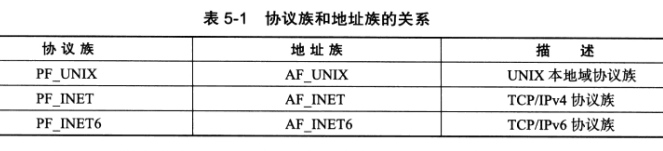

常见的协议族(protocol family,也称domain)和对应的地址族见下表:

宏PF_*和AF_*都定义在bits/socket.h头文件中,且后者与前者有完全相同的值,因此二者通常混用。

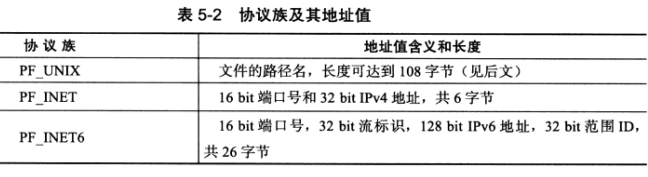

sa_data成员用于存放socket地址值,但不同的协议族的地址有不同的含义和长度:

由上表可见,14字节的sa_data成员无法容纳多数协议族的地址值,因此Linux定义了下面这个新的通用socket地址结构:

#include <bits/socket.h>

struct sockaddr_storage {

sa_family_t sa_family;

unsigned long int __ss_align;

char __ss_padding[128-sizeof(__ss_align)];

}

sockaddr_storage结构体提供了足够大的空间用于存放地址值,而且是内存对齐的(这就是__ss_align成员的作用)。

5.1.3 专用socket地址

通用socket地址结构体显然不好用,比如设置和获取IP地址和端口号需要执行繁琐的位操作,所以Linux为各个协议族提供了专门的socket地址结构。

UNIX本地域协议族使用以下专用socket地址结构:

#include<sys/un.h>

struct sockaddr_un{

sa_family_t sin_family; //地址簇:AF_UNIX

char sun_path[108]; //文件路径名

};

TCP/IP协议族有sockaddr_in(IPv4)和sockaddr_in6(IPv6)两个专用socket地址结构:

struct in_addr{

u_int32_t s_addr;//IPv4地址,用网络字节序

};

struct sockaddr_in{

sa_family_t sin_family; //地址簇:AF_INET

u_int16_t sin_port; //端口号:要用网络字节序表示

struct in_addr sin_addr; //IPv4地址结构体

};

struct in6_addr{

unsigned char sa_addr[16]; //IPv6地址,要用网络字节序表示

};

struct sockaddr_in6{

sa_family_t sin6_family; //地址簇:AF_INET6

u_int16_t sin6_port; //端口号:要用网络字节序表示

u_int32_t sin6_flowinfo; //流信息,应设置为0

struct in6_addr sin6_addr; //IPv6地址结构体

u_int32_t sin6_scope_id;//scope ID,尚处于实验阶段

};

所有socket地址(包括sockaddr_storage)类型的变量在传给socket编程接口时都需要强制转换为sockaddr类型,因为所有socket编程接口使用的地址参数的类型都是sockaddr。

5.1.4 IP地址转换函数

Linux 提供三个「点分十进制字符串表示的 IPv4 地址和用网络字节序整数表示的 IPv4 地址之间转换」的接口

#include <arpa/inet.h>

in_addr_t inet_addr(const char* strptr); // 点分十进制字符串表示的 IPv4 地址转为网络字节序整数表示,失败返回 INADDR_NONE

int inet_aton(const char* cp, struct in_addr* inp); // 功能与inet_addr相同,但它将转换的结果存储于参数inp指向的地址结构中,失败返回 0,成功返回 1

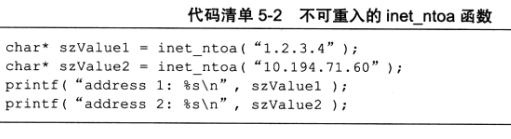

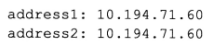

char* inet_ntoa(struct in_addr in); // 逆向转换,注意该函数内部用一个静态变量存储转换结果,函数的返回值指向该静态内存,是不可重入

更适用与 IPv4/IPv6 的函数为:

#include <arpa/inet.h>

int inet_pton(int af, const char* src, void* dst); // af 是地址簇,可以是AF_INET或AF_INET6;src参数是字符串表示的IP地址(点分十进制表示的IPv4地址或十六进制字符串表示的IPv6地址);dst参数用于存储转换后的二进制格式地址;该函数成功时返回1,失败返回0并设置errno

// 逆向转换,cnt 可以为 #define INET_ADDRSTRLEN 16 or #define INET6_ADDRSTRLEN 46

const char* inet_ntop(int af, const void* src, char* dst, socklen_t cnt); // cnt指定dst参数指针指向的地址的长度,成功时返回目标存储单元的地址,失败返回 NULL

5.2 创建socket

UNIX/Linux的一个哲学是:所有东西都是文件。socket也不例外,它就是可读、可写、可控制、可关闭的描述符。

#include <sys/types.h>

#include <sys/socket.h>

// domain: 协议簇,包括 PF_INET、PF_INET6、PF_UNIX

// type: 服务类型,包括 SOCK_STREAM(TCP流服务)、SOCK_DGRAM(UDP数据报服务)

// protocol: 前两个参数已经决定了协议,一般设置为 0 即可

int socket(int domain, int type, int protocol); // 成功时返回一个socket文件描述符,失败返回 -1

Linux内核版本自2.6.17起,type参数可以是服务类型和SOCK_NONBLOCK(将新建的socket设为非阻塞的)、SOCK_CLOEXEC(调用exec时关闭该描述符)标志相与的值,在此版本前,文件描述符的这两个属性需要使用额外的系统调用(如fcntl还是)来设置。

5.3 命名socket

创建socket时,我们指定了地址族,但未指定使用该地址族中哪个具体socket地址,将一个socket与socket地址绑定称为给socket命名。

在服务器程序中,我们通常要命名socket,因为只有命名后客户端才能知道如何连接它。客户端则通常不需要命名socket,而是采用匿名方式,即使用操作系统自动分配的socket地址。

命名socket的系统调用是bind

#include <sys/types.h>

#include <sys/socket.h>

// 将 my_addr 所指的 socket 地址分配给 未命名的 sockfd 文件描述符,addrlen参数指出该socket地址的长度

int bind(int sockfd, const struct sockaddr* my_addr, socklen_t addrlen); // 失败返回 -1

bind函数成功时返回0,失败返回-1并设置errno,其中常见的errno:

- 1.EACCES:被绑定的地址是受保护的地址,仅超级用户能访问,普通用户将socket绑定到端口0~1023上时,bind函数将返回EACCES错误。

- 2.EADDRINUSE:被绑定的地址正在使用中,比如将socket绑定到一个处于TIME_WAIT状态的socket地址。

5.4 监听socket

socket被命名后,还不能接受客户连接,我们需要系统调用创建一个监听队列以存放待处理的客户连接

#include <sys/socket.h>

// sockfd参数指定被监听的socket。

// backlog 是内核监听队列的最大长度,表示服务端完全连接状态 ESTABLISHED 数量的上限(backlog+1)

// Mac 环境中测试是监听上限就是 backlog

int listen(int sockfd, int backlog); // 失败返回 -1,成功返回 0

编写一个服务器程序,研究backlog参数对listen系统调用的实际影响:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <signal.h>

#include <unistd.h>

#include <stdlib.h>

#include <assert.h>

#include <stdio.h>

#include <string.h>

#include <libgen.h>

static bool stop = false;

// SIGTERM信号的处理函数,用于结束main中的循环

static void handle_term(int sig)

{

stop = true;

}

int main(int argc, char *argv[])

{

signal(SIGTERM, handle_term);

if (argc <= 3)

{

printf("usage: %s ip_address port_number backlog\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

int backlog = atoi(argv[3]);//atoi将字符串转换为整数

int sock = socket(PF_INET, SOCK_STREAM, 0);//创建socket

assert(sock >= 0);

struct sockaddr_in address;

bzero(&address, sizeof(address));//将address所指的内存区域前sizeof(address)个字节全部设为零

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);//点分十进制表示的转换为二进制格式

address.sin_port = htons(port);//将主机的字节顺序转换为网络字节顺序

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));//命名socket

assert(ret != -1);

ret = listen(sock, backlog);//监听socket

assert(ret != -1);

while (!stop)

{

sleep(1);

}

close(sock);

return 0;

}

5.5 接受连接

系统调用从监听队列中接受一个连接:

#include <sys/types.h>

#include <sys/socket.h>

// sockfd 是执行过 listen 系统调用的监听 socket,处于 LISTEN 状态

// addr 用来获取被接受连接的远端 socket 地址

int accept(int sockfd, struct sockaddr* addr, socklen_t *addrlen);

accept 成功调用会返回一个新的连接 socket(处于 ESTABLISHED 状态),该套接字唯一标识这个被接受的连接,服务器可以通过读写该 socket 来与客户端通信

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

// 暂停 20 秒等待客户端连接和相关操作(掉线或者退出)完成

sleep(20);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);//接受连接

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

// 不管客户端是掉线还是退出,服务端分别对应 ESTABLISHED 和 CLOSE_WAIT 状态

// accept 都会从监听队列中取出连接,也就是它不会关心任何网络状况变化

char remote[INET_ADDRSTRLEN];

printf("connected with ip: %s and port: %d\n",

inet_ntop(AF_INET, &client.sin_addr, remote, INET_ADDRSTRLEN), ntohs(client.sin_port));

close(connfd);

}

close(sock);

return 0;

}

5.6 发起连接

服务端是通过 listen 被动接受连接,客户端就需要通过 connect 系统调用主动发起与服务端的连接:

#include <sys/types.h>

#include <sys/socket.h>

// sockfd 是客户端自己创建的套接字

// serv_addr 是服务器监听的 socket 地址

int connect(int sockfd, const struct sockaddr* serv_addr, socklen_t addrlen);

成功调用返回 0,客户端的 sockfd 就唯一标识这个连接,客户端就可以通过读写 sockfd 来与服务器通信

失败时返回-1并设置errno,两种常见的errno:

- 1.ECONNREFUSED:目标端口不存在,连接被拒绝。

- 2.ETIMEDOUT:连接超时。

5.7 关闭连接

关闭一个连接实际上就是关闭该连接对应的socket,这可通过以下关闭普通文件描述符的系统调用来完成:

#include <unistd.h>

int close(int fd);

fd参数是待关闭的socket,但close系统调用并不总是立即关闭一个连接,而是将fd参数的引用计数减1,只有当fd参数的引用计数为0时,才真正关闭连接。

多进程程序中,一次fork系统调用使父进程中打开的socket的引用计数加1,因此我们必须在父进程和子进程中都对该socket执行close函数才能将连接关闭。

如果要立即终止连接,而不是将socket的引用计数减1,可用以下shutdown系统调用(相比close函数,它是专门为网络编程设计的):

#include <sys/socket.h>

// howto: 关闭读 SHUT_RD、关闭写 SHUT_WR、关闭读写 SHUT_RDWR

int shutdown(int sockfd, int howto); // 成功返回 0,失败 -1

5.8 数据读写

5.8.1 TCP数据读写

socket编程接口提供了专门用于socket数据读写的系统调用,它们增加了对数据读写的控制,以下系统调用用于TCP流数据读写:

#include <sys/types.h>

#include <sys/socket.h>

// buf 和 len 分别是读缓冲区的位置和大小,flags 一般为 0

// recv 成功时返回实际读取的数据长度,可能小于 len,因此我们可能要多次调用recv才能读到完整的数据

// 返回 0 表示对方已经关闭连接,-1 表示出错

ssize_t recv(int sockfd, void *buf, size_t len, int flags);

// send 成功时返回实际写入的数据长度,失败时返回 -1

ssize_t send(int sockfd, const void *buf, size_t len, int flags);

以下代码演示MSG_OOB选项的使用,它给程序提供了发送和接收带外数据的方法,以下是发送程序:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <string.h>

#include <stdlib.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in server_address;

bzero(&server_address, sizeof(server_address));

server_address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &server_address.sin_addr);

server_address.sin_port = htons(port);

int sockfd = socket(PF_INET, SOCK_STREAM, 0);

assert(sockfd >= 0);

// 客户端

if (connect(sockfd, (struct sockaddr *)&server_address, sizeof(server_address)) < 0)//发起连接

{

printf("connection failed\n");

}

else

{

printf("send oob data out\n");

const char *oob_data = "abc";

const char *normal_data = "123";

send(sockfd, normal_data, strlen(normal_data), 0);

send(sockfd, oob_data, strlen(oob_data), MSG_OOB);

send(sockfd, normal_data, strlen(normal_data), 0);

}

close(sockfd);

return 0;

}

以下是带外数据的接收程序:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <libgen.h>

#define BUF_SIZE 1024

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

// 服务端

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

char buffer[BUF_SIZE];

memset(buffer, '\0', BUF_SIZE);

ret = recv(connfd, buffer, BUF_SIZE - 1, 0);

printf("got %d bytes of normal data '%s'\n", ret, buffer);

memset(buffer, '\0', BUF_SIZE);

ret = recv(connfd, buffer, BUF_SIZE - 1, MSG_OOB);

printf("got %d bytes of oob data '%s'\n", ret, buffer);

memset(buffer, '\0', BUF_SIZE);

ret = recv(connfd, buffer, BUF_SIZE - 1, 0);

printf("got %d bytes of normal data '%s'\n", ret, buffer);

close(connfd);

}

close(sock);

return 0;

}

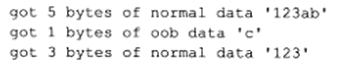

服务器程序的输出如下:

由上图,客户的以MSG_OOB调用的send中,要输出的字符有3个(abc),仅有最有1个字符被服务器当成真正的带外数据接收。

服务器对正常数据的接收被带外数据截断,即前一部分正常数据123ab和后续的正常数据123是不能被一个recv调用全部读出的。

5.8.2 UDP数据读写

socket编程接口中用于UDP数据报读写的系统调用是:

#include <sys/types.h>

#include <sys/socket.h>

// 和 recv 不同的是需要指定发送端的 socket 地址,因为 UDP 没有连接的概念

ssize_t recvfrom(int sockfd, void *buf, size_t len, int flags, struct sockaddr* src_addr, socklen_t* addrlen);

// 指定接收端的 socket 地址

ssize_t sendto(int sockfd, const void *buf, size_t len, int flags, struct sockaddr* dest_addr, socklen_t* addrlen);

5.8.3 通用数据读写函数

socket编程接口还提供了一对通用的数据读写系统调用,它们不仅能用于TCP流数据,也能用于UDP数据报:

#include <sys/socket.h>

ssize_t recvmsg(int sockfd, struct msghdr* msg, int flags);

sszie_t sendmsg(int sockfd, struct msghdr* msg, int flags);

msghdr 结构体为:

struct msghdr {

void* msg_name; // socket 地址

socklen_t msg_namelen; // 地址长度

struct iovec* msg_iov; // 存放数据:分散读、集中写

int msg_iovlen; // iovec 结构体个数

void* msg_control;

socklen_t msg_controllen;

int msg_flags; // 复制函数中 flags 参数,调用过程中更新

};

其中iovec结构类型指针:

struct iovec{

void* iov_base;// 内存起始地址

size_t iov_len;// 这块内存长度

};

5.9 带外标记

在实际应用中,我们通常无法预期带外数据何时到来,好在Linux内核检测到TCP紧急标志时,将通知应用进程有带外数据需要接收。

内核通知应用进程带外数据到达的常见方式是:IO复用产生异常事件和SIGURG信号。即使应用进程得到了有带外数据需要接收的通知,还需要知道带外数据在数据流中的具体位置,才能准确接收带外数据,这一点可通过以下系统调用实现:

#include <sys/socket.h>

// 判断 sockfd 是否处于带外标记,即下一个被读到的数据是否是带外数据

// 如果是返回 1,此时就可以设置 flags 为 MSG_OOB 标志的 recv 调用来接受带外数据;否则返回 0

int sockatmark(int socket);

5.10 地址信息函数

有时想知道一个socket的本端socket地址,以及远端的socket地址,以下函数用于解决这个问题:

#include <sys/socket.h>

// 获取 sockfd 对应的本端 socket 地址,存在 addr 中

int getsockname(int sockfd, struct sockaddr* addr, socklen_t* addlen); // 成功返回 0,失败 -1

// 获取 sockfd 对应的远端 socket 地址,存在 addr 中

int getpeername(int sockfd, struct sockaddr* addr, socklen_t* addlen); // 成功返回 0,失败 -1

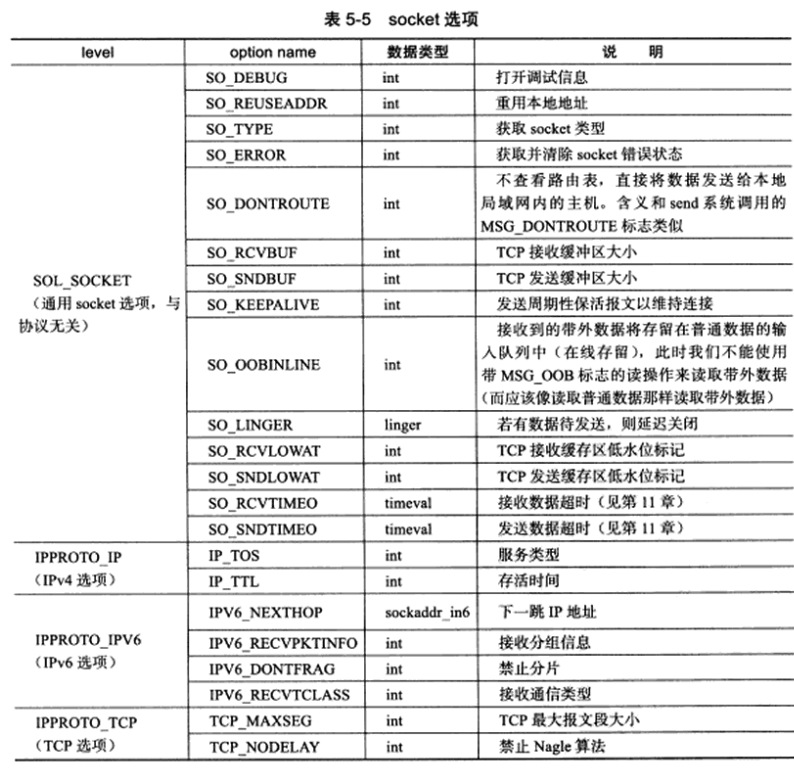

5.11 socket选项

下面两个系统调用是专门用来读取和设置socket文件描述符属性的方法:

#include <sys/socket.h>

// level: 指定哪个协议,包括 SOL_SOCKET、IPPROTO_IP、IPPROTO_IPV6、IPPROTO_TCP

// option_name: 指定选项名称

// option_value 和 option_len 分别是选项的值和长度

int getsockopt(int sockfd, int level, int option_name, void* option_value,

socketlen_t* restrict option_len); // 成功返回 0,失败 -1

int setsockopt(int sockfd, int level, int option_name, const void* option_value,

socketlen_t option_len); // 成功返回 0,失败 -1

下表中是常用的socket选项:

5.11.1 SO_REUSEADDR选项

强制使用被处于 TIME_WAIT 状态的连接占用的 socket 地址

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

// 通过 setsockopt 设置可以让处于 TIME_WAIT 状态的 socket 被重新使用

int reuse = 1;

setsockopt(sock, SOL_SOCKET, SO_REUSEADDR, &reuse, sizeof(reuse));

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

// 服务端

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

char remote[INET_ADDRSTRLEN];

printf("connected with ip: %s and port: %d\n",

inet_ntop(AF_INET, &client.sin_addr, remote, INET_ADDRSTRLEN), ntohs(client.sin_port));

close(connfd);

}

close(sock);

return 0;

}

我们也可通过修改内核参数/proc/sys/net/ipv4/tcp_tw_recycle来快速回收被关闭的socket,从而使TCP连接根本不进入TIME_WAIT状态,进而允许应用进程立即重用本地socket地址。

5.11.2 SO_RCVBUF和SO_SNDBUF选项

SO_RCVBUF和SO_SNDBUF选项分别表示TCP接收缓冲区和发送缓冲区的大小

当我们用setsockopt回收来设置TCP的接收缓冲区和发送缓冲区的大小时,内核会将此值加倍,接收缓冲区加倍后的最小值为256字节,发送缓冲区加倍后的最小值为2048字节,但不同系统可能有不同最小值,如果加倍后的值还小于最小值,则将其设为最小值。最小值限制的目的主要是确保一个TCP连接拥有足够的空闲缓冲区来处理拥塞(如快速重传算法就期望TCP接收缓冲区至少容纳4个大小为MSS的TCP报文段)。

可以修改内核参数/proc/sys/net/ipv4/tcp_rmem和/proc/sys/net/ipv4/tcp_wmem来强制TCP接收缓冲区和发送缓冲区的大小没有最小值限制。

以下是修改发送缓冲区大小的客户端程序:

#include <sys/socket.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <string.h>

#include <stdlib.h>

#include <libgen.h>

#define BUFFER_SIZE 512

int main(int argc, char *argv[])

{

if (argc <= 3)

{

printf("usage: %s ip_address port_number send_bufer_size\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in server_address;

bzero(&server_address, sizeof(server_address));

server_address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &server_address.sin_addr);

server_address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int sendbuf = atoi(argv[3]);

int len = sizeof(sendbuf);

// 客户端:先设置 TCP 发送缓冲区的大小,然后立即读取它

setsockopt(sock, SOL_SOCKET, SO_SNDBUF, &sendbuf, sizeof(sendbuf));

getsockopt(sock, SOL_SOCKET, SO_SNDBUF, &sendbuf, (socklen_t *)&len);

printf("the tcp send buffer size after setting is %d\n", sendbuf);

if (connect(sock, (struct sockaddr *)&server_address, sizeof(server_address)) != -1)

{

char buffer[BUFFER_SIZE];

memset(buffer, 'a', BUFFER_SIZE);

send(sock, buffer, BUFFER_SIZE, 0);

}

close(sock);

return 0;

}

以下是修改接收缓冲区的服务器程序:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <libgen.h>

#define BUFFER_SIZE 1024

int main(int argc, char *argv[])

{

if (argc <= 3)

{

printf("usage: %s ip_address port_number receive_buffer_size\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int recvbuf = atoi(argv[3]);

int len = sizeof(recvbuf);

// 服务端:先设置 TCP 接收缓冲区的大小,然后立即读取它

// 不同系统最小的接受缓冲区大小不同

setsockopt(sock, SOL_SOCKET, SO_RCVBUF, &recvbuf, sizeof(recvbuf));

getsockopt(sock, SOL_SOCKET, SO_RCVBUF, &recvbuf, (socklen_t *)&len);

printf("the receive buffer size after settting is %d\n", recvbuf);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

char buffer[BUFFER_SIZE];

memset(buffer, '\0', BUFFER_SIZE);

while (recv(connfd, buffer, BUFFER_SIZE - 1, 0) > 0)

{

}

close(connfd);

}

close(sock);

return 0;

}

5.11.3 SO_RCVLOWAT 和 SO_SNDLOWAT选项

SO_RCVLOWAT和SO_SNDLOWAT套接字选项分别表示TCP接收缓冲区和发送缓冲区的低水位标记,它们一般被IO复用系统调用用来判断socket是否可读或可写。

当TCP接收缓冲区中可读数据的总数大于其低水位标记时,IO复用系统调用将通知应用进程可以从对应的socket上读取数据;当TCP发送缓冲区中的空闲空间(可以写入数据的空间)大于其低水位标记时,IO复用系统调用将通知应用进程可以向对应的socket上写入数据。

默认,TCP接收缓冲区和发送缓冲区的低水位标记均为1。

5.11.4 SO_LINGER选项

SO_LINGER选项用于控制close系统调用在关闭TCP连接时的行为。

默认,当使用close系统调用关闭一个socket时,close函数将立即返回,TCP模块随后负责把该socket对应的TCP发送缓冲区中残留的数据发送给对方。

SO_LINGER选项对应的值的类型是linger:

#include <sys/socket.h>

struct linger{

int l_onoff;// 开启(非0)还是关闭(0)

int l_linger;// 滞留时间

};

根据linger结构体中两个成员的不同取值,close系统调用可能产生以下3种行为之一:

- 1.l_onoff为0。此时SO_LINGER选项不起作用,close函数用默认行为来关闭socket。

- 2.l_onoff不为0,l_linger为0。此时close系统调用立即返回,TCP模块将丢弃被关闭的socket对应的TCP发送缓冲区中残留的数据,同时给对方发送一个RST报文段。这种情况给服务器提供了一种异常终止一个连接的方法。

- 3.l_onoff不为0,l_linger大于0。此时close函数的行为取决于两个条件:一是被关闭的socket对应的TCP发送缓冲区中是否还有残留的数据;二是该socket是阻塞的还是非阻塞的。对于阻塞的socket,close函数将等待长为l_linger成员的时间,直到TCP模块发送完所有残留数据并得到对方的确认,如果这段时间内TCP模块没有发送完残留数据并得到对方确认,那么close函数将返回-1并设置errno为EWOULDBLOCK。如果socket是非阻塞的,close函数将立即返回,此时我们需要根据其返回值和errno来判断数据是否已经发送完毕。

5.12 网络信息API

socket两个要素,即IP地址和端口号都是数值表示的,不便于记忆,也不便于扩展(如从IPv4转移到IPv6),因此前面我们用主机名访问一台机器,而避免直接使用其IP地址。同样,我们也可用服务名代替端口号。

5.12.1 gethostbyname和gethostbyaddr

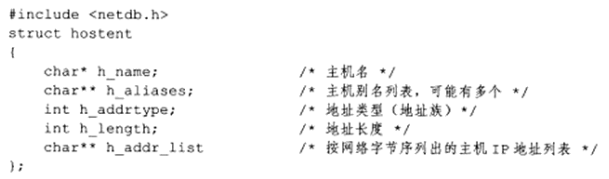

gethostbyname函数根据主机名获取主机的完整信息,gethostbyaddr函数根据IP地址获取主机的完整信息。

#include <netdb.h>

// 根据主机名称获取主机的完整信息

struct hostent* gethostbyname(const char* name);

// 根据 IP 地址获取主机的完整信息

struct hostent* gethostbyaddr(const void* addr, size_t len, int type);

以上两个函数返回的都是hostent类型的指针:

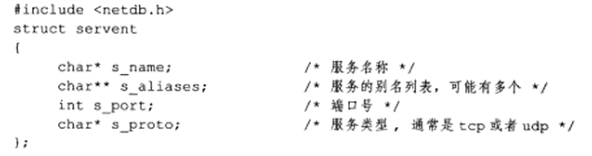

5.12.2 getservbyname和getservbyport

getservbyname函数根据名称获取某个服务的完整信息。getservbyport函数根据端口号获取某个服务的完整信息,它们实际上都是通过读取/etc/services文件来获取服务的信息。

#include <netdb.h>

// name参数指定目标服务的名字,port参数指定目标服务对应的端口号。proto参数指定服务类型,可传tcp和udp,也可传NULL表示获取所有类型的服务。

struct servent* getservbyname(const char* name, const char* proto);

struct servent* getservbyport(int port, const char* proto);

以上两个函数返回的都是servent类型的指针:

通过主机名和服务名访问目标机器上的daytime服务,以获取该机器的系统时间:

#include <sys/socket.h>

#include <netinet/in.h>

#include <netdb.h>

#include <stdio.h>

#include <unistd.h>

#include <assert.h>

int main(int argc, char *argv[])

{

assert(argc == 2);

char *host = argv[1];

// 获取目标主机地址信息

struct hostent *hostinfo = gethostbyname(host);

assert(hostinfo);

// 获取 daytime 服务信息

struct servent *servinfo = getservbyname("daytime", "tcp");

assert(servinfo);

printf("daytime port is %d\n", ntohs(servinfo->s_port));

struct sockaddr_in address;

address.sin_family = AF_INET;

address.sin_port = servinfo->s_port;

// 注意这里由于 h_addr_list 已经是网络字节序了

address.sin_addr = *(struct in_addr *)*hostinfo->h_addr_list;

int sockfd = socket(AF_INET, SOCK_STREAM, 0);

int result = connect(sockfd, (struct sockaddr *)&address, sizeof(address));

assert(result != -1);

char buffer[128];

result = read(sockfd, buffer, sizeof(buffer));

assert(result > 0);

buffer[result] = '\0';

printf("the day tiem is: %s", buffer);

close(sockfd);

return 0;

}

5.12.3 getaddrinfo

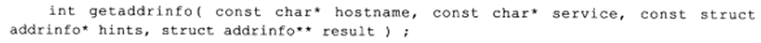

getaddrinfo函数既能通过主机名获得IP地址,也能通过服务名获得端口号,它是可重入函数.

getaddrinfo函数返回的每条结果都是一个addrinfo结构对象:

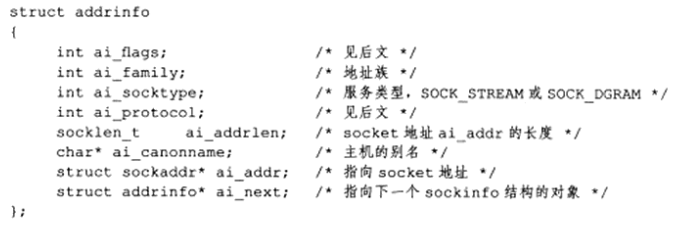

ai_protocol成员指具体的网络协议,其含义与socket系统调用的通常被设为0的第3个参数相同。ai_flags参数可以是下表中标志的按位或:

当使用hints参数时,我们可以设置其ai_flags、ai_family、ai_socktype、ai_protocol字段,其他字段必须设为NULL,例如,下例使用hints参数获取主机ernest-laptop上的daytime流服务信息:

struct addrinfo hints;

struct addrinfo *res;

bzero(&hints, sizeof(hints));

hints.ai_socktype = SOCK_STREAM;

getaddrinfo("ernest-laptop", "daytime", &hints, &res);

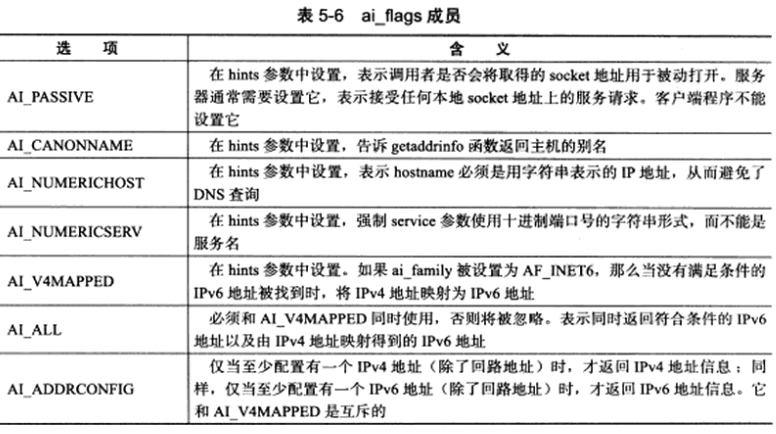

getaddrinfo函数会隐式分配堆内存,因为res指针原本没有指向一块合法内存,所以用完这块内存后,我们需要使用以下函数释放这块内存:

5.12.4 getnameinfo

getnameinfo函数能通过socket地址结构同时获取以字符串表示的主机名和服务名

getnameinfo函数将返回的主机名存储在host参数指向的缓存中,将服务名存储在serv参数指向的缓冲中,hostlen和servlen参数分别指定这两块缓存的长度。

flags参数控制getnameinfo函数的行为,它可以是以下标志的逻辑或:

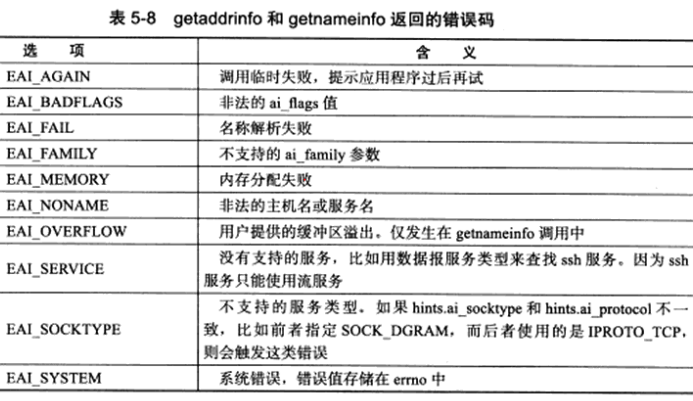

getaddrinfo和getnameinfo函数成功时返回0,失败则返回错误码,可能的错误码见下表:

Linux下strerror函数能将数值错误码errno转换成易读的字符串形式

第6章 高级I/O函数

Linux 提供很多高级 IO 函数,没有 read/open 等基础的常用,但是特定地方使用性能较高,一般有三类

- 创建文件描述符的函数:pipe、dup/dup2

- 读写数据的函数:包括 readv/writev、sendfile、mmap/munmap、splice、tee 等

- 控制 IO 行为和属性的函数:fcntl

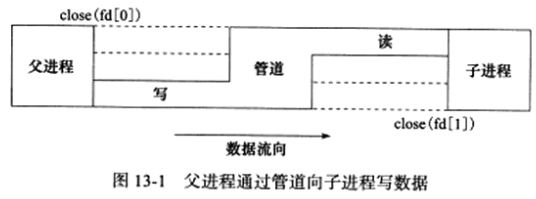

6.1 pipe函数

pipe函数用于创建一个管道,以实现进程间通信:

fd参数是一个包含两个int的数组。该函数成功时返回0,并将一对打开的文件描述符填入其参数指向的数组,如果失败,则返回-1并设置errno。

#include <unistd.h>

// 往 fd[1] 写入的数据可以从 fd[0] 读出,不能反过来

int pipe(int fd[2]); // 成功返回 0,并将一对打开的文件描述符填入其参数指向的数组

pipe函数创建的这两个文件描述符fd[0]和fd[1]分别构成管道的两端,往fd[1]写入的数据可以从fd[0]读出。

fd[0]只能用于从管道读出数据,fd[1]只能用于往管道写入数据,不能反过来使用。

如果要实现双向的数据传输,就应该使用两个管道。默认,这一对文件描述符都是阻塞的。

如果用read系统调用读取一个空管道,则read函数将被阻塞,直到管道内有数据可读;如果我们用write系统调用往一个满的管道中写入数据,则write函数也被阻塞,直到管道有足够的空闲空间可用。

如果管道写端文件描述符fd[1]的引用计数减少到0,即没有任何进程需要往管道中写入数据,则针对该管道的读端文件描述符fd[0]的read操作将返回0,即读取到文件结束标记(EOF,End Of File);反之,如果管道的读端文件描述符fd[0]的引用计数减少至0,即没有任何进程需要从管道读取数据,则针对该管道的写端文件描述符fd[1]的write操作将失败,并引发SIGPIPE信号。

管道内部传输的数据是字节流,管道本身拥有一个容量限制,它规定如果应用进程不将数据从管道读走,该管道最多能被写入多少字节数据。自Linux 2.6.11内核起,管道容量的大小默认是65535字节,我们可用fcntl函数修改管道容量。

socket的基础API中有一个socketpair函数,它能创建双向管道:

#include <sys/types.h>

#include <sys/socket.h>

int socketpair(int domain, int type, int protocol, int fd[2]);

domain参数只能使用UNIX本地域协议族AF_UNIX,因为我们仅能在本地使用这个双向管道。fd参数和pipe系统调用的参数一样,但socketpair函数创建的这对文件描述符都是既可读又可写的。socketpair函数成功时返回0,失败时返回-1并设置errno。

6.2 dup函数和dup2函数

有时我们希望把标准输入重定向到一个文件,或者把标准输出重定向到一个网络连接,这可通过以下用于复制文件描述符的dup或dup2函数来实现:

dup函数创建一个新文件描述符,该新文件描述符和原有文件描述符file_descriptor参数指向相同的文件、管道、网络连接,且dup函数返回的文件描述符总是取系统当前可用的最小整数值。

dup2和dup函数类似,但它将新文件描述符设置为file_descriptor_two参数,返回的第一个不小于file_descriptor_two的整数值。

dup和dup2系统调用失败时返回-1并设置errno。

以下程序使用dup函数实现了一个基本的CGI服务器:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]); //表示 ascii to integer

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);//将点分文本的IP地址转换为二进制网络字节序的IP地址

address.sin_port = htons(port);//将整型变量从主机字节顺序转变成网络字节顺序

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

close(STDOUT_FILENO); // 关闭标准输出

dup(connfd); // connfd 指向 1(标准输出)

printf("abcd\n");

close(connfd);

}

close(sock);

return 0;

}

与客户端通信的 socket 记为 connfd,先关闭标准输出 STDOUT_FILENO (其值为1),然后调用 dup(connfd) 返回 1,这样标准输出就和 connfd 指向同样的文件,也就是 printf 的数据直接写入管道(不会出现在终端上),发送给客户端,这就是 Comman Gateway Interface(CGI)服务器的基本工作原理

6.3 readv函数和writev 函数

readv函数将数据从文件描述符读到分散的内存块中,即分散读;writev函数将多块分散的内存数据一并写入文件描述符中,即集中写:

#include <sys/uio.h>

// fd 是被操作的 socket,vector 是 iovec 结构数组,iovec 结构描述的是一块内存区,count 参数是 vector 数组长度

// 成功时返回读出/写入 fd 的字节数,失败返回 -1 并设置 errno

ssize_t readv(int fd, const struct iovec* vector, int cnt);

ssize_t writev(int fd, const struct iovec* vector, int cnt);

strcut iovec {

void *iov_base; // 内存起始地址

size_t iov_len; // 内存长度

};

例子:HTTP 文件服务器,简单通过 writev 将 headbuf(状态行+头部字段+空行)和 filebuf(文档内容)集中写入 socket

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <sys/stat.h>

#include <sys/types.h>

#include <sys/uio.h>

#include <fcntl.h>

#include <libgen.h>

#define BUFFER_SIZE 1024

// 定义两种 HTTP 状态码和状态信息

static const char *status_line[2] = {"200 OK", "500 Internal server error"};

int main(int argc, char *argv[])

{

if (argc <= 3)

{

printf("usage: %s ip_address port_number filename\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

// 将目标文件作为程序的第三个参数传入

const char *file_name = argv[3];

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

// 用于保存 HTTP 应答的状态行、头部字段和一个空行缓冲区

char header_buf[BUFFER_SIZE];

memset(header_buf, '\0', BUFFER_SIZE);

char *file_buf; // 存放目标文件内容的应用程序缓存

struct stat file_stat; // 用于获取目标文件的属性,比如是否为目录、文件大小等

bool valid = true; // 记录目标文件是否是有效文件

int len = 0; // 缓存区 header_buf 目前已经使用了多少字节的空间

if (stat(file_name, &file_stat) < 0)//调用 stat()函数来获取文件属性的

{

// 目标文件不存在

valid = false;

}

else

{

//判断文件是否为目录

if (S_ISDIR(file_stat.st_mode))//st_mode是一个 32 位无符号整形数据,该变量记录了文件的类型、文件的权限等

{

// 目标文件是一个目录

valid = false;

}

else if (file_stat.st_mode & S_IROTH)

{

// 当前用户有读取目标文件的权限

// 动态分配缓存区 file_buf,并指定其大小为目标文件的大小 + 1

// 然后将目标文件读入缓存区 file_buf

int fd = open(file_name, O_RDONLY);

file_buf = new char[file_stat.st_size + 1];

memset(file_buf, '\0', file_stat.st_size + 1);

if (read(fd, file_buf, file_stat.st_size) < 0)

{

valid = false;

}

}

else

{

valid = false;

}

}

// 目标文件有效就发送正常的 HTTP 应答

if (valid)

{

// HTTP 应答的状态行

//snprintf函数可以将格式化的数据输出到一个指定长度的字符串中

ret = snprintf(header_buf, BUFFER_SIZE - 1, "%s %s\r\n", "HTTP/1.1", status_line[0]);

len += ret;

// “Content-Length” 头部字段

ret = snprintf(header_buf + len, BUFFER_SIZE - 1 - len,

"Content-Length: %d\r\n", file_stat.st_size);

len += ret;

// 空行

ret = snprintf(header_buf + len, BUFFER_SIZE - 1 - len, "%s", "\r\n");

// 利用 writev 将 head_buf 和 file_buf 内容一并写出

struct iovec iv[2];

iv[0].iov_base = header_buf;

iv[0].iov_len = strlen(header_buf);

iv[1].iov_base = file_buf;

iv[1].iov_len = file_stat.st_size;

ret = writev(connfd, iv, 2);

}

else

{

// 目标文件无效则通知客户端服务器发生了“内部错误”

ret = snprintf(header_buf, BUFFER_SIZE - 1, "%s %s\r\n", "HTTP/1.1", status_line[1]);

len += ret;

ret = snprintf(header_buf + len, BUFFER_SIZE - 1 - len, "%s", "\r\n");

send(connfd, header_buf, strlen(header_buf), 0);

}

close(connfd);

delete[] file_buf;

}

close(sock);

return 0;

}

6.4 sendfile函数

sendfile 在两个文件描述符之间直接传递数据,完全在内核中操作,避免了内核缓冲区和用户缓冲区之间的数据拷贝,这就是零拷贝

#include <sys/sendfile.h>

// in_fd --sendfile--> out_fd

// in_fd 表示待读出内容的文件描述符,out_fd 表示待写入内容的文件描述符

// offset 表示 in_fd 的起始位置,count 表示 in_fd 和 out_fd 之间传输的字节数

ssize_t sendfile(int out_fd, int in_fd, off_t* offset, size_t count); // 成功时返回传输的字节数,失败返回-1

- in_fd 必须是一个支持类似 mmap 函数的文件描述符,必须指向真实的文件,不能是 socket 和管道

- out_fd 必须是一个 socket

sendfile 几乎是专门为在网络上传输文件而设计的,以下程序利用sendfile函数将服务器上的一个文件传送给客户:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <fcntl.h>

// #include <sys/sendfile.h>

// Mac 中 socket.h 里包含 sendfile 函数

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 3)

{

printf("usage: %s ip_address port_number filename\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

const char *file_name = argv[3];

int filefd = open(file_name, O_RDONLY);

assert(filefd > 0);

struct stat stat_buf;

fstat(filefd, &stat_buf);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

// Linux 接口

// sendfile(connfd, filefd, NULL, stat_buf.st_size);

// OSX 接口

int ret = 0;

sendfile(filefd, connfd, NULL, (off_t *)&ret, NULL, 0);

printf("sendfile %d bytes into client\n", ret);

close(connfd);

}

close(sock);

return 0;

}

使用 sendfile 将服务器上的一个文件传输给客户端,其中没有为目标文件分配任何用户空间的缓存,也没有执行读取文件的操作,相比于之前的通过 HTTP 传输文件的效率要高得多

6.5 mmap函数和munmap 函数

mmap函数用于申请一段内存空间,我们可将这段内存作为进程间通信的共享内存,也可将文件直接映射到其中。

munmap函数释放由mmap函数创建的这段内存

#include <sys/mman.h>

// start: 待分配内存的起始地址,如果为 null 则系统自动分配一个地址

// length: 指定内存段的长度;prot: 设置内存段的访问权限,可以按位或取 PROT_READ|PROT_WRITE|PROT_EXEC|PROT_NONE

// flags:控制内存段内容被修改后程序的行为

// fd 是被映射文件对应的文件描述符,一般通过 open 获得

// [return] 成功时返回指向目标内存区域的指针,失败 -1

void* mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset);

int munmap(void *start, size_t length); // 失败 -1,成功 0

6.6 splice函数

splice函数用于在两个文件描述符之间移动数据,也是零拷贝操作:

#include <fcntl.h>

// fd_in 表示待输入数据的文件描述符

// len 指定移动数据的长度

// flags 控制数据如何移动,取异或值:SPLICE_F_MOVE|SPLICE_F_NONBLOCK|SPLICE_F_MORE

ssize_t splice(int fd_in, loff_t* off_in, int fd_out, loff_t* off_out, size_t len, unsigned int flags); // 成功时返回移动字节的数量,失败 -1

如果fd_in是一个管道文件描述符,那么off_in参数必须被设置为NULL,否则,off_in参数表示从输入数据流的何处开始读取数据,此时,若off_in被设置为NULL,则表示从输入数据流的当前偏移位置读入,若off_in不为NULL,则它指出具体的偏移位置。fd_out/off_out参数的含义与fd_in/off_in参数相同,不过用于输出数据流。

使用splice函数时,fd_in和fd_out必须至少有一个是管道描述符。

splice函数调用成功时返回移动字节的数量,它可能返回0,表示没有数据需要移动,这发生在从管道中读取数据(此时fd_in是管道文件描述符),而该管道中没有任何数据时。

下面使用splice函数实现一个零拷贝的回射服务器,它将客户端发送的数据原样返回给客户端:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc <= 2)

{

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int sock = socket(PF_INET, SOCK_STREAM, 0);

assert(sock >= 0);

int ret = bind(sock, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(sock, 5);

assert(ret != -1);

struct sockaddr_in client;

socklen_t client_addrlength = sizeof(client);

int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength);

if (connfd < 0)

{

printf("errno is: %d\n", errno);

}

else

{

int pipefd[2];

assert(ret != -1);

ret = pipe(pipefd); // 创建管道

// 将 connfd 上流入的客户数据定向到管道中: socket --> pipe[1]

ret = splice(connfd, NULL, pipefd[1], NULL, 32768, SPLICE_F_MORE | SPLICE_F_MOVE);

assert(ret != -1);

// 将管道的输出定向到 connfd 客户连接的文件描述符: pipe[0] --> socket

ret = splice(pipefd[0], NULL, connfd, NULL, 32768, SPLICE_F_MORE | SPLICE_F_MOVE);

assert(ret != -1);

close(connfd);

}

close(sock);

return 0;

}

通过splice函数将客户端的内容读入pipefd[1]中,然后再使用splice函数从pipefd[0]中读出该内容到客户端,从而实现了简单高效的回射服务,整个过程未执行recv/send函数,因此也未涉及用户空间和内核空间之间的数据拷贝。

6.7 tee函数

tee函数在两个管道文件描述符之间复制数据,也是零拷贝操作,它不消耗数据,因此源文件描述符上的数据仍然可以用于后续的读操作:

#include <fcntl.h>

// fd_in 和 fd_out 必须都是管道文件描述符

// [return] 成功时返回复制的字节数,失败 -1

ssize_t tee(int fd_in, int fd_out, size_t len, unsigned int flags);

例子:实现了一个简单的 tee 程序,利用 splice(标准输入输出<–>输入输出管道) 和 tee(输出管道<–>文件管道)同时输出数据到终端和文件

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <libgen.h>

int main(int argc, char *argv[])

{

if (argc != 2)

{

printf("usage: %s <file>\n", argv[0]);

return 1;

}

int filefd = open(argv[1], O_CREAT | O_WRONLY | O_TRUNC, 0666);

assert(filefd > 0);

int pipefd_stdout[2];

int ret = pipe(pipefd_stdout);

assert(ret != -1);

int pipefd_file[2];

ret = pipe(pipefd_file);

assert(ret != -1);

// close( STDIN_FILENO );

// dup2( pipefd_stdout[1], STDIN_FILENO );

// write( pipefd_stdout[1], "abc\n", 4 );

// 将标准输入内容输入管道 pipe_stdout[1]

ret = splice(STDIN_FILENO, NULL, pipefd_stdout[1], NULL, 32768, SPLICE_F_MORE | SPLICE_F_MOVE);

assert(ret != -1);

// 将管道 pipefd_stdout[0] 的输出复制到管道 pipe_file[1]

ret = tee(pipefd_stdout[0], pipefd_file[1], 32768, SPLICE_F_NONBLOCK);

assert(ret != -1);

// 将管道 pipe_file[0] 的输出定向到文件描述符 filefd 上,从而将标准输入的内容写入文件

ret = splice(pipefd_file[0], NULL, filefd, NULL, 32768, SPLICE_F_MORE | SPLICE_F_MOVE);

assert(ret != -1);

// 将管道 pipe_stdout[0] 的输出定向到标准输出,其内容和写入文件的内容完全一致

ret = splice(pipefd_stdout[0], NULL, STDOUT_FILENO, NULL, 32768, SPLICE_F_MORE | SPLICE_F_MOVE);

assert(ret != -1);

close(filefd);

close(pipefd_stdout[0]);

close(pipefd_stdout[1]);

close(pipefd_file[0]);

close(pipefd_file[1]);

return 0;

}

6.8 fcntl函数

fcntl函数正如其名字file control描述的那样,提供了对文件描述符的各种控制操作。

另一个常见的控制文件描述符属性和行为的系统调用是ioctl,且ioctl函数比fcntl函数能执行更多的控制,但控制文件描述符的常用属性和操作,fcntl函数是POSIX规范指定的首选方法:

#include <fcntl.h>

// fd 是被操作的文件描述符,cmd 指定执行何种类型的操作

// 根据操作类型不同可能还需要第3个可选参数 arg

int fcntl(int fd, int cmd, ...); // 失败 -1

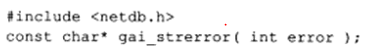

fcntl函数支持的常用操作及其参数见下表:

网络编程中,fcntl函数通常用来将一个文件描述符设为非阻塞的:

int setnonblocking(int fd) {

int old_option = fcntl(fd, F_GETFL);

int new_option = old_option | O_NONBLOCK;

fcntl(fd, F_SETFL, new_option);

return old_option; // 返回旧的状态标志,以便日后恢复该状态标志

}

此外,SIGIO和SIGURG这两个信号与其他Linux信号不同,它们必须与某个文件描述符相关联才能使用。

当被关联的文件描述符可读或可写时,系统将触发SIGIO信号;当被关联的文件描述符(必须是一个socket)上有带外数据可读时,系统将触发SIGURG信号。

将信号和文件描述符关联的方法是使用fcntl函数为目标文件描述符指定宿主进程或进程组,则被指定的宿主进程或进程组将捕获到这两个信号。

使用SIGIO时,还需要用fcntl函数设置套接字描述符的O_ASYNC标志(异步IO标志,但SIGIO信号模型并非真正意义上的异步IO模型)。

第7章 Linux服务器程序规范

服务器程序规范,如:

-

1.Linux服务器程序一般以后台进程形式运行,后台进程又称守护进程(daemon),它没有控制终端,因此不会意外接收到用户输入。守护进程的父进程通常是init进程(PID为1的进程)。

-

2.Linux服务器程序通常有一套日志系统,它至少能输出日志到文件,有的高级服务器还能输出日志到专门的UDP服务器。大部分后台进程都在/var/log目录下拥有自己的日志目录。

-

3.Linux服务器程序一般以某个专门的非root身份运行,如mysqld、httpd、syslogd等后台进程分别拥有运行账户mysql、apache、syslog。

-

4.Linux服务器程序通常是可配置的,服务器程序通常能处理很多选项,如果选项太多,除命令行外可用配置文件来管理。绝大多数服务器程序都有配置文件,并存放在/etc目录下,如squid服务器的配置文件是/etc/squid3/squid.conf。

-

5.Linux服务器进程通常会在启动时生成一个PID文件并存入/var/run目录中,以记录该后台进程的PID,如syslogd的PID文件是/var/run/syslogd.pid。

-

6.Linux服务器通常需要考虑系统资源和限制,以预测自身能承受多大负荷,如进程可用文件描述符总数和内存总量等。

7.1 日志

7.1.1 Linux系统日志

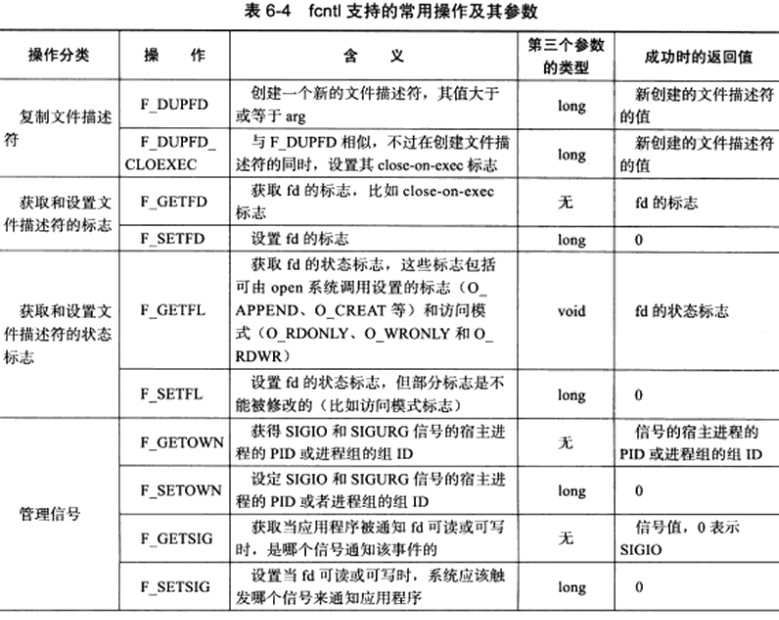

Linux提供一个守护进程来处理系统日志,即syslogd,但现在Linux上使用的都是它的升级版rsyslogd。

rsyslogd守护进程既能接收用户进程输出的日志,又能接收内核日志。

用户进程是通过调用syslog函数生成日志的,该函数将日志输出到一个UNIX本地域socket类型(AF_UNIX)的文件/dev/log中,rsyslogd则监听该文件以获取用户进程的输出。内核日志在老系统上是通过rklogd守护进程管理的,rsyslogd利用以下技术实现了同样的功能:内核日志有printk等函数打印至内核的环状缓存(ring buffer)中,环状缓存的内容直接映射到/proc/kmsg文件中,rsyslogd则通过读取该文件获得内核日志。

rsyslogd守护进程在接收到用户进程或内核输入的日志后,会把它们输出至特定的日志文件。

默认,调试信息会保存至/var/log/debug文件,普通信息保存至/var/log/messages文件,内核消息保存至/var/log/kern.log文件,但日志信息具体如何分发,可在rsyslogd的配置文件中设置。

rsyslogd的主配置文件是/etc/rsyslog.conf,其中主要可以设置的内容包括:内核日志输入路径(接收来自操作系统内核的日志消息的路径),是否接收UDP日志及其监听端口(默认为514,见/etc/services文件),是否接收TCP日志及其监听端口,日志文件的权限,包含哪些子配置文件(如/etc/rsyslog.d/*.conf)。rsyslogd的子配置文件则指定各类日志的目标存储文件。

7.1.2 syslog函数

syslog函数,可以与rsyslogd守护进程通信,定义如下:

#include <syslog.h>

// priority 是设施值(LOG_USER)与日志级别的按位或

void syslog(int priority, const char* message, ...);

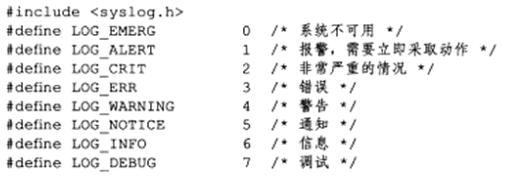

priority参数是设施值和日志级别的按位或,设施值的默认值是LOG_USER,日志级别有以下几个:

openlog 可以改变 syslog 的默认输出方式,进一步结构化日志内容

#include <syslog.h>

// ident 参数指定的字符串被添加到日志消息的日期和时间之后,一般为程序的名字

void openlog(const char* ident, int logopt, int facility);

ident参数指定的字符串被添加到日志消息的日期和时间之后,它通常被设置为程序的名字。

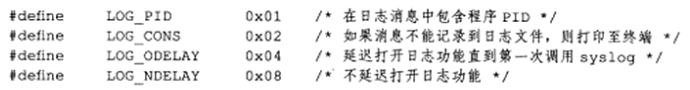

logopt参数对后续syslog函数的行为进行配置,它可取以下值的按位或:

facility参数修改syslog函数中的默认设施值。

程序开发过程中需要输出很多调试信息,而发布之后又需要将这些调式信息关闭,这时候需要对日志进行过滤,setlogmask函数可用于设置syslog的日志掩码:

#include <syslog.h>

// 日志级别大于日志掩码的日志信息会被系统忽略

// maskpri参数指定日志掩码值

int setlogmask(int maskpri);

// 最后需要关闭日志

void closelog();

7.2 用户信息

7.2.1 UID、EUID、GID和EGID

大部分服务器需要以root身份启动,但不能以root身份运行。

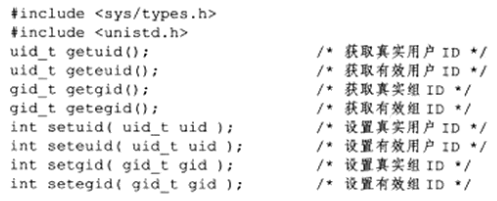

以下函数可获取和设置当前进程的真实用户ID(UID)、有效用户ID(EUID)、真实组(GID)、有效组(EGID):

一个进程拥有两个用户ID:UID和EUID。

EUID存在的目的是方便资源访问,它使得运行程序的用户拥有该程序的有效用户的权限。

如su程序,任何用户都可使用它修改自己的账户信息,但修改账户时su程序需要访问/etc/passwd文件,而访问该文件需要root权限,用ls命令可以看到,su程序的所用者是root,且它被设置了set-user-id标志,这个标志表示,任何用户运行su程序时,其有效用户id就是该程序的所有者(即root),因此根据有效用户的含义,任何运行su程序的用户都能访问/etc/passwd文件。有效用户为root的进程称为特权进程(privileged processes)。EGID的含义与EUID类似,能给运行目标程序的用户提供有效组的权限。

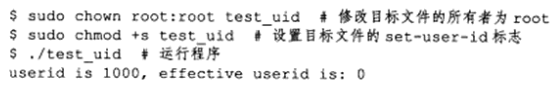

可用以下程序测试进程的UID和EUID的区别:

#include <unistd.h>

#include <stdio.h>

int main()

{

uid_t uid = getuid();

uid_t euid = geteuid();

printf("userid is %d, effective userid is: %d\n", uid, euid);

return 0;

}

将以上程序(名为test_uid)的所有者设置为root,并设置该文件的set-user-id标志,然后运行该程序以查看UID和EUID,具体操作如下:

由上图,进程UID是启动程序的用户的ID,而EUID是root账户(文件所有者)的ID。

7.2.2 切换用户

以下代码将以root身份启动的进程切换为真实用户ID运行:

#include <unistd.h>

#include <stdio.h>

static bool switch_to_user(uid_t user_id, gid_t gp_id)

{

// 确保目标用户不是root

if ((user_id == 0) && (gp_id == 0))

{

return false;

}

gid_t gid = getgid();

uid_t uid = getuid();

// 确保当前用户是合法用户:root或者目标用户

if (((gid != 0) || (uid != 0)) && ((gid != gp_id) || (uid != user_id)))

{

return false;

}

// 如果不是root,则已经是目标用户

if (uid != 0)

{

return true;

}

// 切换目标用户

if ((setgid(gp_id) < 0) || (setuid(user_id) < 0))

{

return false;

}

return true;

}

7.3 进程间关系

7.3.1 进程组

Linux下每个进程都属于一个进程组,因此进程除了有PID信息外,还有进程组ID(PGID),可用getpgid函数获取指定进程的PGID。

每个进程组都有一个首领进程,其PGID和PID相同,进程组将一直存在,直到其中所有进程都离开进程组中(终止或者加入到其他进程组),setpgid函数用于设置PGID。

#include <unistd.h>

pid_t getpgid(pid_t pid); // 成功返回 pid 的进程组的 PGID,失败 -1

int setpgid(pid_t pid, pid_t pgid); // 设置 pid 的进程组的 PGID 为 pgid,成功 0,失败 -1

一个进程只能设置自己或者子进程的 PGID,并且子进程调用 exec 系列函数之后不能再在父进程中对它设置 PGID。

7.3.2 会话

一些关联的进程组形成一个会话 session。

#include <unistd.h>

// 1、只能由非首领进程创建会话,

// 2、调用进程成为会话的首领,此时该进程是新会话的唯一成员

// 3、新建一个进程组,其PGID就是调用进程的PID,调用进程成为该组的首领

pid_t setsid(void);

// 读取会话ID(SID),Linux 系统认为 SID==PGID

pid_t getsid(pid_t pid);

7.3.3 用ps命令查看进程关系

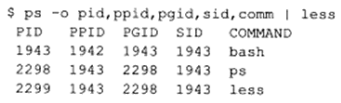

可用ps命令查看进程、进程组、会话之间的关系:

我们是在bash shell下执行ps和less命令的,所以ps和less命令的父进程是bash命令,这可从PPID(父进程PID)一列看出。

这3条命令创建了一个会话(SID是1943)和2个进程组(PGID分别是1942和2298)。

bash命令的PID、PGID、SID都相同,说明它是会话的首领,也是组1943的首领。ps命令则是组2298的首领,因为其PID也是2298。

7.4 系统资源限制

Linux上运行的程序会受到资源限制的影响,如物理设备限制(CPU、内存等)、系统策略限制(CPU时间等)、具体实现的限制(文件名的最大长度等)。Linux系统资源限制可通过以下函数来读取或设置:

#include <sys/resource.h>

int getrlimit(int resource, struct rlimit *rlim);

int setrlimit(int resource, const struct rlimit *rlim);

// rlim_t 是一个整数类型,描述资源级别

struct rlimit

{

rlim_t rlim_cur; // 资源的软限制,建议性的、最好不要超越的限制,超过可能会发信号终止进程

rlim_t rlin_max; // 资源的硬限制,软限制的上限,普通程序只能减少,只有 root 可以增加

}

此外,我们可用ulimit命令修改当前shell环境下的资源限制(软限制和硬限制),这种修改将对该shell启动的所有后续程序有效,我们也可以通过修改配置文件来改变系统软限制和硬限制,且这种修改是永久的。

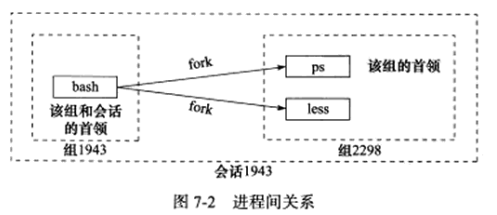

resource参数指定资源限制类型,下标列出了部分比较重要的资源限制类型:

7.5 改变工作目录和根目录

有些服务器程序还需改变工作目录和根目录,一般,Web服务器的逻辑根目录并非文件系统的根目录“/”,而是站点的根目录(对于Linux的Web服务来说,该目录一般是/var/www)。

获取进程当前工作目录和改变进程工作目录的函数:

#include <unistd.h>

// buf 指向内存用于存储进程当前工作目录的绝对路径名,size 指定其大小

// 如果当前工作目录的绝对路径长度加上结束字符\0超过了size参数,则getcwd函数将返回NULL,并将errno设为ERANGE

// 如果buf参数为NULL且size参数非0,则getcwd函数可能在内部使用malloc函数动态分配内存,并将进程的当前工作目录存储在其中,此时我们必须自己释放getcwd函数在内部创建的这块内存。

// [return] 成功时返回一个指向目标存储区的指针

char* getcwd(char* buf, size_t size); // 失败返回 NULL 并设置 errno

// path 指定要切换到的目标目录

int chdir(const char* path); // 成功 0,失败 -1

// 改变进程根目录

// path 指定要切换到的目标根目录

int chroot(const char* path); // 成功 0,失败 -1

chroot函数不改变进程的当前工作目录,所以调用chroot后,我们仍需使用chdir("/")将工作目录切换到新的根目录。

改变进程的根目录后,我们可能无法访问类似/dev的文件或目录,因为它们并非处于新的根目录之下,但调用chroot后,进程原先打开的文件描述符依然生效,所以我们可以利用这些早先打开的文件描述符来访问调用chroot后不能直接访问的文件或目录,尤其是一些日志文件。

只有特权进程才能改变根目录。

7.6 服务器程序后台化

以下函数可以让一个进程以守护进程的方式运行:

#include <unistd.h>

#include <stdio.h>

#include <sys/stat.h>

#include <assert.h>

#include <sys/fcntl.h>

bool daemonize()

{

pid_t pid = fork();//fork 函数会新生成一个进程,调用 fork 函数的进程为父进程,新生成的进程为子进程。

if (pid < 0)

{

return false;

}

else if (pid > 0)

{

exit(0);//关闭父进程,这样子进程就不是进程组首进程,就可以调用setsid了

}

umask(0);// 设置文件权限掩码,这样当进程创建新文件时,文件的额权限将是0777

pid_t sid = setsid();// 创建新会话,本进程将成为进程组的首领

if (sid < 0)

{

return false;

}

if ((chdir("/")) < 0)// 切换工作目录,防止当前工作目录所在文件系统不能卸载

{

return false;

}

// 关闭所有文件描述符

close(STDIN_FILENO);

close(STDOUT_FILENO);

close(STDERR_FILENO);

// 此处省略了关闭其他已打开的文件描述符的代码

// 将标准输入、标准输出、标准错误重定向到/dev/null文件

open("/dev/null", O_RDONLY);

open("/dev/null", O_RDWR);

open("/dev/null", O_RDWR);

return true;

}

Linux提供了完成以上功能的库函数:

#include <unistd.h>

// nochdir 用于指定是否改变工作目录,0 --> 工作目录设置为 "/",否则留在当前目录

// noclose 为 0 时标准输入输出以及错误输出都被重定向到 /dev/null 文件,否则依然使用原来的设备

int daemon(int nochdir, int noclose); // 成功 0,失败-1

第8章 高性能服务器程序框架

在这一章中,按照服务器程序的一般原理,将服务器解构为如下三个主要模块:

- I/O处理单元。本章将介绍IO处理单元的四种I/O模型和两种高效事件处理模式。

- 逻辑单元。本章将介绍逻辑单元的两种高效并发模式,以及高效的逻辑处理方式–有限状态机。

- 存储单元。本书不讨论存储单元,因为它只是服务器程序的可选模块,而且其内容与网络编程本身无关。

8.1 服务器模型

8.1.1 C/S模型

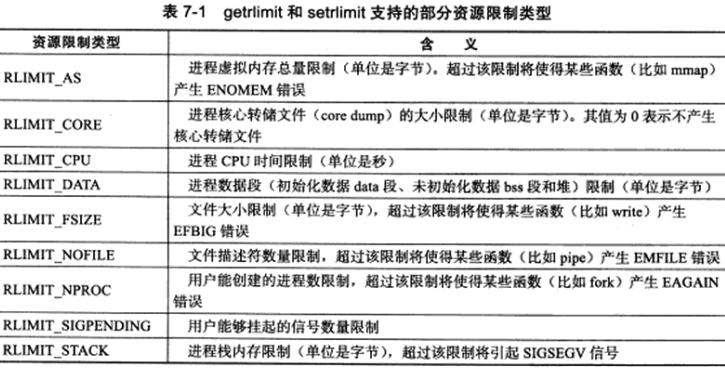

但由于资源(视频、新闻、软件等)被数据提供者所垄断,所以几乎所有网络应用程序都采用了下图所示的C/S(客户端/服务器)模型,所有客户端都通过访问服务器来获取所需资源:

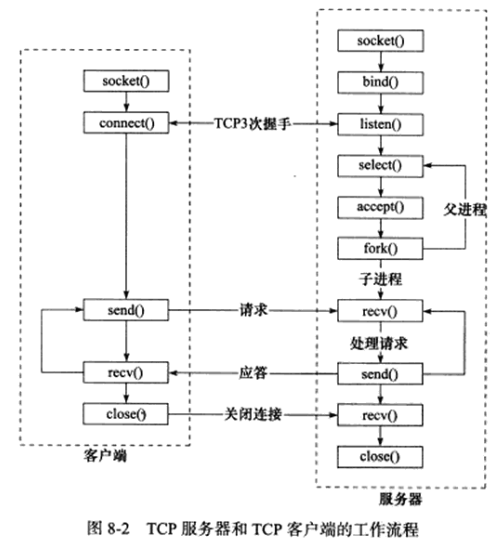

C/S模型中,服务器启动后,首先创建一个或多个监听socket,并调用bind将其绑定到服务器感兴趣的端口上,然后调用listen等待客户连接,之后客户端就可以调用connect向服务器发起连接了。

由于客户连接请求是随机到达的异步事件,服务器需要使用某种IO模型来监听这一事件,图8-2中使用的是IO复用技术(select系统调用)

当监听到连接请求后,服务器就调用accept函数接受它,并分配一个逻辑单元来服务新的连接,逻辑单元可以是新创建的子进程、子线程或其他,上图中,服务器给客户端分配的逻辑单元是由fork系统调用创建的子进程。逻辑单元读取客户请求,处理该请求,然后将处理结果返回给客户端,客户端接收到服务器反馈的结果后,可以继续向服务器发送请求,也可以立即主动关闭连接。如果客户端主动关闭连接,则服务器执行被动关闭连接。至此,双方的通信结束。

服务器在处理一个客户请求的同时还会继续监听其他客户请求,否则就变成了效率低下的串行服务器(必须先处理完前一个客户的请求,才能继续处理下一个客户请求)了。

C/S模型适合资源相对集中的场合,且它的实现也很简单,但其缺点也很明显:服务器是通信的中心,当访问量过大时,可能所有客户都将得到很慢的响应。

8.1.2 P2P模型

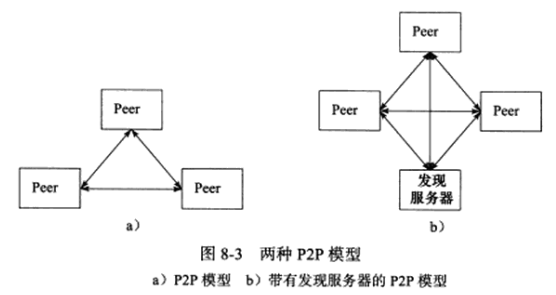

P2P(Peer to Peer,点对点)模型比C/S模型更符合网络通信的实际情况,它摒弃了以服务器为中心的格局,让网络上所有主机重新回归对等的地位,P2P模型如下图所示:

P2P模型使得每台机器在使用服务的同时也给别人提供服务,这样资源能充分、自由地共享。云计算机群(一组云计算资源的集合)可以看做P2P模型的一个典范,但P2P模型也有缺点:当用户之间传输的请求过多时,网络的负载将加重。

图8-3a所示的P2P模型中,主机之间很难互相发现,所以实际使用的P2P模型通常有一个专门的发现服务器,如图8-3b所示,这个发现服务器通常提供查找服务(甚至还可以提供内容服务),使每个客户都能尽快找到自己需要的资源。

从编程角度讲,P2P模型可看作C/S模型的扩展,每台主机既是客户端,又是服务器。

8.2 服务器编程框架

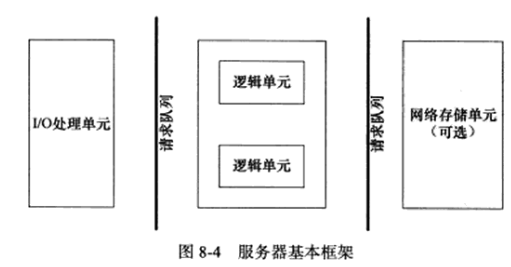

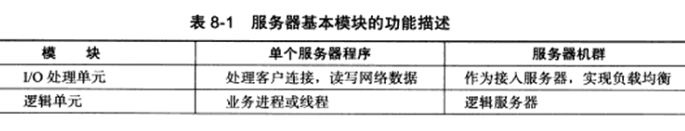

虽然服务器程序种类繁多,但其基本框架都一样,不同之处在于逻辑处理,基本框架见下图:

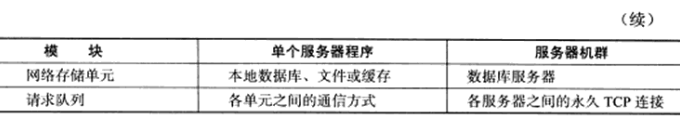

上图既能用来描述一台服务器,也能用来描述一个服务器机群,两种情况下各个部件的含义和功能见下表:

IO处理单元是服务器管理客户连接的模块,它通常要完成以下工作:等待并接受新的客户连接,接收客户数据,将服务器响应数据返回给客户端。但数据的收发不一定在IO处理单元中执行,也可能在逻辑单元中执行,具体在何处执行取决于事件处理模式。对一个服务器机群来说,IO处理单元是一个专门的接入服务器,它实现负载均衡,从所有逻辑服务器中选取符合最小的一台来为新客户服务。

一个逻辑单元通常是一个进程或线程,它分析并处理客户数据,然后将结果传递给IO处理单元或直接发送给客户端(取决于事件处理模式)。对服务器机群而言,一个逻辑单元本身就是一台逻辑服务器,服务器通常拥有多个逻辑单元,以实现对多个客户任务的并行处理。

网络存储单元可以是数据库、缓存、文件,甚至是一台独立的服务器。但它不是必须得,如ssh、telnet等登录服务器就不需要这个单元。

请求队列是各个单元之间的通信方式的抽象,IO处理单元接收到客户请求时,需要以某种方式通知一个逻辑单元来处理该请求,同样,多个逻辑单元同时访问一个存储单元时,也需要某种机制来协调处理竞态条件。请求队列通常被实现为池的一部分。对于服务器机群而言,请求队列是各台服务器之间预先建立的、静态的、永久的TCP连接,这种TCP连接能提高服务器之间交换数据的效率,因为它避免了动态建立TCP连接导致的额外的系统开销。

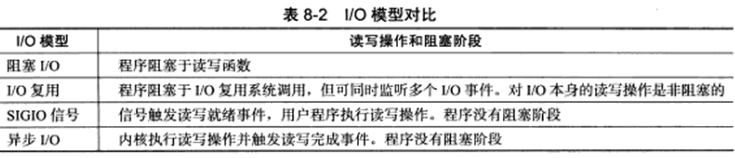

8.3 I/O模型

socket在创建的时候默认是阻塞的,我们可以给socket系统调用的第2个参数传递SOCK_NONBLOCK标志,或通过fcntl系统调用的F_SETFL命令,将其设置为非阻塞的。

阻塞和非阻塞的概念能应用于所有文件描述符,而不仅仅是socket。我们称阻塞的文件描述符为阻塞IO,称非阻塞的文件描述符为非阻塞IO。

针对阻塞IO执行的系统调用可能因为无法立即完成而非操作系统挂起,直到等待的事件发生为止,比如,客户端通过connect函数向服务器发起连接时,connect函数首先发送同步报文段给服务器,然后等待服务器返回确认报文段,如果服务器的确认报文端没有立即到达客户端,则connect函数将被挂起,直到客户端收到确认报文段并唤醒connect函数。socket的基础API中,可能被阻塞的系统调用包括accept、send、recv、connect。

针对非阻塞IO执行的系统调用总是立即返回,而不管事件是否已经发生。如果事件没有立即发生,这些系统调用返回-1,这和出错返回相同,此时我们要根据errno来区分是出错还是非阻塞情况,对accept、send、recv函数而言,事件未发生时errno通常被设置成EAGAIN(意为再来一次)或者EWOULDBLOCK(意为期望阻塞),对connect函数而言,errno则被设置成EINPROGRESS(意为在处理中)。

我们只有在事件已经发生的情况下操作非阻塞IO(读、写等),才能提高程序的效率,因此,非阻塞IO通常要和其他IO通知机制一起使用,比如IO复用和SIGIO信号。

IO复用是最常使用的IO通知机制,它指的是,应用进程通过IO复用函数向内核注册一组事件,内核通过IO复用函数把其中就绪的事件通知给应用程序。Linux上常用的IO复用函数是select、poll、epoll_wait。IO复用函数本身是阻塞的,它能提高程序效率的原因在于它们具有同时监听多个IO事件的能力。

SIGIO信号也能用来报告IO事件,我们可以为一个目标文件描述符指定宿主进程,被指定的宿主进程将捕获到SIGIO信号,这样,当目标文件描述符上有事件发生时,SIGIO信号的信号处理函数将被触发,我们就能在该信号处理函数中对目标文件描述符执行非阻塞IO操作了

理论上,阻塞IO、IO复用、信号驱动IO都是同步IO模型,因为在这三种IO模型中,IO的读写操作,都是在IO事件发生之后,由应用进程来完成的。而POSIX规范所定义的异步IO模型中,用户可以直接对IO执行读写操作,这些操作告诉内核用户读写缓冲区的位置,以及IO操作完成后内核通知应用进程的方式。

异步IO的读写操作总是立即返回,而不论IO是否是阻塞的,因为真正的读写操作已经由内核接管。同步IO模型要求用户代码自行执行IO操作(将数据从内核缓冲区读入用户缓冲区,或将数据从用户缓冲区写入内核缓冲区),而异步IO机制则由内核来执行IO操作(数据在内核缓冲区和用户缓冲区之间的移动是由内核在“后台”完成的)。同步IO向应用进程通知的是IO就绪事件,而异步IO向应用进程通知的是IO完成事件。Linux环境下,aio.h头文件中定义的函数提供了对异步IO的支持。

8.4 两种高效的事件处理模式

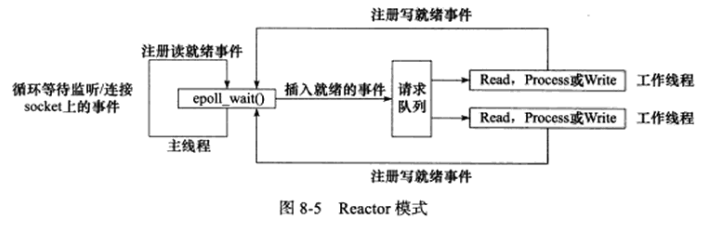

服务器进程通常需要处理三类事件:IO事件、信号、定时事件。我们先整体介绍一下两种高效的事件处理模式Reactor和Proactor。

同步IO模型通常用于实现Reactor模式,异步IO模型则用于实现Proactor模式,也可用同步IO方式模拟出Proactor模式。

8.4.1 Reactor模式

Reactor模式要求主线程(IO处理单元)只负责监听文件描述符上是否有事件发生,有的话立即将该事件通知工作线程(逻辑单元),除此之外,主线程不做任何其他实质性的工作。读写数据、接受新连接、处理客户请求均在工作线程中完成。

使用同步IO模型(以epoll_wait函数为例)实现的Reactor模式的工作流程是:

-

1.主线程往epoll内核事件表中注册socket上的读就绪事件。

-

2.主线程调用epoll_wait等待socket上有数据可读。

-

3.当socket上有数据可读,epoll_wait函数通知主线程,主线程将socket可读事件放入请求队列。

-

4.睡眠在请求队列上的某个工作线程被唤醒,它从socket读取数据,并处理客户请求,然后往epoll内核事件表中注册该socket上的写就绪事件。

-

5.主线程调用epoll_wait等待socket可写。

-

6.当socket可写时,epoll_wait函数通知主线程,主线程将socket可写事件放入请求队列。

-

7.睡眠在请求队列上的某个工作线程被唤醒,它往socket上写入服务器处理客户请求的结果。

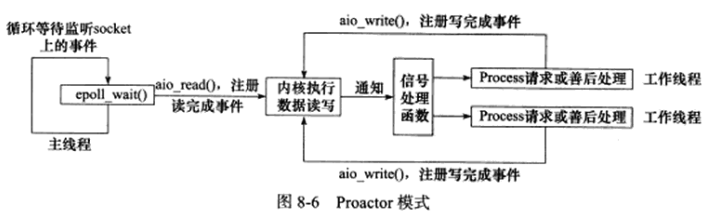

8.4.2 Proactor模式

Proactor模式将所有IO操作都交给主线程和内核来处理,工作线程仅仅负责业务逻辑,因此,Proactor模式更符合图8-4所描述的服务器编程框架。

使用异步IO模型(如aio_read、aio_write函数)实现的Proactor模型的工作流程是:

-

1.主线程调用aio_read向内核注册socket上的读完成事件,并告诉内核用户读缓冲区的位置,以及读操作完成时如何通知应用程序(这里以信号为例)。

-

2.主线程等待读完成期间可继续处理其他逻辑。

-

3.当socket上的数据被读入用户缓冲区后,内核向应用进程发送一个信号,以通知数据已可用。

-

4.应用进程预先定义好的信号处理函数选择一个工作线程来处理客户请求,工作线程处理完客户请求后,调用aio_write向内核注册socket上的写完成事件,并告诉内核用户写缓冲区的位置,以及写操作完成时如何通知应用进程(仍以信号为例)。

-

5.主线程继续处理其他逻辑。

-

6.当用户缓冲区中的数据被写入socket后,内核向应用进程发送一个信号,以通知应用进程数据已经发送完毕。

-

7.应用进程预先定义好的信号处理函数选择一个工作线程做善后处理,如是否关闭socket。

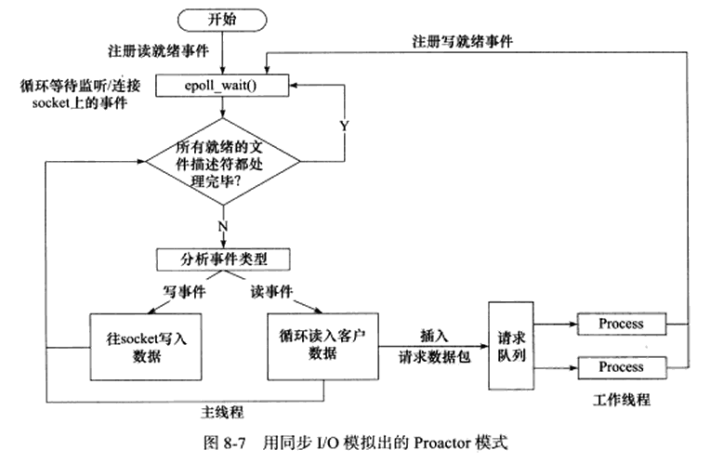

8.4.3 模拟Proactor模式

使用同步IO方式模拟Proactor模式的一种方法:主线程执行数据读写操作,读写完成后,主线程向工作线程通知这一完成事件,从工作线程的角度来看,它们直接获得了数据读写的结果,接下来只需对读写的结果进行逻辑处理。

使用同步IO模型(以epoll_wait函数为例)模拟出的Proactor模式的工作流程如下:

-

1.主线程往epoll内核事件表中注册socket上的读就绪事件。

-

2.主线程调用epoll_wait等待socket上有数据可读。

-

3.当socket上有数据可读时,epoll_wait函数通知主线程,主线程从socket循环读取数据,直到没有更多数据可读,然后将读取到的数据封装成一个请求对象并插入请求队列。

-

4.睡眠在请求队列上的某个工作线程被唤醒,它获得请求对象并处理客户请求,然后往epoll内核事件表中注册socket上的写就绪事件。

-

5.主线程调用epoll_wait等待socket可写。

-

6.当socket可写时,epoll_wait函数通知主线程,主线程往socket上写入服务器处理客户请求的结果。

8.5 两种高效的并发模式

并发编程的目的是让进程“同时”执行多个任务,如果程序是计算密集型的,并发编程并没有优势,反而由于任务的切换使效率降低,但如果进程是IO密集型的,如经常读写文件、访问数据库等,并发编程就有优势了,由于IO操作的速度远没有CPU的计算速度快,所以让程序阻塞于IO操作将浪费大量CPU时间。

并发模式指IO处理单元和多个逻辑单元之间协调完成任务的方法,服务器主要有两种并发编程模式:半同步/半异步(half-sync/half-async)和领导者/追随者(Leader/Follwers)模式。

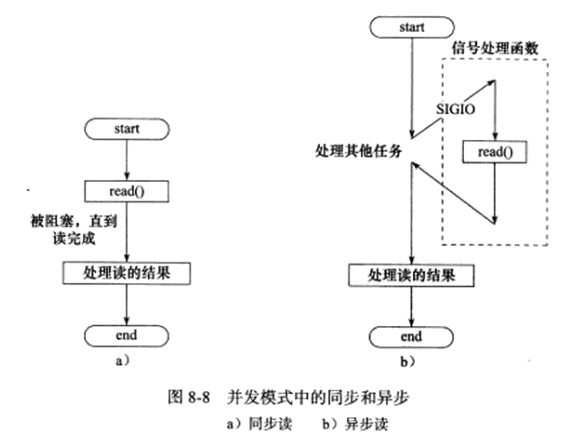

8.5.1 半同步/半异步模式

在IO模型中,同步和异步区分的是内核向应用进程通知的是何种IO事件(是就绪时间还是完成事件),以及该由谁来完成IO读写(是应用进程还是内核)。

在并发模式中,同步指的是进程完全按照代码序列顺序执行,异步指的是程序的执行需要由系统事件来驱动,常见的系统事件包括中断、信号。

按照同步方式运行的线程称为同步线程,按照异步方式运行的线程称为异步线程。

异步线程的执行效率高,实时性强,这是很多嵌入式程序采用的模型,但编写以异步方式执行的程序相对复杂,难以调试和扩展,且不适合大量的并发(大量信号和跳转)。而同步线程虽然执行效率相对较低,实时性较差(阻塞中,其他IO被搁置),但逻辑简单。

对于像服务器这种既要求较好的实时性,又要求能同时处理多个客户请求的应用,就应该同时使用同步线程和异步线程来实现,即半同步/半异步模式。

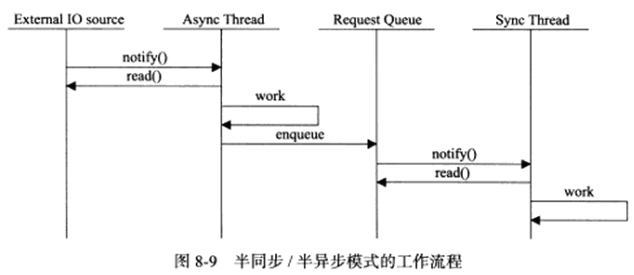

半同步/半异步模式中,同步线程用于处理客户逻辑,相当于逻辑单元,异步线程用于处理IO时间,相当于IO处理单元。异步线程监听到客户请求后,就将其封装成请求对象插入请求队列,请求队列将通知某个工作在同步模式的工作线程来读取并处理该请求对象。具体选择哪个工作线程来为新的客户请求服务,取决于请求队列的设计,如最简单的轮流选取工作线程的Round Robin算法,也可通过条件变量或信号量来随机选择一个工作线程。

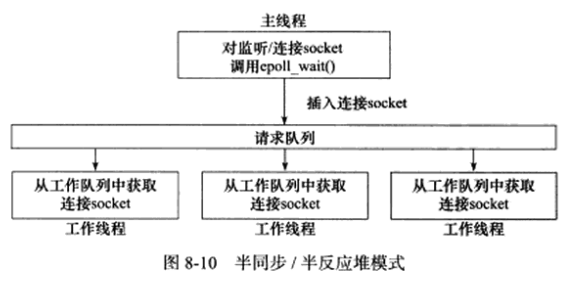

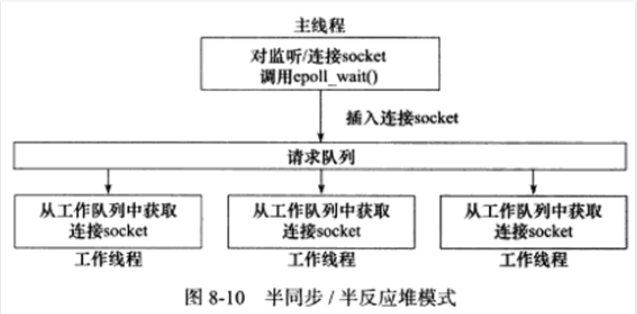

如果考虑两种事件处理模式(reactor和proactor)和几种IO模型,则半同步/半异步模式就存在多种变体,其中一种变体被称为半同步/半反应堆(half-sync/half-reactive)模式:

上图中,异步线程只有主线程,它负责监听所有socket上的事件,如果监听socket上有可读事件发生,即有新的连接请求到来,主线程就接受它以得到新的连接socket,然后往epoll内核事件表中注册新的已连接socket上的读写事件。如果连接socket上有读写事件发生,即有新的客户请求到来或有数据要发送到客户端,主线程就将该连接socket插入请求队列中。所有工作线程都睡眠在请求队列上,有任务到来时,它们通过竞争(如申请互斥锁)获得任务的接管权,这种竞争机制使得只有空闲的工作线程才有机会处理新任务。

上图中,主线程插入请求队列中的任务是就绪的连接socket,说明采用的事件处理模式是Reactor模式(它要求工作线程自己从socket上读取客户请求和往socket写入服务器应答),这就是该模式的名称中half-reactive的含义。

实际上,半同步/半反应堆模式也能使用模拟的Proactor事件处理模式,即由主线程完成数据的读写,此时,主线程一般会将应用数据、任务类型等信息封装为一个任务对象,然后将其(或指向该任务对象的一个指针)插入请求队列,工作线程从请求队列中取得任务对象后,即可处理它,而无须执行读写操作了。

半同步/半反应堆模式存在如下缺点:

- 1.主线程和工作线程共享请求队列,主线程往请求队列中添加任务,或工作线程从请求队列中取出任务,都需要对请求队列加锁保护,从而白白耗费CPU时间。

- 2.每个工作线程同一时间只能处理一个客户请求,如果客户数量较多,而工作线程较少,则请求队列中将堆积很多任务,客户端的响应速度将变慢,如果通过增加工作线程来解决这一问题,则工作线程的切换也将耗费大量CPU时间。

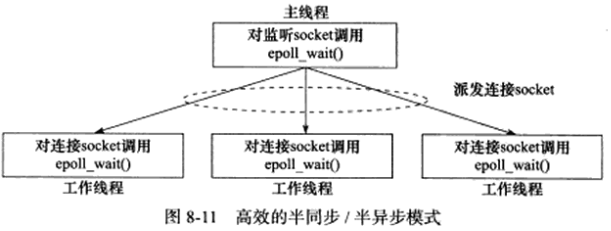

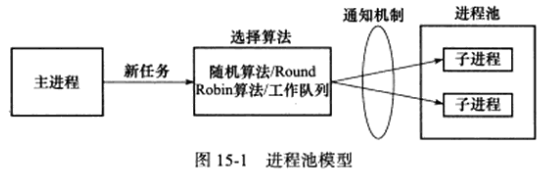

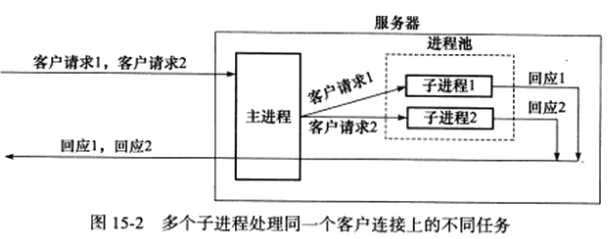

下图描述了一种相对高效的半同步/半异步模式,它的每个工作线程都能同时处理多个客户连接:

上图中,主线程只管理监听socket,连接socket由工作线程来管理,当有新连接到来时,主线程就接受之并将新返回的连接socket派发给某个工作线程,此后该新socket上的任何IO操作都由被选中的工作线程来处理,直到客户关闭连接。主线程往工作线程派发socket的最简单方式,是往它和工作线程之间的管道里写数据,工作线程检测到管道上有数据可读时,就分析是否是一个新客户连接请求到来,如果是,就把新socket上的读、写事件注册到自己的epoll内核事件表中。

可见,上图中每个线程(主线程和工作线程)都维持自己的事件循环,它们各自独立地监听不同的事件,因此,在这种高效的半同步/半异步模式中,每个线程都工作在异步模式,所以它并非严格意义上的半同步/半异步模式。

8.5.2 领导者/追随者模式

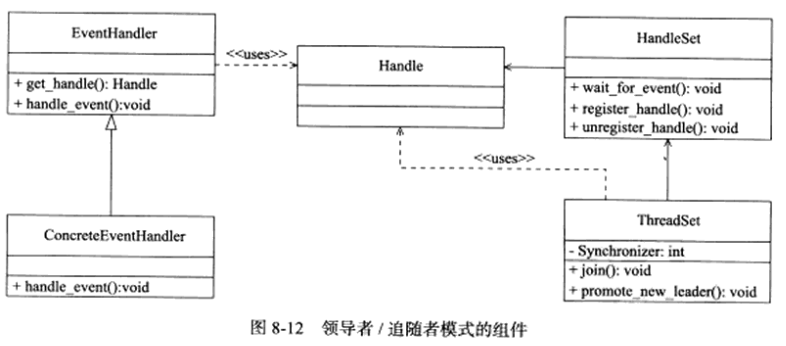

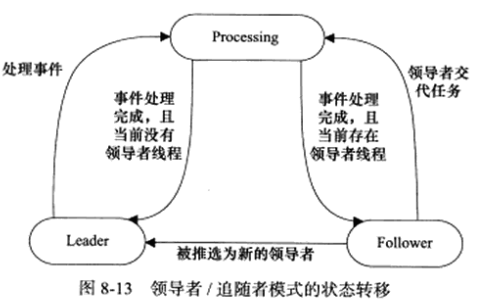

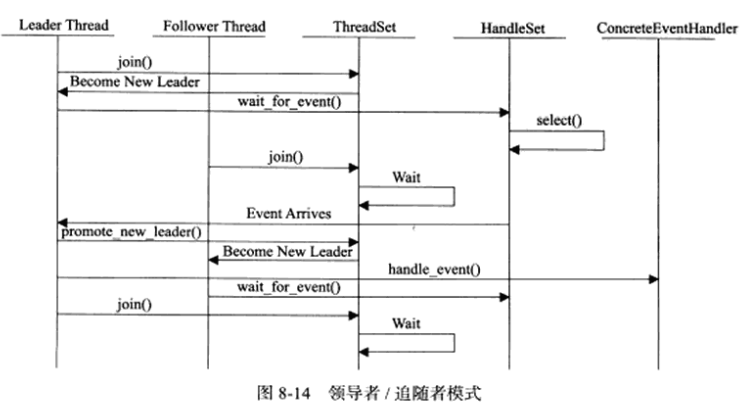

领导者/追随者模式是多个工作线程轮流获得事件源集合,轮流监听、分发并处理事件的一种模式。在任意时间点,程序都仅有一个领导者线程,它负责监听IO事件,而其他线程都是追随者,他们休眠在线程池中等待成为新领导者。当前的领导者如果检测到IO事件,首先从线程池中推选出新的领导者线程,然后处理IO事件,此时,新的领导者等待新的IO事件,而原来的领导者则处理IO事件,两者实现了并发。

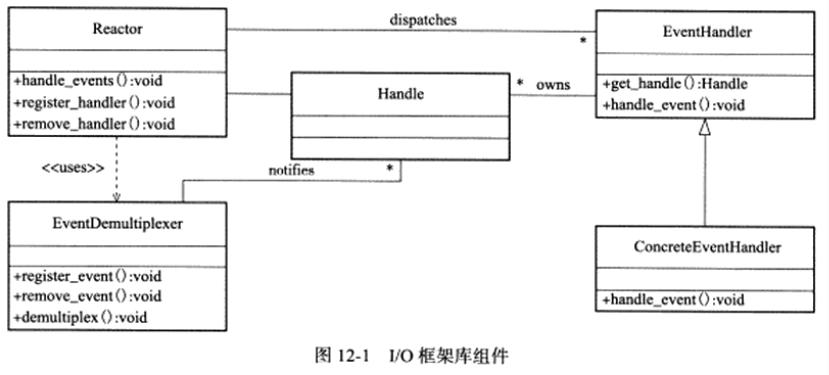

领导者/追随者模式包含以下几个组件:句柄集(HandleSet)、线程集(ThreadSet)、事件处理器(EventHandler)、具体的事件处理器(ConcreteEventHandler),它们的关系见下图:

-

1.句柄集:句柄(Handle)用于表示IO资源,在Linux下通常是一个文件描述符。句柄集管理众多句柄,它使用wait_for_event方法来监听这些句柄上的IO事件,并将其中的就绪事件通知给领导者线程。领导者则调用绑定到Handle上的事件处理器来处理事件。领导者将Handle和事件处理器绑定是通过register_handle方法实现的。

-

2.线程集:这个组件是所有工作线程(包括领导者线程和追随者线程)的管理者。它负责各线程之间的同步,以及新领导者线程的推选。线程集中的线程在任一时间必处于以下三种状态之一:

-

(1)Leader:线程当前处于领导者身份,负责等待句柄集上的IO事件。

-

(2)Processing:线程正在处理事件。领导者检测到IO事件之后,可以转移到Processing状态来处理该事件,并调用promote_new_leader方法推选新的领导者;也可以指定其他追随者来处理事件(Event Handoff),此时领导者的地位不变。当处于Processing状态的线程处理完事件后,如果当前线程中没有领导者,则它将成为新的领导者,否则它直接转变为追随者。

-

(3)Follower:线程当前处于追随者身份,通过调用线程集的join方法等待成为新领导者,也可能被当前的领导者指定来处理新任务。

-

-

-

3.事件处理器和具体的事件处理器:通常包含一个或多个回调函数handle_event,这些回调函数用于处理事件对应的业务逻辑。事件处理器在使用前需要被绑定到某个句柄上,当该句柄上有事件发生时,领导者就执行与之绑定的事件处理器中的回调函数。具体的事件处理器是事件处理器的派生类,它们必须重新实现基类的handle_event方法,以处理特定的任务。

-

由于领导者线程自己监听IO事件并处理客户请求,因此领导者/追随者模式不需要在线程之间传递任何额外数据,也无须像半同步/半反应堆模式那样在线程之间同步对请求队列的访问。但领导者/追随者的一个缺点是无法让每个工作线程像图8-11那样独立管理多个客户连接。

8.6 有限状态机

接下来介绍一种逻辑单元内部的高效编程方法:有限状态机(finite state machine)。

有的应用层协议头部包含数据包类型字段,每种类型可以映射为逻辑单元的一种执行状态,服务器可根据它来编写相应的处理逻辑:

STATE_MACHINE (Package _pack) {

PackageType _type = _pack.GetType();

switch (_type) {

case type_A:

process_package_A(_pack);

break;

case type_B:

process_package_B(_pack);

break;

}

}

上例代码就是一个简单的有限状态机,只不过该状态机的每个状态都是相互独立的,即状态之间没有相互转移。状态之间的转移需要状态机内部驱动:

STATE_MACHINE() {

State cur_State = type_A;

while (cur_State != type_C) {

Package _pack = getNewPackage();

switch (cur_State) {

case type_A:

process_package_state_A(_pack);

cur_State = type_B;

break;

case type_B:

process_package_state_B(_pack);

cur_State = type_C;

break;

}

}

}

该状态机包含三种状态:type_A、type_B、type_C,其中type_A是状态机的开始状态,type_C是状态机的结束状态。状态机的当前状态记录在cur_State变量中。在一次循环中,状态机先通过getNewPackage方法获得一个新数据包,然后根据cur_State变量的值判断如何处理该数据包,数据包处理完后,状态机通过给cur_State变量传递目标状态值来实现状态转移,那么当状态机进入下一次循环时,它将执行新的状态对应的逻辑。

下面考虑有限状态机的一个实例:HTTP请求的读取和分析。

很多网络协议,包括TCP和IP协议,都在首部中提供首部长度字段,程序根据该字段的值就可知道是否接收到一个完整的协议头部。但HTTP协议没有这样的头部长度字段,且其头部长度变化也很大,可以只有十几字节,也可以有上百字节。根据HTTP协议,我们判断HTTP头部结束的依据是遇到一个空行,该空行仅包含一对回车换行符()。如果一次读操作没有读入HTTP请求的整个头部,即没有遇到空行,那么我们必须等待客户继续写数据并再次读入。因此,我们每完成一次读操作,就要分析新读入的数据中是否有空行。但在寻找空行的过程中,我们可以同时完成对整个HTTP头的分析,以提高解析HTTP请求的效率。以下代码使用主、从两个有限状态机实现了最简单的HTTP请求的读取和分析:

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <libgen.h>

#define BUFFER_SIZE 4096

// 主状态机有两种状态,当前正在分析请求行(HTTP请求头部的第一行)、当前正在分析头部字段

enum CHECK_STATE {CHECK_STATE_REQUESTLINE = 0, CHECK_STATE_HEADER};

// 从状态机有三种状态,用来表示行的读取状态,分别表示读到一个完整行、行出错、行数据尚不完整

enum LINE_STATUS {LINE_OK = 0, LINE_BAD, LINE_OPEN};

// 服务器处理HTTP请求的结果:

// NO_REQUEST:请求不完整,需要继续读取客户数据

// GET_REQUEST:获得了一个完整的客户请求

// BAD_REQUEST:客户请求有语法错误

// FORBIDDEN_REQUEST:客户对资源没有足够的访问权限

// INTERNAL_ERROR:服务器内部错误

// CLOSED_CONNECTION:客户已经关闭连接

enum HTTP_CODE {NO_REQUEST, GET_REQUEST, BAD_REQUEST, FORBIDDEN_REQUEST, INTERNAL_ERROR,

CLOSED_CONNECTION};

// 为简化问题,我们不给客户发送一个完整的HTTP应答报文,而是根据服务器的处理结果发送如下成功或失败信息

static const char *szret[] = {"I get a correct result\n", "Something wrong\n"};

// 解析出首部中一行的内容,返回值是从状态机的一个状态

LINE_STATUS parse_line(char *buffer, int &checked_index, int &read_index) {

char temp;

// checked_index指向buffer(用户的读缓冲区)中当前正在分析的字节,read_index指向buffer中客户数据的尾后字节

// buffer中第0~checked_index字节都已分析完毕,第checked_index~read_index-1字节由以下循环逐个分析

for (; checked_index < read_index; ++checked_index) {

// 获得当前要分析的字节

temp = buffer[checked_index];

// 如果当前分析的字节是\r,即回车符,则说明可能读到了一个完整行

if (temp == '\r') {

// 如果\r字符是目前buffer中最后一个读到的客户数据,则此次分析没有读到一个完整行

// 返回LINE_OPEN表示还要继续读取客户数据才能进一步分析

if ((checked_index + 1) == read_index) {

return LINE_OPEN;

// 如果下一个字符是\n,说明我们成功读到一个完整的行

} else if (buffer[checked_index + 1] == '\n') {

buffer[checked_index++] = '\0';

buffer[checked_index++] = '\0';

return LINE_OK;

}

// 否则说明客户发送的HTTP请求存在语法问题(这意味着除了每行结尾,行内不能出现\r)

return LINE_BAD;

// 如果当前的字节是\n,即换行符,则说明可能读到一个完整的行

} else if (temp == '\n') {

// 如果有前一个字符,且前一个字符是\r,说明读到了一个完整的行

if ((checked_index > 1) && buffer[checked_index - 1] == '\r') {

buffer[checked_index - 1] = '\0';

buffer[checked_index++] = '\0';

return LINE_OK;

}

// 否则说明客户发送的HTTP请求存在语法问题(这意味着除了每行结尾,行内不能出现\n)

return LINE_BAD;

}

}

// 如果没有遇到\r或\n,则返回LINE_OPEN,表示还需继续读取客户数据才能进一步分析

return LINE_OPEN;

}

// 分析请求行(HTTP头部中的第一行)

// 一个请求行的例子:GET http://www.a.com/index.html HTTP/1.0

HTTP_CODE parse_requestline(char *temp, CHECK_STATE &checkstate) {

// strpbrk函数在一个字符串中查找第一个匹配指定字符集合中任何字符的位置

char *url = strpbrk(temp, " \t");

// 如果请求行中没有\t或空格,则HTTP请求有语法错误

if (!url) {

return BAD_REQUEST;

}

// 此处将上例中,GET后的空格或\t改为了\0,并将url指向了http::的h

*url++ = '\0';

char *method = temp;

// 如果不是GET请求,当成语法错误处理

if (strcasecmp(method, "GET") == 0) {

printf("The request method is GET\n");

} else {

return BAD_REQUEST;

}

// strspn函数用于计算一个字符串中连续包含在另一个字符串中的字符的长度

// 此处是为了跳过上例中的GET和http::之间的多个空格或\t

url += strspn(url, " \t");

char *version = strpbrk(url, " \t");

if (!version) {

return BAD_REQUEST;

}

// 此处将上例中url和HTTP版本之间的空格或\t换成\0

*version++ = '\0';

// 防止url和HTTP版本之间有多个空格或\t

version += strspn(version, " \t");

// 只处理HTTP/1.1版本

if (strcasecmp(version, "HTTP/1.1") != 0) {

return BAD_REQUEST;

}

// 检查url是否以http://开头

if (strncasecmp(url, "http://", 7) == 0) {

// 将url指向上例中的www的第一个w

url += 7;

// strchr函数用于在一个字符串中查找指定字符的第一次出现的位置,并返回该位置的指针

// 这里将url指向上例中的www.a.com/index.html中的/

url = strchr(url, '/');

}

if (!url || url[0] != '/') {

return BAD_REQUEST;

}

printf("The request URL is: %s\n", url);

// 读完请求行,将从状态机改为CHECK_STATE_HEADER,表示接下来分析头部字段

checkstate = CHECK_STATE_HEADER;

// 继续读更多数据

return NO_REQUEST;

}

// 分析头部字段

HTTP_CODE parse_headers(char *temp) {

// 遇到一个空行,说明我们得到了正确的HTTP请求,返回GET_REQUEST表示我们获得了一个完整的客户请求

// 在读取一行数据时,我们把该行中所有\r\n都改成了\0

if (temp[0] == '\0') {

return GET_REQUEST;

// 处理HOST头部字段

} else if (strncasecmp(temp, "Host:", 5) == 0) {

temp += 5;

// 跳过冒号后的一个或多个空格或\t

temp += strspn(temp, " \t");

printf("the request host is: %s\n", temp);

// 其他头部字段不处理

} else {

printf("I can not handle this header\n");

}

// 没有遇到空行,返回NO_REQUEST表示请求不完整,需要继续读取客户数据

return NO_REQUEST;

}

// 分析HTTP请求的入口函数

HTTP_CODE parse_content(char *buffer, int &checked_index, CHECK_STATE &checkstate,

int &read_index, int &start_line) {

LINE_STATUS linestatus = LINE_OK;

HTTP_CODE retcode = NO_REQUEST;

// 如果读到了一整行

while ((linestatus = parse_line(buffer, checked_index, read_index)) == LINE_OK) {

// start_line是当前行的起始位置

char *temp = buffer + start_line;

// 更新下一行的起始位置

start_line = checked_index;

// checkstate是主状态机当前的状态

switch (checkstate) {

// 分析请求行

case CHECK_STATE_REQUESTLINE:

{

retcode = parse_requestline(temp, checkstate);

// 语法错误

if (retcode == BAD_REQUEST) {

return BAD_REQUEST;

}

break;

}

// 分析头部字段

case CHECK_STATE_HEADER:

{

retcode = parse_headers(temp);

// 语法错误

if (retcode == BAD_REQUEST) {

return BAD_REQUEST;

// 已读到完整HTTP请求

} else if (retcode == GET_REQUEST) {

return GET_REQUEST;

}

break;

}

default:

{

return INTERNAL_ERROR;

}

}

}

// 如果没有读到完整行,表示还需继续读取客户数据才能进一步分析

if (linestatus == LINE_OPEN) {

return NO_REQUEST;

// 既没有读到完整行,也没有返回继续读取数据,说明返回了LINE_BAD(语法错误)

} else {

return BAD_REQUEST;

}

}

int main(int argc, char *argv[]) {

if (argc < 2) {

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int listenfd = socket(PF_INET, SOCK_STREAM, 0);

assert(listenfd >= 0);

int ret = bind(listenfd, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(listenfd, 5);

assert(ret != -1);

struct sockaddr_in client_address;

socklen_t client_addrlength = sizeof(client_address);

int fd = accept(listenfd, (struct sockaddr *)&client_address, &client_addrlength);

if (fd < 0) {

printf("errno is: %s\n", errno);

} else {

char buffer[BUFFER_SIZE];

memset(buffer, '\0', BUFFER_SIZE);

int data_read = 0;

int read_index = 0; // 当前已读了多少客户数据

int checked_index = 0; // 当前已经分析完了多少字节的客户数据

int start_line = 0; // 行在buffer中的起始位置

// 将主状态机状态设置为读请求行

CHECK_STATE checkstate = CHECK_STATE_REQUESTLINE;

while (1) { // 循环读取客户数据并分析

data_read = recv(fd, buffer + read_index, BUFFER_SIZE - read_index, 0);

if (data_read == -1) {

printf("reading failed\n");

break;

} else if (data_read == 0) {

printf("remote client has closed the connection\n");

break;

}

read_index += data_read;

// 分析当前读取的数据

HTTP_CODE result = parse_content(buffer, checked_index, checkstate, read_index,

start_line);

// 尚未得到完整的HTTP请求,接着读

if (result == NO_REQUEST) {

continue;

// 得到了一个完整的、正确的HTTP请求

} else if (result == GET_REQUEST) {

send(fd, szret[0], strlen(szret[0]), 0);

break;

// 其他情况表示发生错误

} else {

send(fd, szret[1], strlen(szret[1]), 0);

break;

}

}

close(fd);

}

close(listenfd);

return;

}

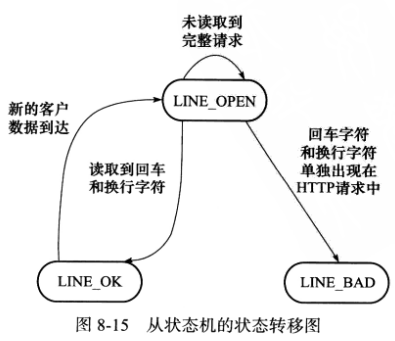

以上代码中有两个有限状态机,分别称其为主状态机和从状态机,主状态机在内部调用从状态机。先分析从状态机,即parse_line函数,它从buffer中解析出一个行,下图是它可能的状态和状态转移过程:

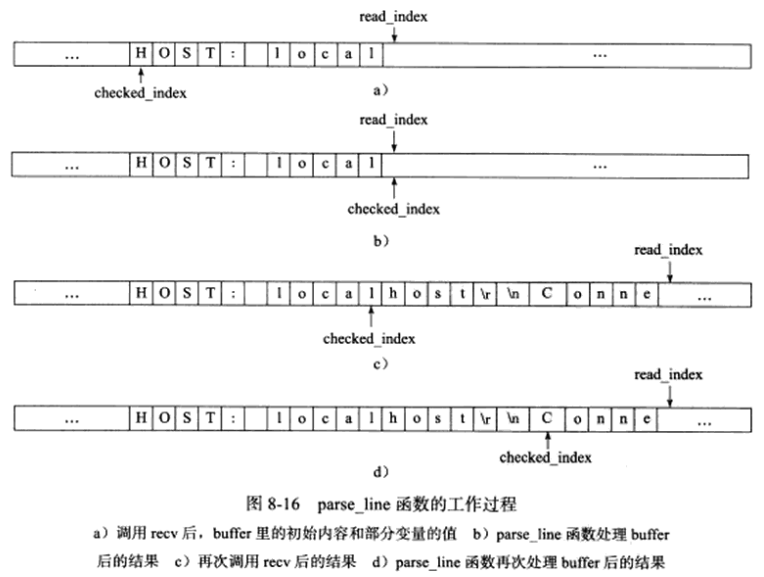

从状态机的初始状态是LINE_OK,其原始驱动力来自于buffer中新到达的客户数据。在main函数中,我们循环调用recv函数往buffer中读入客户数据,每次成功读取数据后,就调用parse_content分析新读入的数据,parse_content函数首先要做的就是调用parse_line来获取一个行,假设服务器经过一次recv调用后,buffer的内容和部分变量的值如图8-16a所示:

parse_line函数处理后的结果如图8-16b所示,它挨个检查图8-16a所示的buffer中checked_index到read_index-1之间的字节,判断是否存在行结束符,并更新checked_index的值,当前buffer中不存在行结束符,因此parse_line函数返回LINE_OPEN。接下来,程序继续调用recv读取更多客户数据,这次读操作后buffer中的内容和部分变量的值如图8-16c所示,然后parse_line函数处理这部分新到的数据,如图8-16d所示,这次它读到了一个完整的行,即HOST: localhost\r\n,此时,parse_line函数就可以将这行内容递交给parse_content函数中的主状态机来处理了。

8.7 提高服务器性能的其他建议

由于硬件技术飞速发展,现代服务器都不缺乏硬件资源,因此,我们需要考虑如何从软环境来提升服务器性能,服务器软环境一方面指系统的软件资源,如操作系统允许用户打开的最大文件描述符数量,另一方面指服务器程序本身,即如何从编程角度确保服务器的性能。

8.7.1 池

池的概念就是这样,池是一组资源的集合,这组资源在服务器启动的时候就被完全创建好并初始化,这称为静态资源分配。

当服务器进入正式运行阶段,即开始处理客户请求的时候,如果它需要相关资源,就可以直接从池中获取,无须动态分配。显然,直接从池中获取所需资源比动态分配资源的速度要快得多,因为分配系统资源的系统调用都是很耗时的。当服务器处理完一个客户连接后,可以把相关资源放回池中,无须执行系统调用来释放资源。从最终效果看,池相当于服务器管理系统资源的应用层设施,它避免了服务器对内核的频繁访问。

但既然池中的资源是预先静态分配的,我们无法预期应分配多少资源,这个问题的解决办法就是分配足够多的资源,即针对每个可能的客户连接都分配必要的资源,这通常会导致资源的浪费,因为任一时刻的客户数量都可能远远没有达到服务器能支持的最大客户数量,好在这种资源的浪费对服务器来说一般不会构成问题。还有一种解决方案是预先分配一定的资源,此后如果发现资源不够用,就再动态分配一些并加入池中。

根据不同的资源类型,池可分为多种,常见的有内存池、进程池、线程池、连接池。

内存池通常用于socket的接收缓存和发送缓存,对于某些长度有限的客户请求,如HTTP请求,预先分配一个大小足够的接收缓存区是合理的。当客户请求超过接收缓冲区大小时,我们可以选择丢弃请求或动态扩大接收缓冲区。

进程池和线程池在并发编程中很常用,当我们需要一个工作进程或工作线程来处理新到来的客户请求时,我们可以直接从进程池或线程池中取得一个执行实体,而无须动态调用fork或pthread_create等函数来创建进程或线程。

连接池通常用于服务器或服务器机群的内部永久连接,图8-4中,每个逻辑单元可能都需要频繁访问本地的某个数据库,简单做法是,逻辑单元每次需要访问数据库时,就向数据库进程发起连接,而访问完后释放连接,显然这样做效率太低,一种解决方案是使用连接池,连接池是服务器预先和数据库进程建立的一组连接的集合,当某个逻辑单元需要访问数据库时,它可以从连接池中取得一个连接的实体并使用之,待完成数据库的访问后,逻辑单元再将该连接返还给连接池。

8.7.2 数据复制

高性能服务器应避免不必要的数据复制,尤其是当数据复制发生在用户代码和内核之间的时候。如果内核可以直接处理从socket或文件读入的数据,则应用进程就没必要将这些数据从内核缓冲区复制到应用缓冲区中。

此处的直接处理指的是应用进程不关心这些数据的内容,不需要对它们做任何分析,如ftp服务器,当客户请求一个文件时,服务器只需检测目标文件是否存在,以及客户是否有读取它的权限,而不会关心文件的具体内容,因此ftp服务器就无须把目标文件的内容完整读入应用进程缓冲区中,并调用send来发送,而是可以使用零拷贝函数sendfile来直接将其发送给客户端。

此外,用户代码内部(不访问内核)的数据复制也应避免,例如,当两个工作进程之间要传递大量数据时,我们应考虑使用共享内存在它们之间直接共享这些数据,而不是使用管道或消息队列来传递,又比如我们可用指针来指出数据的位置,以便随后对该位置的内容进行访问,而不是把内容复制到另一个缓冲区中来使用,这样既浪费空间,又效率低下。

8.7.3 上下文切换和锁

并发程序必须考虑上下文切换(context switch)问题,即进程切换或线程切换导致的系统开销。不应使用过多工作进程(线程),否则进程(线程)间的切换将占用大量CPU时间,服务器真正用于处理业务逻辑的CPU时间的比重就会变小。

并发编程需要考虑的另一个问题是共享资源的加锁保护,锁通常被认为是导致服务器效率低下的一个因素,因为由锁引入的代码不仅不处理任何业务逻辑,而且需要访问内核资源,因此,如果服务器有更好的解决方案,就应该避免使用锁。显然图8-11所描述的半同步/半异步模式就比图8-10所描述的半同步/半反应堆模式的效率高。如果服务器必须使用锁,则可以考虑减小锁的粒度,如使用读写锁,当所有工作线程只读取一块共享内存的内容时,读写锁并不会增加系统的额外开销,只有当一个工作线程需要写这块内存时,系统才必须去锁住这块区域。

第9章 IO复用

IO复用使程序能同时监听多个文件描述符,这可以提高程序的性能,通常网络程序在以下情况需要使用IO复用:

-

1.客户端进程需要同时处理多个socket。

-

2.客户端进程需要同时处理用户输入和网络连接。

-

3.TCP服务器要同时处理监听socket和连接socket。

-

4.服务器要同时处理TCP请求和UDP请求。

-

5.服务器要同时监听多个端口,或处理多种服务,如xinetd服务器。

IO复用能同时监听多个文件描述符,但它本身是阻塞的,且当多个文件描述符同时就绪时,如果不采取额外措施,进程只能按顺序依次处理其中的每个文件描述符,这使得服务器看起来像是串行工作的,如果要实现并发,只能用多进程或多线程等编程手段。

Linux下实现IO复用的系统调用主要有select、poll、epoll。

9.1 select系统调用

select系统调用的用途是:在一段指定时间内,监听用户感兴趣的文件描述符上的可读、可写、异常事件。

9.1.1 select API

select 系统调用的原型如下:

#include <sys/select.h>

// nfds 指定被监听的文件描述符的总数,通常是监听的所有文件描述符中的最大值加1

// readfds, writefds, exceptfds 分别指向可读、可写和异常等事件对应的文件描述符集合

// timeout 设置 select 函数的超时时间,0 立即返回,NULL 一直阻塞

int select(int nfds, fd_set* readfds, fd_set* writefds, fd_set* exceptfds, struct timeval* timeout);

// fd_set 结构体仅包含一个整形数组,该数组的每个元素的每一位 bit 标记一个文件描述符,容纳数量由 FD_SETSIZE 指定

FD_ZERO(fd_set* fdset); // 清除 fdset 的所有位

FD_SET(int fd, fd_set *fdset); // 设置 fdset 的位 fd

FD_CLR(int fd, fd_set *fdset); // 清除 fdset 的位 fd

int FD_ISSET(int fd, fd_set *fdset); // 测试 fdset 的位 fd 是否被设置

struct timeval

{

long tv_sec; // 秒数

long tv_usec; // 微秒数

}

9.1.2 文件描述符就绪条件

在网络编程中,以下情况认为socket可读:

-

1.socket内核接收缓存区中的字节数大于其低水位标记SO_RCVLOWAT,此时我们可以无阻塞地读该socket,且读操作返回的字节数大于0。

-

2.socket通信的对方关闭连接,此时对该socket的读操作将返回0。

-

3.监听socket上有新的连接请求。

-

4.socket上有未处理的错误,此时我们可用getsockopt函数来读取和清除该错误。

以下情况认为socket可写:

-

1.socket内核发送缓存区中的可用字节数大于或等于其低水位标记SO_SNDLOWAT,此时我们可以无阻塞地写该socket,且写操作返回的字节数大于0。

-

2.socket的写操作被关闭,对写操作被关闭的socket执行写操作将触发SIGPIPE信号。

-

3.socket使用非阻塞connect连接成功或失败(超时)后。

-

4.socket上有未处理的错误,此时我们可用getsockopt函数来读取和清除该错误。

select函数能处理的异常情况只有一种,socket上接收到带外数据。

9.1.3 处理带外数据

socket上接收到普通数据和带外数据都将使select函数返回,以下代码同时处理这两者:

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <stdlib.h>

#include <libgen.h>

int main(int argc, char *argv[]) {

if (argc <= 2) {

printf("usage: %s ip_address port_number\n", basename(argv[0]));

return 1;

}

const char *ip = argv[1];

int port = atoi(argv[2]);

int ret = 0;

struct sockaddr_in address;

bzero(&address, sizeof(address));

address.sin_family = AF_INET;

inet_pton(AF_INET, ip, &address.sin_addr);

address.sin_port = htons(port);

int listenfd = socket(PF_INET, SOCK_STREAM, 0);

assert(listenfd >= 0);

ret = bind(listenfd, (struct sockaddr *)&address, sizeof(address));

assert(ret != -1);

ret = listen(listenfd, 5);

assert(ret != -1);

struct sockaddr_in client_address;

socklen_t client_addrlength = sizeof(client_address);

int connfd = accept(listenfd, (struct sockaddr *)&client_address, &client_addrlength);

if (connfd < 0) {

printf("errno is: %d\n", errno);

close(listenfd);

}

char buf[1024];

fd_set read_fds;

fd_set exception_fds;

FD_ZERO(&read_fds);

FD_ZERO(&exception_fds);

while (1) {

memset(buf, '\0', sizeof(buf));

FD_SET(connfd, &read_fds);

FD_SET(connfd, &exception_fds);

ret = select(connfd + 1, &read_fds, NULL, &exception_fds, NULL);

if (ret < 0) {

printf("selection failure\n");

break;

}

if (FD_ISSET(connfd, &read_fds)) {

ret = recv(connfd, buf, sizeof(buf) - 1, 0);

if (ret <= 0) {

break;

}

printf("get %d bytes of normal data: %s\n", ret, buf);

} else if (FD_ISSET(connfd, &exception_fds)) {

ret = recv(connfd, buf, sizeof(buf) - 1, MSG_OOB);

if (ret <= 0) {

break;

}

printf("get %d bytes of oob data: %s\n", ret, buf);

}

}

close(connfd);

close(listenfd);

return 0;

}

9.2 poll系统调用

poll系统调用和select系统调用类似,也是在指定时间内轮询一定数量的文件描述符,以测试其中是否有就绪者.

#include <poll.h>

// fds 参数指定感兴趣的文件描述符上发生的可读、可写和异常事件

// nfds 参数指定被监听事件集合 fds 的大小,实际类型为 unsigned long int

// timeout 指定 poll 的超时值,单位是毫秒,-1 永远阻塞,0 直接返回

// [return] 和 select 一样

int poll(struct pollfd* fds, nfds_t nfds, int timeout);

// pollfd 结构体

struct pollfd

{

int fd; // 文件描述符

short events; // 注册的事件,一系列 POLL 事件的按位或

short revents; // 实际发生的事件,内核填充

}

9.3 epoll系列系统调用

9.3.1 内核事件表

epoll函数是Linux特有的IO复用函数,它在实现和使用上与select、poll函数有很大差异。

首先,epoll函数使用一组函数来完成任务,而非单个函数,其次,epoll函数把用户关心的文件描述符上的事件放在内核里的一个事件表中,从而无须像select和poll函数那样每次调用都要重复传入文件描述符集或事件集。epoll需要使用一个额外的文件描述符,来唯一标识内核中的这个事件表,这个文件描述符使用epoll_create函数来创建。

#include <sys/epoll.h>

// 创建标识内核中的事件表,size 参数并无实际作用

// [return] 返回的 fd 将作为其他所有 epoll 系统调用的第一个参数

int epoll_create(int size);

// 操作内核事件表

// op 参数指定操作类型,由 EPOLL_CTL_ADD|EPOLL_CTL_MOD|EPOLL_CTL_DEL 组成

// fd 参数是要操作的文件描述符

// event 参数指定事件

// [return] 成功 0,失败 -1 并设置 errno

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

struct epoll_event {

_uint32_t events; // epoll 事件,和 poll 类型基本一致

epoll_data_t data; // 用户数据

}

// 联合体,不能同时使用其ptr成员和fd成员

typedef union epoll_data {

void* ptr; // 指向用户定义数据的指针

int fd; //指定要监视的文件描述符

uint32_t u32;

uint64_t u64;

} epoll_data_t;

9.3.2 epoll_wait函数

epoll_wait,它在一段超时时间内等待一组文件描述符上的事件

// timeout 指定超时,

// maxevents 指定最多监听多少个事件

// epoll_wait函数如果检测到事件,就将所有就绪的事件从内核事件表(由epfd参数指定的)中复制到它的第二个参数events指向的数组中,这个数组只用于输出epoll_wait函数检测到的就绪事件,而不像select和poll函数的数组参数那样既用于传入用户注册的事件,又用于输出内核检测到的就绪事件,这样就极大地提高了应用进程索引就绪文件描述符的效率

int epoll_wait(int epfd, struct epoll_event* events, int maxevents, int timeout);

9.3.3 LT和ET模式

epoll对文件描述符的操作有两种模式:LT(Level Trigger,电平触发)模式和ET(Edge Trigger,边沿触发)模式。

- LT:Level Trigger,默认的,epoll_wait 检测到其上有事件发生并将此事件通知应用程序之后,应用程序可以不立即处理该事件,下次调用 epoll_wait 还可以再次向应用程序通告此事件

- ET:Edge Trigger,epoll_wait 检测到就绪事件之后必须处理,效率比 LT 模式要高,需要指定 EPOLLET 事件类型

ET模式降低了同一个epoll事件被重复触发的次数,因此效率比LT模式高。

使用ET模式的文件描述符应该是非阻塞的,如果文件描述符是阻塞的,那么读或写操作将会因为没有后续事件而一直处于阻塞状态。

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <assert.h>

#include <stdio.h>

#include <unistd.h>

#include <errno.h>

#include <string.h>

#include <fcntl.h>

#include <stdlib.h>

#include <sys/epoll.h>

#include <pthread.h>

#include <libgen.h>

#define MAX_EVENT_NUMBER 1024

#define BUFFER_SIZE 10

// 将文件描述符设为非阻塞的

int setnonblocking(int fd) {

int old_option = fcntl(fd, F_GETFL);

int new_option = old_option | O_NONBLOCK;

fcntl(fd, F_SETFL, new_option);

return old_option;

}

// 将文件描述符fd参数上的EPOLLIN注册到epollfd参数指示的内核事件表中

// 参数enable_et指定是否对fd参数启用ET模式

void addfd(int epollfd, int fd, bool enable_et) {

epoll_event event;

event.data.fd = fd;

event.events = EPOLLIN;

if (enable_et) {

event.events |= EPOLLET;

}

epoll_ctl(epollfd, EPOLL_CTL_ADD, fd, &event);

setnonblocking(fd);

}

// LT模式的工作流程

void lt(epoll_event *events, int number, int epollfd, int listenfd) {

char buf[BUFFER_SIZE];

for (int i = 0; i < number; ++i) {

int sockfd = events[i].data.fd;

if (sockfd == listenfd) {

struct sockaddr_in client_address;

socklen_t client_addrlength = sizeof(client_address);

int connfd = accept(listenfd, (struct sockaddr *)&client_address, &client_addrlength);

addfd(epollfd, connfd, false);

} else if (events[i].events & EPOLLIN) {

// 只要socket读缓存中还有未读出的数据,这段代码就被触发

printf("event trigger once\n");

memset(buf, '\0', BUFFER_SIZE);

int ret = recv(sockfd, buf, BUFFER_SIZE - 1, 0);