大模型发展方向

大模型成为发展通用人工智能的重要途径

从专用模型(针对特定任务)→ 通用大模型(多种任务、多种模态通用)

语言模型 → 智能体

语言模型的发展与演进

书生·浦语大模型开源历程

书生·浦语2·0(InternLM2)的体系

2种规格:

- 7B参数:为轻量级研究和应用提供了一个轻便但性能不俗的模型,性价比高

- 20B参数:综合性能更强,支持更复杂的实用场景

每个规格都包含3个模型版本

- InternLM2-Base模型基座:具有很强可塑性的模型基座,进行深度领域适配的高质量起点

- InternLM2:Base基础上,强化了多个能力方向,评测成绩优异,同时保持了很好的通用语言能力,大部分应用中推荐考虑选用

- InternLM2-Chat:Base基础上,经过SFT和RLHF,面向对话交互进行了优化,具有很好的指令遵循、共情聊天和调用工具等的能力

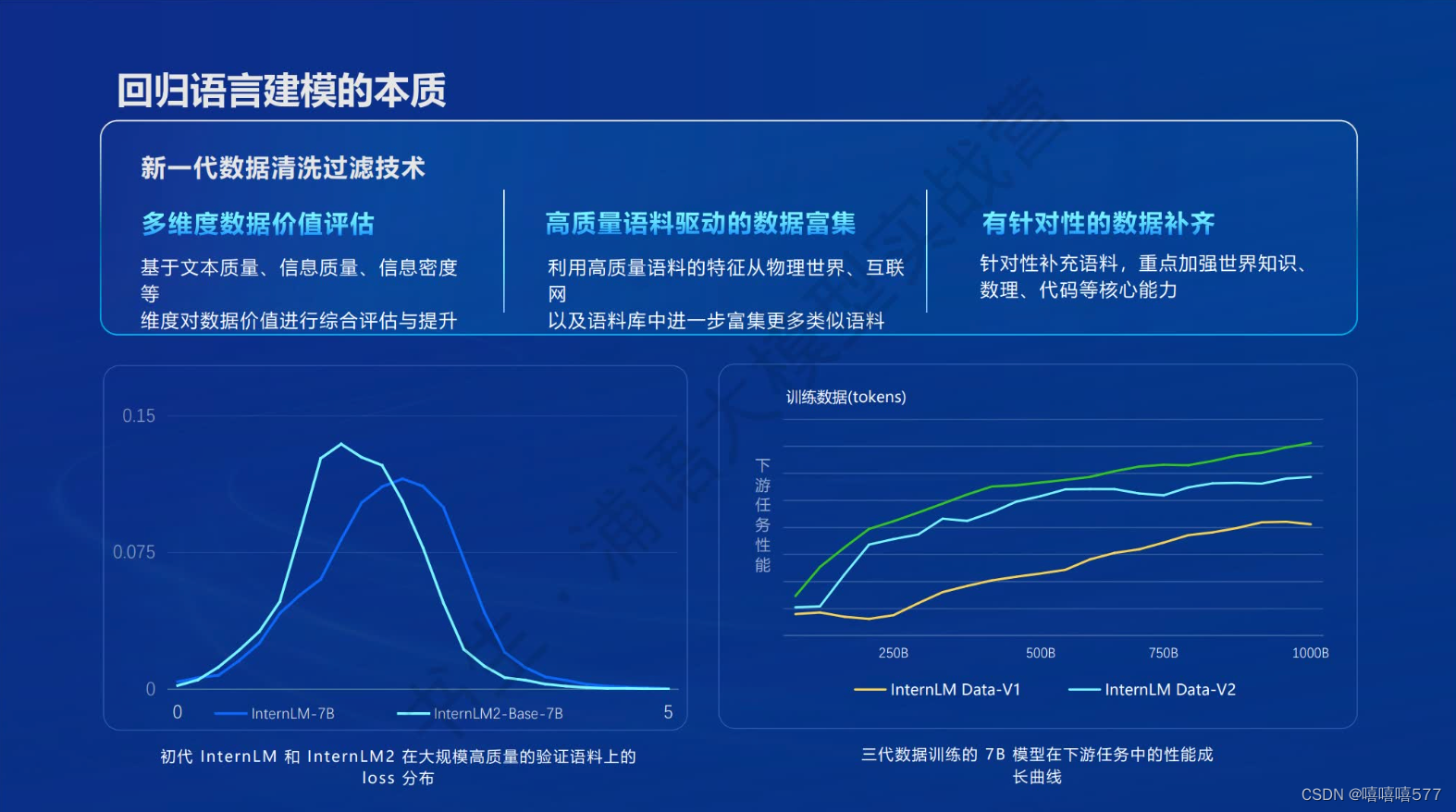

回归语言建模的本质

大语言模型的本质是语言建模,context预测token

InternLM系列采用新一代的数据清洗过滤技术:

多维度数据价值评估 → 高质量语料 → 驱动进行数据富集 → 针对性的数据补齐(强化核心能力)

InternLM2模型的主要亮点

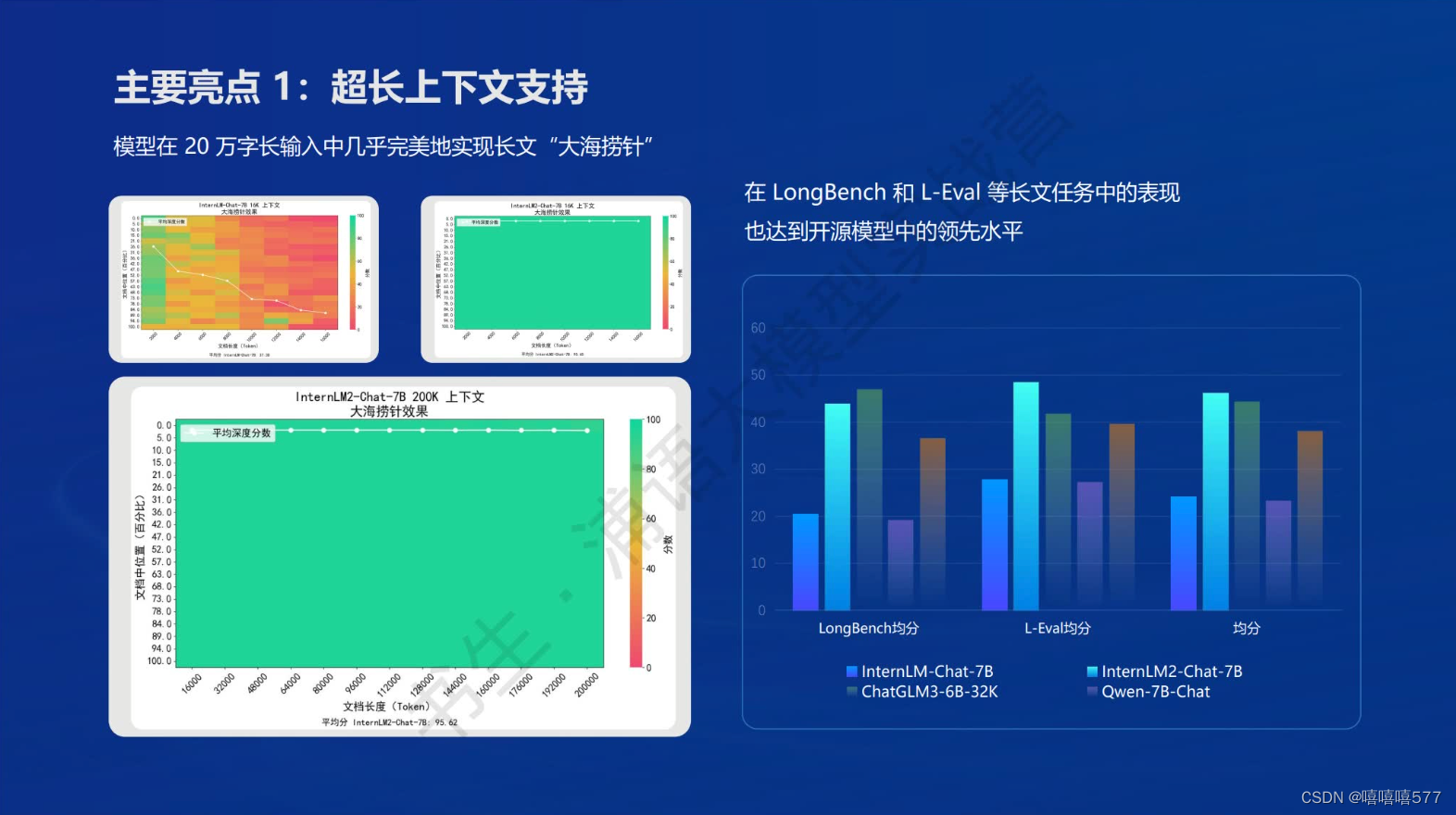

1、输入:支持超长上下文,20万字长输入中完美实现“大海捞针”

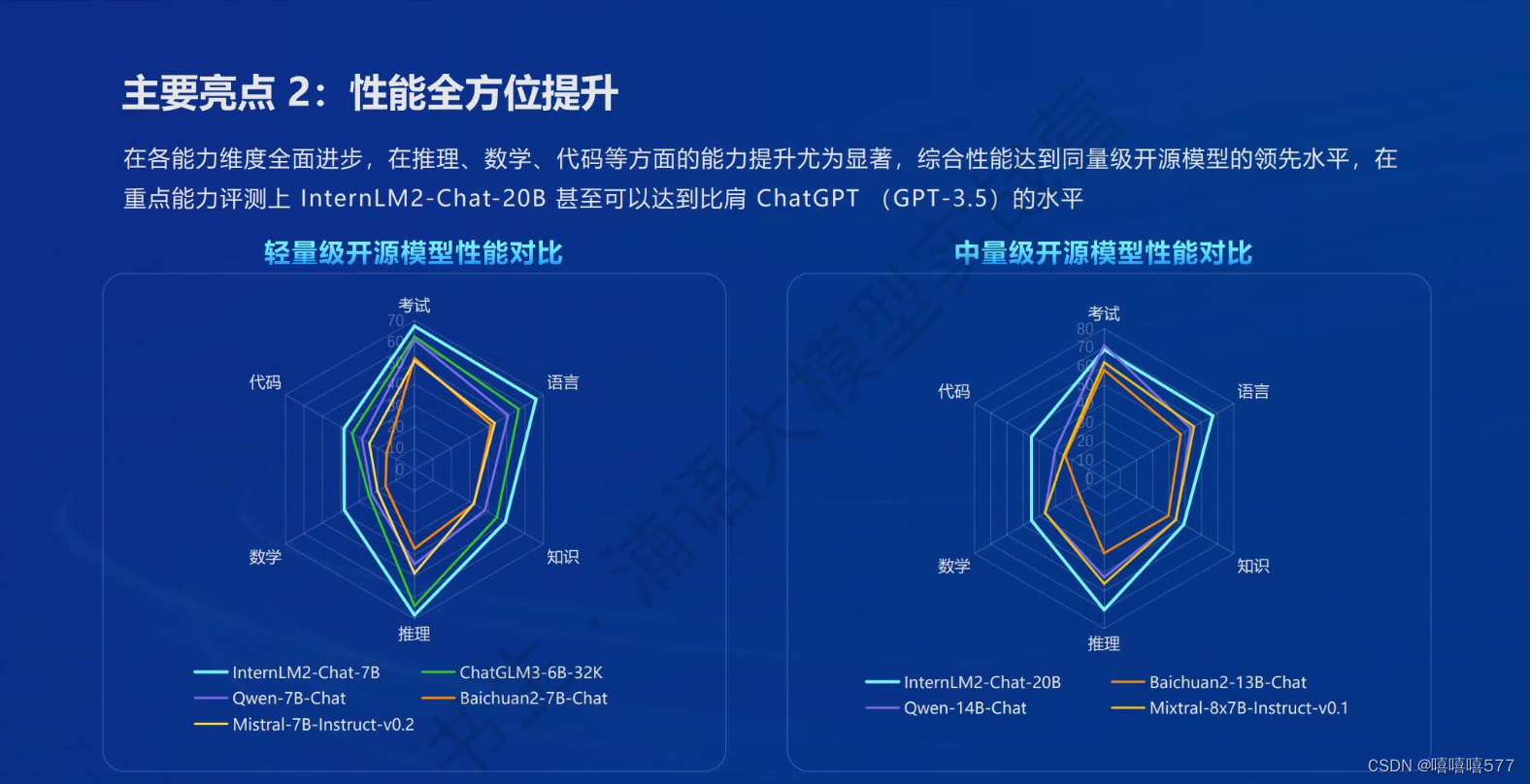

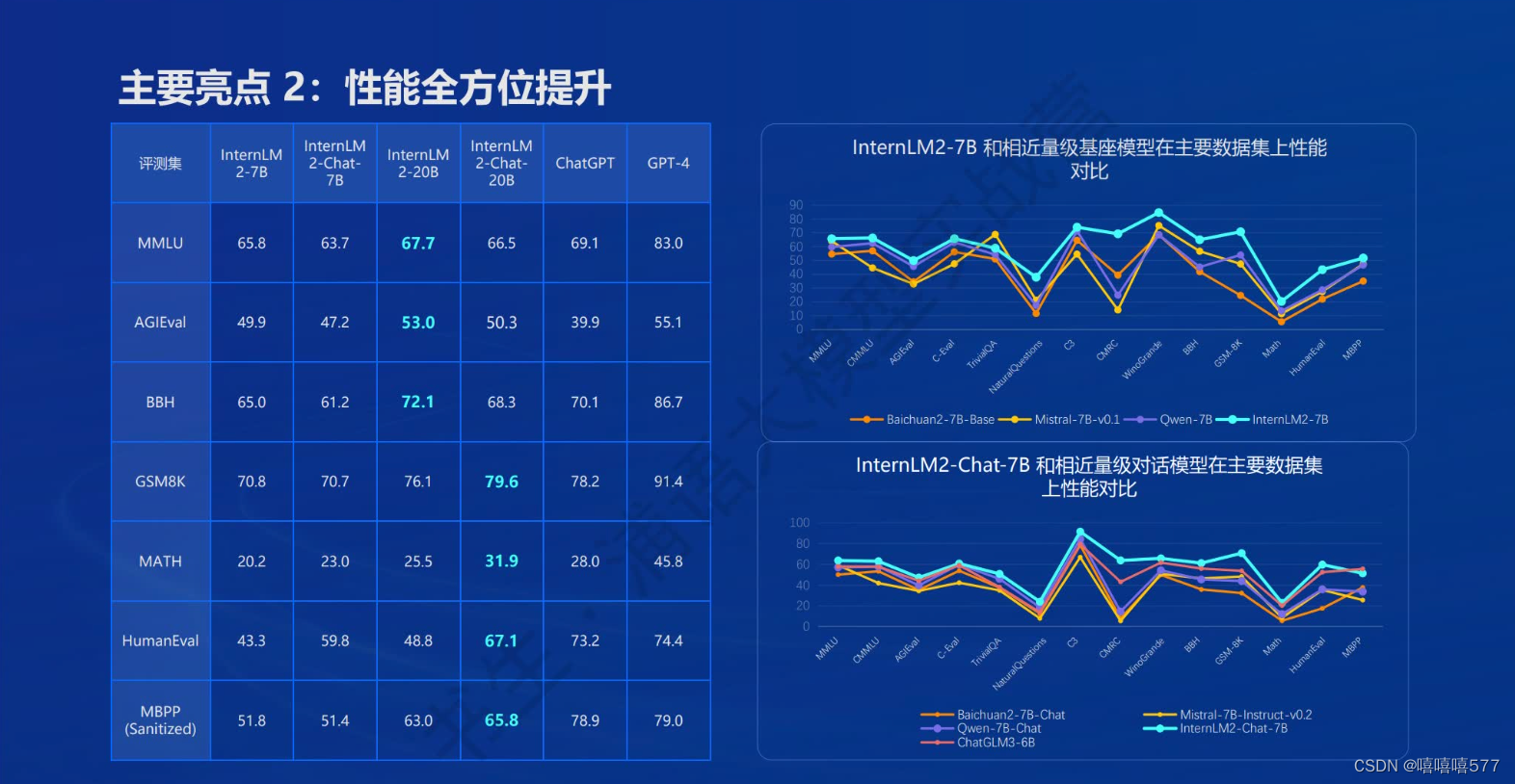

2、性能:综合性能全面提升。尤其是推理、数学、代码等方面能力提升显著,综合性能达到同量级开源模型的领先水平,在重点能力评测上InternLM2-Chat-20B甚至比肩ChatGPT-3.5水平

3、优秀的对话和创作体验

4、工具调用能力整体升级,极大拓展能力边界。通过搜索、计算、代码解释器等获取最新的知识并处理更复杂的问题。InternLM2能更稳定地进行工具筛选和多步骤规划,完成复杂问题。

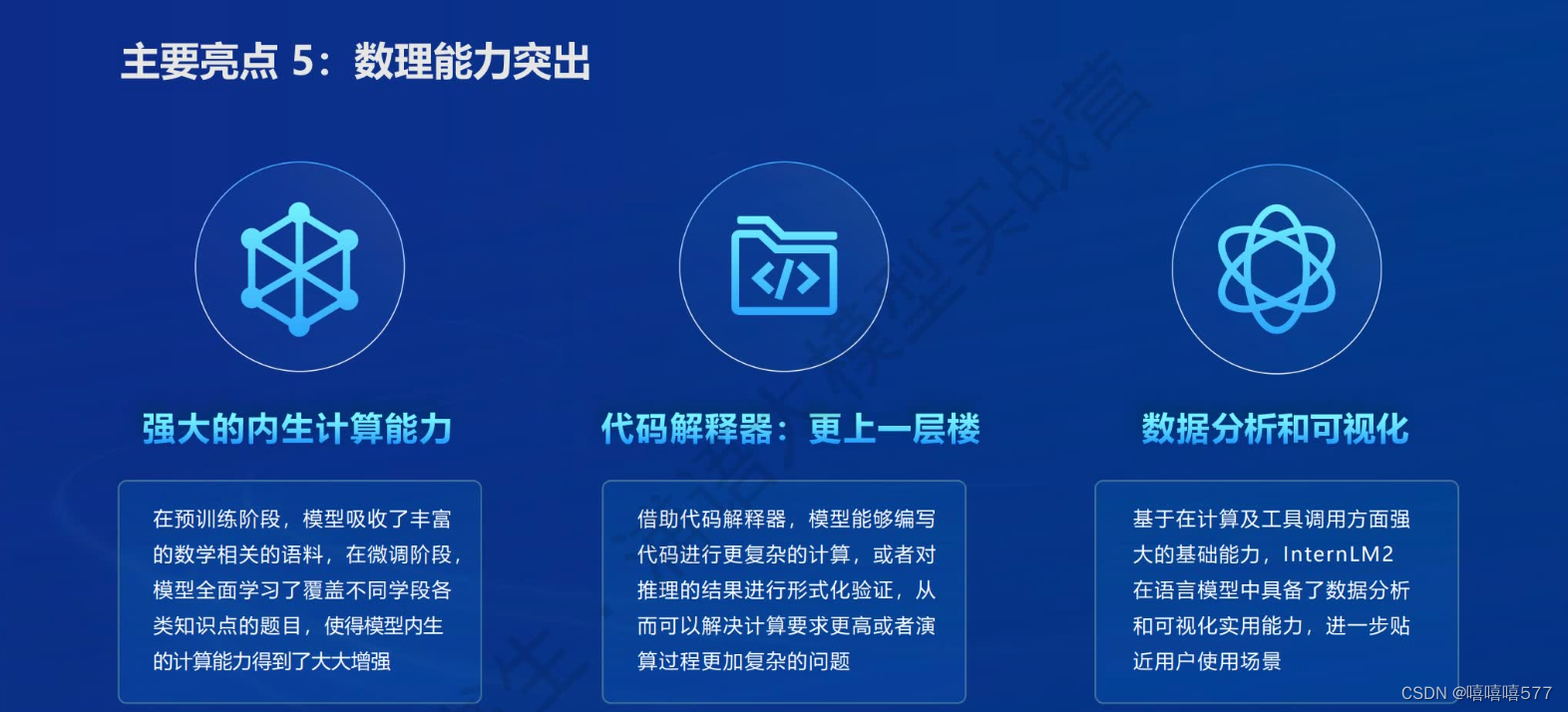

5、实用性,更贴近用户使用场景:突出的数理能力、实用的数据分析功能。

- ①强大的内生计算能力:预训练阶段吸收丰富的数学相关语料,并在微调阶段全面学习各学段各类知识题目。

- ②代码解释器:能编写代码进行更复杂的计算,或对推理的结果进行形式化验证,解决计算要求更高或演算过程更复杂的问题。

- ③数据分析和可视化,进一步贴近用户使用场景:基于计算和工具调用方面的强大基础能力,InternLM语言模型中具备了数据分析和可视化实用能力。

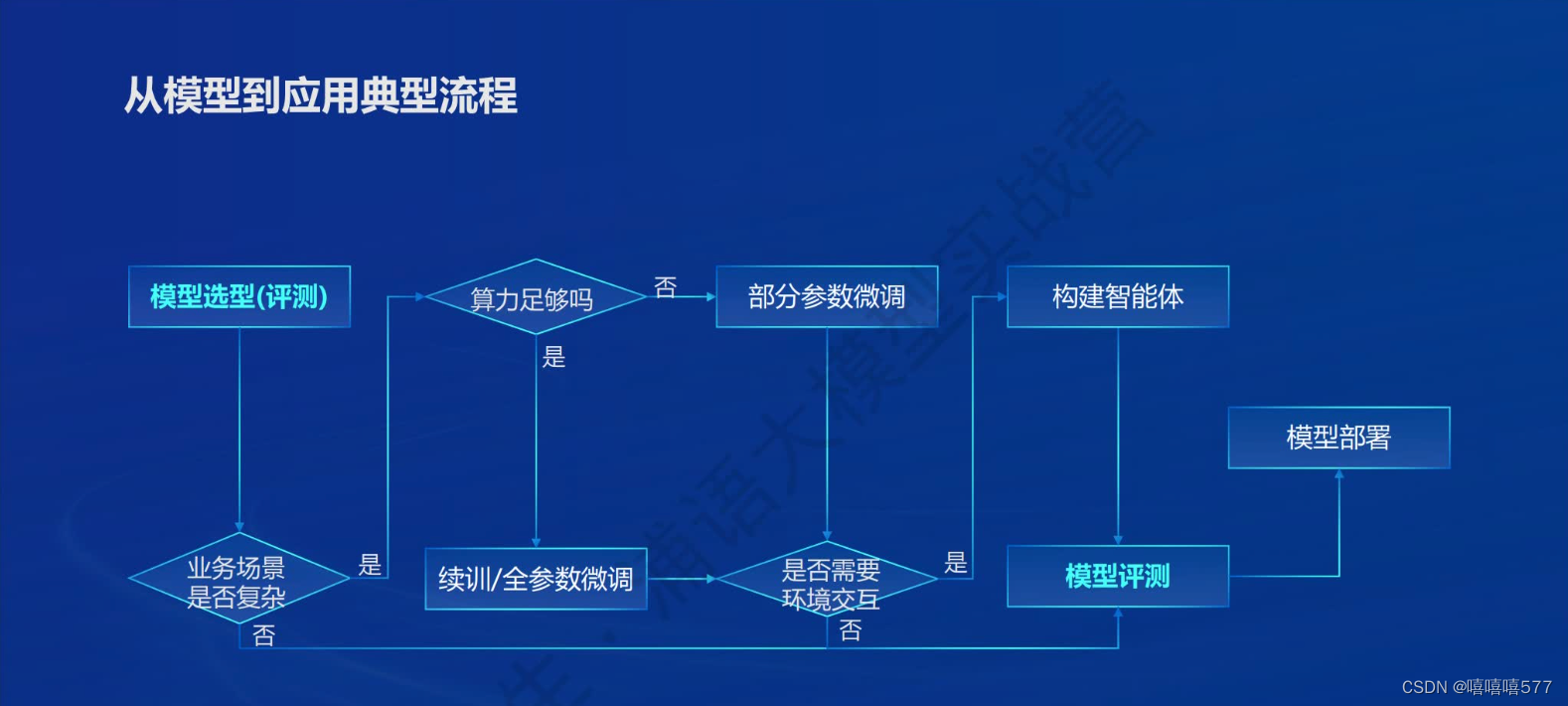

从模型到应用的典型流程

关键节点:

模型选型(评测)、业务场景是否复杂、算力足够否 → 微调方式(部分/全参数/续训) → 是否需要与环境交互(与环境交互→构建智能体)、模型评测、模型部署

书生·浦语全链条开源开放体系

全链路:数据(书生·万卷) → 预训练InternLM-Train → 微调XTuner → 部署LMDeploy → 评测OpenCompass → 应用Lagent AgentLego

- 数据(书生·万卷):2TB数据,涵盖多种模态与任务。

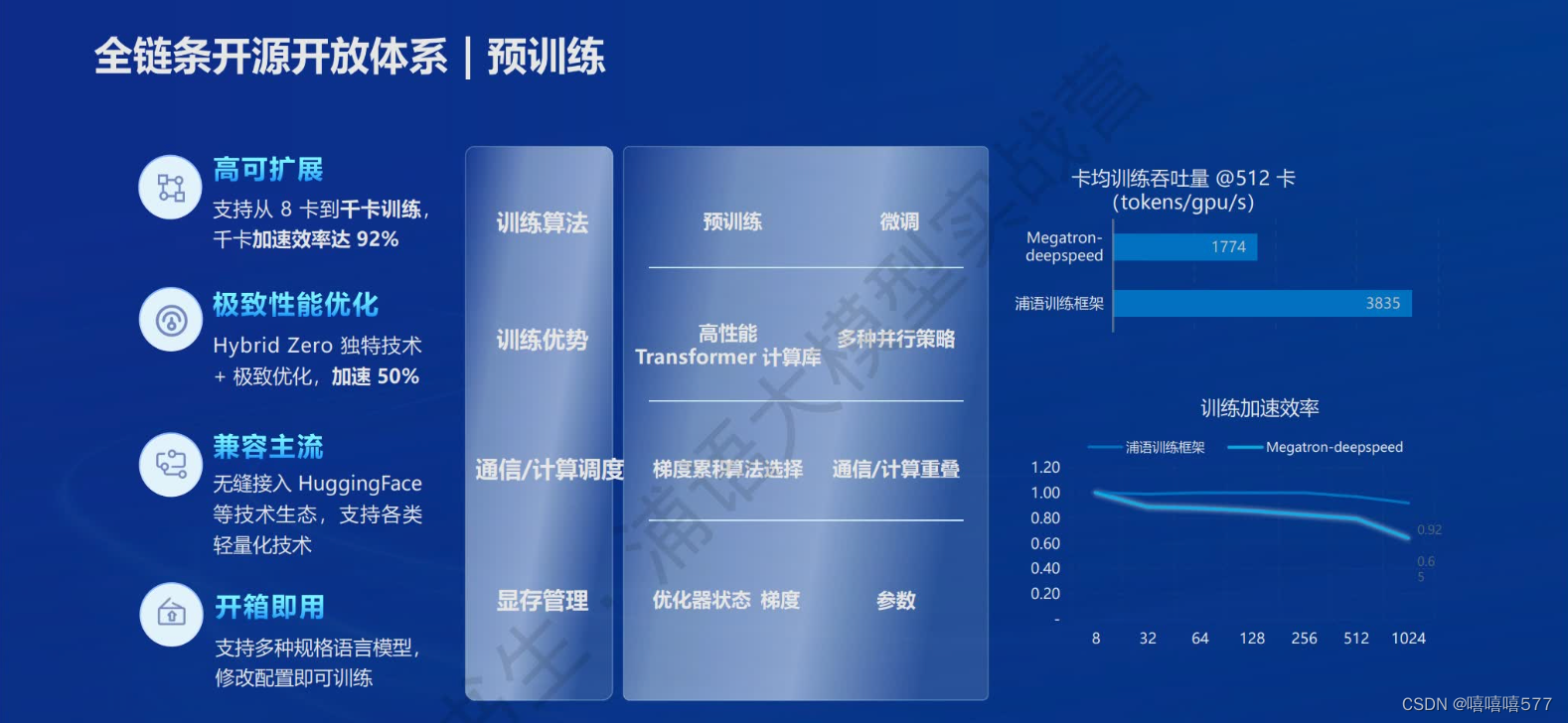

- 预训练InternLM-Train:并行训练,极致优化,速度达到3600 tokens/sec/gpu

- 微调XTuner:支持全参数微调,支持LoRA等低成本微调

- 部署LMDeploy:全链路部署,每秒生成2000+ tokens,性能领先

- 评测OpenCompass:全方位评测,性能可复现。

- 应用Lagent AgentLego:支持多种智能体,支持代码解释器等多种工具

开放高质量语料数据

数据集获取:OpenDataLab

书生·万卷1.0(总数据量2TB)、书生·万卷CC(总数据量400G)

高质量体现:多模态融合、时间跨度长、来源丰富多样、尤其是安全密度高、四重“”萃取“高质量数据、价值观对齐、精细化处理

预训练

- 高可扩展

- 极致性能优化

- 兼用主流(无缝接入HuggingFace等技术生态,支持各类轻量化技术)

- 开箱即用(支持多种规格语言模型,修改配置即可训练)

微调

下游应用中,微调常用增量续训和有监督微调,计算资源使用上更有性价比

1、增量续训

"增量续训"(Incremental Training)指的是在模型已经训练好的基础上,继续添加新的数据进行训练,以提高模型的性能或适应新的数据分布。适用于大语言模型,因为它们需要处理大量的文本数据,并且随着时间的推移,语言的使用方式可能会发生变化。

增量续训的特性:

- 持续学习:增量续训允许模型持续学习,适应新的语言趋势和更新最新数据,保持相关性和准确性,帮助避免模型变得过时。

- 避免遗忘:模型可以避免由于长时间不训练而遗忘旧知识(灾难性遗忘)。

- 计算资源效率高:相比于从头开始训练一个全新的模型,增量续训通常只需要较少的计算资源。

- 微调:通常与微调相结合,在特定垂类任务上对模型进行额外的训练,以提高在该任务上的性能。 模型维护:对于大型语言模型,定期的增量续训是维护模型性能和相关性的重要手段。

- 数据多样性提高泛化能力:增量续训可以帮助模型更好地理解和处理多样化的数据,提高其泛化能力。

使用场景:让模型基座学习新知识,如某垂类领域知识,语言变化等。

训练数据为文章、书籍、代码等。

2、有监督微调

使用场景:让模型学会理解各种指令进行对话,或者注入少量领域知识训练数据。

训练数据为高质量的对话、问答数据。

微调方式:全量参数微调、部分参数微调

高效微调框架XTuner

XTuner 是由上海人工智能实验室开发的用于大型语言模型(LLMs)的微调工具。XTuner 旨在帮助研究人员和开发者以低成本在单个GPU上对大型语言模型进行微调,以适应特定的下游任务。

适配多种生态:

- 多种微调算法,覆盖各类SFT场景(Supervised Fine-Tuning有监督微调)

- 适配多种开源生态:支持加载HuggingFace、ModelScope模型或数据集

适配多种硬件:

- 训练方案覆盖NVIDIA 20系以上所有显卡

- 最低只用8G显存即可微调7B模型

评测

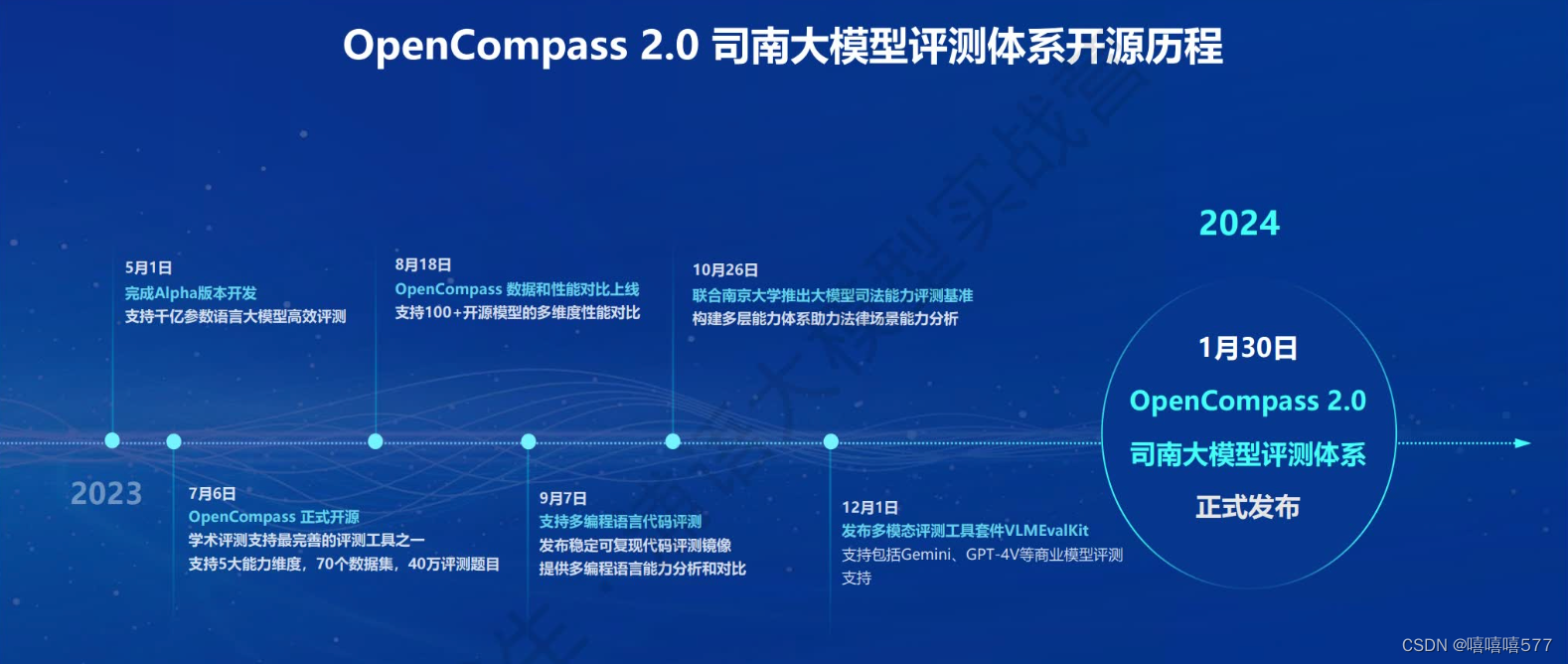

OpenCompass 2.0司南

OpenCompass(司南)由上海人工智能实验室发布的一个开源的大模型评测体系,旨在为大型语言模型、多模态模型等提供一站式的评测服务。

主要特点:

-

开源可复现:OpenCompass提供了公平、公开、可复现的大模型评测方案。

-

全面的能力维度:设计了五大能力维度,提供了70+个数据集,约40万题的模型评测方案,全面评估模型能力。

-

丰富的模型支持:已支持20+ HuggingFace及API模型。

-

分布式高效评测:通过一行命令实现任务分割和分布式评测,数小时即可完成千亿模型的全量评测。

-

多样化评测范式:支持零样本、小样本及思维链评测,结合标准型或对话型提示词模板,激发各种模型的最大性能。

-

灵活化拓展:可以轻松扩展新模型或数据集,自定义更高级的任务分割策略,甚至接入新的集群管理系统。

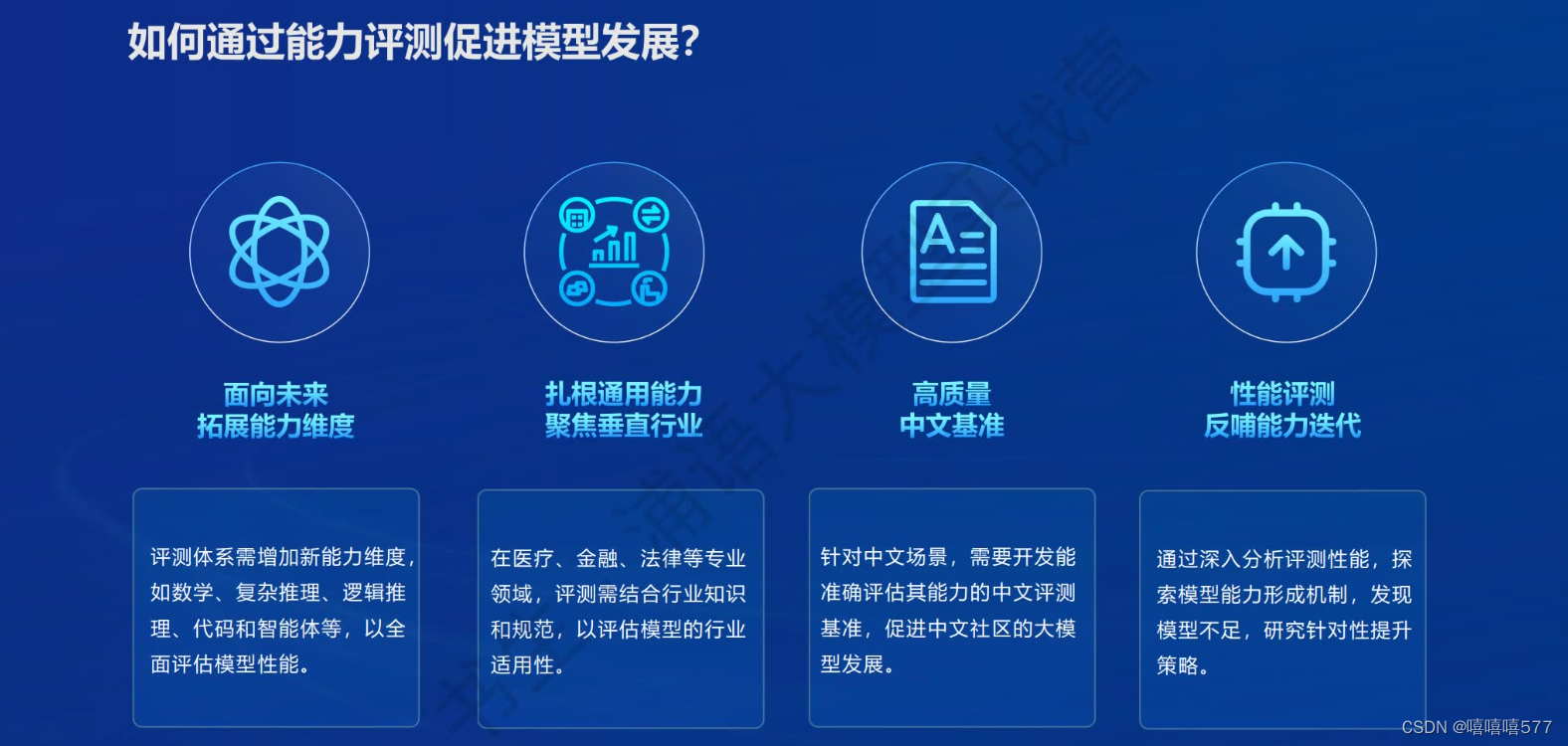

能力评测促进模型发展

- 拓展能力维度,以全面评估模型性能。

- 扎根通用能力,聚焦垂直行业知识和规范,以评估模型的行业适用性。

- 针对中文场景,开发高质量中文基准,促进中文社区的大模型发展。

- 性能评测反哺能力迭代,探索模型能力形成机制,发现不足并研究提升策略。

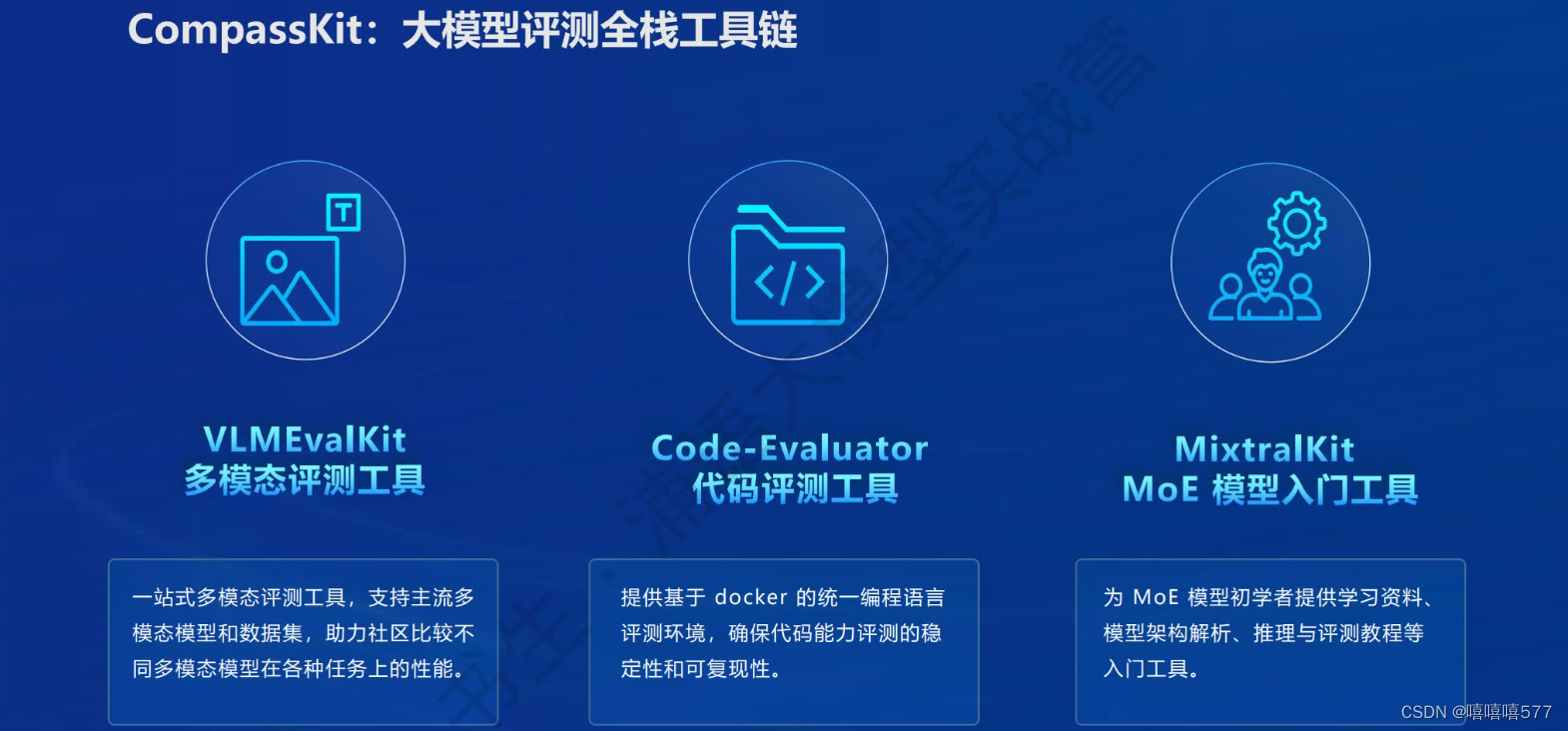

CompassKit:大模型评估全栈工具链

CompassKit是OpenCompass 系统中的一个重要组成部分,为大型语言模型(LLMs)和大型视觉-语言模型(VLMs)设计的全面评估工具集。

功能全面升级:数据污染监测、更丰富的模型推理接入、长文本能力评测、中英文双语主观评测

关键组件:

- VLMEvalKit多模态评测工具:一站式多模态评测工具,支持主流的多模态模型和数据集,帮助社区成员比较不同多模态模型在各种任务上的性能

- Code-Evaluator代码评测工具:提供基于 Docker 的统一编程语言评测环境,确保代码能力评测的稳定性和可复现性。

- MixtralKit MoE模型入门工具:为 MoE(Mixture of Experts)模型初学者提供学习资料、模型架构解析、推理与评测教程等入门工具。

CompassKit 主要特点:

- 开源可复现:确保评测过程的透明度和可重复性。

- 全面的能力维度:提供多维度的评测,覆盖语言、知识、理解、数学、代码等多个方面。

- 分布式高效评测:支持分布式评测策略,提高评测效率。

- 丰富的模型支持:支持多种模型,包括 HuggingFace 及 API 模型。

- 多样化评测范式:结合零样本、小样本及思维链评测等多种评测范式。

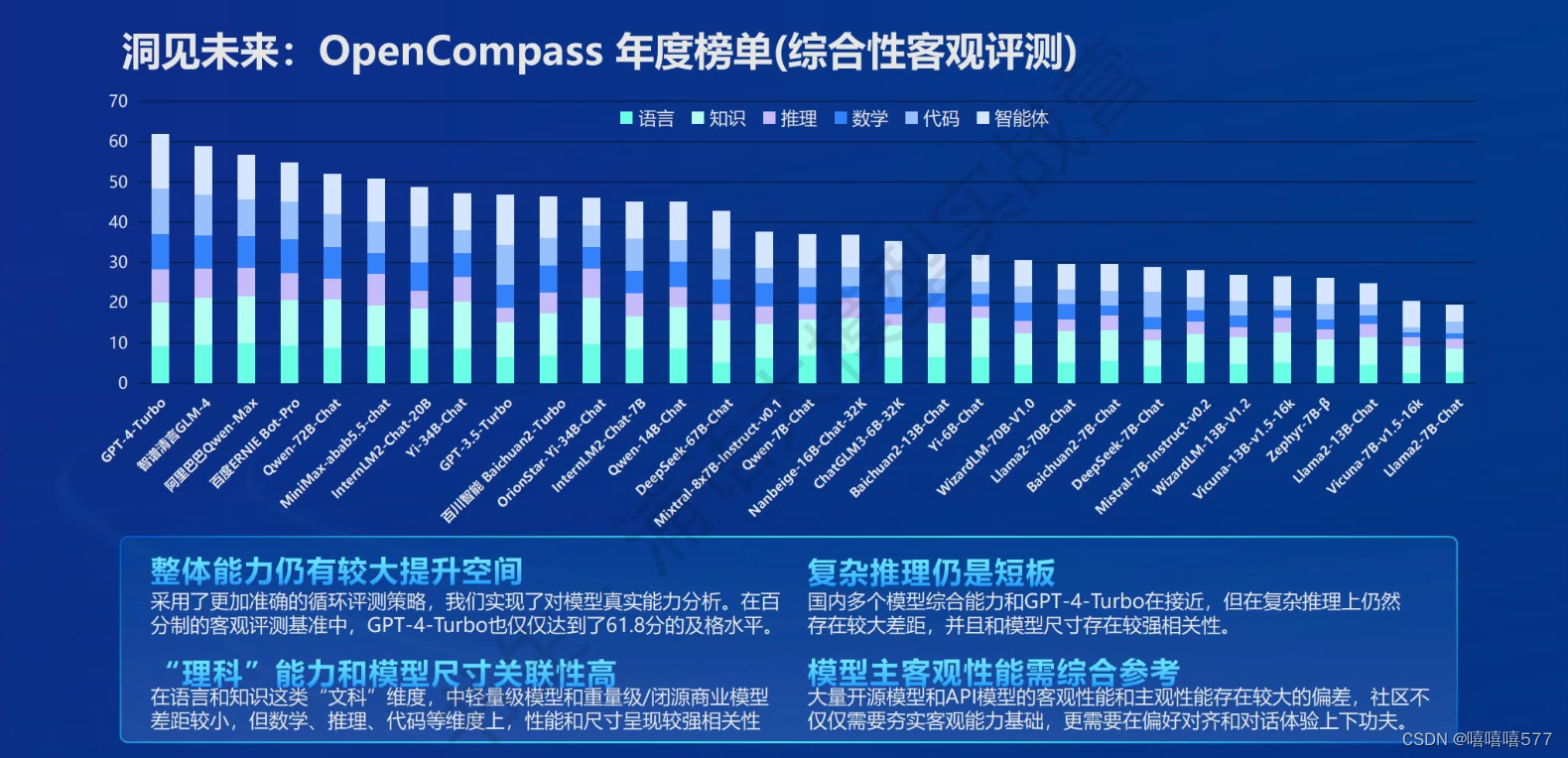

OpenCompass年度榜单(综合性能客观评测)

OpenCompass年度榜单(综合性能客观评测)

- 整体能力仍有较大提升空间

- 复杂推理仍是短板

- “理科”能力和模型尺寸关联性高

- 模型主客观性能需综合参考

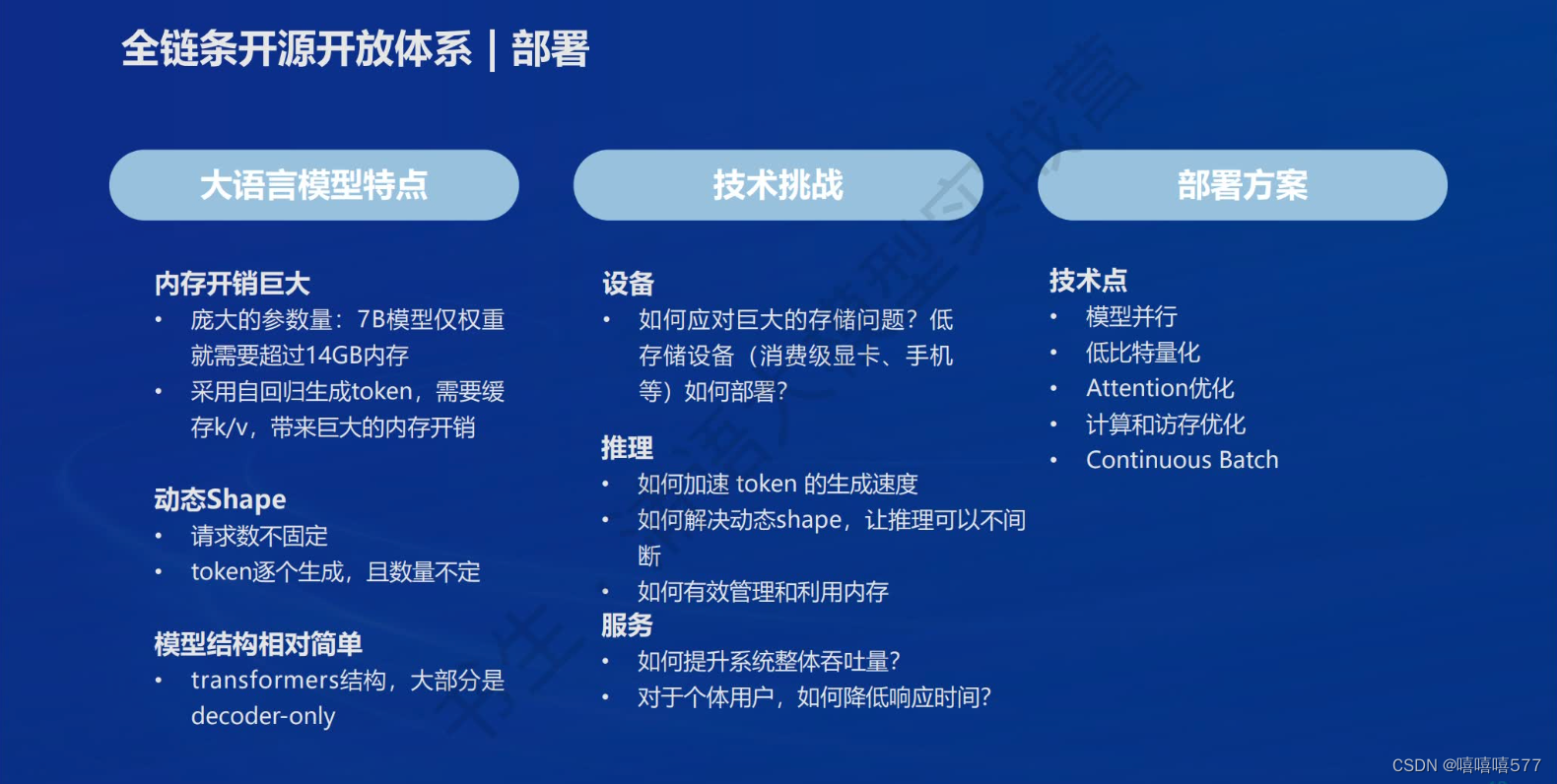

部署

大语言模型特点

- 内存开销巨大

- 动态Shape

- 模型结构相对简单

技术挑战

- 低存储设备如何部署?

- 如何加速推理速度,解决动态shape让推理不间断?

- 如何有效管理和利用内存?

部署方案的技术点

- 模型并行

- 低比特量化

- Attention优化

- 计算和访存优化

- Continuous Batch

LMDeploy

提供大模型在GPU上部署的全流程解决方案,包括模型轻量化、推理和服务。

LMDeploy是由上海人工智能实验室联合其他机构共同开发的,一个用于大型语言模型(LLMs)的全套轻量化、部署和服务解决方案。LMDeploy 包含了高效的推理引擎、量化支持、交互式推理模式以及分布式服务器等功能,旨在提供优化的推理性能和模型部署的便利性

智能体

背景:因为大语言模型在最新信息和知识获取、回复的可靠性、数学计算、工具使用和交互方面的局限性,LLM向智能体发展。

1、轻量级智能体框架 Lagent

Lagent是由上海人工智能实验室开发的轻量级、开源的智能体框架,旨在帮助用户快速将大语言模型转变为多种类型的智能体,并提供了一些典型工具来增强大语言模型的能力。

主要特性:

- 支持多种类型的智能体能力(例如 ReAct、ReWoo、AutoGPT)

- 灵活支持多种大语言模型(包括GPT-3.5/4、InternLM、HuggingFace Transformers、Llama)

- 简单易拓展,支持丰富的工具(AI工具、借助搜索/计算器/代码解释器的能力拓展、Rapid API)

2、多模态智能体工具箱 AgentLego

主要特点:

- 丰富的工具集合,尤其是大量视觉、多模态相关领域的前沿算法功能

- 支持多个主流智能体系统,如LangChain、Transformers Agent、lagent等

- 灵活的多模态工具调用接口,可以轻松支持各类输入输出格式的工具函数

- 一键式远程工具部署,轻松使用和调用大模型智能体

Lagent与AgentLego的关系:

Lagent 是一个轻量级的智能体框架,专注于构建基于大语言模型(LLM)的智能体。而 AgentLego 是一个多模态工具包,提供了多种开源工具 API,用于扩展和增强智能体的能力。

二者互补协同工作,AgentLego 作为一个工具库,可以在 Lagent 的功能支持模块中发挥作用。

1619

1619

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?