目录

HDFS(Hadoop Distributed File System)是Hadoop生态系统的一部分,用于存储和处理大规模数据集。

一、VMware虚拟机中部署

1、安装包下载

官方网址:https://hadoop.apache.org,

2、集群规划

在前置准备章节,准备了基于VMware的三台虚拟机,其硬件配置如下。

| 节点 | CPU | 内存 |

| node1 | 1核心 | 4GB |

| node2 | 1核心 | 2GB |

| node3 | 1核心 | 2GB |

Hadoop HDFS的角色包含:

- NameNode,主节点管理者

- DataNode,从节点工作者

- SecondaryNameNode,主节点辅助

| 节点 | 服务 |

| node1 | NameNode、DataNode、SecondaryNameNode |

| node2 | DataNode |

| node3 | DataNode |

3、上传&解压

!注意:请确认已经完成前置准备中的服务器创建,固定IP、防火墙关闭、Hadoop用户创建、SSH免密、JDK部署等操作。

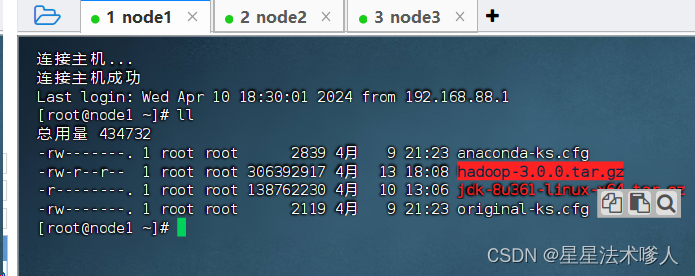

node1节点执行,以root身份登录:

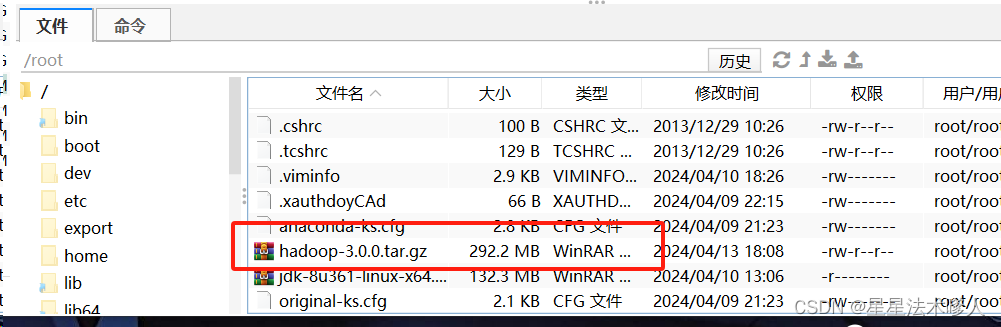

3.1.上传hadoop安装包到node1节点中

通过ll命令可以查看目录,可见hadoop上传成功

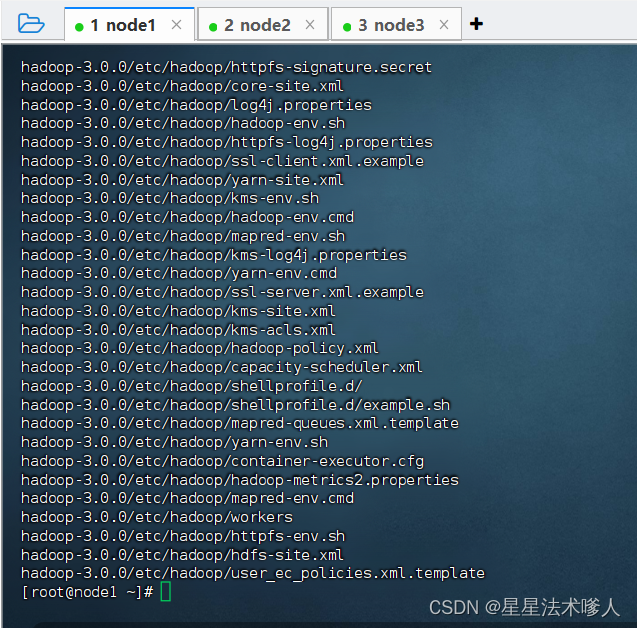

3.2.解压缩安装包到/export/server/中

tar -zxvf hadoop-3.0.0.tar.gz -C /export/server/

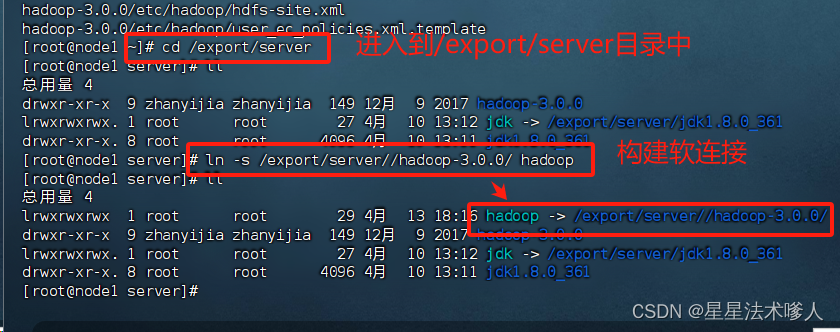

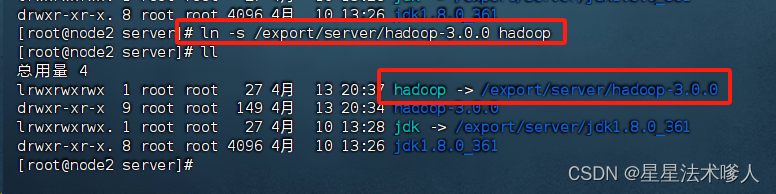

3.3.构建软连接

cd /export/server

ln -s /export/server//hadoop-3.0.0/ hadoop

4、进入hadoop安装包内

4.1Hadoop安装包目录结构

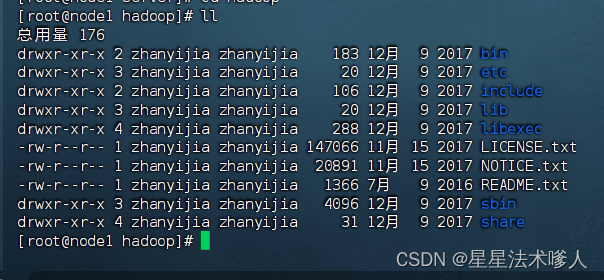

cd进入Hadoop安装包内,通过ls -l 命令查看文件夹内部结构

各个文件夹含义如下:

- bin,存放Hadoop的各类程序(命令)

- etc,存放Hadoop的配置文件

- include,C语言的一些头文件

- lib,存放Linux系统的动态链接库(.so文件)

- libexec,存放配置Hadoop系统的脚本文件(.sh和.cmd)

- licenses-binary,存放许可证文件

- sbin,管理员程序(super bin)

- share,存放二进制源码(java jar包)

4.2修改配置文件,应用自定义设置

配置HDFS集群,我们主要涉及到如下文件的修改:

- workers: 配置从节点(DataNode)有哪些

- hadoop-env.sh 配置Hadoop的相关环境变量

- core-site.xml: Hadoop核心配置文件

- hdfs-site.xml: HDFS核心配置文件

这些文件均存在于$HADOOP_HOME/etc/hadoop文件夹中

ps:$HADOOP_HOME是后续我们要设置的环境变量,其指代Hadoop安装文件夹即/export/server/hadoop。

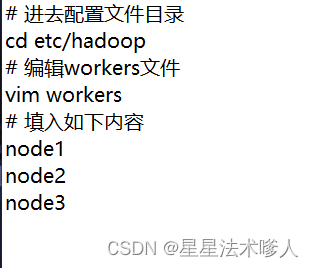

4.2.1.配置workers文件

填入的node1、node2、node3表明集群记录了三个从节点。

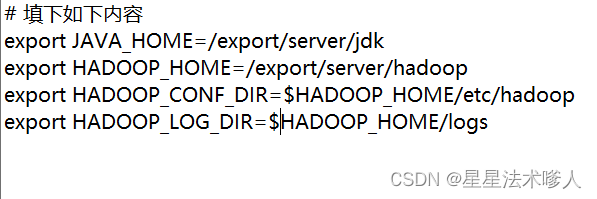

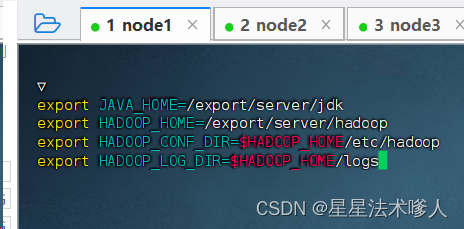

4.2.2.配置hadoop-env.sh文件

export JAVA_HOME=/export/server/jdk

export HADOOP_HOME=/export/server/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_LOG_DIR=$HADOOP_HOME/logs- JAVA_HOME,指明JDK环境的位置在哪

- HADOOP_HOME,指明Hadoop安装位置

- HADOOP_CONF_DIR,指明Hadoop配置文件目录位置

- HADOOP_LOG_DIR,指明Hadoop运行日志目录位置

通过记录这些环境变量,来指明上述运行时的重要信息。

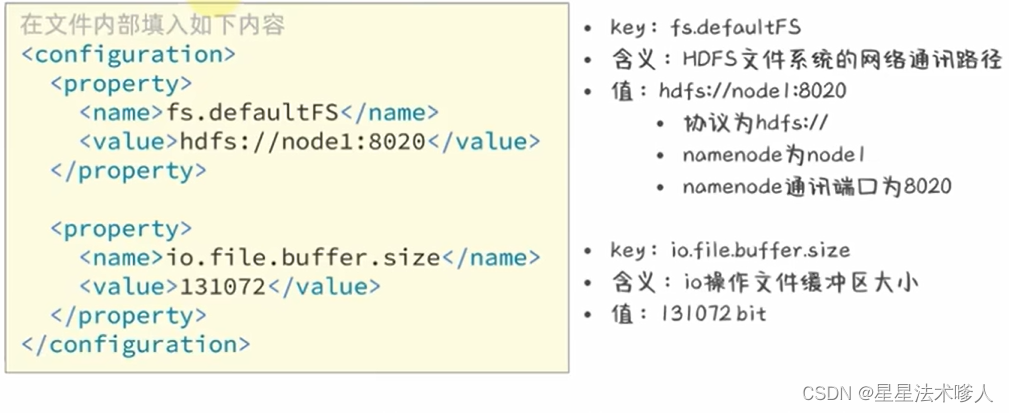

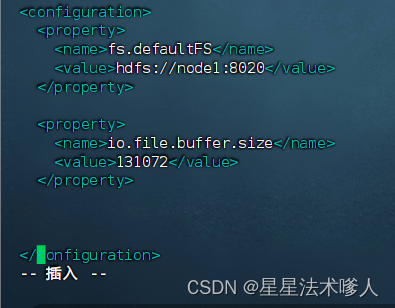

4.2.3.配置core-site.xml文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:8020</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

</configuration>- hdfs://node1:8020为整个HDFS内部的通讯地址,应用协议为hdfs://(Hadoop内置协议)

- 表明DataNode将和node1的8020端口通讯,node1是NameNode所在机器

- 此配置固定了node1必须启动NameNode进程

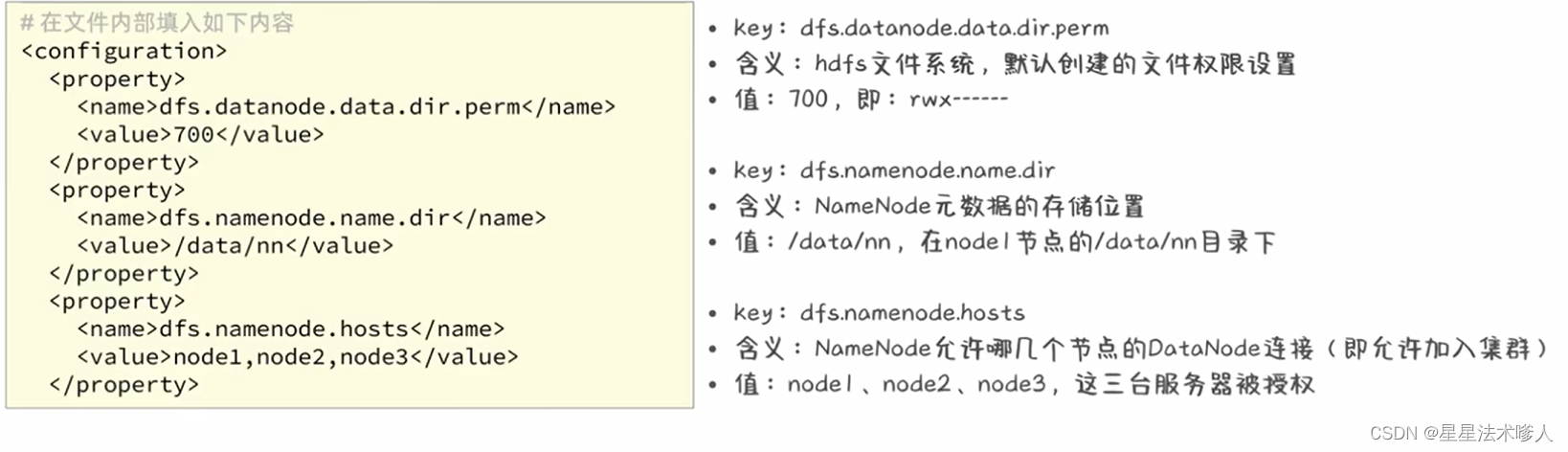

4.2.4.配置hdfs-site.xml文件

<configuration>

<property>

<name>dfs.datanode.data.dir.perm</name>

<value>700</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/nn</value>

</property>

<property>

<name>dfs.namenode.hosts</name>

<value>node1,node2,node3</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>268435456</value>

</property>

<property>

<name>dfs.namenode.handler.count</name>

<value>100</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/dn</value>

</property>

</configuration>4.2.5.准备数据目录

- namenode数据存放node1的/data/nn

- datanode数据存放node1、node2、node3的/data/dn

所以应该

- 在node1节点:

- mkdir -p /data/nn

- mkdir /data/dn

- 在node2和node3节点:

- mkdir -p /data/dn

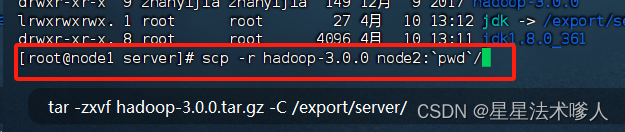

5、分发Hadoop文件夹

目前,已经基本完成Hadoop的配置操作,可以从node1将Hadoop安装文件远程复制到node2、node3。因为在前边的设置中并没有将hadoop上传给node2、node3。

以下是复制到node2的操作示例,同样操作复制到node3,

node2复制完毕

分别在node2、node3构建软连接(需要分别切换到node2与node3执行):

构建软连接相当于给一个快捷操作。

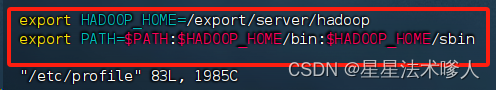

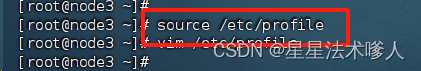

6、配置环境变量

为了方便操作Hadoop,可以将Hadoop的一些脚本、程序配置到PATH中,方便后续使用,在Hadoop文件夹中bin、sbin两个文件夹内有许多的脚本和程序,现在来配置一下环境变量。

在三台虚拟机都需要配置:

vim /etc/profile

在文件底部追加一下内容

export HADOOP_HOME=/export/server/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin添加保存退出后需要source

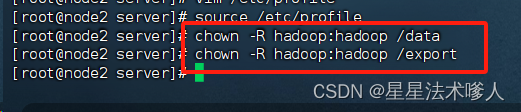

7、授权为hadoop用户

hadoop部署的准备工作基本完成

为了确保安全,hadoop系统不以root用户启动,我们以普通用户hadoop来启动整个Hadoop服务

所以,现在需要对文件权限进行授权。

ps:先确保已经提前创建好了hadoop用户,并配置了hadoop用户之间的免密登录

- 以root身份,分别在node1、node2、node3三台虚拟机均执行以下代码

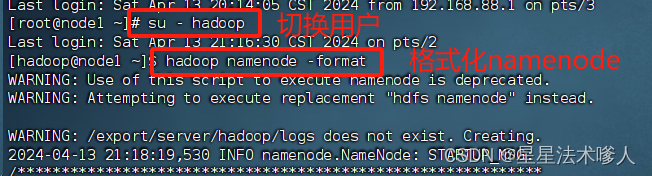

8、格式化整个文件系统

前期准备全部完成,现在对整个文件系统执行初始化

以下操作只需要在node1执行

- 格式化namenode

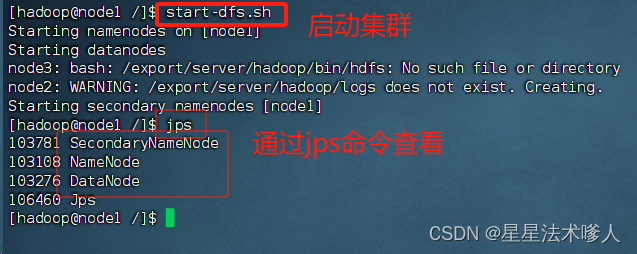

- 启动

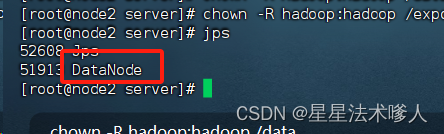

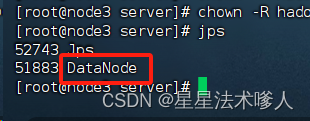

node2、node3的结果如下:

9.查看HDFS WEBUI

启动完成后,可以在浏览器打开:http://node1.9870

即可查看到hdfs文件系统的管理网页

1918

1918

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?