各应用程序及版本

- CentOS65

- jdk1.8.0_121

- storm1.1.1

- zookeeper3.4.10

- kafka2.12-1.0.0

- redis4.0.5

storm、zookeeper、kafka可从apache.org网站获取相应版本,建议版本与本文档一致;否则后续的示例程序可能会有乱码等不可知异常。

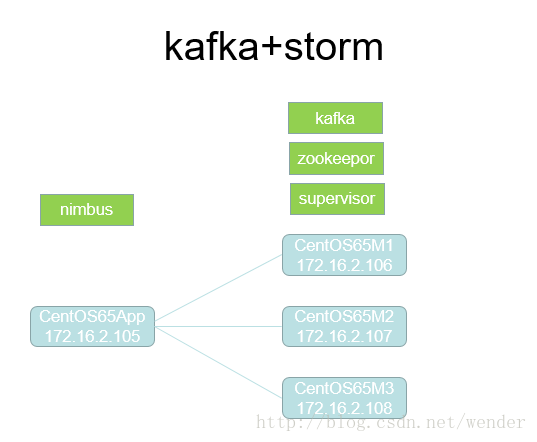

服务器IP及拓朴结构

storm安装在/app/apache-storm-1.1.1

四台服务器 创建本地输出路径 /data/storm

mkdir /data

mkdir /data/storm四台服务器 {storm_home}/conf/storm.yaml配置内容

storm.zookeeper.servers:

- "CentOS65M1"

- "CentOS65M2"

- "CentOS65M3"

nimbus.seeds: ["CentOS65App"]

storm.zookeeper.port: 2181

storm.local.dir: "/data/storm"

ui.port: 9099

supervisor.slots.ports:

- 6700

- 6701

- 6702

- 6703

四台服务器配置/etc/hosts,为方便后续部署,四台服务器已经设置了ssh免密登录

172.16.2.105 CentOS65App

172.16.2.106 CentOS65M1

172.16.2.107 CentOS65M2

172.16.2.108 CentOS65M3四台服务器配置环境变量 /etc/profile

export STORM_HOME=/app/apache-storm-1.1.1

export STORM_EXT_CLASSPATH=$STORM_HOME/extlib

export STORM_EXT_CLASSPATH_DAEMON=$STORM_HOME/extlib-daemon

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$REDIS_HOME/bin:$ZOOKEEPER_HOME/bin:$STORM_HOME/bin:$HADOOP_INSTALL/bin:$HADOOP_INSTALL/sbin:$PATH

source /etc/profilezookeeper安装配置

zookeeper安装在 /app/zookeeper-3.4.10

三台supervisor服务器的 {zookeeper_home}/conf/zoo.cfg

dataDir=/data/zookeeper

clientPort=2181

server.106=CentOS65M1:2888:3888

server.107=CentOS65M2:2888:3888

server.108=CentOS65M3:2888:3888

mkdir /data/zookeeper

touch /data/zookeeper/myid

echo {主机IP最后一节,如106} > /data/zookeeper/myid

#即/data/zookeeper/myid的内容为106、107、108之一,且三台服务器的myid内容不同。

export ZOOKEEPER_HOME=/app/zookeeper-3.4.10

export ZOO_LOG_DIR=/data/zookeeper #有了此项配置,便不在当前路径生成zookeeper.out

export PATH=$JAVA_HOME/bin:$ZOOKEEPER_HOME/bin:$STORM_HOME/bin:$KAFKA_HOME/bin:$HADOOP_INSTALL/bin:$HADOOP_INSTALL/sbin:$PATHkafka安装配置

kafka安装在/app/kafka_2.12-1.0.0

三台supervisor服务器的 {kafka_home}/config/server.properties

broker.id=106 #此处与zookeeper/myid相同

log.dirs=/data/kafka #作用同storm、zookeeper,统一输出路径,便于问题集中排查

zookeeper.connect=CentOS65M1:2181,CentOS65M2:2181,CentOS65M3:2181mkdir /data/kafka三台supervisor服务器配置然后加载环境变量/etc/profile

export KAFKA_HOME=/app/kafka_2.12-1.0.0

export PATH=$JAVA_HOME/bin:$ZOOKEEPER_HOME/bin:$STORM_HOME/bin:$KAFKA_HOME/bin:$HADOOP_INSTALL/bin:$HADOOP_INSTALL/sbin:$PATHredis安装配置

redis安装在nimbus服务器CentOS65App的 /app/redis/

如果需要设置访问密码,则配置{redis_home}/conf/redis.conf

requirepass inputYourPasswordHereexport REDIS_HOME=/app/redis

export PATH=$JAVA_HOME/bin:$REDIS_HOME/bin:$STORM_HOME/bin:$HADOOP_INSTALL/bin:$HADOOP_INSTALL/sbin:$PATH

设置防火墙

设置nimbus服务器防火墙

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2181 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6627 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6379 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 9099 -j ACCEPT

设置supervisor服务器防火墙

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2181 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 2888 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 3888 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6700 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6701 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6702 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 6703 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 8000 -j ACCEPT

-A INPUT -m state --state NEW -m tcp -p tcp --dport 9092 -j ACCEPT

按如下顺序启动集群:

在三台supervisor服务器上启动zookeeper

zkServer.sh startstorm nimbus > /data/storm/nimbus.log 2>&1 &

storm ui > /data/storm/ui.log 2>&1 &

storm supervisor > /data/storm/supervisor.log 2>&1 &kafka-server-start.sh /app/kafka_2.12-1.0.0/config/server.properties > /data/kafka/kafka.log 2>&1 &启动完成后在浏览器输入以下地址进入storm ui

http://centos65app:9099/index.html

示例代码

代码亲测可用,具体执行顺序,请参考下载项目的README.md的[Order of execution]部分。

http://download.csdn.net/download/wender/10234046

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?