yolov5v7.0 segmet 实例分割 openvino Dnn onnxruntime C++部署

训练后模型导出成onnx

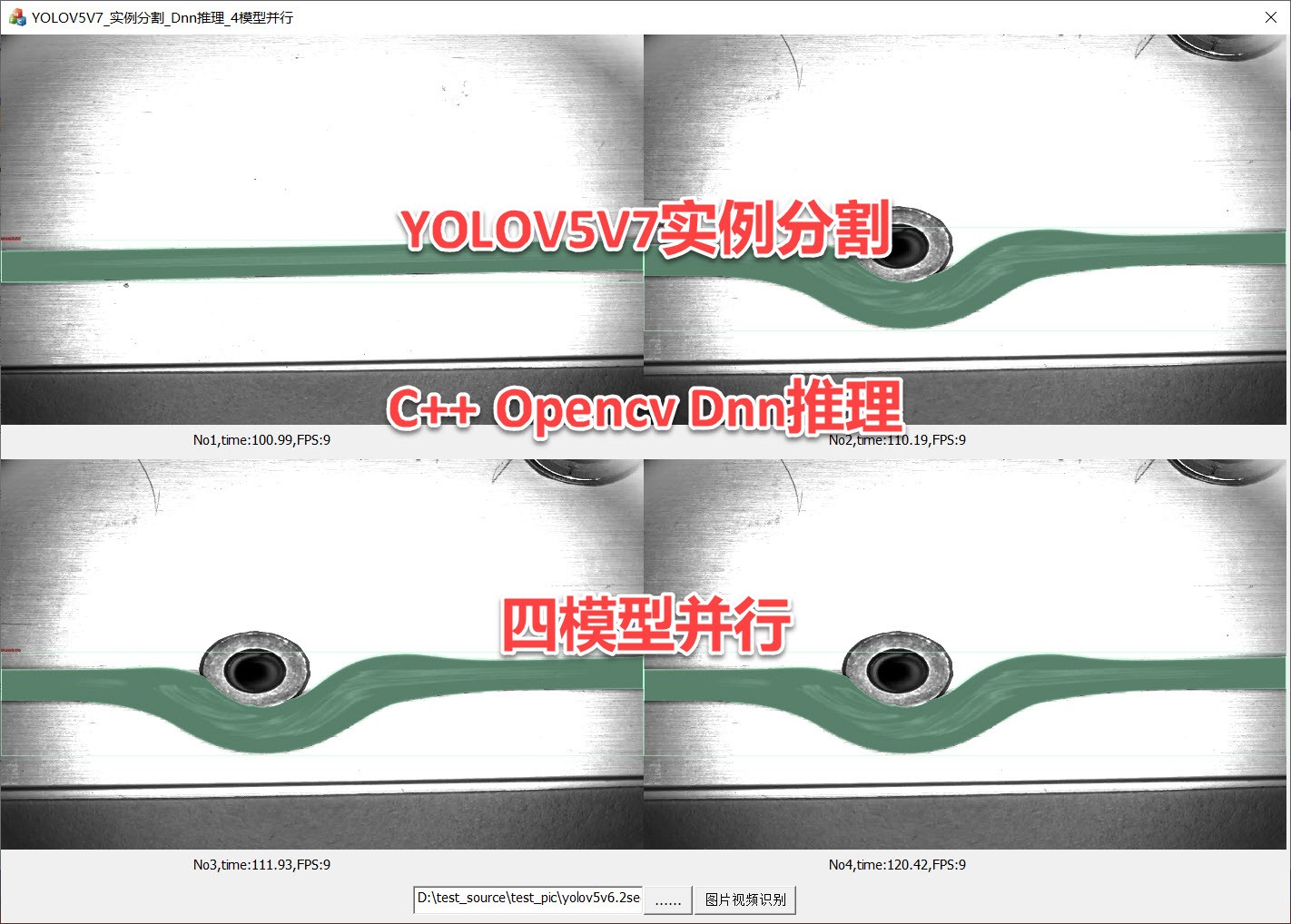

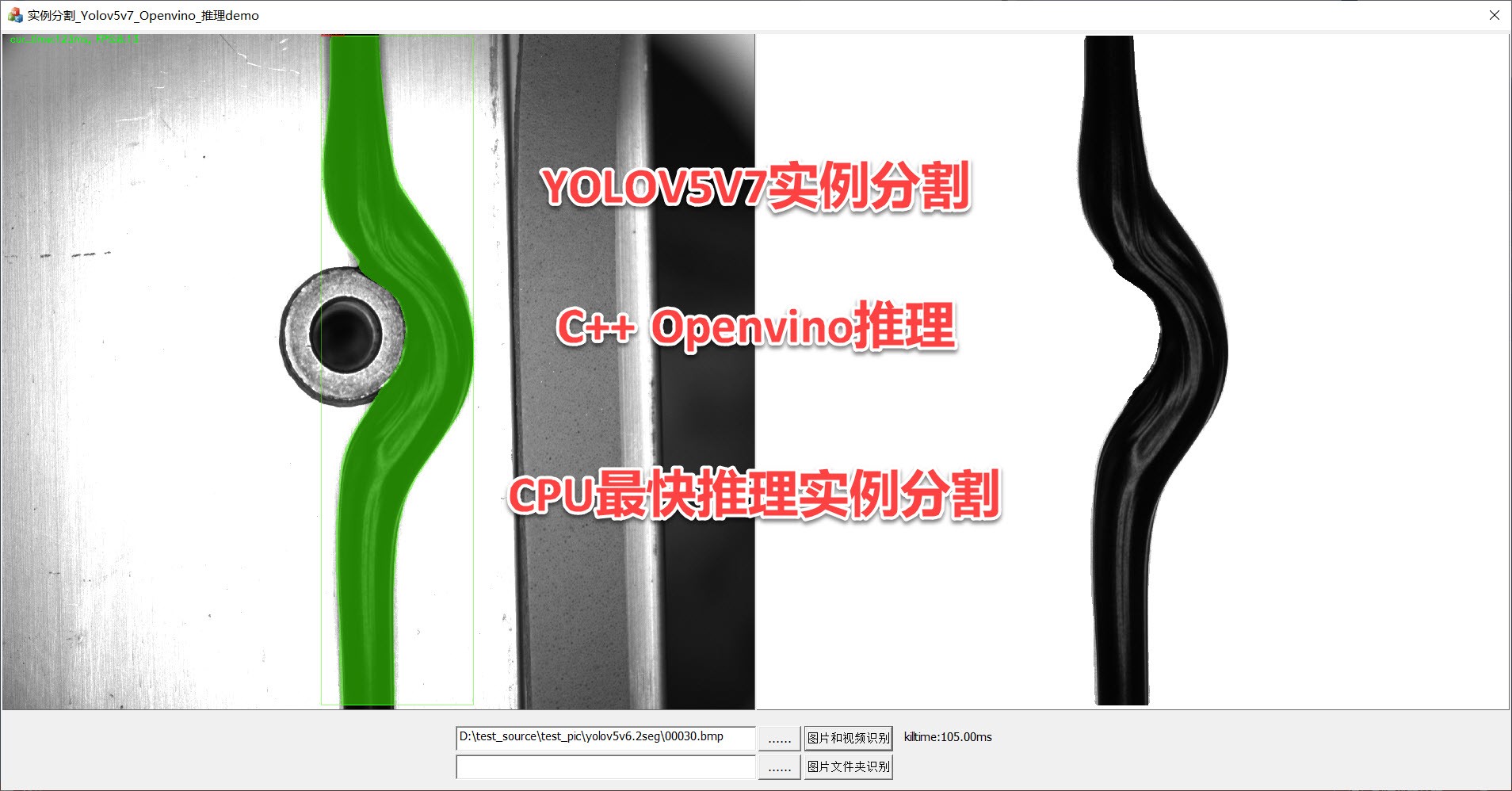

C++后台可使用openvino Dnn onnxruntime推理,封装成dll库,支持多模型并行运行,支持自训练自定义模型

支持界面MFC/C#/Qt调用

ID:882400694310355195

IT干将

yolov5v7.0 segmet 实例分割 openvino Dnn onnxruntime C++部署

训练后模型导出成onnx

C++后台可使用openvino Dnn onnxruntime推理,封装成dll库,支持多模型并行运行,支持自训练自定义模型

支持界面MFC C# Qt调用

近年来,随着计算机视觉技术的快速发展,物体检测和分割已成为计算机视觉领域的重要任务。在物体检测中,目标检测模型的性能和速度是衡量其优劣的重要指标之一。yolov5v7.0是一种当前非常流行的物体检测模型,具有快速、准确的特点。与此同时,开源的openvino Dnn和onnxruntime库为我们提供了便捷而高效的模型推理框架。本文将介绍如何将训练完成的yolov5v7.0模型导出成onnx格式,并在C++后台中使用openvino Dnn和onnxruntime进行模型推理。同时,我们还将展示如何将模型封装成dll库,以支持多模型并行运行,并介绍如何在界面上使用MFC、C#和Qt调用这些模型。

首先,我们需要了解yolov5v7.0模型和onnx格式的基本概念。yolov5v7.0模型是一种基于深度学习的物体检测模型,能够快速、准确地识别图像中的目标。它具有多层卷积神经网络结构,能够从图像中提取丰富的特征信息,并输出目标的位置和类别。onnx是一种跨平台的开放式模型格式,能够在不同的深度学习框架之间进行模型的导入和导出。通过将yolov5v7.0模型导出成onnx格式,我们可以在不同的平台和环境中使用该模型进行推理。

接下来,我们将介绍如何使用openvino Dnn和onnxruntime进行模型推理。openvino Dnn是一种针对深度学习模型推理的高性能、低延迟的库,能够加速模型的推理过程。onnxruntime则是微软开源的深度学习推理引擎,能够在不同硬件平台上高效地执行深度学习模型。通过结合这两个库,我们可以在C++后台中快速而高效地进行yolov5v7.0模型的推理。

在模型导出和推理的基础上,我们还将介绍如何将模型封装成dll库,并

【相关代码,程序地址】:http://fansik.cn/694310355195.html

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?