上一篇:某大厂员工吐槽:今天拉肚子,在厕所突然听到领导叫自己,让快出来沟通工作。同事说领导先来工位问,得知他在厕所后,还真去找了...

人生观念的转变往往能带来心态和生活状态的积极改变。当一个人开始以更加开放的心态去面对生活中的挑战和变化时,他们往往能够以更加乐观的态度去应对困难,从而在逆境中寻找到成长和进步的机会。这种心态的转变不仅能够帮助个人减轻压力和焦虑,还能够让他们在面对挑战时更加从容不迫,甚至能够将不利的情况转化为有利的机会。

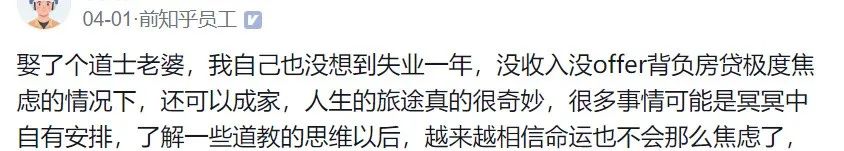

以一位朋友的经历为例,他的婚姻和职业道路都充满了意外和挑战。他娶了一位道士为妻,而自己却意外地遭遇了长达一年的失业。在当前就业市场竞争激烈的环境中,没有稳定的收入和工作机会对他来说无疑是巨大的打击。更糟糕的是,他还需要承担沉重的房贷压力,这使得他的经济状况更加紧张。

然而,即便在这样的困境中,他依然能够与心爱的人组建家庭,这本身就是一种难得的缘分。这种经历让人不禁感叹,生活中的美好往往在不经意间降临,即使在最困难的时刻,也有可能遇到意想不到的幸福。

这位朋友的故事也让人深思,即使在逆境中,保持积极的心态和乐观的人生观是非常重要的。通过了解和学习道教的思想,他逐渐学会了顺应自然,接受生活的起伏,并从中寻找到了内心的平静。他开始相信命运的安排,并减少了无谓的焦虑,他的生活状态也因此得到了改善。他的经历告诉我们,顺其自然的生活态度有时候能够带来意想不到的积极效果。

所以,人生充满了不确定性和变数,但通过调整心态,学会接受和适应生活中的变化,我们可以更好地应对挑战,享受生活带来的每一份惊喜。这位朋友的故事就是一个很好的例证,它鼓励我们在面对困难时,保持乐观和积极的心态,相信生活中总有美好的安排在等待着我们。

在现代社会的快节奏和高压力环境下,人们往往需要在对外的社交互动和对内的个人修养之间找到平衡。儒家的教义强调社会和谐与道德修养,而道家的思想则倡导自然无为和内在平和。结合这两者,可以帮助我们在复杂的社会关系中保持稳定,在个人生活中寻求宁静。

楼主在面对生活挑战时,采用了一种特别的方式来减轻焦虑和压力。受到妻子的影响,楼主每天都会安排20到30分钟的时间进行诵经,这是一种有助于内心平静和精神集中的活动。虽然一开始可能会觉得枯燥乏味,甚至有些难以坚持,但随着时间的推移,这种习惯会带来积极的变化。坚持诵经不仅能够帮助人们放松心情,还能够提升个人的精神状态,使人变得更加平和、不易焦虑。

楼主的体验告诉我们,当我们处于焦虑状态时,我们的思维往往会受限,容易陷入负面的循环之中。这种时候,我们需要采取一些措施来打破这种循环。例如,多参与户外活动,与朋友相聚,享受阳光,这些都是有效的缓解负面情绪的方法。通过这些活动,我们可以释放压力,调整心态,从而吸引更多积极的能量和事件。

此外,保持规律的生活习惯也是非常重要的。专注于解决眼前的问题,合理安排饮食和休息,可以帮助我们恢复体力和精神,提升我们的整体能量。当我们的能量场得到提升时,我们会发现生活中的困难和挑战变得更易于应对,事情也会逐渐向好的方向发展。

总之,通过结合儒家和道家的哲学思想,我们可以在现代社会中找到一种平衡,既能处理好人际关系,又能保持内心的宁静。通过日常的诵经、户外活动和规律作息,我们可以有效地减轻焦虑,提升生活质量,让生活变得更加美好。

说不定,真的转运了呢。

故事情节取材于网络素材、作者及身边人真实案例。由于未进行大数据统计、部分信息来自二手渠道、以及样本存在偏差,故部分读者可能在实际体验中感受到与文章有不一致的地方。

如有任何偏颇之处,欢迎进行讨论。

对此,你怎么看?

PS:欢迎在留言区留下你的观点,一起讨论提高。如果今天的文章让你有新的启发,欢迎转发分享给更多人。

全文完,感谢你的耐心阅读。如果你还想看到我的文章,请一定给本文“在看”、“点赞”,新文章推送才会第一时间出现在你的微信里。

- END -

热门推荐:

那些在一个公司死磕了5-10年的人,最后都怎么样了?

36岁被小米裁员,北邮硕士毕业,待过字节,阿里,现在只能去外包。。。

航天院入两万,是一种什么体验!

最详细的ChatGPT注册与使用教程!

爆料下各司年终奖PS:如果觉得我的分享不错,欢迎大家随手点赞、转发、在看

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?