卡奥斯智能交互引擎是卡奥斯基于海尔近40年工业生产经验积累和卡奥斯7年工业互联网平台建设的最佳实践,基于大语言模型和RAG技术,集合海量工业领域生态资源方优质产品和知识服务,旨在通过智能搜索、连续交互,实时生成个性化的内容和智能化产品推荐,为用户提供快速、可靠的交互式搜索服务,首创了聚焦工业领域的智能交互引擎。

详情请戳:卡奥斯智能交互引擎_ 智能交互引擎智能交互、智享未来

Simon Zhai 投稿

量子位 | 公众号 QbitAI

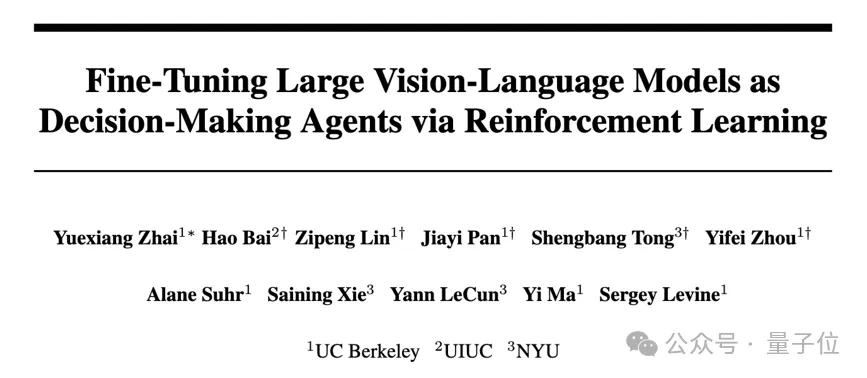

只用强化学习来微调,无需人类反馈,就能让多模态大模型学会做决策!

这种方法得到的模型,已经学会了看图玩扑克、算“12点”等任务,表现甚至超越了GPT-4v。

这是来自UC伯克利等高校最新提出的微调方法,研究阵容也是相当豪华:

-

图灵奖三巨头之一、Meta首席AI科学家、纽约大学教授LeCun

-

UC伯克利大牛、ALOHA团队成员Sergry Levine

-

ResNeXt一作、Sora基础技术DiT作者谢赛宁

-

香港大学数据科学学院院长、UC伯克利教授马毅

该方法名为RL4VLM,论文预印本已经上线,相关代码也已在GitHub中开源。

RL4VLM提出了一种新的算法框架,直接使用强化学习方法对多模态大模型进行微调。

其中奖励信息直接来源于环境当中,摆脱了RLHF中对于人类反馈的需要,从而直接赋予了多模态模型决策能力。

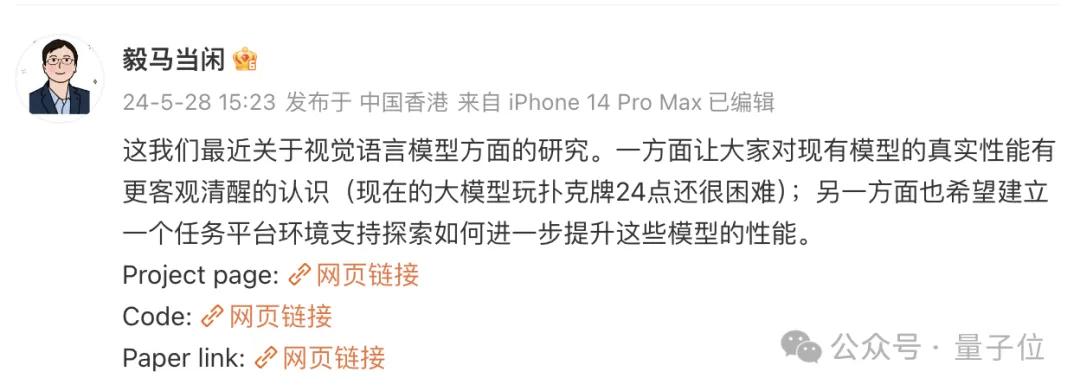

对于RL4VLM的意义,参与了这项工作的马毅教授这样说:

一方面希望大家对模型真实性能有更客观清醒的认识;

另一方面,也希望能建立一个平台,支持探索如何进一步提升模型性能。

那么,用这种方法微调出来的多模态大模型,都能让智能体学会哪些能力呢?

多模态决策能力超GPT-4v

为了评估训练出的多模态大模型给智能体带来的能力,作者一共使用了两类物种评测任务:

-

第一类任务(a-d) 主要考验模型利用图像中的细粒度视觉信息做决策的能力,包括对于数字的识别能力和利用识别的数字进行逻辑推理的能力

-

第二类任务(e)主要考察多模态大模型在具身智能环境中的视觉语义推理能力。

具体来说,这五个任务分别是:

-

a.数轴(Numberline):模型需要通过输出“+” 或者 “-”,将当前数字移动到目标数字

-

b.简易12点(EZPoint):模型需要识别两张牌,并用加号和乘号运算“12点”

-

c.24点(Point24): 模型需要识别四张牌,并用加减乘除和括号运算“24点”

-

-

d.21点(Blackjack):模型需要通过牌面上的信息来决定“要牌”或者“停牌”

-

e.ALFWorld:一个标准具身智能环境

149

149

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?