系列篇章💥

目录

前言

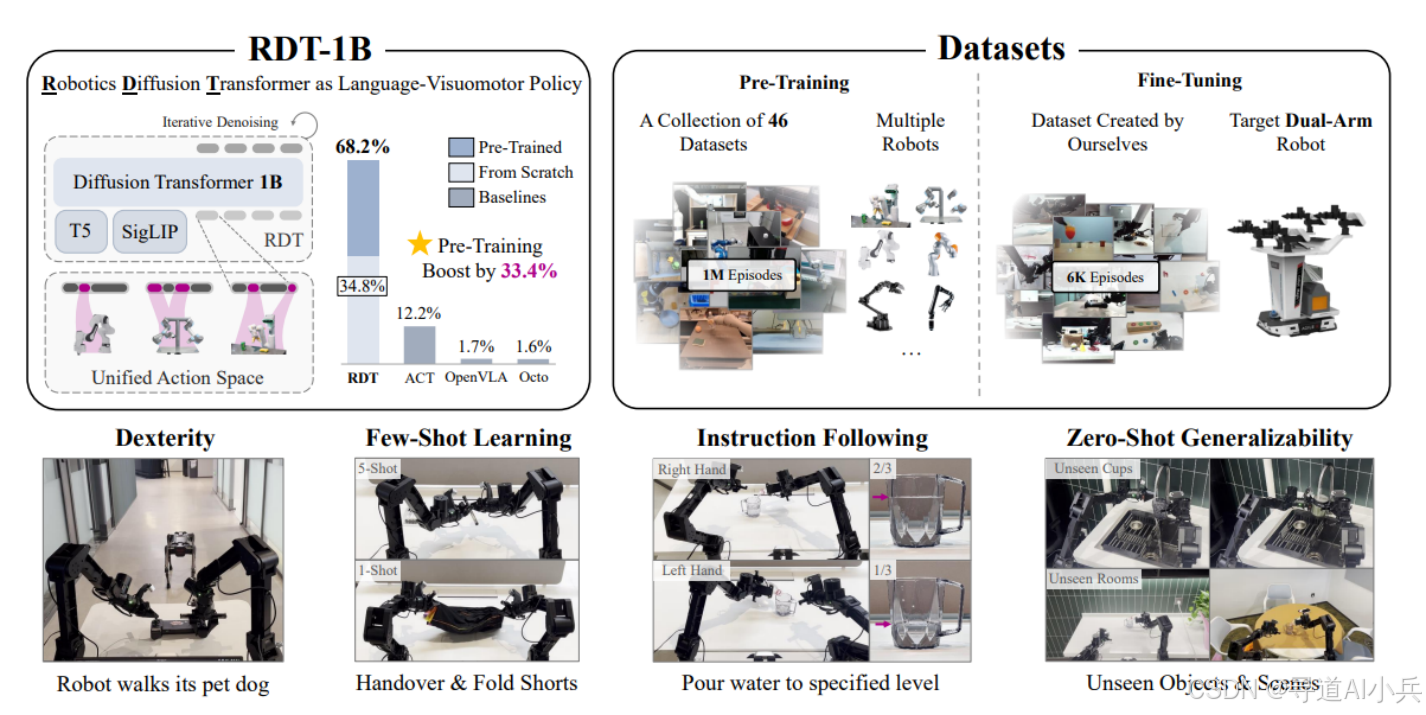

在机器人领域,双手机器人操控对于执行复杂任务至关重要,如家庭服务、工业生产等场景。然而,开发具备强大泛化能力的双手机器人操控基础模型面临诸多挑战,其中数据稀缺和架构设计难题尤为突出。由清华大学等机构研发的RDT-1B(Robotics Diffusion Transformer)模型应运而生,它创新性地采用扩散模型和可扩展的Transformer架构,致力于解决这些问题,为双手机器人操控带来了新的解决方案,在机器人领域引起广泛关注。

一、项目概述

RDT-1B是一个参数规模达10亿级别的模仿学习扩散Transformer模型,它基于大规模多机器人数据集进行预训练,旨在实现双手机器人操控任务的高效执行。该模型能够根据语言指令和多视角RGB图像,预测未来的机器人动作,具备零样本泛化、少样本学习以及处理复杂灵巧任务的能力,在双手机器人操控领域展现出卓越的性能。

二、技术原理

(一)挑战与解决方案

开发双手机器人操控基础模型面临两大核心挑战。一是设计强大的架构,以捕捉双手机器人动作分布中的多模态信息,并具备处理大规模异质数据的可扩展性;二是解决在异质数据上的训练难题,由于不同机器人的物理结构和动作空间差异巨大,如何有效利用这些数据进行模型训练是关键问题。

为应对这些挑战,RDT-1B采用了一系列创新技术。在架构设计上,它以扩散Transformer为基础,通过特殊设计来处理语言条件下的双手机器人操控任务;在数据处理方面,提出了物理可解释的统一动作空间,将不同机器人的动作映射到统一空间,便于模型学习可迁移的物理知识。

(二)模型架构

RDT-1B模型主要由扩散模型和多模态编码器组成。扩散模型用于对连续条件分布进行建模,以生成合理的机器人动作。在面对复杂的双手机器人操控任务时,由于存在多种可能的动作模式,扩散模型能够通过学习这些模式的分布,生成更符合实际情况的动作,避免了传统确定性映射方法可能产生的不合理动作。

多模态编码器负责处理来自不同模态的输入,包括低维输入(如机器人的本体感受、动作块和控制频率)、图像输入和语言输入。对于低维输入,使用带有傅里叶特征的MLP进行编码,以有效捕捉高频变化;图像输入则通过预训练的SigLIP视觉编码器提取紧凑表示;语言输入借助预训练的T5-XXL语言模型进行编码。同时,为解决多模态输入的异质性问题,模型在编码过程中采用了随机独立掩码策略,促进各模态信息的平衡融合。

(三)统一动作空间

为实现对多机器人数据的有效训练,RDT-1B提出了物理可解释的统一动作空间。这个统一动作空间具有128维,涵盖了大多数机器人的主要物理量。在将不同机器人的原始动作空间映射到统一动作空间时,根据动作向量各元素的物理意义,将其填充到相应位置,其余位置则进行填充。这种设计使得模型能够在统一的空间内学习不同机器人的动作模式,促进知识的迁移和泛化。

三、功能特点

(一)多模态融合

RDT-1B能够融合语言指令、视觉信息和机器人本体感受等多模态信息,从而更全面地理解任务和环境。在执行“拿起桌子上的杯子”任务时,模型可以结合语言指令中的“拿起杯子”信息、视觉图像中杯子的位置和形状,以及机器人自身的位置和关节状态,生成准确的动作指令,实现精准操控。

(二)零样本和少样本学习

通过大规模的预训练,RDT-1B具备强大的零样本和少样本学习能力。在面对未见过的物体、场景或任务时,模型能够凭借预训练学到的知识,快速适应并完成任务。在实验中,RDT-1B在处理“将水倒入指定杯子”的任务时,即使面对从未见过的杯子和房间场景,也能表现出较高的成功率,展示了其卓越的零样本泛化能力。在少样本学习方面,仅通过少量的示范,模型就能学习到新的技能,如“折叠短裤”任务,体现了其高效的学习能力。

(三)处理复杂任务

RDT-1B能够处理复杂、灵巧的任务,如控制机器人狗行走、精确倒水等。在控制机器人狗行走任务中,模型可以精确控制操纵杆的角度,使机器人狗直线行走,这得益于其对多模态动作分布的准确建模和对非线性动作的有效捕捉能力。

四、应用场景

(一)家庭服务机器人

在家庭环境中,RDT-1B可用于控制机器人完成各种任务,如清洁、整理物品、协助烹饪等。机器人可以根据主人的语言指令“将餐桌上的盘子收拾到厨房”,结合视觉信息识别盘子和厨房的位置,通过精准的动作规划完成任务,为人们的生活提供便利。

(二)工业生产

在工业生产线上,RDT-1B能够控制机器人进行高精度的装配、检测等工作。在电子产品装配过程中,机器人可以根据指令准确地抓取和安装微小零件,提高生产效率和产品质量。由于其具备零样本和少样本学习能力,能够快速适应新产品的生产需求,减少重新编程和调试的时间成本。

(三)教育和科研

在教育领域,RDT-1B可用于开发智能教学机器人,辅助教师进行实验演示、教学互动等。在科学研究中,它可以帮助研究人员进行复杂的实验操作,如在化学实验中,机器人能够根据实验步骤的语言指令,准确地进行试剂添加、仪器操作等,提高实验的准确性和可重复性。

五、快速使用

(一)安装

首先,克隆RDT-1B的GitHub仓库:

git clone git@github.com:thu-ml/RoboticsDiffusionTransformer.git

cd RoboticsDiffusionTransformer

然后创建Conda环境并安装所需的依赖项:

conda create -n rdt python=3.10.0

conda activate rdt

pip install torch==2.1.0 torchvision==0.16.0 --index-url https://download.pytorch.org/whl/cu121

pip install packaging==24.0

pip install flash-attn --no-build-isolation

pip install -r requirements.txt

还需要下载现成的多模态编码器,并将其链接到仓库目录:

mkdir -p google

ln -s /path/to/t5-v1_1-xxl google/t5-v1_1-xxl

ln -s /path/to/siglip-so400m-patch14-384 google/siglip-so400m-patch14-384

(二)微调

如果要在自己的数据集上微调RDT-1B,首先需要准备数据集。将数据集下载到磁盘,并链接到仓库目录:

cd data

mkdir -p datasets

ln -s /path/to/my_cool_dataset datasets/my_cool_dataset

接着,需要实现数据集加载器。这包括注册数据集配置、在相关文件中追加控制频率、编写数据集名称等操作,同时还需要重新实现HDF5VLADataset类,根据数据集的实际情况修改相关参数和函数。

计算数据集的统计信息:

python -m data.compute_dataset_stat_hdf5

最后,使用以下命令进行微调:

source finetune.sh

其中finetune.sh文件内容如下:

deepspeed --hostfile=hostfile.txt main.py \

--deepspeed="./configs/zero2.json" \

--pretrained_model_name_or_path=<MODEL ID | DIRECTORY OF MODEL WEIGHTS | PATH TO MODEL CHECKPOINT> \

--pretrained_text_encoder_name_or_path=<MODEL ID | PATH TO MODEL DIRECTORY > \

--pretrained_vision_encoder_name_or_path=<MODEL ID | PATH TO MODEL DIRECTORY> \

--output_dir=<DIRECTORY to SAVE CHECKPOINTS> \

--train_batch_size=32 \

--sample_batch_size=64 \

--max_train_steps=200000 \

--checkpointing_period=1000 \

--sample_period=500 \

--checkpoints_total_limit=40 \

--lr_scheduler="constant" \

--learning_rate=1e-4 \

--mixed_precision="bf16" \

--dataloader_num_workers=8 \

--image_aug \

--dataset_type="finetune" \

--state_noise_snr=40 \

--load_from_hdf5 \

--report_to=wandb

(三)部署

在实际机器人上部署RDT-1B时,需要对模型的推理进行封装。RDT-1B已经将推理封装到RoboticDiffusionTransformerModel类中,使用时调用step()方法进行推理。但需要根据具体机器人的情况,重新实现_format_joint_to_state()和_unformat_action_to_joint()方法,用于转换机器人的原始动作和RDT-1B接受的统一动作向量。同时,还需要指定机器人的控制频率。

提供的示例硬件代码和运行脚本如下:

python -m scripts.agilex_inference \

--use_actions_interpolation \

--pretrained_model_name_or_path=<PATH TO MODEL CHECKPOINT> \

--lang_embeddings_path=<PATH TO YOUR INSTURCTION EMBEDDINGS> \

--ctrl_freq=25

六、结语

RDT-1B作为双手机器人操控领域的创新模型,通过其独特的技术架构和功能特点,为解决双手机器人操控的难题提供了有效的解决方案。它在多个应用场景中展现出巨大的潜力,有望推动机器人技术在家庭服务、工业生产、教育科研等领域的广泛应用和发展。随着技术的不断进步,相信RDT-1B以及类似的模型将不断优化和完善,为人们的生活和工作带来更多便利和创新。

七、相关资源

- 项目代码:https://github.com/thu-ml/RoboticsDiffusionTransformer

- 论文:https://arxiv.org/pdf/2410.07864

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?