第一章绪论

统计学习基础介绍

统计学习的特点

统计学习三要素:模型(model)、策略(strategy)、算法(algorithm)。

统计学习是关于计算机基于数据构建概率统计模型并运用模型对数据进行预测和分析的一门学科。统计学习也称为统计机器学习(statisical machine learing)。

统计学习的特点:

1.建立在计算机及网络之上。

2.以数据为研究对象,是由数据驱动的学科。

3.以方法为中心,通过构建模型预测与分析

4.其目的是对数据进行预测和分析

5.统计学习多个领域的交叉学科

计算机中的“学习”的理解:一个系统通过执行某个过程改进它的性能。当人们提及机器学习时,往往是指统计机器学习。

统计学习的方法

统计学习由:

监督学习(supervised learning)

非监督学习(unsupervised learing)

半监督学习(semi-supervised learning)

强化学习(reinforecement learning)

等组成。

此部分着重介绍监督学习。

统计学习包括模型的假设空间,模型选择的准则,模型学习的算法

假设空间(hypothesis space):要学习的模型属于某个函数的集合 =>>>模型

评价准则(evaluation criterion):从假设空间中选取一个最优的模型 =>>>策略

实现统计学习的步骤:

1.得到一个有限的训练数据集合;

2.确定所包含所有可能的模型的假设空间,即学习模型的集合;

3.确定模型选择的准则,即学习的策略;

4.实现求解模型的算法,即学习的算法;

5.通过学习方法选择最优模型;

6.利用学习的最优模型对新数据进行预测或分析;

统计学习的研究

统计学习研究一般包括

统计学习方法(statistical learning method):旨在开发新的学习方法

统计学习理论(statistical learning theory):研究探求统计学习方法的有效性和效率,以及统计学习的基本理论问题

统计学习应用(application of statistical learning):将统计学习应用到实际问题中去,解决实际问题。

统计学习的重要性

1.处理海量数据的有效方法

2.计算机智能化的有效手段

3.计算机科学发展的重要组成部分

监督学习基础介绍

基本概念

1.输入空间(input space):输入的所有可能取值的集合

2.特征空间(feature space):特征向量存在的空间

3.输出空间(output space):输出的所有可能取值的集合

输入和输出空间可以是有限元素的集合,也可以是整个欧式空间,输入空间与输出空间可以是同一个空间也可以不同,通常输出空间远远小于输入空间。

每一个具体的输入称为一个实例(instance),通常有特征向量(feature vector)表示,特征空间每一维对应一个特征,有时假设输入空间和特征空间为相同空间,不予区分;有时假设其为不同空间,将实例从输入空间映射到特征空间。模型实际上都是定义在特征空间的。

在监督学习中,将输入和输出看做是定义在输入(特征)输出空间上的随机变量的取值,输入输出用大写字母表示,习惯上输入用X,输出用Y。输入输出的值用小写字母表示,输入用x输出用y。变量可以是标量可以是向量,不做区分。输入输出变量可以是连续的也可以是离散的。

监督学习从训练数据集合中学习模型,对测试数据进行预测,训练数据有输入(特征向量)与输出对组成,其又被称为样本(sample)或样本点

输入与输出便令均为连续变量的称为回归问题;

输出变量为有限个离散变量的预测问题称为分类问题;

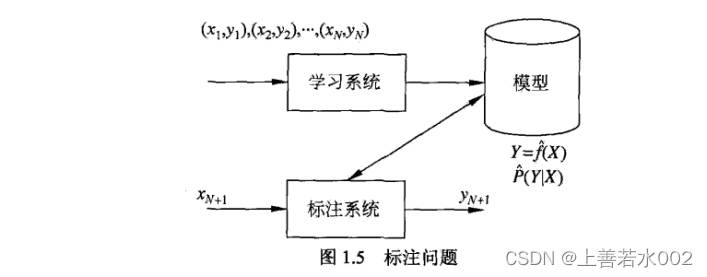

输入变量和输出变量均为变量序列的问题称为标注问题;

监督学习对于数据的基本假设:输入与输出的随机变量X和Y遵循联合概率分布P(X,Y)。P(X,Y)表示分布函数,或分布密度函数。训练数据和测试数据被看作是依照联合概率分不P(X,Y)独立同分布产生。

监督学习的目的在于学习一个有输入到输出的映射。这一映射有模型来表示。模型属于由输入空间到输出空间的映射集合,这个集合就是假设空间。假设空间的确定意味着学习范围的确定

监督学习的模型可以是概率模型或非概率模型。由条件概率分布P(Y|X)或决策函数Y=f(X)表示,随具体学习方法而定。对具体输入进行输出预测时写作P(y|x)或y=f(x)。

问题的形式化

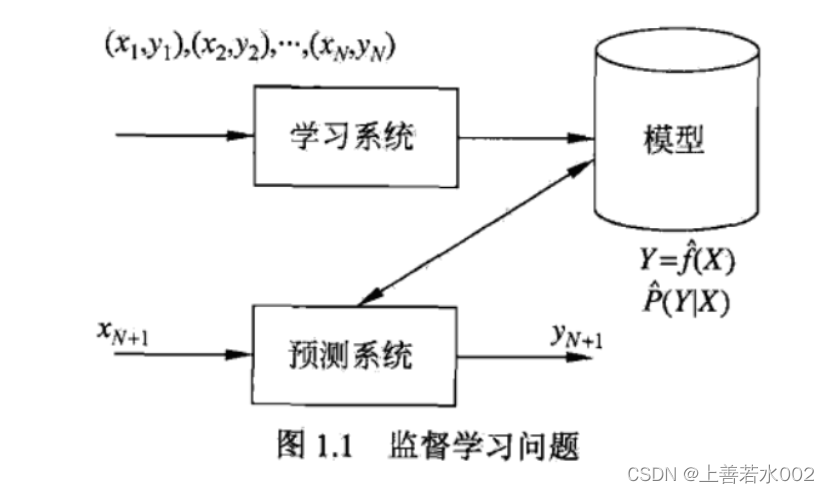

监督学习分为学习和预测两个过程,由学习系统和预测系统完成。

在学习过程中,学习系统利用给定的训练数据集,通过学习和训练得到一个模型,在预测过程中预测系统对于给定的测试样本集中的输入,由学习得到的模型给出相应的输出。

统计学习三要素

模型

所要学习的条件概率分布或决策函数

假设空间包含所有可能的条件概率分布和决策函数。

假设空间用F表示,则F={f|Y=f(X)}或F={P|(Y|X)}

策略

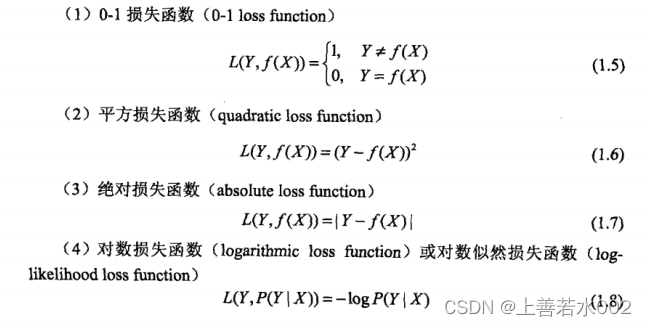

损失函数(loss function)/代价函数(cost function):度量模型一次预测的好坏。

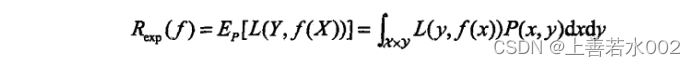

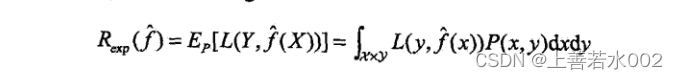

函数损失值越小,模型就越好,模型输入输出(X,Y)是随机变量,遵循联合分布P(X,Y),所以损失函数的期望是

风险函数(risk function):平均意义下模型预测的好坏。上图值称为风险函数(risk function)或期望损失(expected loss)

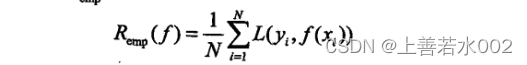

训练集的平均损失称为经验风险(empirical risk)或经验损失(empirical loss)记作Remp

**经验风险最小化(empirical risk minimization ,ERM)**认为经验风险最小的就是最优模型,当样本足够大时,经验风险能保证有很好的学习效果,在现实中被广泛采用,如极大似然估计(maximum likelihood estimation),损失函数是对数损失函数时经验风险最小化就等价于极大似然估计。当样本很小时会产生过拟合(over-fitting)现象。

**结构风险最大化(structural risk minimization ,SRM)**是为了防止过拟合现象提出的策略。结构风险最小化等价于正则化,结构风险在经验风险上加上表示模型复杂度的正则化项或罚项。如贝叶斯估计中的最大后验概率估计(maximum posterior probability estimation,MAP)。当模型是条件概率分布,损失函数是对数函数,模型复杂度由模型的先验概率表示时,结构风险最小化就等价于最大后验概率估计。结构风险最小化认为结构风险最小的模型就是最优的模型。

由此,监督学习问题就变成经验风险或结构风险函数最优化问题

算法

算法指学习模型的具体计算方法,统计学习基于训练数据集,根据学习策略,从假设空间中选择最优模型,最后需要考虑用什么样的计算方法求解最优模型

模型的评估和选择

训练误差和测试误差

训练误差:训练数据集的平均损失

测试误差:测试数据集的平均损失

训练误差和测试误差是评估学习方法的标准。,统计学习采用的损失函数未必是评估时使用的损失函数,理想状态是让两者一致。

过拟合和模型选择

过拟合:学习时选择的模型包含的参数过多,以致于对这一模型的已知数据预测很好,对未知数据预测很差。

模型选择:如果在假设空间中存在“真”模型,那么所选择的模型应该逼近真模型,即所选模型要与真模型参数个数相同,所选模型参数向量要与真模型参数向量相同,常见的模型选择方法由正则化和交叉验证

正则化与交叉验证

正则化

正则化是结构风险最小化策略的实现,实在经验风险上加一个正则化项或罚项,正则化项一般是模型复杂度的单调递增函数,模型越复杂,正则化值越大。

正则化符合奥克姆剃刀原理(如无必要勿增实体):在所有可能的模型中,能够很好地解释已知数据并且十分简单的才是最好的模型,也是应该选择的模型。

交叉验证

如果样本充足,可以将数据集随机的分为训练集,验证集,测试集。其中验证集用于选择模型,因为验证集拥有足够多的数据,所以它对模型的选择也是有效的。

在样本不充足的情况下可以采用交叉验证方法,其本质思想就是重复使用数据。

1.简单交叉验证

随机的将数据分为训练集和测试集,用训练集在各种条件下训练模型,从而得到不同模型,选出测试误差最小的模型

2.S折交叉验证(S-fold cross validation)

j将数据且分为S个互不相交的的大小相同的子集,利用S-1个子集的数据训练模型,剩下的测试模型;这一过程对可能的S中选择重复进行,最后选出S次评测中平均测试误差最小的模型。

3.留一交叉验证(leave-one-out cross validation)

S交叉验证的特殊情况是S=N,称为留一交叉验证,往往在数据缺乏的情况下使用。N是数据集的容量。

泛化能力(generalization ability)

泛化误差

定义:如果学到的模型是f,那么用这个模型对未知数据预测的误差即为泛化误差。

泛化误差反映了学习方法的泛化能力,如果一种方法学习的模型比另一种方法学习的模型具有更小的泛化误差,那么这种方法就更有效。事实上,泛化误差就是模型的期望风险。

泛化误差上界(generalization error bound)

泛化误差上界即泛化误差概率的上界,学习方法的泛化能力往往用泛化误差的概率上界来评估。泛化误差上界具有以下性质:它是样本容量的函数当样本容量增加时,泛化上届趋于零;它是假设空间容量的函数,假设空间容量越大,模型就越难学,泛化 误差上界就越大。

生成和判别模型

监督学习分为生成方法(generative approach)和判别方法(discriminative approach)。所学到的模型分别称为生成模型(generative model)和判别模型(discriminative model)

生成方法:由数据学习联合概率分布

P

(

X

,

Y

)

P(X,Y)

P(X,Y),然后求出条件概率分布

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X)作为预测的模型,即生成模型。

生成方法特点:可以还原出联合概率分布

P

(

X

,

Y

)

P(X,Y)

P(X,Y)而判别方法不能;生成方法的学习收敛速度更快,当样本容量增加时学到的模型能更快的收敛于真实模型;当存在隐变量时,仍可使用生成方法,此时判别方法就不能用

判别方法:由数据直接学习决策函数

f

(

X

)

f(X)

f(X)或者条件概率分布

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X)作为预测的模型,即判别模型。

判别方法特点:判别方法直接学习的是决策函数

f

(

X

)

f(X)

f(X)或者条件概率分布

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X),直接面对预测,往往准确率更高;因为直接学习

f

(

X

)

f(X)

f(X)或

P

(

Y

∣

X

)

P(Y|X)

P(Y∣X),可以对数据进行各种程度的抽象,定义特征并使用特征,因此可以简化学习问题。

分类问题

当输出变量

Y

Y

Y取有限个离散值时,预测问题便是分类问题。监督学习在数据中学习的一个分类模型或决策函数,称为分类器。分类器对新的输入进行预测,称为分类,可能的输出称为类。当有多个类别时称为多类分类问题。

评价分类器的性能指标一般为分类准确率(accuracy):对于给定的测试数据集,分类器正确分类的样本数与总样本数之比。

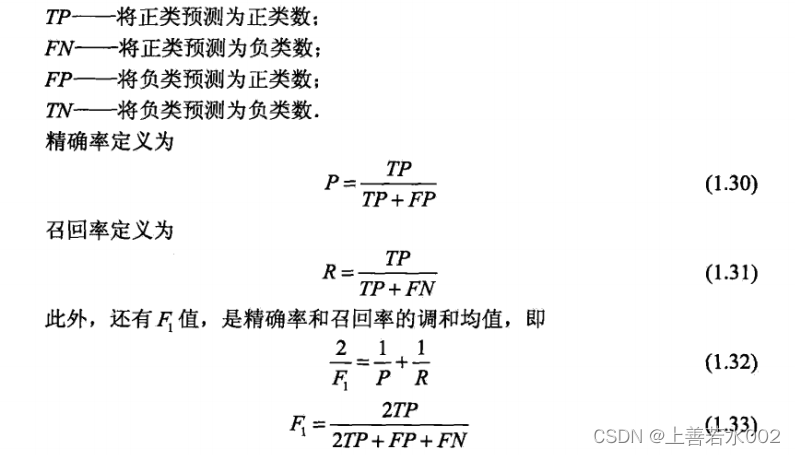

对于二类分类问题常用的评价指标是精确率(precision)与召回率(recall)。通常以关注的类为正类,其他类为负类。

许多方法可以用于分类问题,如感知机,朴素贝叶斯法,决策树,决策列表,等

标注问题

可以认为标注问题是分类问题的一个推广,标注问题是更复杂的结构预测问题的简单形式。其输入是一个观测序列,输出是一个标记序列或状态序列。标注分为标记和学习两个部分。

评价标注模型的指标和评价分类模型的指标一样,常用的有标注准确率,精确率,召回率,其定义与分类相同。

回归问题

回归(regression)用于预测输入变量和输出变量之间的关系。回归模型正式表示输入变量到输出变量之间映射的函数,回归问题的学习等价于函数拟合。回归问题按照输入变量的个数分为一元回归和多元回归;按照输入变量如输出变量之间的关系类型即模型的类型分为线性回归和非线性回归

回归学习最常用的损失函数是平方损失函数,在此情况下,回归问题可以由最小二乘法(least squares)求解

341

341

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?