在训练神经网络时,批量大小(batch size)与损失(loss)之间有着密切的关系。以下是一些关键点和影响因素:

1. 批量大小对梯度估计的影响

-

小批量:

- 优点:小批量可以增加梯度更新的频率,使得模型参数更快地更新,从而更快地逼近最优值。此外,小批量训练中噪声较大,可以帮助模型跳出局部最优解,有助于更好地探索损失空间。

- 缺点:小批量的梯度估计不如大批量稳定,可能导致损失曲线波动较大,并且训练时间较长(因为需要更多的迭代次数)。

-

大批量:

- 优点:大批量训练的梯度估计更精确,损失曲线更平滑,模型收敛更加稳定。对于使用GPU的情况下,大批量训练可以更好地利用并行计算资源。

- 缺点:虽然大批量训练的每次迭代更高效,但每个epoch的更新频率较低,可能导致训练时间更长。此外,大批量训练容易陷入局部最优,泛化能力可能较差。

2. 损失曲线的稳定性

- 小批量:由于每次更新的梯度受限于小样本的随机性,损失曲线可能会出现较大的波动。这种波动在一定程度上有助于跳出局部最优,但也可能导致训练不稳定。

- 大批量:损失曲线更加平滑,因为每次更新的梯度更接近全局梯度。虽然训练过程更稳定,但有可能陷入局部最优。

3. 训练速度

- 小批量:需要更多的迭代次数来完成一个epoch,因此训练时间较长。

- 大批量:每个epoch的迭代次数减少,但每次迭代的计算量较大,整体训练时间可能更短。

实验和示例代码

通过以下示例代码,可以观察不同批量大小对训练损失的影响:

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, TensorDataset

import matplotlib.pyplot as plt

# 定义一个简单的神经网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(784, 256)

self.fc2 = nn.Linear(256, 128)

self.fc3 = nn.Linear(128, 10)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

# 生成指定大小的数据集

def generate_dataset(size):

input_data = torch.randn(size, 784)

labels = torch.randint(0, 10, (size,))

return TensorDataset(input_data, labels)

# 训练函数

def train_model(dataset, batch_size, num_epochs=20):

train_loader = DataLoader(dataset, batch_size=batch_size, shuffle=True)

model = SimpleNet()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

train_losses = []

for epoch in range(num_epochs):

model.train()

running_loss = 0.0

for inputs, targets in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

running_loss += loss.item()

train_loss = running_loss / len(train_loader)

train_losses.append(train_loss)

print(f'Epoch {epoch + 1}/{num_epochs}, Batch Size: {batch_size}, Loss: {train_loss:.4f}')

return train_losses

# 生成数据集并进行训练

dataset = generate_dataset(10000)

batch_sizes = [16, 32, 64, 128]

results = {}

for batch_size in batch_sizes:

print(f"\nTraining with batch size: {batch_size}")

train_losses = train_model(dataset, batch_size, num_epochs=20)

results[batch_size] = train_losses

# 绘制训练损失曲线

plt.figure(figsize=(14, 6))

for batch_size, train_losses in results.items():

plt.plot(range(1, 21), train_losses, label=f'Batch Size {batch_size}')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.title('Training Loss for Different Batch Sizes')

plt.show()

结果分析

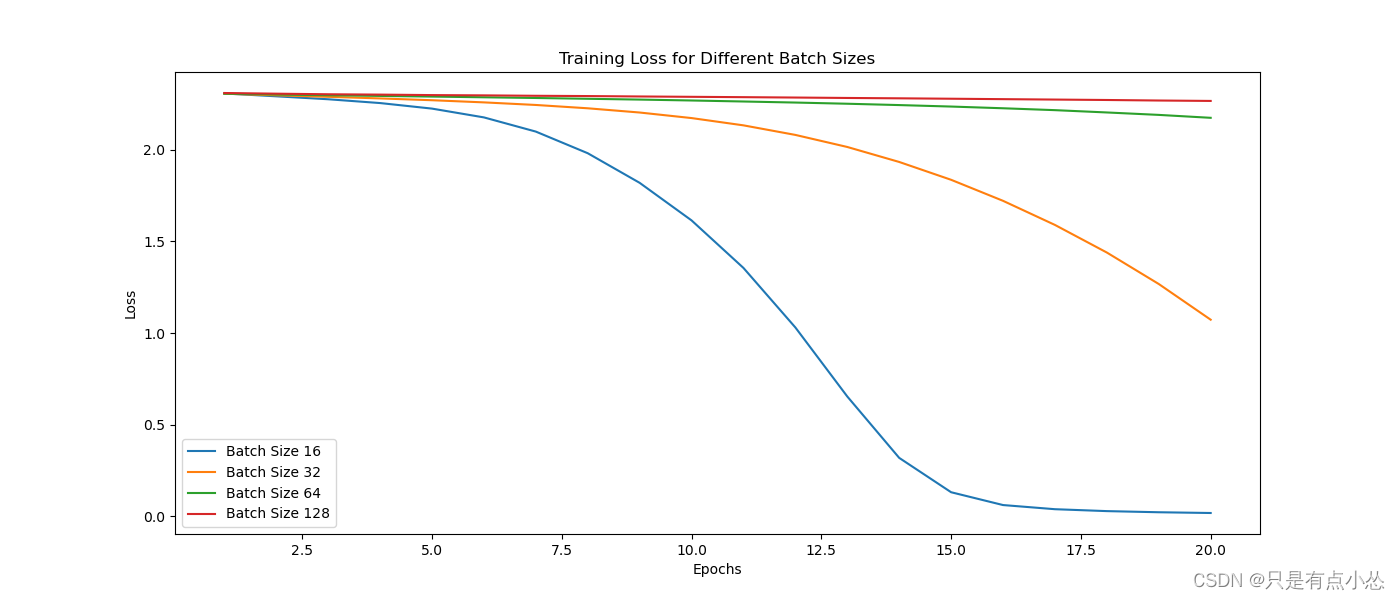

通过对不同批量大小的训练损失进行比较,可以观察到:

- 小批量训练:损失曲线可能会有较大的波动,但在某些情况下能够更快地逼近最优值。

- 大批量训练:损失曲线更加平滑,训练过程更稳定,但可能需要更多的时间来达到相同的损失水平。

总结

批量大小对训练过程中的损失曲线有重要影响。小批量可以加快收敛速度但可能导致损失曲线波动较大;大批量可以提供更稳定的训练过程但可能需要更多的时间来达到最优结果。在实际应用中,需要根据具体情况和硬件条件选择合适的批量大小。

1851

1851

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?