一、数据生成脚本

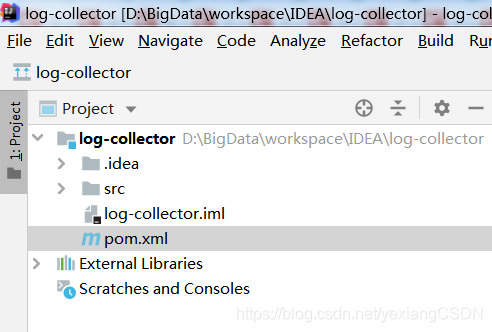

1. 创建Maven项目

2. 修改 pom.xml

- 注意 <mainClass>com.yx.demo.AppMain</mainClass> ,这个是全类名

<!--版本号统一-->

<properties>

<slf4j.version>1.7.20</slf4j.version>

<logback.version>1.0.7</logback.version>

</properties>

<!-- json框架

1. 解析JSON框架 FastJson

2. 日志记录框架 logback

本文介绍了如何生成大数据项目所需的数据脚本,包括创建Maven项目,配置pom.xml,编写Bean和logback.xml,打包并上传jar包到服务器。接着详细阐述了如何运行log-collectort编译的jar包,编写生成日志和修改日期时间的脚本,以及如何在不需要输入密码的情况下执行root权限命令。

本文介绍了如何生成大数据项目所需的数据脚本,包括创建Maven项目,配置pom.xml,编写Bean和logback.xml,打包并上传jar包到服务器。接着详细阐述了如何运行log-collectort编译的jar包,编写生成日志和修改日期时间的脚本,以及如何在不需要输入密码的情况下执行root权限命令。

订阅专栏 解锁全文

订阅专栏 解锁全文

1204

1204

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?