文章转自公众号老刘说NLP

我们来看看两个问题,一个是对昨日的相关进展进行回顾。

另一个是对几个面向RAG任务的开源微调大模型进行介绍,尝试从数据侧给做一些总结。

这两个工作都很有趣,仔细读读,都会有收获。

一、昨日大模型相关进展早报

我们来看看回顾昨日大模型进展早报,社区常规活动之一,如下:

其中,主要涵盖在关于RAG进展。三阶段问答思路R2GQA、大模型的偏好学习综述、开源进展MiniCPM 3.0、时关时序知识图谱进展-时序知识图谱表示与推理的研究进展与趋势、关于边缘侧大模型部署总结、关于开源课程,Self Attention by Hand ,手动实现自注意力机制的教程、知识图谱进展Graphiti:构建和查询动态、时间感知的知识图谱以及大模型微调数据合成思路CRAFT及4StepFocus三元组前过滤优化大模型问答方案等。

突破性的进展不多,不温不火,但跟进还是有意义的。

二、几个面向RAG任务的微调大模型

通过搜索huggingface的方式,我们可以找到MiniCPM3-RAG-LoRA、Mixtral_13B_Chat_RAG-Reader、Orion-14B-RAG、Llama-3-8B-RAG-v1以及Mistral-RAG等大模型。

1、MiniCPM3-RAG-LoRA

MiniCPM3-RAG-LoRA(https://huggingface.co/openbmb/MiniCPM3-RAG-LoRA)是一个专门面向检索增强生成(RAG)场景的生成模型。

它在MiniCPM3 的基础上,采用低秩适应(LoRA)技术,通过直接偏好优化(DPO)方法进行微调,仅基于两万余条开放域问答和逻辑推理任务的开源数据,在通用评测数据集上实现了模型性能平均提升约 13%。

可以看看其训练数据格式,MiniCPM3-RAG-LoRA模型遵循格式如下:

MiniCPM3-RAG-LoRA supports instructions in the following format:

对应微调数据:

Passages = "In the novel 'The Silent Watcher,' the lead character is named Alex Carter. Alex is a private detective who uncovers a series of mysterious events in a small town.\nSet in a quiet town, 'The Silent Watcher' follows Alex Carter, a former police officer turned private investigator, as he unravels the town's dark secrets.\n'The Silent Watcher' revolves around Alex Carter's journey as he confronts his past while solving complex cases in his hometown.",

Instruction = "Q: What is the name of the lead character in the novel 'The Silent Watcher'?\nA:"

Input = 'Background:\n'+ Passages + '\n\n' + Instruction

2、Mixtral_13B_Chat_RAG-Reader

Mixtral_13B_Chat_RAG-Reader(https://huggingface.co/HIT-TMG/Mixtral_13B_Chat_RAG-Reader),基于Mixtral_13B_Chat进行为微调形成的RAG模型。

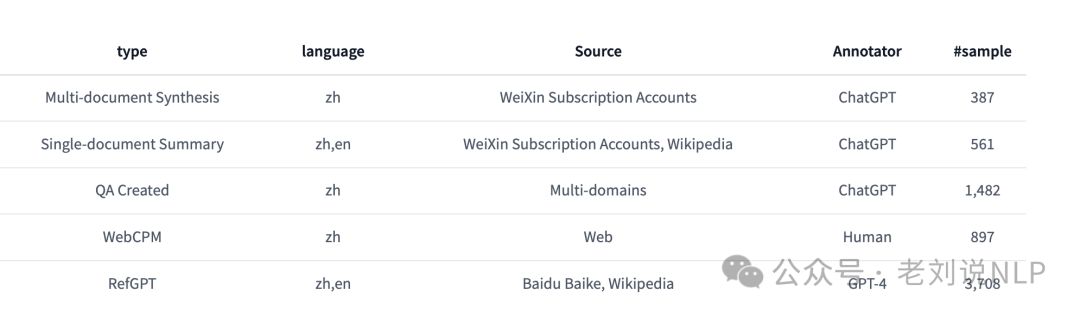

其微调数据使用TruthReader(https://huggingface.co/datasets/HIT-TMG/TruthReader_RAG_train)

其数据集构成如下:

其微调数据格式如下:

请基于给定的文档,生成问题的答案。如果文档中没有包含答案的信息,请回复抱歉并给出理由。

# DOCUMENTS:

## 文档[1] this is dummy title 1

this is dummy document text 1

## 文档[2] this is dummy title 2

this is dummy document text 2

# QUESTION: this is a dummy question

# ANSWER:

3、Orion-14B-RAG

Orion-14B-Chat-RAG(https://huggingface.co/OrionStarAI/Orion-14B-Chat-RAG),在一个定制的检索增强生成数据集上进行微调的聊天模型,但是细节并未公开。

地址:https://modelscope.cn/models/OrionStarAI/Orion-14B-Chat-RAG/summary

4、Llama-3-8B-RAG-v1

Llama-3-8B-RAG-v1(https://huggingface.co/glaiveai/Llama-3-8B-RAG-v1)基于Llama-3-8B,利用Glaive-RAG-v1数据集微调而成。

对应的数据集在:

Glaive-RAG-v1(https://huggingface.co/datasets/glaiveai/RAG-v1):

也可以顺便来看看数据的构成,如上表所示,包括List of documents for context、Question、Answer Mode、Answer几个字段。

其中,Answer Mode定义了模型是否应该只输出基于事实的回答,或者是否应该结合其内部信息。

Answer在开头引用了相关文档,并且在文本中使用了 <co:1> 标签来标记引用。

因此,答案中文章的引用信息也是直接生成的。

5、Mistral-RAG

Mistral-RAG(https://huggingface.co/DeepMount00/Mistral-RAG)是Mistral-Ita-7b模型的微调版本,专门设计用于增强问答任务。

其使用的数据为:https://huggingface.co/datasets/DeepMount00/gquad_it

同类型的,还有Minerva-3B-base-RAG(https://huggingface.co/DeepMount00/Minerva-3B-base-RAG)

总结

本文主要讲了两个事儿,一个是对昨日的相关进展进行回顾。另一个是对几个面向RAG任务的开源微调大模型进行介绍,尝试从数据侧给做一些总结。

常总结,常看,常思考,总会有很多进步。

清醒前进,踏实进步。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?