提到“大模型”,你最先想到的是不是OpenAI的ChatGPT、DeepSeek这类对话工具?或是能生成图片的MidJourney、写代码的GitHub Copilot?甚至是商场里能指路、工厂里会巡检的智能机器人?再往深想,或许还能说出“训练要喂数据”“推理是出结果”这样的关键词。

有没有一种强烈的感受:铺天盖地的报道、产品更新、行业论坛,都在渲染大模型的颠覆性——仿佛今天不摸透它,明天就会被技术浪潮甩在身后?

如果你有这种紧迫感,其实很正常。我曾经也被这种“知识焦虑”推着走,直到某天下定决心:与其被动听别人说,不如主动搞懂大模型的底层逻辑。于是就有了这篇文章:搞懂文中的核心概念,你就已经超过80%的“跟风讨论者”;若能理清原理,就算得上半个“懂行的人”,和他人交流时也能言之有物,不用怕露怯。

当然,专业知识的阅读体验,肯定比不上刷娱乐八卦轻松。但希望我们能一起沉下心来——毕竟,对新技术的理解,从来都是拉开差距的关键。接下来,咱们一步步拆解大模型的“骨架”。

一、从AI到深度学习:大模型的技术基石

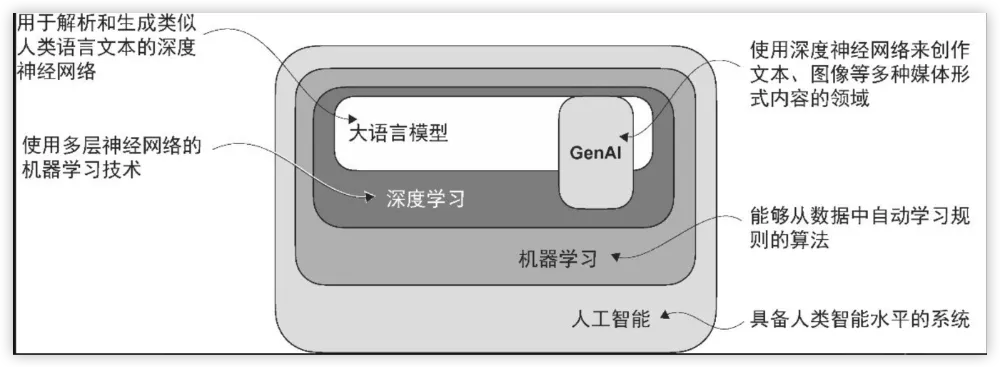

首先得理清三个绕不开的概念:人工智能(AI)、机器学习(Machine Learning) 和深度学习(Deep Learning)。它们不是并列关系,而是“顶层范畴→核心方法→关键分支”的逻辑链:

- 人工智能(Artificial Intelligence, AI):是最宽泛的概念,指让机器具备“模拟人类智能”的能力,比如判断、推理、学习。

- 机器学习(Machine Learning, ML):是实现AI的核心技术——它让机器不用被“逐行编程”,而是通过“数据训练”自主学习规律(比如从海量邮件中识别垃圾邮件)。

- 深度学习(Deep Learning, DL):是机器学习的“进阶分支”,核心是多层神经网络(类似人类大脑的神经元连接),能处理更复杂的数据(比如长文本、图像),也是如今大模型能“读懂语言、生成内容”的根本。

简单说:没有深度学习的突破,就没有今天能理解上下文、写文章、做翻译的大模型。比如以前的翻译工具,可能只会逐词对应(像“你好”直接译成“Hello”),而基于深度学习的大模型,能理解“苹果”在“吃苹果”和“苹果公司”中的不同含义,甚至还原句子的语气(比如区分“你真行”是表扬还是反讽)。

正是深度学习的发展,让大模型能“吞噬”海量文本数据,捕捉人类语言的细微差别——这也是它在翻译、情感分析、问答等任务中,比传统方法强得多的原因。

二、LLM:大语言模型到底“大”在哪?

我们常说的“大模型”,全称是大语言模型(Large Language Model, LLM) ——它是一种能理解、生成、响应人类语言的深度神经网络。

先明确两个关键属性:

-

“大”的两层含义

一是数据规模大:训练数据几乎覆盖了互联网上大部分公开文本(比如GPT-4的训练数据包含万亿级别的书籍、网页、学术论文、新闻);二是模型参数大:参数是神经网络里的“可调权重”,LLM通常有数百亿甚至数千亿个参数(比如GPT-3有1750亿个参数),参数越多,模型能学习的语言规律越精细。 -

“理解”≠人类的意识

当我们说LLM“懂”语言时,其实是它能基于训练数据,生成“符合语境、逻辑连贯”的文本——比如你问“如何煮奶茶”,它能列出步骤,但这不是因为它“会煮奶茶”,而是它从海量食谱中学习了“煮奶茶”的文本模式,本质是“概率性的文本生成”,没有人类那样的意识和体验。

LLM还有两个重要标签:

- 生成式AI(Generative AI/GenAI):因为它能主动生成文本(比如写报告、编故事),而不只是“分析已有文本”(比如给文章打标签),所以被归为生成式AI的核心应用。

- 定制化趋势:现在很多LLM不再追求“通用全能”,而是向“领域专用”发展。比如金融领域的LLM能分析财报、生成研报;医疗领域的LLM能解读电子病历、回答患者的健康咨询。这类定制模型有个明显优势:数据隐私可控——比如医院的模型不会把患者数据传给第三方(如OpenAI),符合HIPAA(美国医疗隐私法规)或国内的《个人信息保护法》。此外,小体量的定制模型还能“本地部署”(比如装在企业的服务器、员工的笔记本上),不仅响应速度从“秒级”缩到“毫秒级”,还能省下服务器租赁成本,避免网络波动导致的服务中断。

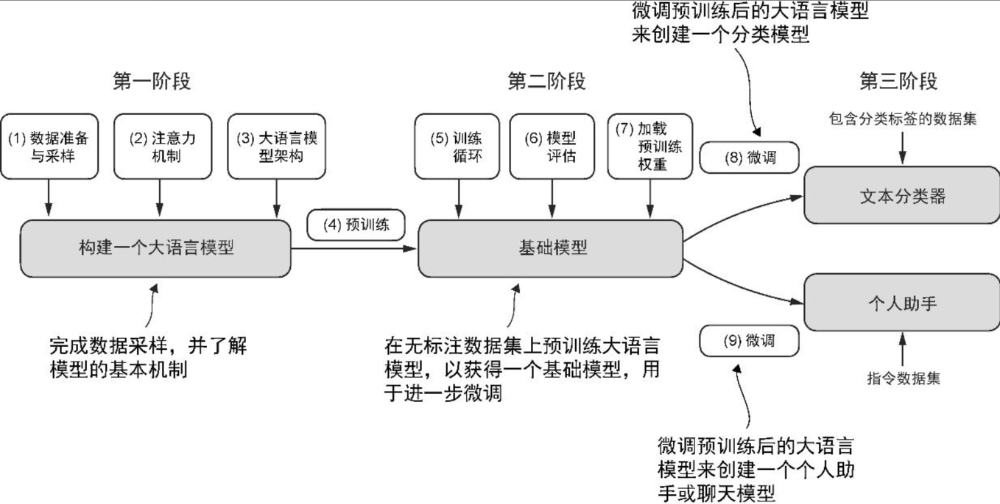

三、预训练与微调:LLM的“两步成长法”

要打造一个能用的LLM,通常要走“预训练→微调”两步,就像人先“读万卷书”,再“学专业技能”。

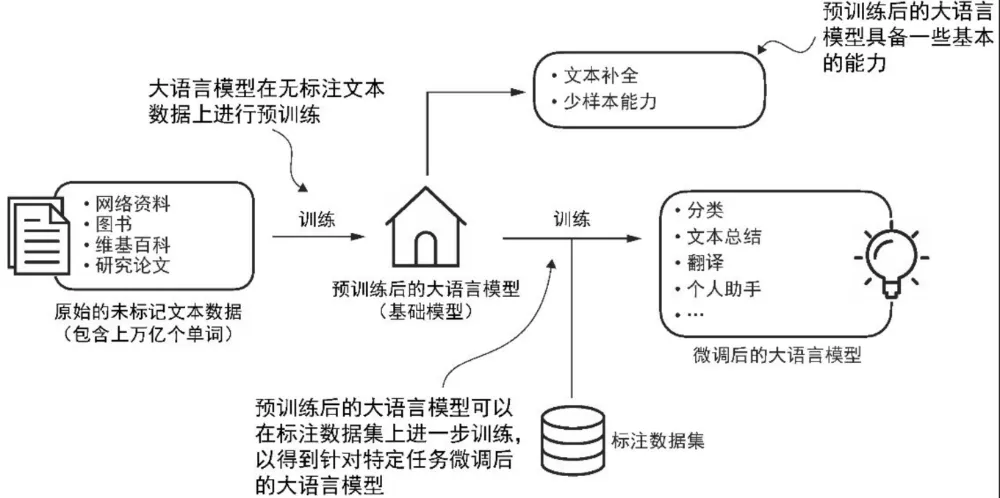

1. 预训练:让模型“打好语言基础”

定义:用大规模、无标注的通用数据(比如全网公开的文章、书籍、论坛内容)对模型进行“初步训练”,让它掌握语言的基本规律(语法、常识、逻辑),相当于给模型搭建“通用语言能力框架”。

这一步的核心是“无标注数据”——不用人工给数据打标签(比如不用标注“这句话是新闻”“这句话是小说”),模型自己从数据中学习。预训练后的模型被称为“基础模型(Foundation Model)”,就像刚毕业的大学生,有通用知识,但还没掌握具体工作技能。

比如GPT-3的预训练:它在3000亿个词元(文本的基本单位,后文会讲)上学习,最终能完成“文本补全”(比如你输入“床前明月光,疑是”,它能补“地上霜”),还具备“少样本学习”能力——给它几个例子(比如“北京→中国,巴黎→法国”),它就能学会“城市→国家”的对应关系,不用再大量训练。

2. 微调:让模型“适配具体任务”

定义:在预训练好的基础模型上,用“小规模、有标注的特定任务数据”进一步训练,调整模型参数,让它专注于某类场景(比如从“通用对话”变成“电商客服”)。

常见的微调方式有两种:

- 指令微调(Instruction Tuning):用“指令→答案”的配对数据训练,比如翻译任务用“把‘我爱中国’译成英文→I love China”,客服任务用“用户问‘退货要多久’→回答‘退货审核需1-3个工作日’”。

- 分类任务微调(Classification Tuning):用“文本→类别标签”的数据训练,比如垃圾邮件识别用“邮件内容:‘恭喜您中了100万’→标签:垃圾邮件”,情感分析用“评论:‘这手机续航太差’→标签:负面”。

举个实际案例:一个通用LLM要变成“教育辅导模型”,微调时会用“数学题→解题步骤”“作文批改示例”等数据训练,最终它能帮学生讲题、改作文,而不是像通用模型那样“什么都能聊,但聊教育不够专业”。

四、Transformer架构:LLM的“发动机”

如果说深度学习是LLM的“地基”,那Transformer架构就是LLM的“发动机”——当前主流的LLM(比如GPT、BERT),都基于这个架构构建。

Transformer是谷歌在2017年发表的论文《Attention Is All You Need》中提出的,最初是为“机器翻译”设计(比如把英文译成德语),但后来发现它在所有NLP任务中都很高效——彻底替代了之前的RNN(循环神经网络)(RNN处理长文本时会“记不住前面的内容”,比如处理1000字的文章,后面的词会忘了前面的逻辑)。

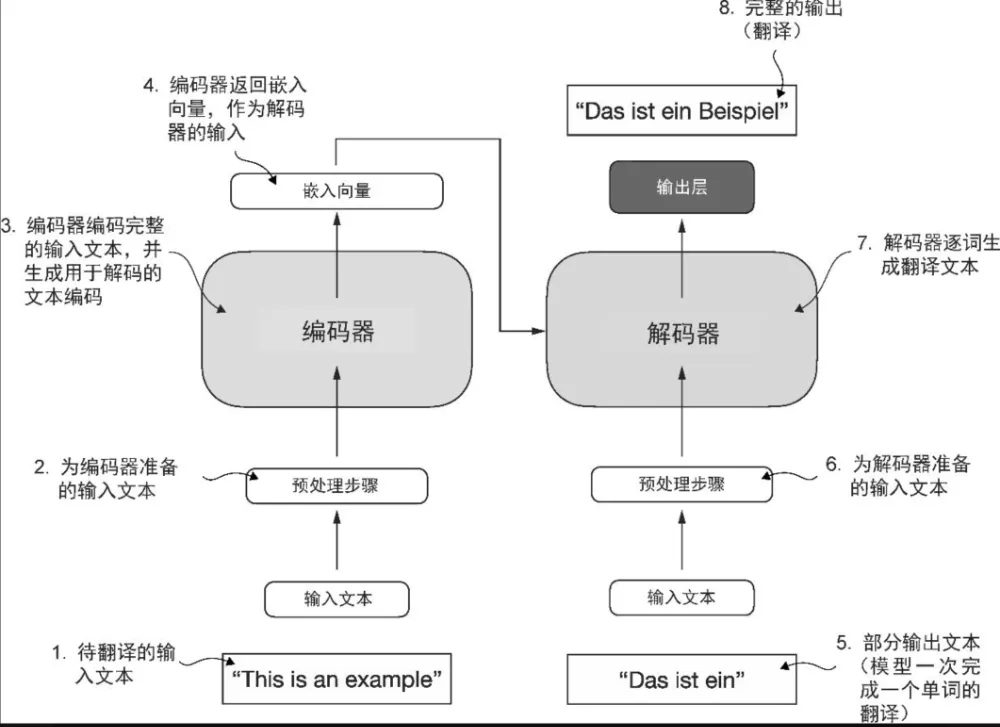

Transformer的核心:编码器与解码器

Transformer由两个关键模块组成,分工明确:

- 编码器(Encoder):负责“理解输入文本”——把文本转换成模型能处理的“数值向量”(类似给文本做“数字编码”),同时捕捉文本中的上下文关系(比如“小明”和“他”的指代关系)。

- 解码器(Decoder):负责“生成输出文本”——接收编码器的“数字编码”,然后逐词生成符合需求的内容(比如翻译时,解码器根据英文的编码,生成对应的中文)。

无论是编码器还是解码器,都依赖一个“黑科技”——自注意力机制(Self-Attention Mechanism)。它能让模型在处理文本时,“重点关注重要的词”:比如在“小明带小红去公园,她很开心”这句话里,自注意力机制会让模型知道“她”指的是“小红”,而不是“小明”;在“苹果发布了新手机”里,“苹果”指的是公司,不是水果。

这里要澄清一个误区:不是所有Transformer都是LLM,也不是所有LLM都用Transformer。比如Transformer也能用于计算机视觉(比如图像识别),而早期的一些LLM,用的是RNN或卷积神经网络(CNN)架构——只是现在Transformer因为效率高,成了主流。

五、GPT与BERT:Transformer架构的“两大明星”

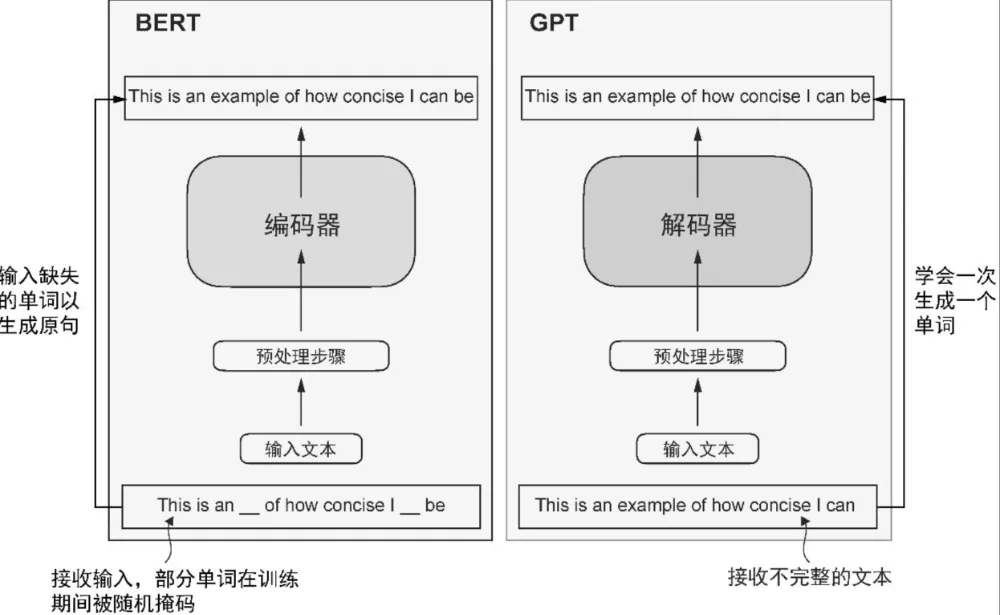

同样基于Transformer,GPT和BERT的“分工”却完全不同——一个擅长“生成文本”,一个擅长“理解文本”,相当于“作家”和“评论家”。

1. GPT:专注“生成”的“作家”

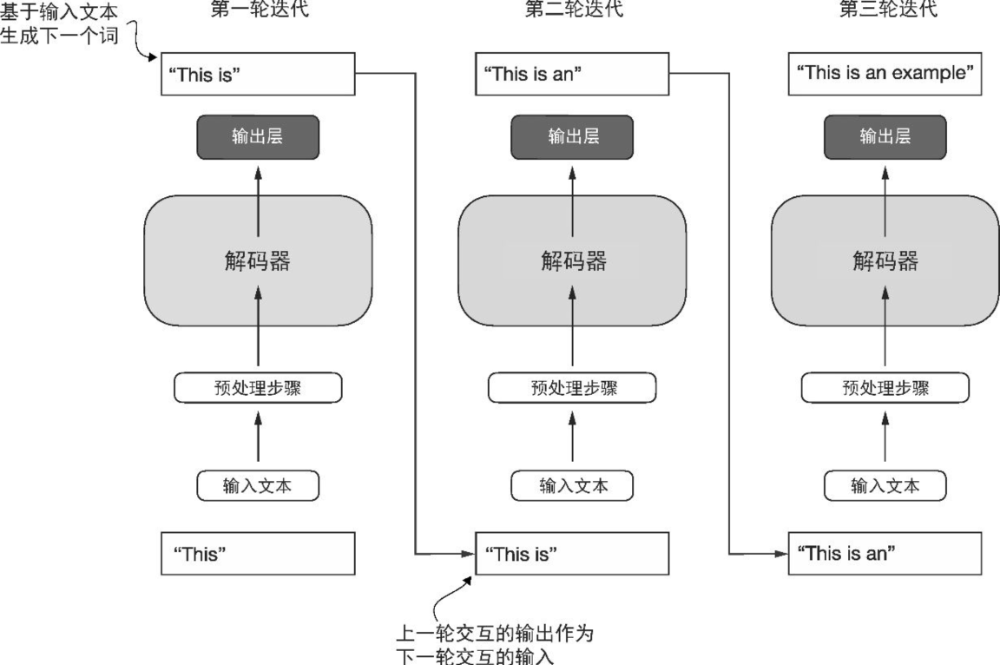

GPT的全称是生成式预训练Transformer(Generative Pre-trained Transformer),它的核心特点是:

- 只用Transformer的解码器:没有编码器,专注于“逐词生成文本”,属于“自回归模型”——简单说,就是用前面生成的词,预测下一个词(比如写“今天天气很好,我打算去”,它会根据“天气好”“打算去”的上下文,预测下一个词可能是“公园”“爬山”“散步”)。

- 涌现能力(Emergence):这是GPT的“惊喜之处”——它没被专门训练过某类任务,却能靠预训练时学的海量数据“自主解锁技能”。比如GPT-3没学过代码生成,却能写出简单的Python脚本;没学过写诗,却能模仿唐诗的韵律。

- 擅长的任务:文本创作(写邮件、小说)、对话交互(客服、聊天机器人)、代码生成(GitHub Copilot就是基于GPT架构)、机器翻译等。

以GPT-3为例:它有96层Transformer解码器,1750亿个参数,虽然没专门针对“翻译”训练,但能把英文“Today is a sunny day”准确译成中文——这就是解码器架构+海量数据训练的效果。

2. BERT:专注“理解”的“评论家”

BERT的全称是双向编码器表示来自Transformer(Bidirectional Encoder Representations from Transformers),它的核心特点是:

- 只用Transformer的编码器:没有解码器,专注于“理解文本含义”,属于“双向理解模型”——和GPT“从左到右逐词预测”不同,BERT能同时看一个词的“左边和右边”(比如“[MASK]在吃苹果”,它能根据“吃”和“苹果”,双向判断[MASK]处可能是“小明”“孩子”)。

- 核心任务:掩码预测(Masked Word Prediction):训练时,BERT会把文本中的部分词换成“[MASK]”,然后让模型预测被掩盖的词——这个过程能让它更深入地理解上下文逻辑(比如“他买了[MASK],因为想喝热饮”,BERT能预测[MASK]是“咖啡”“奶茶”,而不是“水果”)。

- 擅长的任务:文本分类(垃圾邮件识别、情感分析)、命名实体识别(从“小明在上海工作”中找出“小明”是人名、“上海”是地名)、问答匹配(判断“北京是中国首都吗”的答案是否正确)等。

简单总结:GPT是“Transformer解码器+生成任务”,BERT是“Transformer编码器+理解任务” ——两者就像LLM领域的“双子星”,分别支撑了“生成式应用”和“理解式应用”。

六、Token:LLM“读文本”的“最小单位”

想让LLM处理文本,首先要把人类的文字“翻译成”机器能懂的“数字”——这个过程就需要“Token(词元)”。

Token是LLM处理文本的最小单位,可以理解为“文本的‘原子’”:

- 英文中,Token可能是一个词(比如“apple”)、一个子词(比如“unhappiness”会分成“un-”“happiness”),甚至是一个字符(比如“a”“b”);

- 中文中,Token通常是一个词(比如“人工智能”“电脑”)或一个字(比如“我”“你”),标点符号(“。”“,”)也会被视为独立Token。

比如句子“我喜欢用ChatGPT写文章”,会被拆成这样的Token:[“我”, “喜欢”, “用”, “ChatGPT”, “写”, “文章”]——每个Token都会被转换成一个数字向量,供模型计算。

这里有两个实用知识点:

- Token数量与成本的关系:LLM的训练和使用,通常按“Token数量”收费。比如GPT-3的预训练成本约460万美元,其中很大一部分是处理3000亿个Token的计算资源费用;而现在的轻量级开源模型(如Llama 2-7B),微调时只需处理几百万个Token,成本降到几千美元,让中小企业也能用得起。

- 自监督学习的关键:LLM的“下一单词预测”任务,本质是靠Token实现的“自监督学习”——不用人工给数据打标签,直接用“前N个Token”预测“第N+1个Token”(比如用“我喜欢用ChatGPT”预测下一个Token是“写”)。这种方式能让模型利用海量无标注文本(比如全网的免费文章)训练,大大降低了数据成本。

七、核心知识点总结(清晰版)

- 深度学习:基于多层神经网络的机器学习分支,是LLM的技术基础,能让模型自主学习复杂语言规律。

- Transformer架构:基于自注意力机制的深度学习框架,分编码器(理解文本)和解码器(生成文本),是GPT、BERT的核心。

- LLM(大语言模型):超大规模语言模型,靠“海量数据+千亿级参数”实现语言理解与生成,属于生成式AI的核心。

- GPT:Transformer解码器架构,擅长文本生成(写文章、编代码),有自回归和涌现能力。

- BERT:Transformer编码器架构,擅长文本理解(情感分析、命名实体识别),靠双向掩码预测训练。

- 预训练:用大规模无标注数据训练模型,搭建通用语言能力,产出“基础模型”。

- 微调:用小规模标注数据优化预训练模型,使其适配具体场景(如电商客服、医疗问答)。

- Token:LLM处理文本的最小单位(词、子词、字符),是文本与数字向量的“桥梁”。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?