嗯嗯 今天学习了来自Jack-Cui大大的网络爬虫(四)(http://blog.csdn.net/c406495762/article/details/60137956)

感觉对于一个爬虫来说 最基础的就是四步

from urllib import request第一步 输入网址

url = 'http://www.csdn.net/'第二部 创建 request对象

req = request.Request(url)第三部 传输创建好的对象

response = request.urlopen(req)第四部 读取并解码传输来的信息

html = response.read().decode('utf-8')

然后 就可以对数据进行操作了

这一章讲的是 使用 User-Agent 有些网站就是靠这个来反爬虫的 如果我我们不修改 requset.Request()的 header 参数的话 默认就是Python 这样一看就看出来

所以我们要对其进行伪装

我使用的是

是这个

head['User-Agent']="Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.94 Safari/537.36"

接着是怎么实现

第一方法是 构造一个 字典 head = {} 传参的时候把这个作为参数传进去就可以了

# -*- coding : UTF-8 -*-

from urllib import request

if __name__ == "__main__":

# url = "http;//www.csdn.net/" 不行

url = 'http://www.csdn.net/' #可以

head ={}

head['User-Agent']="Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.94 Safari/537.36"

#创建 request对象

req = request.Request(url,headers = head)

#传输好的request 对象

response = request.urlopen(req)

#读取响应信息并解码

html = response.read().decode('utf-8')

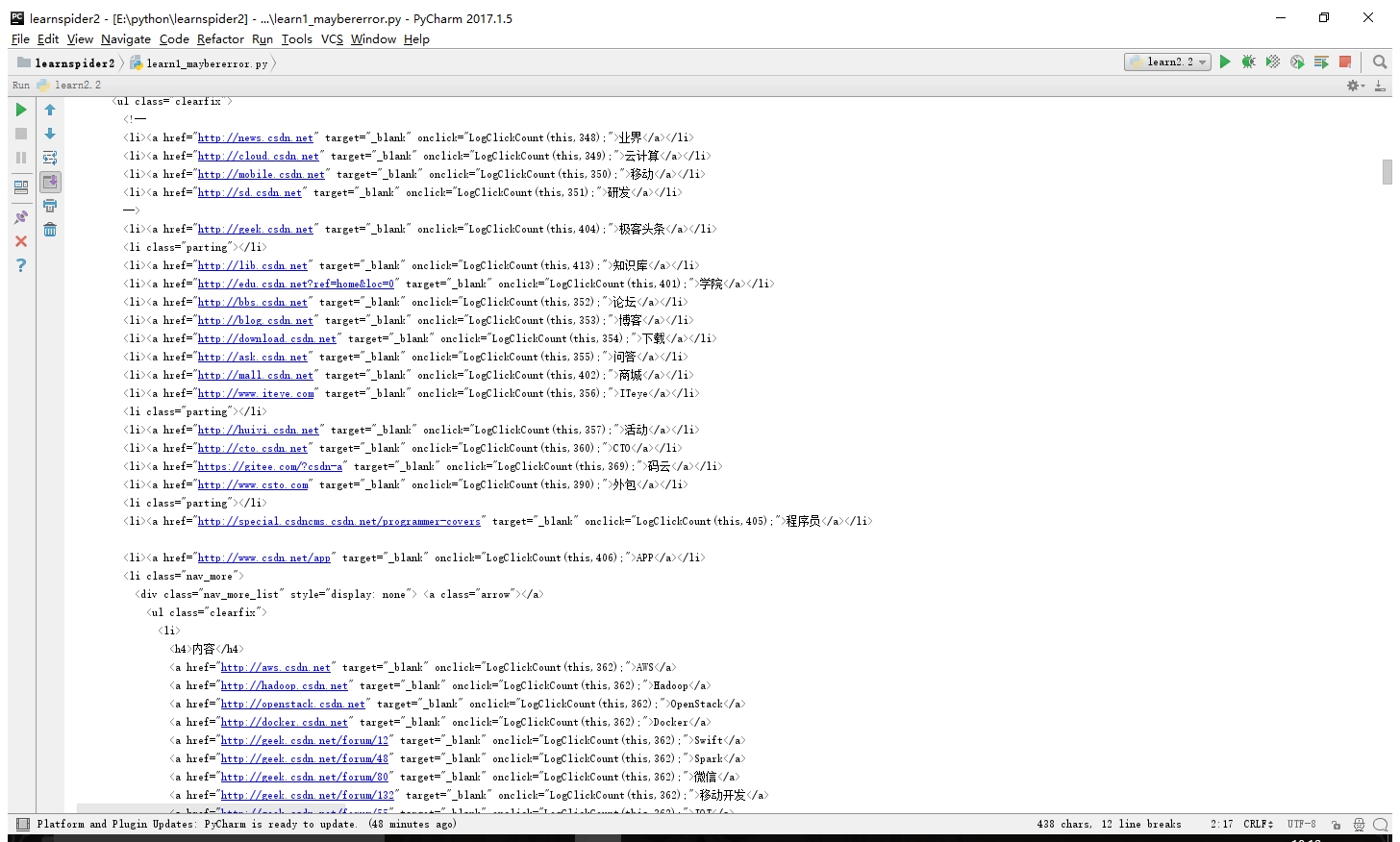

print(html)附上结果

第二种是使用 add_header()函数 这个就是直接创建好request对象之后 往里面传参了

# -*- coding: UTF-8 -*-

from urllib import request

if __name__=="__main__":

url = 'http://www.csdn.net/'

req = request.Request(url)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.2; WOW64; rv:21.0) Gecko/20100101 Firefox/21.0")

response = request.urlopen(req)

#没有弹出后续( •̀ ω •́ )y

html = response.read().decode('utf-8')

print(html)不过作者说 没有UA 的话 可能会出问题 我就想看看会出什么问题 就把那两行代码注释了

#-*- coding: UTF-8 -*-

# 好像不加head 也不是不行

from urllib import request

if __name__=="__main__":

url = 'http://www.csdn.net/'

# head ={}

# head[

# 'User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19'

req = request.Request(url)

response = request.urlopen(req)

html = response.read().decode('utf-8')

print(html)然后结果很迷

还是可以... ...

111

111

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?