前言

GFS是一个可扩展的分布式文件系统,用于大型的、分布式的、对大量数据进行访问的应用。它运行于廉价的普通硬件上,并提供容错功能。它可以给大量的用户提供总体性能较高的服务。

GlusterFS的工作流程

① 客户端或应用程序通过 GlusterFS 的挂载点访问数据;

② linux系统内核**通过 VFS API 虚拟接口收到请求并处理;

③ VFS 将数据递交给 FUSE 内核文件系统,这是一个伪文件系统,这个伪文件系统主要用来转存,它提供一个虚拟接口,映射出来/dev/fuse这样一个虚拟路径,而 FUSE 文件系统则是将数据通过/dev/fuse 设备文件递交给了 GlusterFS client 端。可以将 FUSE 文件系统理解为一个代理

④ GlusterFS client 会实时监听/dev/fuse下的数据,一旦数据更新,会把数据拿过来,client 根据配置文件的配置对数据进行处理

⑤ 经过 GlusterFS client 处理后,通过网络将数据传递至远端的 GlusterFS Server,server会先转存到本地的 vfs 虚拟文件系统中**,然后再通过 vfs 转存到EXT3上。EXT3指的是各个block块中的EXT3文件系统中。

一、准备环境:

Kylin Linux Advanced Server release V10 (SP1) /(Tercel)-x86_64-Build20/20210518 *3台

192.168.1.101 node1

192.168.1.102 node2

192.168.1.103 node3

二、安装部署

2.1 gluster软件安装(所有机器执行)

yum install glusterfs glusterfs-resource-agents glusterfs-devel

执行systemctl start glusterd

或者systemctl enable --now glusterd

2.2 修改hosts文件(所有机器执行)

vim /etc/hosts 添加如下内容:

192.168.1.101 node1

192.168.1.102 node2

192.168.1.103 node3

2.3 创建对应目录(所有机器执行,对应的目录最好是单独分区,本例中非单独分区)

mkdir -p /opt/gluster/data

2.4 添加信任存储池,在node1上执行命令,并查看状态

gluster peer probe node2

gluster peer probe node3

gluster peer status

2.5 创建逻辑卷(node1上执行,逻辑卷类型很多,本例以复制卷为例)

gluster volume create gfs1 replica 3 node1:/opt/gluster/data node2:/opt/gluster/data node3:/opt/gluster/data force

gluster volume start gfs1

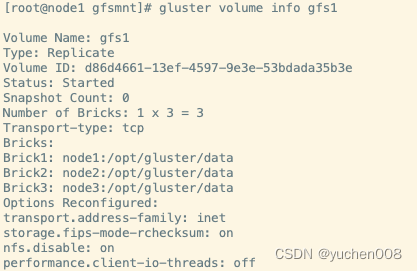

gluster volume info gfs1

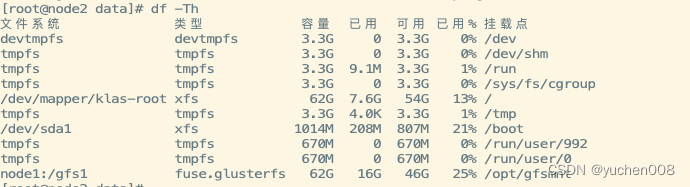

2.6 客户端挂载测试(以node2为客户端为例)

mkdir /opt/gfsmnt

mount -t glusterfs node1:/gfs1 /opt/gfsmnt/

在node2的/opt/gfsmnt下创建文件

echo "hello kylinos" > gfs.txt

在node1和node3对应的/opt/gluster/data目录下都生成了gfs.txt文件

![]()

![]()

附一:GlusterFS 几种volume 模式说明:

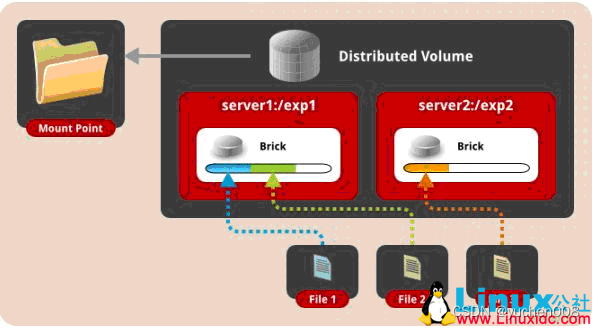

一、 默认模式,既DHT, 也叫 分布卷: 将文件已hash算法随机分布到 一台服务器节点中存储。

gluster volume create test-volume server1:/exp1 server2:/exp2

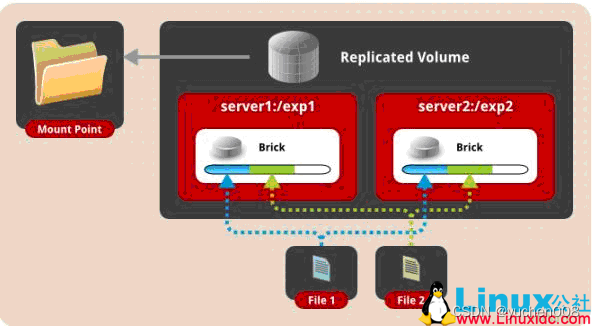

二、 复制模式,既AFR, 创建volume 时带 replica x 数量: 将文件复制到 replica x 个节点中。

gluster volume create test-volume replica 2 transport tcp server1:/exp1 server2:/exp2

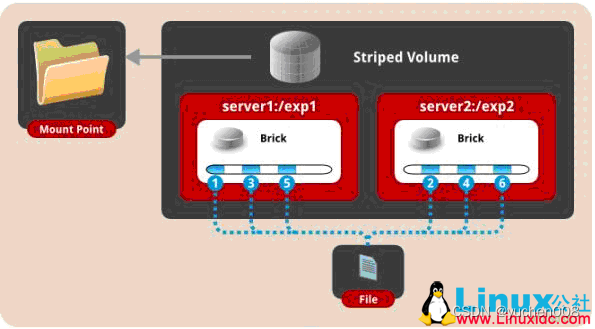

三、 条带模式,既Striped, 创建volume 时带 stripe x 数量: 将文件切割成数据块,分别存储到 stripe x 个节点中 ( 类似raid 0 )。

gluster volume create test-volume stripe 2 transport tcp server1:/exp1 server2:/exp2

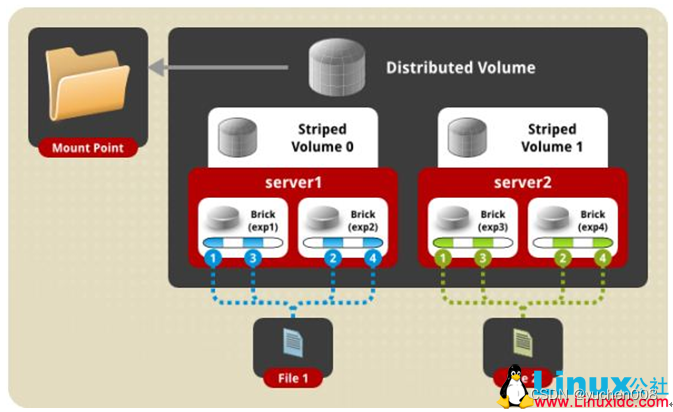

四、 分布式条带模式(组合型),最少需要4台服务器才能创建。 创建volume 时 stripe 2 server = 4 个节点: 是DHT 与 Striped 的组合型。

gluster volume create test-volume stripe 2 transport tcp server1:/exp1 server2:/exp2 server3:/exp3 server4:/exp4

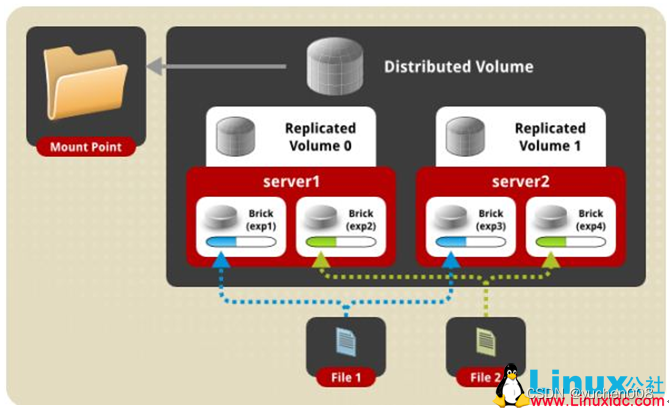

五、 分布式复制模式(组合型), 最少需要4台服务器才能创建。 创建volume 时 replica 2 server = 4 个节点:是DHT 与 AFR 的组合型。

gluster volume create test-volume replica 2 transport tcp server1:/exp1 server2:/exp2 server3:/exp3 server4:/exp4

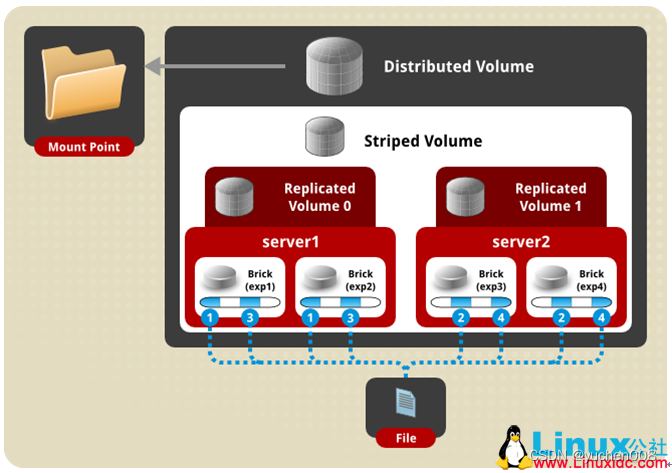

六、 条带复制卷模式(组合型), 最少需要4台服务器才能创建。 创建volume 时 stripe 2 replica 2 server = 4 个节点: 是 Striped 与 AFR 的组合型。

gluster volume create test-volume stripe 2 replica 2 transport tcp server1:/exp1 server2:/exp2 server3:/exp3 server4:/exp4

七、 三种模式混合, 至少需要8台 服务器才能创建。 stripe 2 replica 2 , 每4个节点 组成一个 组。

gluster volume create test-volume stripe 2 replica 2 transport tcp server1:/exp1 server2:/exp2 server3:/exp3 server4:/exp4 server5:/exp5 server6:/exp6 server7:/exp7 server8:/exp8

672

672

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?