Docker 搭建 ElasticSearch5.x 集群

一.环境准备

mkdir -p ES/config

cd ES/config/

二.编写配置文件

## es1.yml

# ======================== Elasticsearch Configuration =========================

#

# ---------------------------------- Cluster -----------------------------------

#

# 配置Elasticsearch的集群名称,默认是elasticsearch

#

cluster.name: elasticsearch-cluster

#

# ------------------------------------ Node ------------------------------------

#

# 节点名,默认随机指定一个name列表中名字。集群中node名字不能重复

node.name: es-node1

#

#

#################################### Index ####################################

#

# 设置每个index默认的分片数,默认是5

#

index.number_of_shards: 2

#

# 设置每个index的默认的冗余备份的分片数,默认是1

index.number_of_replicas: 1

# ----------------------------------- Paths ------------------------------------

#

# 索引数据的存储路径,默认是es根目录下的data文件夹

#

# path.data: /path/to/data

#

# 日志路径:

#

# path.logs: /path/to/logs

#

# ----------------------------------- Memory -----------------------------------

#

# 启动时开启内存锁,防止启动ES时swap内存。

#

bootstrap.memory_lock: true

#

#

# ---------------------------------- Network -----------------------------------

#

# Set the bind address to a specific IP (IPv4 or IPv6):

#

# 绑定的ip地址, 可以是hostname或者ip地址,用来和集群中其他节点通信,同时会设置network.publish_host,以及network.bind_host

network.host: 0.0.0.0

#设置绑定的ip地址,生产环境则是实际的服务器ip,这个ip地址关系到实际搜索服务通信的地址,和服务在同一个集群环境的可以用内网ip,默认和network.host相同。

network.publish_host: 192.168.198.241

#设置绑定的ip地址,可以是ipv4或ipv6的,默认和network.host相同。

network.bind_host: 0.0.0.0

#节点间交互的tcp端口,默认是9300

transport.tcp.port: 9300

#设置对外服务的http端口,默认为9200

http.port: 9200

transport.tcp.compress: true

设置是否压缩tcp传输时的数据,默认为false,不压缩。

#

# --------------------------------- Discovery ----------------------------------

#

# 启动时初始化集群的服务发现的各个节点的地址。

discovery.zen.ping.unicast.hosts: ["192.168.198.241:9300","192.168.198.241:9301","192.168.198.241:9302"]

#设置这个参数来保证集群中的节点可以知道其它N个有master资格的节点。默认为1。为了防止选举时发生“脑裂”,建议配置master节点数= (总结点数/2 + 1)

discovery.zen.minimum_master_nodes: 1

#

# ---------------------------------- Gateway -----------------------------------

#

# 设置集群中N个节点启动之后才可以开始数据恢复,默认为1。

gateway.recover_after_nodes: 1

#

# ---------------------------------- Various -----------------------------------

#

# node.max_local_storage_nodes: 1

#

# 设置删除索引时需要指定索引name,防止一条命令删除所有索引数据。默认是true

#

action.destructive_requires_name: true

## es2.yml

cluster.name: elasticsearch-cluster

node.name: es-node2

network.bind_host: 0.0.0.0

network.publish_host: 192.168.198.241

http.port: 9201

transport.tcp.port: 9301

http.cors.enabled: true

http.cors.allow-origin: "*"

node.master: true

node.data: true

discovery.zen.ping.unicast.hosts: ["192.168.198.241:9300","192.168.198.241:9301","192.168.198.241:9302"]

discovery.zen.minimum_master_nodes: 2

## es3.yml

cluster.name: elasticsearch-cluster

node.name: es-node3

network.bind_host: 0.0.0.0

network.publish_host: 192.168.198.241

http.port: 9202

transport.tcp.port: 9302

http.cors.enabled: true

http.cors.allow-origin: "*"

node.master: true

node.data: true

discovery.zen.ping.unicast.hosts: ["192.168.198.241:9300","192.168.198.241:9301","192.168.198.241:9302"]

discovery.zen.minimum_master_nodes: 2

注:本机虚拟机ip:192.168.198.241 请自行更改

三.调高JVM线程数限制数量

vim /etc/sysctl.conf

加入如下内容:

vm.max_map_count=262144

启用配置:

sysctl -p

四.部署ElasticSearch集群容器

es对性能要求高,确保机器的配置内存大于2G,不然会出现es exited with code 137

拉取镜像:

docker pull elasticsearch:5.6.12

根据所用ElasticSearch版本选择ik版本:Analysis-ik版本

https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v5.6.12/elasticsearch-analysis-ik-5.6.12.zip

还可以选择的插件有:Elasticsearch API Extension Plugins

编写 Dockerfile 添加 ik、delete-by-query插件:

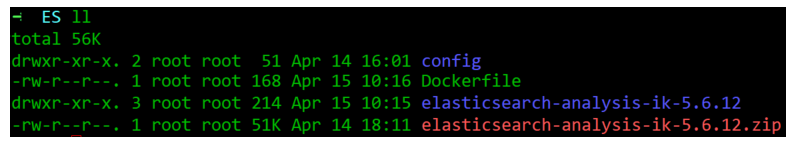

cd /home/ES

vim Dockerfile

解压获取ik:

#指定基础镜像

FROM elasticsearch:5.6.12

RUN mkdir -p /usr/share/elasticsearch/plugins/ik

ADD elasticsearch-analysis-ik-5.6.12 /usr/share/elasticsearch/plugins/ik

创建ElasticSearch基础镜像:

docker build -t my/elasticsearch . #后面这个.表示当前目录下的Dockerfile

启动镜像:

docker run -e ES_JAVA_OPTS="-Xms256m -Xmx256m" -d -p 9200:9200 -p 9300:9300 -v /home/ES/config/es1.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/ES/data1:/usr/share/elasticsearch/data --name ES01 my/elasticsearch

docker run -e ES_JAVA_OPTS="-Xms256m -Xmx256m" -d -p 9201:9201 -p 9301:9301 -v /home/ES/config/es2.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/ES/data2:/usr/share/elasticsearch/data --name ES02 my/elasticsearch

docker run -e ES_JAVA_OPTS="-Xms256m -Xmx256m" -d -p 9202:9202 -p 9302:9302 -v /home/ES/config/es3.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /home/ES/data3:/usr/share/elasticsearch/data --name ES03 my/elasticsearch

若启动失败:chmod 777 data1 data2 data3

验证容器已经启动

五.验证是否搭建成功

1.在浏览器地址栏访问 http://192.168.198.241:9200/_cat/nodes?pretty

2.验证IK

- 分词类别分为:ik_max_word和ik_smart ,如果不指定Elastic对于汉字默认使用standard只是将汉字拆分成一个个的汉字,ik_max_word: 将文本按最细粒度的组合来拆分,ik_smart: 最粗粒度的拆分。

- 使用ik_smart分词

:curl -X GET -H "Content-Type: application/json" "http://localhost:9200/_analyze?pretty=true" -d'{"text":"中华五千年华夏","analyzer": "ik_smart"}';

- ik_max_word分词

:curl -X GET -H "Content-Type: application/json" "http://localhost:9200/_analyze?pretty=true" -d'{"text":"中华五千年华夏","analyzer": "ik_max_word"}';

注:节点名称带*表示为主节点

六.安装elasticsearch-head前端可视化框架

拉取镜像

docker pull mobz/elasticsearch-head:5

启动容器

docker run -d -p 9100:9100 --name es-manager mobz/elasticsearch-head:5

浏览器访问 http://192.168.198.241:9100/

注:

-

cluster.name:用于唯一标识一个集群,不同的集群,其 cluster.name 不同,集群名字相同的所有节点自动组成一个集群。如果不配置改属性,默认值是:elasticsearch。

-

node.name:节点名,默认随机指定一个name列表中名字。集群中node名字不能重复

-

index.number_of_shards: 默认的配置是把索引分为5个分片

-

index.number_of_replicas:设置每个index的默认的冗余备份的分片数,默认是1

通过 index.number_of_shards,index.number_of_replicas默认设置索引将分为5个分片,每个分片1个副本,共10个结点。

禁用索引的分布式特性,使索引只创建在本地主机上:

index.number_of_shards: 1

index.number_of_replicas: 0

但随着版本的升级 将不在配置文件中配置而实启动ES后,再进行配置

-

bootstrap.memory_lock: true 当JVM做分页切换(swapping)时,ElasticSearch执行的效率会降低,推荐把ES_MIN_MEM和ES_MAX_MEM两个环境变量设置成同一个值,并且保证机器有足够的物理内存分配给ES,同时允许ElasticSearch进程锁住内存

-

network.bind_host: 设置可以访问的ip,可以是ipv4或ipv6的,默认为0.0.0.0,这里全部设置通过

-

network.publish_host:设置其它结点和该结点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址

同时设置bind_host和publish_host两个参数可以替换成network.host

network.bind_host: 192.168.198.241

network.publish_host: 192.168.198.241

=>network.host: 192.168.198.241

-

http.port:设置对外服务的http端口,默认为9200

-

transport.tcp.port: 设置节点之间交互的tcp端口,默认是9300

-

http.cors.enabled: 是否允许跨域REST请求

-

http.cors.allow-origin: 允许 REST 请求来自何处

-

node.master: true 配置该结点有资格被选举为主结点(候选主结点),用于处理请求和管理集群。如果结点没有资格成为主结点,那么该结点永远不可能成为主结点;如果结点有资格成为主结点,只有在被其他候选主结点认可和被选举为主结点之后,才真正成为主结点。

-

node.data: true 配置该结点是数据结点,用于保存数据,执行数据相关的操作(CRUD,Aggregation);

-

discovery.zen.minimum_master_nodes: //自动发现master节点的最小数,如果这个集群中配置进来的master节点少于这个数目,es的日志会一直报master节点数目不足。(默认为1)为了避免脑裂,个数请遵从该公式 => (totalnumber of master-eligible nodes / 2 + 1)。 * 脑裂是指在主备切换时,由于切换不彻底或其他原因,导致客户端和Slave误以为出现两个active master,最终使得整个集群处于混乱状态*

-

discovery.zen.ping.unicast.hosts: 集群个节点IP地址,也可以使用es-node等名称,需要各节点能够解析

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?